2017/04/01(土) [n年前の日記]

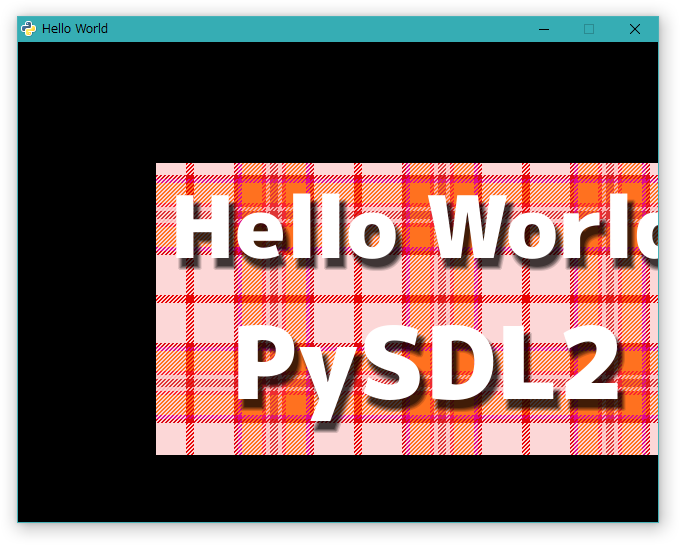

#1 [dxruby] HLSLでフォンシェーディングをやろうとしてハマり中

NVIDIA FX Composer を試用したら Phongシェーディング(フォンシェーディング)のシェーダがあったので、コレをコピペしたら簡単にできるんじゃないか、と安易に思って DXRuby で試したらこれが全然上手くいかず。とんでもない描画になる…。何がおかしいのや…。

[ ツッコむ ]

2017/04/02(日) [n年前の日記]

#1 [dxruby] フォンシェーディングっぽくなってきた気がするけどまだなんだか怪しい

DXRuby の CutomRender で3D描画の実験中。

鏡面反射をそれらしく見せてくれるという、フォン(Phong)シェーディングとやらができないものかと試しているのだけど…。なんとなくそれっぽくなってきた気がする。けど、なんだか、まだちょっと怪しい気もする。これで本当に正しく処理されているのだろうか…。何か間違えてないか…。

ソースは以下。

_crt_test06_phongshading.rb , hlsl_lambert.fx , hlsl_phong.fx

動作には _tinydaeparser.rb と _tinywavefrontobj.rb 、 _サンプルデータ が必要。

というか、ソースもデータもまとめておいたほうがいいのか…。 _customrender_sample.zip として置いときます。

鏡面反射をそれらしく見せてくれるという、フォン(Phong)シェーディングとやらができないものかと試しているのだけど…。なんとなくそれっぽくなってきた気がする。けど、なんだか、まだちょっと怪しい気もする。これで本当に正しく処理されているのだろうか…。何か間違えてないか…。

ソースは以下。

_crt_test06_phongshading.rb , hlsl_lambert.fx , hlsl_phong.fx

動作には _tinydaeparser.rb と _tinywavefrontobj.rb 、 _サンプルデータ が必要。

というか、ソースもデータもまとめておいたほうがいいのか…。 _customrender_sample.zip として置いときます。

◎ 関係ありそうなところをメモ。 :

hlsl_phong.fx の中の、Phongシェーディングと関係ありそうなところを抜き出してメモ。

// vertex shader with texture

VS_OUT VS(VS_IN v) {

...

output.vNormal = mul(v.vNormal, (float3x3)mWorld).xyz;

output.vWPos = mul(v.vPosition, mWorld);

output.vEyePos = mView[3].xyz;

...

}

// pixel shader with texture

PS_OUT PS(VS_OUT p) {

...

float3 light = normalize(vLightDir.xyz);

float3 normal = normalize(p.vNormal);

...

// specular

float3 view = normalize(p.vEyePos - p.vWPos);

float3 r = normalize(light - 2.0f * normal * dot(light, normal)).xyz;

float spe = pow(max(dot(r, view), 0.0f), vMatShininess);

// float3 halfway = normalize(light - view);

// float spe = pow(max(dot(normal, halfway), 0.0f), vMatShininess);

float3 specular = vMatSpecular * spe;

...

}

これで合ってるのですかね…? 分からん…。

◎ 気づいた点をメモ。 :

DXRuby開発版に同梱されていた公式サンプル、spheretest.rb の中の光源用変数は、位置座標じゃなくてライトの方向を示してたのですな…。それも、光源から頂点へのベクトルじゃなくて、頂点から光源へのベクトル、のように思えてきたり。

フォンシェーディングの計算をする際は、頂点から視点へのベクトルが必要なのだけど…。サンプル内では mView[3].xyz で似たような値が取り出せそうな気がする、けど、それで合っているのかどうか…。

_その39 知っていると便利?ワールド変換行列から情報を抜き出そう

_☆PROJECT ASURA☆ [OpenGL] 『ライティング(3) Lambert』 によると、ハーフランバートなるものがあるらしいので試したり。

フォンシェーディングの計算をする際は、頂点から視点へのベクトルが必要なのだけど…。サンプル内では mView[3].xyz で似たような値が取り出せそうな気がする、けど、それで合っているのかどうか…。

_その39 知っていると便利?ワールド変換行列から情報を抜き出そう

_☆PROJECT ASURA☆ [OpenGL] 『ライティング(3) Lambert』 によると、ハーフランバートなるものがあるらしいので試したり。

◎ 参考ページ。 :

以下を参考にしつつ試行錯誤しました。

_床井研究室 - 第1回 シェーダプログラムの読み込み

_床井研究室 - 第2回 Gouraud シェーディングと Phong シェーディング

_フォンシェーディング - Wikipedia

_Maverick Project

_DirectX9 プログラミングメモ - HLSL:フォン鏡面反射

_High Level Shading Language - Wikipedia

_☆PROJECT ASURA☆ [OpenGL] 『ライティング(3) Lambert』

ランバート反射については、以下の記事内の画像が分かりやすい、ような気もする。

_【Unityシェーダ入門】ランバート拡散照明モデルを試す - おもちゃラボ

_床井研究室 - 第1回 シェーダプログラムの読み込み

_床井研究室 - 第2回 Gouraud シェーディングと Phong シェーディング

_フォンシェーディング - Wikipedia

_Maverick Project

_DirectX9 プログラミングメモ - HLSL:フォン鏡面反射

_High Level Shading Language - Wikipedia

_☆PROJECT ASURA☆ [OpenGL] 『ライティング(3) Lambert』

ランバート反射については、以下の記事内の画像が分かりやすい、ような気もする。

_【Unityシェーダ入門】ランバート拡散照明モデルを試す - おもちゃラボ

[ ツッコむ ]

#2 [emacs] emacsでHLSLを編集

Rubyスクリプトソースを書く時は emacs (NTEmacs) を使っているのだけど、HLSLもemacs上で書きたいなと。

_HLSL Mode download | SourceForge.net で、emacs 用の hlsl-mode が公開されている。NTEmacs 上で導入してみたり。作業が楽になった。

~/.emacs 等に以下を記述。これで .fx ファイルを開くと hlsl-mode になる。

_HLSL Mode download | SourceForge.net で、emacs 用の hlsl-mode が公開されている。NTEmacs 上で導入してみたり。作業が楽になった。

~/.emacs 等に以下を記述。これで .fx ファイルを開くと hlsl-mode になる。

;; HLSL mode

(autoload 'hlsl-mode "hlsl-mode" nil t)

(add-to-list 'auto-mode-alist '("\\.fx\\'" . hlsl-mode))

(add-to-list 'auto-mode-alist '("\\.hlsl\\'" . hlsl-mode))

[ ツッコむ ]

2017/04/03(月) [n年前の日記]

#1 [cg_tools][blender] 宇宙船を自動生成するアレコレを試したり

宇宙船の3DCGモデルを自動生成するアレコレを試したり。

◎ blenderで自動生成 :

_a1studmuffin/SpaceshipGenerator

というアドオンを使うと、blenderで宇宙船を自動生成できるようで。

導入の仕方は、 _Releases - a1studmuffin/SpaceshipGenerator から、add_mesh_SpaceshipGenerator.zip をダウンロード。blender を起動して、ファイル → ユーザー設定 → アドオン → ファイルからインストール、で、先ほどDLしたzipファイルを選択して、「ファイルからインストール」ボタンをクリック。アドオンリストに表示されるのでチェックを入れて有効化。

使い方は、Shift + A → メッシュ → Spaceship。もしくはスペースキーを押して「spaceship」と打ち込めば項目がリストアップされるのでソレを選択。

3Dビュー画面に形状が追加されたら、左下のプロパティ?で生成時の設定を弄れる。とりあえず、シード(おそらく疑似乱数のシード)にテキトーな数値を入れていけば、生成される形がランダムで変わる模様。

デフォルト設定ではテクスチャも貼ってある状態なので、そのままレンダリングできるっぽい。

導入の仕方は、 _Releases - a1studmuffin/SpaceshipGenerator から、add_mesh_SpaceshipGenerator.zip をダウンロード。blender を起動して、ファイル → ユーザー設定 → アドオン → ファイルからインストール、で、先ほどDLしたzipファイルを選択して、「ファイルからインストール」ボタンをクリック。アドオンリストに表示されるのでチェックを入れて有効化。

使い方は、Shift + A → メッシュ → Spaceship。もしくはスペースキーを押して「spaceship」と打ち込めば項目がリストアップされるのでソレを選択。

3Dビュー画面に形状が追加されたら、左下のプロパティ?で生成時の設定を弄れる。とりあえず、シード(おそらく疑似乱数のシード)にテキトーな数値を入れていけば、生成される形がランダムで変わる模様。

デフォルト設定ではテクスチャも貼ってある状態なので、そのままレンダリングできるっぽい。

◎ Webサービスで自動生成。 :

_Ship - shapeWright.com

を使うと、ブラウザ上で宇宙船っぽい3Dモデルを自動生成できる。

_宇宙船っぽい3Dモデルをランダムで生成してくれる『shapeWright』 | IDEA*IDEA

によると、少なくとも2011年以前から存在していたらしい…。

上のほうの「Your name here」と表示されてる入力欄にテキトーな文字列を打ち込んで(「apple」とか「pen」とか文字列なら何でもOK)、「BUILD IT」ボタンをクリックすると、生成されるモデルの形状が変わる。おそらく文字列を疑似乱数のシードにしている予感。

生成された形状は、右下の「Downloads as VRML」をクリックすることで、 .wrl形式のファイルでダウンロードできる。blender でインポートできることも確認した。

ただ、このサービス、ライセンスが不明なんだよな…。 _shapeWright.com には「free」としか書いてないけど…。あらかじめそれっぽく作られたモデルをいくつか組み合わせて生成してるようだけど、そのパーツモデルにも著作権があるだろうし…。ダウンロードしたモデルを何かしらに使う場合、ライセンス面でどんな制限がついてまわるのやら…。

上のほうの「Your name here」と表示されてる入力欄にテキトーな文字列を打ち込んで(「apple」とか「pen」とか文字列なら何でもOK)、「BUILD IT」ボタンをクリックすると、生成されるモデルの形状が変わる。おそらく文字列を疑似乱数のシードにしている予感。

生成された形状は、右下の「Downloads as VRML」をクリックすることで、 .wrl形式のファイルでダウンロードできる。blender でインポートできることも確認した。

ただ、このサービス、ライセンスが不明なんだよな…。 _shapeWright.com には「free」としか書いてないけど…。あらかじめそれっぽく作られたモデルをいくつか組み合わせて生成してるようだけど、そのパーツモデルにも著作権があるだろうし…。ダウンロードしたモデルを何かしらに使う場合、ライセンス面でどんな制限がついてまわるのやら…。

[ ツッコむ ]

#2 [tv] 「NHKスペシャル メルトダウン6 原子炉冷却12日間の深層〜見過ごされた危機」を視聴

録画したまま見てなかった、「

_NHKスペシャル メルトダウン6 原子炉冷却12日間の深層〜見過ごされた危機

」を今頃になって視聴。なかなか興味深い話がチラホラ。

覚えてる範囲で内容だの感想だのをメモ。

覚えてる範囲で内容だの感想だのをメモ。

◎ イソコンの話。 :

イソコン(isolation condenser、

_非常用復水器

)なる、電源喪失に陥っても冷却できる装置が1号機にはちゃんとついてたけれど。

そのイソコン、原発の建設時にテストで動かしただけで、その後40年間、一度も動かしてなかったものだから…。正常動作していたらどういう状態になるか知ってる人が誰も居なくて、動いてないことに誰も気づかず、冷却できていないことすら気付けなかった、てな話が紹介されてたり。

_福島第一原発の非常用冷却装置、長期に渡って稼働試験がされていない状態だった | スラド ハードウェア

本来、ちゃんと動いたら、建屋の壁についてる二つの穴、通称「豚の鼻」から、まるで雲のように凄い勢いでモクモクと水蒸気が出るそうで。40年前に動作テストを見ていた人はそう証言してた。

が、件の事故ではちょろちょろと水蒸気が出てただけ。しかし正常動作してる様子を見たことのある人が現場に誰一人居ないものだから、「水蒸気が一応出てるね」→「正常動作してるんだろう。してるはず」と思い込んだそうで。

ちなみにアメリカではイソコンの実動作試験が義務付けられてる、と番組内で紹介されてた。アメリカの原発関係者は、「普段から動作テストしておかないと、いざという時にちゃんと動いてるか分からんだろ。何言ってんのお前」的な、実に当たり前なことを言っていた…。

日本の場合、万が一イソコン内で配管が壊れてたら放射性物質が外部に出てしまうので周辺地域へのリスクを考えてこれまで動作試験しなかった、との東京電力の弁で。地域住民に配慮して、あえて動作試験しなかったのだ、俺達悪くない、みたいな物言い。

配管が壊れてたらいざという時に手が打てないのだからそこまで含めてチェックして動作試験する体制を整えておかないといかんのではと素人考えでは思うのだけど。まあ、「日本の原発は絶対に事故を起こさない」と念仏のように唱えてた人達にそんなこと言ってみてもどうせニヤニヤ笑われてスルーされるだけ、ではあったのだろうなとも。

そのイソコン、原発の建設時にテストで動かしただけで、その後40年間、一度も動かしてなかったものだから…。正常動作していたらどういう状態になるか知ってる人が誰も居なくて、動いてないことに誰も気づかず、冷却できていないことすら気付けなかった、てな話が紹介されてたり。

_福島第一原発の非常用冷却装置、長期に渡って稼働試験がされていない状態だった | スラド ハードウェア

本来、ちゃんと動いたら、建屋の壁についてる二つの穴、通称「豚の鼻」から、まるで雲のように凄い勢いでモクモクと水蒸気が出るそうで。40年前に動作テストを見ていた人はそう証言してた。

が、件の事故ではちょろちょろと水蒸気が出てただけ。しかし正常動作してる様子を見たことのある人が現場に誰一人居ないものだから、「水蒸気が一応出てるね」→「正常動作してるんだろう。してるはず」と思い込んだそうで。

ちなみにアメリカではイソコンの実動作試験が義務付けられてる、と番組内で紹介されてた。アメリカの原発関係者は、「普段から動作テストしておかないと、いざという時にちゃんと動いてるか分からんだろ。何言ってんのお前」的な、実に当たり前なことを言っていた…。

日本の場合、万が一イソコン内で配管が壊れてたら放射性物質が外部に出てしまうので周辺地域へのリスクを考えてこれまで動作試験しなかった、との東京電力の弁で。地域住民に配慮して、あえて動作試験しなかったのだ、俺達悪くない、みたいな物言い。

配管が壊れてたらいざという時に手が打てないのだからそこまで含めてチェックして動作試験する体制を整えておかないといかんのではと素人考えでは思うのだけど。まあ、「日本の原発は絶対に事故を起こさない」と念仏のように唱えてた人達にそんなこと言ってみてもどうせニヤニヤ笑われてスルーされるだけ、ではあったのだろうなとも。

◎ なんでも本社を通さないと話が進まない話。 :

1号機は早い段階で中の水が空になってメルトダウンしてたのだけど、実は水量計が正しい値を示してなくて、半分ぐらいは水が入って冷却できてるものと12日間もずっと思い込んでいたそうで。

しかし、柏崎刈羽原発の所長さん達は、「ガンガン注水してるのに水量計がピクリとも変化しないってどう考えてもおかしいやろ」「これ、水量計壊れてるやろ」「中は水が空になってる可能性を考えんと」と助言してくれていたようで。

でも、なんでもかんでも東電本社(本店)を通さないと話が進まないものだから、東電本社+福島第一原発所長の「実は半分どころじゃなく満杯になってるけど、水量計がソレを示してくれないだけではないのかなあ」てな、今になってみると明らかな _正常性バイアス でかき消されて助言が活かされなかったという…。

要は、縦の繋がりが強過ぎて、横の繋がりで現状を把握や推測することが難しい状態に置かれてたっぽいよねコレ、てなことが番組内で指摘されてた。

たしか欧州のどこかの国では、原発を運用する会社は本社を原発の横に置くこと、みたいな義務化がされているらしいのだけど…。重大事故が発生した時に、各対策について決定権を持つ本社が遠くにあったら、正確な現状把握も、迅速な対策決定も、まともにできるわけないやろ、みたいな理由だったはずだけど。せめて、日本もそうしておいたほうがいいんじゃないかなあ、と思えたり。いやまあ、本社を都市圏から移せないというなら逆に原発を都市圏に持っていくのでも構いませんけど。もっとも、その選択をするよりは、本社を原発の横に移転するほうがマシじゃないかと…。

と思ったけど、遠く離れた柏崎刈羽原発の人達が客観的に推測できてるのに、現場の人達が正常性バイアスに支配されてるという状況を考えると…。いや、決定権を持つ本社が事故現場の近くにあるだけでも、分離していた現場と本社を一体化できるのだからマシになりそうな…。どうなんだ。

しかし、柏崎刈羽原発の所長さん達は、「ガンガン注水してるのに水量計がピクリとも変化しないってどう考えてもおかしいやろ」「これ、水量計壊れてるやろ」「中は水が空になってる可能性を考えんと」と助言してくれていたようで。

でも、なんでもかんでも東電本社(本店)を通さないと話が進まないものだから、東電本社+福島第一原発所長の「実は半分どころじゃなく満杯になってるけど、水量計がソレを示してくれないだけではないのかなあ」てな、今になってみると明らかな _正常性バイアス でかき消されて助言が活かされなかったという…。

要は、縦の繋がりが強過ぎて、横の繋がりで現状を把握や推測することが難しい状態に置かれてたっぽいよねコレ、てなことが番組内で指摘されてた。

たしか欧州のどこかの国では、原発を運用する会社は本社を原発の横に置くこと、みたいな義務化がされているらしいのだけど…。重大事故が発生した時に、各対策について決定権を持つ本社が遠くにあったら、正確な現状把握も、迅速な対策決定も、まともにできるわけないやろ、みたいな理由だったはずだけど。せめて、日本もそうしておいたほうがいいんじゃないかなあ、と思えたり。いやまあ、本社を都市圏から移せないというなら逆に原発を都市圏に持っていくのでも構いませんけど。もっとも、その選択をするよりは、本社を原発の横に移転するほうがマシじゃないかと…。

と思ったけど、遠く離れた柏崎刈羽原発の人達が客観的に推測できてるのに、現場の人達が正常性バイアスに支配されてるという状況を考えると…。いや、決定権を持つ本社が事故現場の近くにあるだけでも、分離していた現場と本社を一体化できるのだからマシになりそうな…。どうなんだ。

◎ リーダーにかかる負荷の話。 :

12日間の、関係者のTV電話を使った発言内容をAIで分析してみたら、福島第一原発の所長さんの疲労度等がグラフの形でハッキリわかる状態になったそうで。同じ単語が何度も出てくるとか、発言時間をカウントすると休息が一切取れてないとか、把握かつ指示を出さなければいけないジャンルがあまりにも多岐にわたるとか。

最後は所長の意識がもうろとして対策室から外に運ばれていく瞬間が来るのだけど…。次回もこういうシステムで対応してたらまた同じ展開になるよね、みたいな話に。

最後は所長の意識がもうろとして対策室から外に運ばれていく瞬間が来るのだけど…。次回もこういうシステムで対応してたらまた同じ展開になるよね、みたいな話に。

◎ てなわけで。 :

リーダーにかかる負荷とかどうやって軽減したらいいのか素人考えでもさっぱり思いつかないけど。とりあえず、再稼働の認可が下りた原発ってイソコンの類はあるのかな、一応実動作試験したのかな、てなあたりが気になりました。もし、動作試験してなかったら、フラグ臭いなと…。

*1

*1: まあ、「東日本と西日本の原発はそもそも仕組みが違うから」とか言ってうやむやになってそうだけど。所詮は他所の国で起きた事故だから俺達関係ねえ、みたいなノリだろうなあ…。日本って、明治時代になるまで、各地域はそれこそ「国」と呼ばれてたわけで、距離感と当事者意識って未だにそんなレベルだろうと思ったりもするので、件の事故の経験はどうせろくに活かされないのだ、防ぐ努力をしておけばちゃんと防げたものも結局防がないあたりが日本人、などと予想してたりもしますが。とは言えこのあたり、神様の振ったサイコロの目が悪かったらこうなる、という話だし、貴方の国(=県)ではイイ目が永遠に出続けるといいですねえ、どうせ皆さんイイ目が出続けると信じ込んでそうしてるんでしょ、てなところもあるわけで、絶対に事故が起きるとも言えないし、絶対に事故が起きないとも言えないしで、難しい面があるよなと思ったり思わなかったり。

[ ツッコむ ]

2017/04/04(火) [n年前の日記]

#1 [ruby][dxruby] ドット絵を自動生成するスクリプトをRubyで移植してみたり

_zfedoran/pixel-sprite-generator

という、ドット絵っぽい何かを自動生成してくれるJavaScriptがあるのだけど、なんだか面白そうなので Ruby で移植して DXRuby から使ってみたり。

_mieki256/tinypixelspritegenerator

こんな感じのドット絵、っぽい何かが作れるようです。

生成時にガイド相当としてマスクパターンを渡すので、全自動じゃないあたりがちとアレですけど、それでも同じマスクパターンからこれだけ違うモノを生成してくれるので、何か使い道が…あるのかな。どうかな。どうなんだろう。

_mieki256/tinypixelspritegenerator

こんな感じのドット絵、っぽい何かが作れるようです。

生成時にガイド相当としてマスクパターンを渡すので、全自動じゃないあたりがちとアレですけど、それでも同じマスクパターンからこれだけ違うモノを生成してくれるので、何か使い道が…あるのかな。どうかな。どうなんだろう。

◎ 使い方。 :

_tinypixelspritegenerator.rb

をダウンロード。Rawと書かれたボタンを右クリックして「リンク先を保存」等で落とせるかと。

DXRuby がインストールされてる環境なら、ruby tinypixelspritegenerator.rb でひとまず動作確認はできるかと。

何かから呼び出して使いたい時は…。

二次元配列に [R, G, B, A] を入れて返すだけなので、配列から画像用クラスに変換する処理さえ書けば、DXRuby以外、例えば gosu 等でも使える、のではないかと。

DXRuby がインストールされてる環境なら、ruby tinypixelspritegenerator.rb でひとまず動作確認はできるかと。

何かから呼び出して使いたい時は…。

require 'dxruby'

require_relative 'tinypixelspritegenerator'

# 配列を DXRuby の Image に変換

# @param a [Array<Array>] 3次元配列

def array_to_image(a)

h = a.size

w = a[0].size

img = Image.new(w, h, [0, 0, 0, 0])

a.each_with_index do |row, y|

row.each_with_index do |rgb, x|

r, g, b, a = rgb

img[x, y] = [a, r, g, b]

end

end

return img

end

# マスクパターン

mask_spaceship = [

# 12x12

# "0" or " " = 透明部分

# "1" or "." = ランダムで、ボディ部分か透明部分になる

# "2" or "+" = ランダムで、境界線かボディ部分になる

# "3" or "*" = 常に境界線になる

'000000',

'000011',

'000013',

'000113',

'000113',

'001113',

'011122',

'011122',

'011122',

'011113',

'000111',

'000000',

]

# 文字列で指定されたマスクパターンを配列のマスクパターンに変換

mask = TinyPixelSpriteGenerator.convert_mask(mask_spaceship)

# ドット絵生成

p = TinyPixelSpriteGenerator.new(

mask, # マスクパターンの配列

mirror_x: true, # true で左右ミラーを有効

mirror_y: false, # true で上下ミラーを有効

colored: true, # 色付きにするか白黒にするか

edgebrightness: 0.3, # 境界線の明度。値が小さければ黒に近付く

colorvariations: 0.2, # 色付け時のバリエーション幅

brightnessnoise: 0.3, # 色付け時の明度差

saturation: 0.5, # 色付け時の彩度幅

seed: rand(65536) # ランダムシード。ここが同じなら同じドット絵ができる

)

# 得られたドット絵のパターン配列を DXRuby の Image に変換

img = array_to_image(p.pixel_data)

Window.loop do

break if Input.keyPush?(K_ESCAPE)

Window.draw(0, 0, img)

end

こんな感じですかね…。二次元配列に [R, G, B, A] を入れて返すだけなので、配列から画像用クラスに変換する処理さえ書けば、DXRuby以外、例えば gosu 等でも使える、のではないかと。

◎ アルゴリズム。 :

_Pixel Spaceships (Internet Archive)

で元々のアルゴリズムが紹介されてますが、簡単に説明すると、ざっくりとしたマスクパターンを渡して、ボディ部分をランダムに On/Off した後、境界線を作って縁取る、てな処理のようで。

しかしコレ、元々の画像を見ると、ボディとコクピット部分で色が分かれてるような…。自分の書いた版は、というかオリジナルのJavaScript版も、そこまで反映されてないな…。

色付けする時に、元々のマスクパターンを参照して、「ココはコクピット部分だから色を変えよう」みたいな処理をすればいいのかな。たぶん。まあ、そこらへんは宿題ってことで。

しかしコレ、元々の画像を見ると、ボディとコクピット部分で色が分かれてるような…。自分の書いた版は、というかオリジナルのJavaScript版も、そこまで反映されてないな…。

色付けする時に、元々のマスクパターンを参照して、「ココはコクピット部分だから色を変えよう」みたいな処理をすればいいのかな。たぶん。まあ、そこらへんは宿題ってことで。

[ ツッコむ ]

#2 [prog] TortoiseGitでエラー

TortoiseGit 2.4.0.0 を使おうとしたら libgit2 とやらがエラーを出して。

ググったら、バグだったらしい。

_AWS CodeCommit+TortoiseGitで”libgit2 returned invalid path”エラー | Mashpote - マシュポテ

_Doing Add on repository root fails with libgit2 returned invalid path" (#2911) - Issues - TortoiseGit / TortoiseGit - GitLab

ググったら、バグだったらしい。

_AWS CodeCommit+TortoiseGitで”libgit2 returned invalid path”エラー | Mashpote - マシュポテ

_Doing Add on repository root fails with libgit2 returned invalid path" (#2911) - Issues - TortoiseGit / TortoiseGit - GitLab

[ ツッコむ ]

#3 [tv][movie] 「アナと雪の女王」を視聴

TV放送されたソレを録画したまま放置してたのだけど、ようやく視聴。

なるほど、ディズニーっぽい…ってディズニーアニメだから当たり前、だろうか。いやいや、手描き時代のスタッフはもうほとんど居ないだろうから、 次の世代がディズニーらしさを再現・復元しようと努力した末にこうなったはずで。 *1 できて当前、ではなくて、道具もスタッフも何もかも違うだろうによくぞここまでそれらしく仕上げてみせたものだなあ、恐ろしいなあ、てな印象を。

見ていてなんとなく思ったけれど、これこそが、ディズニーがずっと望んでいたけど手描き時代は実現できなかった、真に理想のディズニーアニメ映像、なのだろうなと。手描き時代の基本2コマ撮りではなく、24コマ/秒で動かしてる上に、画面に登場する全ての形状を正確に完全にコントロールしているわけで。究極のアニメ映像。本物のフルアニメーション。

そしておそらく日本のアニメも、「作画崩壊」と叩かれることばかり気にしてお綺麗なお人形さんばかり描くことを意識して作っていたら、最終的にはこういう映像に到達せざるを得ないだろう、などとますます思えてきたり。 *2

なるほど、ディズニーっぽい…ってディズニーアニメだから当たり前、だろうか。いやいや、手描き時代のスタッフはもうほとんど居ないだろうから、 次の世代がディズニーらしさを再現・復元しようと努力した末にこうなったはずで。 *1 できて当前、ではなくて、道具もスタッフも何もかも違うだろうによくぞここまでそれらしく仕上げてみせたものだなあ、恐ろしいなあ、てな印象を。

見ていてなんとなく思ったけれど、これこそが、ディズニーがずっと望んでいたけど手描き時代は実現できなかった、真に理想のディズニーアニメ映像、なのだろうなと。手描き時代の基本2コマ撮りではなく、24コマ/秒で動かしてる上に、画面に登場する全ての形状を正確に完全にコントロールしているわけで。究極のアニメ映像。本物のフルアニメーション。

そしておそらく日本のアニメも、「作画崩壊」と叩かれることばかり気にしてお綺麗なお人形さんばかり描くことを意識して作っていたら、最終的にはこういう映像に到達せざるを得ないだろう、などとますます思えてきたり。 *2

◎ みんなで歌おうのソレ。 :

さておき、本編が終わった後の「みんなで歌おう」の映像を目にして、なんだか絶望的な気分になりつつ映像を早送り。日本人って心底救いようがねえな…。一体誰だよ、この同調圧力映像をツッコもうと言い出したヤツは…。どうしてこういうことしちゃいけないのか、TVの仕事をしていながら全然分かってないんだな…。

*3

いや待て。もしかしてコレは幼児向け番組として企画・放送されていたのだろうか…。映像も幼児がやたらと出ていたし…。だとしたらアリなのか…。「おかあさんといっしょ」の最後のあたりで幼児の群れがわらわらと動いてるコーナーみたいなもんで…。

などとだんだん気になってきてググったら。

_『アナ雪』の「みんなで歌おう」企画が賛否両論 不向きな日本人は「クール」じゃないのか - AOLニュース

_「アナと雪の女王の主題歌みんなで歌おう♪」シング・アロングは、なぜ成功したか。(碓井真史) - 個人 - Yahoo!ニュース

_成功と失敗の違いは?:GWの映画館「アナと雪の女王の主題歌みんなで歌おう♪」シング・アロング(碓井真史) - 個人 - Yahoo!ニュース

うげ。劇場公開時からやってたのか…。知らなかった…。TV局の方をアレしてしまってゴメンナサイ。とばっちりですね。映画版からしてそもそもアレだったのね…。

ひょっとして、 _シン・ゴジラ発声可能上映 みたいなものか…。するとこの「アナ雪」も、TVの前の視聴者は、「歌うぞ…歌うぞ…歌うぞおおおお…」と手に汗握ってその時を待ち続けてあの映像が流れた途端に「ありょりょおおお!」と絶唱し始めたってことなんでしょうか。ですか。だったらいいんじゃないでしょうか…。そういう祭りがあるとは知らなかったもので文句言っちゃってゴメンナサイ。その手の祭りで「君が担いでるソレ、チ○コの形してるけどいいの?」と心配してるようなもんだよな…。KYにもほどがある。

それはともかく。

_『ありのままで』の歌詞はトンデモ訳?→日本語版に合わせたプロの仕事! - Togetterまとめ

自分、あの歌を耳にすると、「訳はこれで良いのだろうか…」「本当はもっと意味が重なっていたはず…」「しかし英語と日本語では時間あたりに詰め込める情報量が違うし…」「このキャラクターにしてみれば思ってもいないことを歌わされてるようなものだよな…」「とは言え翻訳と言う作業が入ってくる娯楽コンテンツには必ず付きまとう問題…」「かといって英語のままでは例えば幼児は理解できないのでは…」などと正解がない問題について悩み始めちゃうので仮に「歌え」と強制されても頭の中は色々とグルグル回ってしまって今ちょっと歌うどころじゃないです勘弁してください。

いや待て。もしかしてコレは幼児向け番組として企画・放送されていたのだろうか…。映像も幼児がやたらと出ていたし…。だとしたらアリなのか…。「おかあさんといっしょ」の最後のあたりで幼児の群れがわらわらと動いてるコーナーみたいなもんで…。

などとだんだん気になってきてググったら。

_『アナ雪』の「みんなで歌おう」企画が賛否両論 不向きな日本人は「クール」じゃないのか - AOLニュース

_「アナと雪の女王の主題歌みんなで歌おう♪」シング・アロングは、なぜ成功したか。(碓井真史) - 個人 - Yahoo!ニュース

_成功と失敗の違いは?:GWの映画館「アナと雪の女王の主題歌みんなで歌おう♪」シング・アロング(碓井真史) - 個人 - Yahoo!ニュース

うげ。劇場公開時からやってたのか…。知らなかった…。TV局の方をアレしてしまってゴメンナサイ。とばっちりですね。映画版からしてそもそもアレだったのね…。

ひょっとして、 _シン・ゴジラ発声可能上映 みたいなものか…。するとこの「アナ雪」も、TVの前の視聴者は、「歌うぞ…歌うぞ…歌うぞおおおお…」と手に汗握ってその時を待ち続けてあの映像が流れた途端に「ありょりょおおお!」と絶唱し始めたってことなんでしょうか。ですか。だったらいいんじゃないでしょうか…。そういう祭りがあるとは知らなかったもので文句言っちゃってゴメンナサイ。その手の祭りで「君が担いでるソレ、チ○コの形してるけどいいの?」と心配してるようなもんだよな…。KYにもほどがある。

それはともかく。

_『ありのままで』の歌詞はトンデモ訳?→日本語版に合わせたプロの仕事! - Togetterまとめ

自分、あの歌を耳にすると、「訳はこれで良いのだろうか…」「本当はもっと意味が重なっていたはず…」「しかし英語と日本語では時間あたりに詰め込める情報量が違うし…」「このキャラクターにしてみれば思ってもいないことを歌わされてるようなものだよな…」「とは言え翻訳と言う作業が入ってくる娯楽コンテンツには必ず付きまとう問題…」「かといって英語のままでは例えば幼児は理解できないのでは…」などと正解がない問題について悩み始めちゃうので仮に「歌え」と強制されても頭の中は色々とグルグル回ってしまって今ちょっと歌うどころじゃないです勘弁してください。

*1: たしかディズニーの手描きアニメーターさん達は一時期全員解雇されてたような…。PIXAR買収後にラセター監督達がディズニーに乗り込んで手描きのソレを再評価させたことで戻った人も居るかもしれんけど、それでも実作業をしてるのはやっぱり若い世代のCGアニメーターさん達だろうと想像するわけで。

*2: 個人的には、手描きアニメの強みを自覚してソレを活かしたアニメも作ってほしいのだけど…。いやまあ、活かしてる作品もちゃんとあるのでアレなんだけど、3DCGで作るべきではないかと思う作品を見かけてしまうこともそれなりに…。

*3: TV番組等を見せた際に視聴者がどういう気分になるか、どういう表情をするか、そこから先は全部は視聴者側の仕事というか担当なわけで、それを映像提示側が先に前に出てやっちゃったらダメだろうと。例えば、子供が自発的に宿題やろうとして教科書開いたタイミングで「早く宿題やりなさい!」と母ちゃんが怒鳴ったら子供はどんな気持ちになりますか。漫才コンビがコントでネタを一つ披露するたびに客が笑うより早く自分達で笑ってたらどうなりますか。そういう状況を想像したら「あっ。コレやっちゃダメだ」と容易に分かるだろと。なのに、昨今の日本のTV局は民放に限らずNHKも含めて延々とその類の愚行を繰り返して…。それでいて「視聴者離れが」とか愚痴ってるし。正直、こういう言葉は吐きたくないけど…馬鹿じゃないのか。

*2: 個人的には、手描きアニメの強みを自覚してソレを活かしたアニメも作ってほしいのだけど…。いやまあ、活かしてる作品もちゃんとあるのでアレなんだけど、3DCGで作るべきではないかと思う作品を見かけてしまうこともそれなりに…。

*3: TV番組等を見せた際に視聴者がどういう気分になるか、どういう表情をするか、そこから先は全部は視聴者側の仕事というか担当なわけで、それを映像提示側が先に前に出てやっちゃったらダメだろうと。例えば、子供が自発的に宿題やろうとして教科書開いたタイミングで「早く宿題やりなさい!」と母ちゃんが怒鳴ったら子供はどんな気持ちになりますか。漫才コンビがコントでネタを一つ披露するたびに客が笑うより早く自分達で笑ってたらどうなりますか。そういう状況を想像したら「あっ。コレやっちゃダメだ」と容易に分かるだろと。なのに、昨今の日本のTV局は民放に限らずNHKも含めて延々とその類の愚行を繰り返して…。それでいて「視聴者離れが」とか愚痴ってるし。正直、こういう言葉は吐きたくないけど…馬鹿じゃないのか。

[ ツッコむ ]

#4 [zatta][neta] 「みんなで歌う」ことに対して何か妙な気分になる自分

自分、基本的に、皆で揃って歌うことに対してどうも抵抗があるのだけど。なんでだろう、どうしてだろうと考えた時、どうも小中学校の体験が関係してそうな気もしてきたり。

小中学校って、君が代斉唱等、自分の意志とは関係なくとにかく揃って歌うことを強制されるじゃないですか。竹刀を持った先生が目の前をウロウロして、「おらあ! オマエラ声が出てねえぞ!」と竹刀で地面をバシッと叩いたりとかやってましたけど。まあ、戦中の軍隊ノリが学校と言う閉鎖空間の中でずっと続いてたというか、上からの命令に絶対服従する兵士を効率よく育てるためには必要な訓練時間なのだ、みたいなところがあるんでしょうけど。

もちろん自分は当時子供だったし頭も回るほうじゃないから「なんで歌わなきゃいけないんだろう」と疑問を持ちながらも反抗する気力もなければそれらしい理論武装を構築できるわけでもなくひたすら怒られないように口パクパクさせて歌ってるフリだけはしてましたけど。どうもあの頃に、「皆で歌うという行為」に対して、「気分が滅入ること・なんだか気持ち悪いこと」てなイメージが付加されてしまった、ような気もしてきたり。

そういや、今現在も「愛国心を育てるために」とか言ってその手のアレコレを学校内で強制されてたはずですが。本来愛国心ってコミュニティに属する人達の心の中で自発的に湧き上がってくるのが理想的な状況だろうと思うわけなんですけど、それって何かしらをグリグリと強制することで各人の中にムクムクと育つものなのかねえ、などと思うわけですよ。特に「歌う」という行為はかなり自発的な行為だよなと。そこを強制したら、嫌な思い出しか残らないのとちゃうかと。

何せこの歳になっても、子供の頃に味わったいやーな感じの体験・気分を引き摺って、未だに「皆で歌うとかちょっと気持ち悪いなあ」なんてうっかり思ってしまうのだから、アレはちと逆効果だったのではないかしらん、などと思ったり思わなかったり。 *1

かといって、子供達が皆で自然と歌いたくなるような状況を作り出せるかと考えたらコレもちょっと難しいわけで。「君が代斉唱したあの瞬間、楽しかったなあ…」なんて思える状況を作れたら理想的ですけど、そんなの無理ですわな。教えてる先生達自身にもそういう体験がまず無いだろうし。

まあ、そこに一体感があるから自然と歌うのか、それとも歌うことで一体感があるように錯覚させたいのか ―― 歌は結果として出現するのか、それとも歌を道具として扱うのか、みたいな話なのでしょうかね。わからんですが。

オチはないです。思考メモです。

小中学校って、君が代斉唱等、自分の意志とは関係なくとにかく揃って歌うことを強制されるじゃないですか。竹刀を持った先生が目の前をウロウロして、「おらあ! オマエラ声が出てねえぞ!」と竹刀で地面をバシッと叩いたりとかやってましたけど。まあ、戦中の軍隊ノリが学校と言う閉鎖空間の中でずっと続いてたというか、上からの命令に絶対服従する兵士を効率よく育てるためには必要な訓練時間なのだ、みたいなところがあるんでしょうけど。

もちろん自分は当時子供だったし頭も回るほうじゃないから「なんで歌わなきゃいけないんだろう」と疑問を持ちながらも反抗する気力もなければそれらしい理論武装を構築できるわけでもなくひたすら怒られないように口パクパクさせて歌ってるフリだけはしてましたけど。どうもあの頃に、「皆で歌うという行為」に対して、「気分が滅入ること・なんだか気持ち悪いこと」てなイメージが付加されてしまった、ような気もしてきたり。

そういや、今現在も「愛国心を育てるために」とか言ってその手のアレコレを学校内で強制されてたはずですが。本来愛国心ってコミュニティに属する人達の心の中で自発的に湧き上がってくるのが理想的な状況だろうと思うわけなんですけど、それって何かしらをグリグリと強制することで各人の中にムクムクと育つものなのかねえ、などと思うわけですよ。特に「歌う」という行為はかなり自発的な行為だよなと。そこを強制したら、嫌な思い出しか残らないのとちゃうかと。

何せこの歳になっても、子供の頃に味わったいやーな感じの体験・気分を引き摺って、未だに「皆で歌うとかちょっと気持ち悪いなあ」なんてうっかり思ってしまうのだから、アレはちと逆効果だったのではないかしらん、などと思ったり思わなかったり。 *1

かといって、子供達が皆で自然と歌いたくなるような状況を作り出せるかと考えたらコレもちょっと難しいわけで。「君が代斉唱したあの瞬間、楽しかったなあ…」なんて思える状況を作れたら理想的ですけど、そんなの無理ですわな。教えてる先生達自身にもそういう体験がまず無いだろうし。

まあ、そこに一体感があるから自然と歌うのか、それとも歌うことで一体感があるように錯覚させたいのか ―― 歌は結果として出現するのか、それとも歌を道具として扱うのか、みたいな話なのでしょうかね。わからんですが。

オチはないです。思考メモです。

◎ 先生達でバンド組むとか。 :

校長先生がギターをギュイーン。教頭先生がドラムをズダダダ。音楽の先生がキーボードをピコピコピコ。生徒達は「クッ…体が…自然と動いちまう…」「このグルーブに乗るしかねえ!」みたいな感じで「君が代はー!」「イエーイ!」「校歌斉唱ー!」「イエーイ!」「チクショウ、こんなイカレタ国に生まれて、俺達ってもしかして幸せなのかも…!」

ねーよ。

でも、そういう漫画があってもいいような気もしてきたり。ていうかあるんじゃないか、もしかして。

ねーよ。

でも、そういう漫画があってもいいような気もしてきたり。ていうかあるんじゃないか、もしかして。

*1: しかし、小中学校のソレも、外国の人達から「なんで日本人は国家を歌わないんだ?」と妙な疑問を持たれないようにあくまで儀礼の一つとして身に着けておきませう、みたいなことを当時言われてたらちょっとは印象違ったかもと思ったりもするのですが。必要性さえ理解できれば、そこからは自発的行為に変わっていく可能性も期待できるわけで。

[ ツッコむ ]

#5 [anime][neta] 「戦姫絶唱シンフォギア」ってアメリカで実写ドラマ化しないものか

つい先日まで、BS-11で「戦姫絶唱シンフォギア」というアニメの1期が放送されていたので一応視聴してたのですが。なるほどコレは続編が作られるわけだなと納得を。最終回1話前のラストは、たしかに燃える。ような気がしたり。

ところで。

「アナと雪の女王」を見ながら、「どうしてこの人達、何かというとすぐに歌い始めるのかなあ。そういう病気なんだろうか」などと素朴で幼い疑問を持ちながらも、圧倒的な歌と映像のシンクロ及びコンボを目にして呆気に取られているうちに、ふと「シンフォギア」のことを思い出して。

もしかして、「シンフォギア」をアメリカで流したらウケたりしないかなと。見せ方についてはディズニーアニメと変わらん気がするわけで。ディズニーアニメは歌で城が建つけど、シンフォギアは歌でミサイルが飛ぶ…その程度の些細な違いしかないよなあ、と。

まあ、アメリカ内で、アニメとして流したのでは見る層が限られるから…。やっぱり実写ドラマ化だよなと。おそらくあちらにも自社で抱える若い娘さん達をどうにか売り出したいと考えるレコード会社の人達が絶対居るだろうから、企画内容・作品設定を聞いて「それはイイ!」「ウチの商品を前面に出せる!」と喜ぶはず…。

とは言えおそらく最初のうちは視聴者から「なんで歌いながら戦うんだよコイツラ頭おかしいんじゃないの?」てな冷たい扱いを受けるだろうけど、おそらく途中で「アレ? コレ面白いんじゃね?」「意外と燃えるんじゃね?」と気づいてしまう目利きが少しずつ増えてきて、最後のあたりはもう「みんなで歌おう!」状態に。

てな妄想をしてしまったのでメモ。

いや、ホント、「シンフォギア」ってディズニーアニメとそんなに違わないと思うんだけど…似たようなもんだよなあ…。「レリゴーレリゴー」と歌いながらモンスターをスパーンスパーンと破裂させていくいかにもアメリカンな体型の三次元美少女戦士達。全然アリでしょう。ナシですか。ですか。

ところで。

「アナと雪の女王」を見ながら、「どうしてこの人達、何かというとすぐに歌い始めるのかなあ。そういう病気なんだろうか」などと素朴で幼い疑問を持ちながらも、圧倒的な歌と映像のシンクロ及びコンボを目にして呆気に取られているうちに、ふと「シンフォギア」のことを思い出して。

もしかして、「シンフォギア」をアメリカで流したらウケたりしないかなと。見せ方についてはディズニーアニメと変わらん気がするわけで。ディズニーアニメは歌で城が建つけど、シンフォギアは歌でミサイルが飛ぶ…その程度の些細な違いしかないよなあ、と。

まあ、アメリカ内で、アニメとして流したのでは見る層が限られるから…。やっぱり実写ドラマ化だよなと。おそらくあちらにも自社で抱える若い娘さん達をどうにか売り出したいと考えるレコード会社の人達が絶対居るだろうから、企画内容・作品設定を聞いて「それはイイ!」「ウチの商品を前面に出せる!」と喜ぶはず…。

とは言えおそらく最初のうちは視聴者から「なんで歌いながら戦うんだよコイツラ頭おかしいんじゃないの?」てな冷たい扱いを受けるだろうけど、おそらく途中で「アレ? コレ面白いんじゃね?」「意外と燃えるんじゃね?」と気づいてしまう目利きが少しずつ増えてきて、最後のあたりはもう「みんなで歌おう!」状態に。

てな妄想をしてしまったのでメモ。

いや、ホント、「シンフォギア」ってディズニーアニメとそんなに違わないと思うんだけど…似たようなもんだよなあ…。「レリゴーレリゴー」と歌いながらモンスターをスパーンスパーンと破裂させていくいかにもアメリカンな体型の三次元美少女戦士達。全然アリでしょう。ナシですか。ですか。

◎ 歌ってないと死んじゃう病。 :

ディズニーキャラ達が病院のベットでゴホゴホと咳き込んで、付き添いのキャラが「早く! 早く歌うのよ! じゃないと死んじゃう!」と。ベットの上のキャラが「もう嫌! ゴホゴホ…もう歌いたくない! 私達、一体いつまで無意味に歌い続けなければいけないの!?」と。

そういうパロディが既にありそう…。サウスパークやシンプソンズでやってたりしないか…。

そういうパロディが既にありそう…。サウスパークやシンプソンズでやってたりしないか…。

[ ツッコむ ]

2017/04/05(水) [n年前の日記]

#1 [dxruby][ruby] ドット絵を自動生成するスクリプトを弄ってたり

昨日アップロードした

_tinypixelspritegenerator

を弄ってたり。わざわざマスクパターンを渡すあたりがどうも気になるので、中に何種類かマスクパターンを持っておいて、パターンの種類を文字列を渡して指定するだけでもひとまず出力できるようにしてみようと。

種類を指定して出力するソレはできたので、ついでにサイズを渡すとそのサイズに拡大して生成する処理も入れてみようと思いついて。マスクパターンを拡大すれば、それっぽくなってくれないか…。

ダメだった。境界線部分が予想以上に目立ってしまって、かなり酷い結果に。考えてみれば、1ドットの境界線が2〜3ドットになってそこに居座るのだから、目立つのは当たり前か…。

マスクパターンを拡大する処理は諦めた。大きい画像を生成したい時は、面倒臭いけどマスクパターンを渡す方向で。その代わり、出来上がったピクセルデータをニアレストネイバーで拡大できる処理を追加してみたり。ドット絵らしさが強調されるから、これはこれでアリ、かもしれない。

_画素の補間(Nearest neighbor,Bilinear,Bicubic) 画像処理ソリューション

種類を指定して出力するソレはできたので、ついでにサイズを渡すとそのサイズに拡大して生成する処理も入れてみようと思いついて。マスクパターンを拡大すれば、それっぽくなってくれないか…。

ダメだった。境界線部分が予想以上に目立ってしまって、かなり酷い結果に。考えてみれば、1ドットの境界線が2〜3ドットになってそこに居座るのだから、目立つのは当たり前か…。

マスクパターンを拡大する処理は諦めた。大きい画像を生成したい時は、面倒臭いけどマスクパターンを渡す方向で。その代わり、出来上がったピクセルデータをニアレストネイバーで拡大できる処理を追加してみたり。ドット絵らしさが強調されるから、これはこれでアリ、かもしれない。

_画素の補間(Nearest neighbor,Bilinear,Bicubic) 画像処理ソリューション

[ ツッコむ ]

2017/04/06(木) [n年前の日記]

#1 [dxruby][ruby] ドット絵を自動生成するスクリプトを更新

_tinypixelspritegenerator

を修正してアップロードしておきました。

使い方は…。

もっとそれっぽくしたいとか、あるいはもうちょっと大きい画像が欲しいときは、自前でマスクパターンを用意して渡してやってください。

使い方は…。

require_relative 'tinypixelspritegenerator'

psg = TinyPixelSpriteGenerator.new("spaceship", seed: 43291)

p psg.pixel_data

こんな感じで。最初にアップロードした版より少しは簡単に使えるようになったはず。もっとそれっぽくしたいとか、あるいはもうちょっと大きい画像が欲しいときは、自前でマスクパターンを用意して渡してやってください。

◎ 根本的な問題に気づいてしまった。 :

今頃になって気づいてしまったけど…。例えば、何かしらの本体スクリプトとは別に、このファイルも添付して配布、という形になると…。ソレって最初から画像ファイルを一つ同梱・添付しても状況として変わらないのでは、ていうかむしろ画像ファイルを添付したほうが確実なのでは、という気もしてきたり。

いやまあ、このファイル一つで、ランダムシードさえ変えれば膨大な数のドット絵モドキを出せるメリットはあるけれど。しかし、それぞれがちゃんと使えそうな見た目になってくれるのかという問題も…。

gem にして配布すれば使える場面も出てくるのだろうか。しかし、そもそも Ruby でこういうソレを使いたい場面がどれだけあるんだという疑問も…。いや待て。インストールが楽になれば、その分何かしら違う使い道が思いつく展開もあり得るのだろうか。

まあ、いいか。個人的にはこういうのって面白いし。

いやまあ、このファイル一つで、ランダムシードさえ変えれば膨大な数のドット絵モドキを出せるメリットはあるけれど。しかし、それぞれがちゃんと使えそうな見た目になってくれるのかという問題も…。

gem にして配布すれば使える場面も出てくるのだろうか。しかし、そもそも Ruby でこういうソレを使いたい場面がどれだけあるんだという疑問も…。いや待て。インストールが楽になれば、その分何かしら違う使い道が思いつく展開もあり得るのだろうか。

まあ、いいか。個人的にはこういうのって面白いし。

[ ツッコむ ]

#2 [prog] 「ここはテキトーな数を書け」的な定番の書き方ってあるのだろうか

README.md を書いているうちに、ちと疑問が湧いて。

「ココはランダムシード(疑似乱数の種)を渡せばいいですよ」と伝えたいのだけど、サンプルソース上ではどう書けばいいのだろうと。例えば、0 だの 32 だの 256 だの 65536 だの、キリのいい数値を書いてしまうと、「この数値、おそらく何か意味があるのだろう」と思われそうだなと。違うんだ。なんでもいいんだ。疑似乱数の種にするだけなんだから。でも、どうやってソレを伝えればいいのか。

プログラマーの間では、 _hoge, fuga, piyo, foo, bar 等、「ここはなんでもいいんだよ」と伝えるソレがあるけれど。「○○○○○という数値が出てきたら、どんな数値をそこに入れても良いのじゃ」的な暗黙のルールってあるのだろうか。どうなんだろ。

もしかして、数値じゃなくて「random_seed」とか変数名でも書いとけばいいのかな?

「ココはランダムシード(疑似乱数の種)を渡せばいいですよ」と伝えたいのだけど、サンプルソース上ではどう書けばいいのだろうと。例えば、0 だの 32 だの 256 だの 65536 だの、キリのいい数値を書いてしまうと、「この数値、おそらく何か意味があるのだろう」と思われそうだなと。違うんだ。なんでもいいんだ。疑似乱数の種にするだけなんだから。でも、どうやってソレを伝えればいいのか。

プログラマーの間では、 _hoge, fuga, piyo, foo, bar 等、「ここはなんでもいいんだよ」と伝えるソレがあるけれど。「○○○○○という数値が出てきたら、どんな数値をそこに入れても良いのじゃ」的な暗黙のルールってあるのだろうか。どうなんだろ。

もしかして、数値じゃなくて「random_seed」とか変数名でも書いとけばいいのかな?

◎ 一応数値版もあるらしい。 :

_メタ構文変数 - Wikipedia

を眺めてたら、気になる記述が。

知らなかった…。一応数値にも、そういうのがあるのか…。

しかしソレ、短すぎてなんだか意味がありそうな気もしてくる値だけど…。いや、でも、1byte内で表せる数値じゃないと汎用性が、てなところもあるのだろうか。

サンプルプログラムに使われる無意味な整数リテラルにも同様の概念が存在し、「23」や「42」などが用いられる。「42」は生命、宇宙、そして万物についての究極の疑問の答えに由来する。

知らなかった…。一応数値にも、そういうのがあるのか…。

しかしソレ、短すぎてなんだか意味がありそうな気もしてくる値だけど…。いや、でも、1byte内で表せる数値じゃないと汎用性が、てなところもあるのだろうか。

◎ そもそも知られてないらしい。 :

[ ツッコむ ]

#3 [cg_tools] 宇宙船っぽい2Dドット絵を自動生成するツールを試用

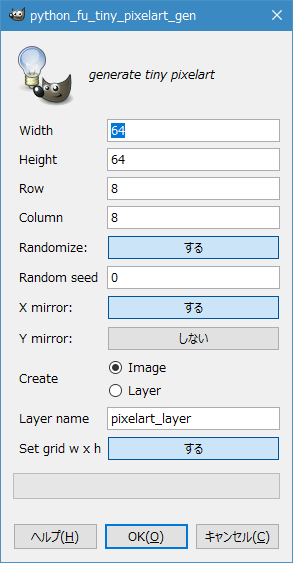

横から見て宇宙船っぽく見えるドット絵っぽい画像を自動生成してくれるツールに遭遇したので試用してみたり。Windows上で動作するツールらしい。

_Pixel Ship Generator by thydungeonsean

「Download Now」のボタンをクリックすると、「無料で使えるけど寄付してくれればサポートもできるんだけどなあ」てな感じのダイアログが開く。一応、「No thunks 〜」のリンクをクリックすればダウンロードページに行けるようで。試用してみて「これは応援したい」と思ったら寄付(?)する感じでもいいのかな。

PixelShipGenerator v1.10.zip をDLして解凍。PixelShipGenフォルダ内の PixelShipGen.exe を実行すれば起動する。

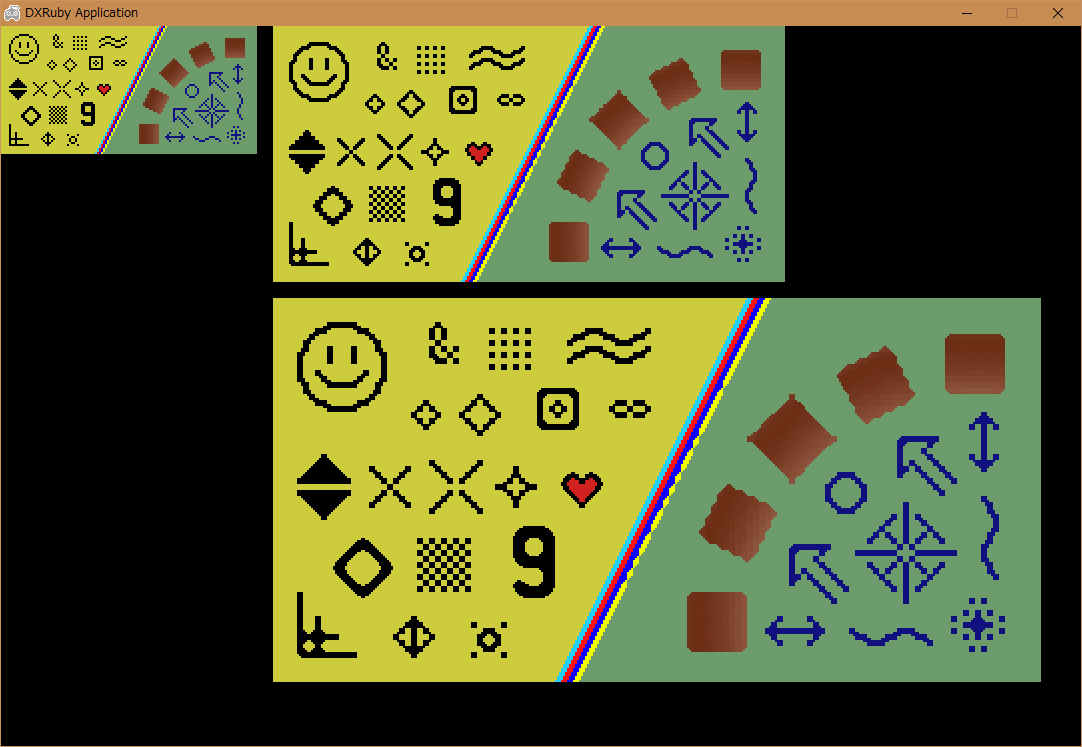

起動画面はこんな感じ。

左上の「GENERATE」をクリックすると、次々に新しい画像が生成される。「この形がカッコイイな」と思ったら、ソレをクリックすると選択できる。上のほうの「SAVE」をクリックすると、選択してるそれぞれにフロッピーディスクのアイコンがついて、exportsフォルダの中に ship30.png とか ship87.png というファイル名で画像が保存される。

_Pixel Ship Generator by thydungeonsean

「Download Now」のボタンをクリックすると、「無料で使えるけど寄付してくれればサポートもできるんだけどなあ」てな感じのダイアログが開く。一応、「No thunks 〜」のリンクをクリックすればダウンロードページに行けるようで。試用してみて「これは応援したい」と思ったら寄付(?)する感じでもいいのかな。

PixelShipGenerator v1.10.zip をDLして解凍。PixelShipGenフォルダ内の PixelShipGen.exe を実行すれば起動する。

起動画面はこんな感じ。

左上の「GENERATE」をクリックすると、次々に新しい画像が生成される。「この形がカッコイイな」と思ったら、ソレをクリックすると選択できる。上のほうの「SAVE」をクリックすると、選択してるそれぞれにフロッピーディスクのアイコンがついて、exportsフォルダの中に ship30.png とか ship87.png というファイル名で画像が保存される。

◎ 化粧してみる。 :

このままではシンプル過ぎてアレだろうけど、ざっと見た感じでは四角と円のみで構成されてるように見えるので、それぞれを安易にグラデ塗りしてみるだけでも多少違った印象になりそうな。

うむ。これはこれで。

逆に考えると…。どういうアルゴリズムで生成してるか分からんけど、四角と丸を単にグラデーションで塗り潰しながら出力するように機能を追加するだけでも雰囲気が変わりそうな。枠をつけたり等、お化粧のバリエーションは他にも色々あるけれど、ひとまずグラデだけでも効果が期待できる予感。

もっとも、レトロな2Dドット絵を目指してこういう仕様に留めている可能性も。それに、何かしらの下絵にする時は、このほうが都合がいい気もする。

うむ。これはこれで。

逆に考えると…。どういうアルゴリズムで生成してるか分からんけど、四角と丸を単にグラデーションで塗り潰しながら出力するように機能を追加するだけでも雰囲気が変わりそうな。枠をつけたり等、お化粧のバリエーションは他にも色々あるけれど、ひとまずグラデだけでも効果が期待できる予感。

もっとも、レトロな2Dドット絵を目指してこういう仕様に留めている可能性も。それに、何かしらの下絵にする時は、このほうが都合がいい気もする。

◎ 他にも見かけたソレをメモ。 :

_GameDev Resource Pick: Random Sprite Generators - EandEGames

経由で、ドット絵っぽい何かを生成するソレを他にも見かけたのでメモ。

_Sprite Generator

_Sprite Generator 1.2 - procedurally generated pixel art

_procedural graphics | Ludum Dare

アニメーションまでしている…。どういうアルゴリズムになってるんだろう…。

_Sprite Generator

_Sprite Generator 1.2 - procedurally generated pixel art

_procedural graphics | Ludum Dare

アニメーションまでしている…。どういうアルゴリズムになってるんだろう…。

[ ツッコむ ]

#4 [ruby] 正規乱数とやらが作れそうかテスト

_乱数にコクを出すアレ

が気になり始めたので Ruby + DXRuby を使ってテスト。

_「ちゃんとした正規乱数が欲しいなら Box-Muller を使うべき」 _「sin,cosとか平方根とか今時はたいして重くないし」 という主張も見かけたので、以下を参考にして Box-Muller もテスト。

_Box-Muller法による正規分布列生成 - Qiita

こんな感じのソースでどうだろう。合ってるのだろうか。

_boxmuller.rb

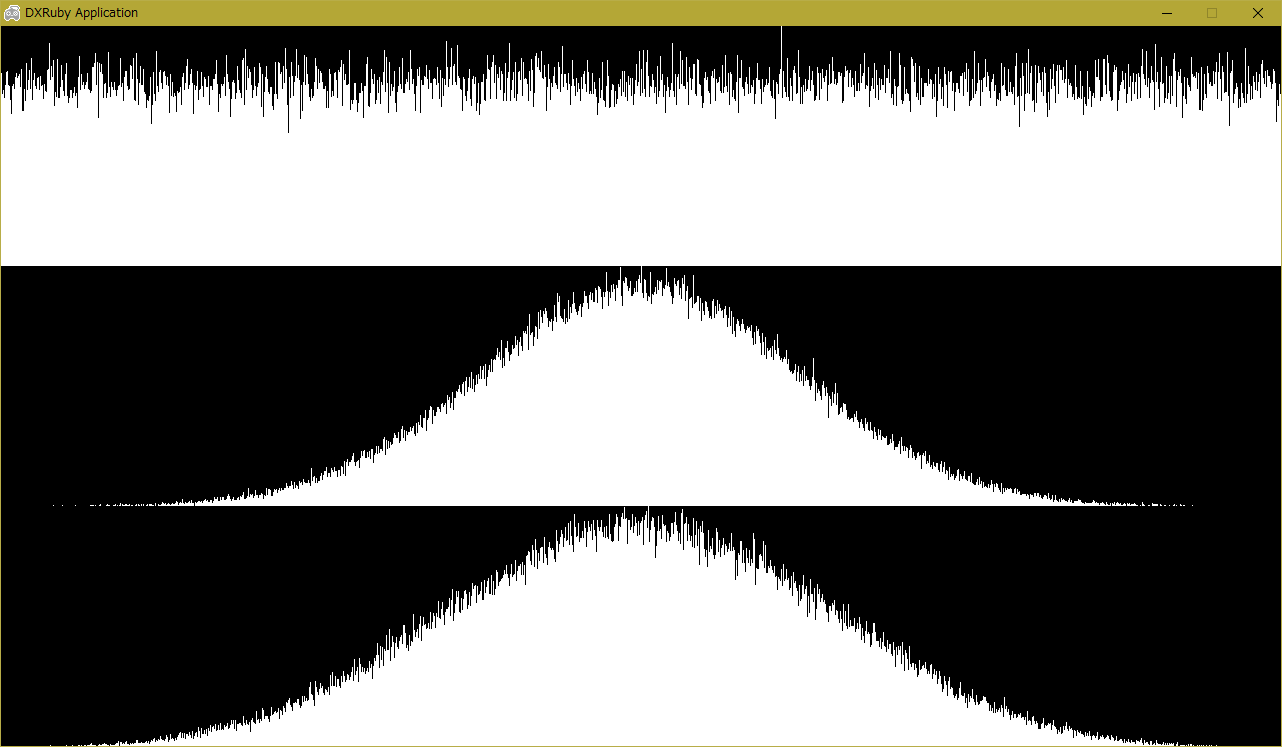

結果はこんな感じに。

上から、只の rand (= 一様分布)、Box-Muller法、乱数にコクを出すアレ。

ゲーム等で使う分には乱数にコクを出すソレでもそこそこ十分っぽい雰囲気。Box-Mullerはどこからどこまでの範囲を取るのかもちと分からんかったし…。

その後、 _「一様乱数の平均値を正規乱数として代用する」という話をゆるふわ統計的に検証する - k11i.biz で、 _Ziggurat法 なるものもあると知った。コレも試せば良かったかしらん。

_「ちゃんとした正規乱数が欲しいなら Box-Muller を使うべき」 _「sin,cosとか平方根とか今時はたいして重くないし」 という主張も見かけたので、以下を参考にして Box-Muller もテスト。

_Box-Muller法による正規分布列生成 - Qiita

こんな感じのソースでどうだろう。合ってるのだろうか。

_boxmuller.rb

# Box-Muller法による正規乱数が作れそうかどうかをテスト

require 'dxruby'

# 乱数の結果を DXRuby の Image に描き込む

def get_image(w, h, data)

# 最大カウント数を取得

m = data.max

# Imageに描き込み

img = Image.new(w, h)

w.times do |x|

cnt = (data[x] * h.to_f / m).to_i

y = h - 1

cnt.times do

img[x, y] = C_WHITE

y -= 1

end

end

return img

end

# Box-Muller法で乱数を取得

def get_box_mular(mu, sigma)

x = rand

y = rand

r = Math.sqrt(-2.0 * Math.log(x)) * Math.cos(2.0 * Math::PI * y)

return r * sigma + mu

end

w, h = 1280, 720

hh = h / 3

tc = 200000

# 一様分布になってるか確認

n = Array.new(w, 0)

tc.times do

r = (rand * w).to_i

n[r] += 1

end

nml_img = get_image(w, hh, n)

# Box-Muller法

n = Array.new(w, 0)

tc.times do

rbm = get_box_mular(0.0, 1.0)

r = (rbm * (w / 8) + (w / 2)).to_i

n[r] += 1 if r >= 0 and r < w

end

bmr_img = get_image(w, hh, n)

# 乱数にコクを出すアレ

n = Array.new(w, 0)

tc.times do

r = 0

cnt = 4

cnt.times { r += rand }

r = ((r / cnt) * w).to_i

n[r] += 1

end

kok_img = get_image(w, hh, n)

# 結果表示

Window.resize(w, h)

Window.loop do

break if Input.keyPush?(K_ESCAPE)

Window.draw(0, 0, nml_img)

Window.draw(0, hh, bmr_img)

Window.draw(0, hh + hh, kok_img)

end

結果はこんな感じに。

上から、只の rand (= 一様分布)、Box-Muller法、乱数にコクを出すアレ。

ゲーム等で使う分には乱数にコクを出すソレでもそこそこ十分っぽい雰囲気。Box-Mullerはどこからどこまでの範囲を取るのかもちと分からんかったし…。

その後、 _「一様乱数の平均値を正規乱数として代用する」という話をゆるふわ統計的に検証する - k11i.biz で、 _Ziggurat法 なるものもあると知った。コレも試せば良かったかしらん。

[ ツッコむ ]

#5 [anime] EVA旧劇場版「Air/まごころを、君に」を視聴

NHK-BSで放送されてたソレをようやく視聴。一応、昔見た記憶があるような。わざわざDVDを買った…ような気がする。もっともこの作品、色んな版があるそうで、自分が買ったのはどの版か分からんのだけど。

改めて見てみると…やっぱり凄いなと…。初見時も思ったけど、内容はともかく映像が凄いからもうこれで十分じゃないかなあ、という気分に。無理して新劇場版を作らんでも…これでええやん…。

それはともかく。NHKがモザイクをかける際の基準が分からん…。「え? そこでモザイク?」「そこよりもあっちのシーンのほうがヤバくない…?」と何度か困惑。せっかくここまで攻めたんだから「作品の時代性を尊重して」とかテキトーなテロップ出してそのまま流しちゃえば良かったのに。 *1

改めて見てみると…やっぱり凄いなと…。初見時も思ったけど、内容はともかく映像が凄いからもうこれで十分じゃないかなあ、という気分に。無理して新劇場版を作らんでも…これでええやん…。

それはともかく。NHKがモザイクをかける際の基準が分からん…。「え? そこでモザイク?」「そこよりもあっちのシーンのほうがヤバくない…?」と何度か困惑。せっかくここまで攻めたんだから「作品の時代性を尊重して」とかテキトーなテロップ出してそのまま流しちゃえば良かったのに。 *1

*1: 今となっては、こんなアレなソレに熱狂しちゃってた若者達が当時居たんだよ、てな状況自体が貴重な記録になっていくだろうと思うわけで、そのためには「うげえ。こんなもんを当時見てたのかよ。作ったヤツラも見てたヤツラも気持ち悪い」と今時の若い視聴者がゲンナリする映像をそのまま流したほうが、それこそ当時の「社会現象としてのEVA」を的確に伝えてくれるのでは、などと思ったり思わなかったり。とは言え今回「妙なところで保身に走るNHKという組織」「所詮はNHK」の記録になってたような気もしてきてこれはこれでアリかも、などと思えてきたりもして。いやまあ、「伝えることには妥協しないNHK」「さすがNHK」を目撃したかった気もしますが…。コレを放送しただけでも「一体どうしたNHK」「気はたしかなのかNHK」ってところもあるわけで…。

[ ツッコむ ]

2017/04/07(金) [n年前の日記]

#1 [dxruby][ruby] ドット絵モドキを自動生成するソレを自分でも考えて試したり

ドット絵というか PixelArt というかソレっぽいものを自動生成するアレコレを眺めているうちに、もしかして乱数でテキトーにドットを打つだけでもそれっぽくなるんじゃないかと安易に思えてきたので一応試してみたり。Ruby + DXRuby で実験。

◎ 乱数でテキトーにドットを打つだけの版。 :

まずは本当に、乱数でテキトーにドットを打ってみた。

_tinypixelartgen_take1.rb

結果は以下。

うむ。完全に甘かった。全く話にならない。ダメだこりゃ。

_tinypixelartgen_take1.rb

# ドット絵自動生成のテスト

#

# License : CC0 / Public Domain

class TinyPixelArtGen

attr_accessor :pixels

def initialize(w, h, mirror_x: true, mirror_y: false, seed: 0, color: 8)

srand(seed)

@color = color

@w, @h = w, h

@mirror_x, @mirror_y = mirror_x, mirror_y

@canvas = Array.new(@h).map { Array.new(@w, 0) }

@pixels = Array.new(@h).map { Array.new(@w).map { Array.new(4, 0) } }

ww, hh = (@w / 2.0).round, (@h / 2.0).round

wwf, hhf = @w % 2, @h % 2

# generate dot pattern

@h.times do |y|

@w.times do |x|

@canvas[y][x] = rand(@color)

end

end

# generate palette

@pal = Array.new(@color)

@pal.size.times do |i|

if i == 0

r, g, b, a = 0, 0, 0, 0

elsif i == 1

r, g, b, a = 0, 0, 0, 255

elsif i == @pal.size - 1

r, g, b, a = 255, 255, 255, 255

else

r, g, b = rand(256), rand(256), rand(256)

a = 255

end

@pal[i] = [r, g, b, a]

end

# make pixel data

@h.times do |y|

@w.times do |x|

sx, sy = x, y

sx = (x >= ww and @mirror_x)? (ww - 1 - wwf - (x - ww)) : x

sy = (y >= hh and @mirror_y)? (hh - 1 - hhf - (y - hh)) : y

r, g, b, a = @pal[@canvas[sy][sx]]

@pixels[y][x] = [r, g, b, a]

end

end

end

end

if $0 == __FILE__

# ----------------------------------------

require 'dxruby'

def conv_pixels_to_image(pixels)

w, h = pixels[0].size, pixels.size

img = Image.new(w, h, [0, 0, 0, 0])

h.times do |y|

w.times do |x|

r, g, b, a = pixels[y][x]

img[x, y] = [a, r, g, b]

end

end

return img

end

def generate_images(n, seed)

sz = 16

imgs = []

n.times do |i|

pat = TinyPixelArtGen.new(

sz, sz,

mirror_x: (rand > 0.5)? true : false,

mirror_y: (rand > 0.5)? true : false,

seed: seed + i,

color: 8

)

imgs.push(conv_pixels_to_image(pat.pixels))

end

return imgs

end

Window.resize(640, 480)

Window.bgcolor = [32, 128, 196]

Window.minFilter = TEXF_POINT

Window.magFilter = TEXF_POINT

cnt = 96

seed = 0

imgs = generate_images(cnt, seed)

seed += cnt

Window.loop do

break if Input.keyPush?(K_ESCAPE)

if Input.keyPush?(K_SPACE)

imgs = generate_images(cnt, seed)

seed += cnt

end

scale = 3

border = 4

x, y = 0, 0

imgs.each do |img|

Window.drawScale(x, y, img, scale, scale, 0, 0)

x += img.width * scale + border

if (x + img.width * scale) >= Window.width

x = 0

y += img.height * scale + border

end

end

end

end

結果は以下。

うむ。完全に甘かった。全く話にならない。ダメだこりゃ。

◎ 輪郭を与えてみた。 :

sinカーブを使って、ざっくりとした形っぽいものを与えてみた。かつ、最後にエッジ(境界線)を追加してみた。

_tinypixelartgen_take2.rb

結果は以下。

むっ。ちょっとはマシになってきた、そんな気がしないでもない。

が、これは 16x16ドットで生成して3倍に拡大表示してるからそれっぽく見えている、てなところもあって。例えば、32x32ドットで生成してみると…。

「なんじゃこりゃああ!(ジーパン刑事風に)」度が増してしまってダメダメ状態に近づいていくなと。

_tinypixelartgen_take2.rb

# ドット絵自動生成のテスト

# sinカーブで型を与えて生成、かつ、境界線を付加してみる

#

# License : CC0 / Public Domain

class TinyPixelArtGen

attr_accessor :pixels

def initialize(w, h, mirror_x: true, mirror_y: false, seed: 0, color: 8)

srand(seed)

@color = color

@w, @h = w, h

@mirror_x, @mirror_y = mirror_x, mirror_y

@canvas = Array.new(@h).map { Array.new(@w, 0) }

@pixels = Array.new(@h).map { Array.new(@w).map { Array.new(4, 0) } }

ww, hh = (@w / 2.0).round, (@h / 2.0).round

wwf, hhf = @w % 2, @h % 2

# generate dot pattern

ang = rand(360)

ang_d = rand(270.0 / @h) + (45.0 / @h)

(1..(@h-2)).each do |y|

rad = (ang + (ang_d * y)) * Math::PI / 180.0

rw = (((w * 4 / 10.0 - 1) * Math.sin(rad)).to_i + (w * 5 / 10.0)) * 2

rx = (w - rw) / 2

@w.times do |x|

xx = rand(rw) + rx

@canvas[y][xx] = rand(@color)

end

end

# generate edge

@h.times do |y|

@w.times do |x|

next if @canvas[y][x] <= 1

@canvas[y - 1][x] = 1 if (y - 1 >= 0 and @canvas[y - 1][x] == 0)

@canvas[y + 1][x] = 1 if (y + 1 < @h and @canvas[y + 1][x] == 0)

@canvas[y][x - 1] = 1 if (x - 1 >= 0 and @canvas[y][x - 1] == 0)

@canvas[y][x + 1] = 1 if (x + 1 < @w and @canvas[y][x + 1] == 0)

end

end

# generate palette

@pal = Array.new(@color)

rr, gg, bb = rand(128), rand(128), rand(128)

@pal.size.times do |i|

if i == 0

r, g, b, a = 0, 0, 0, 0

elsif i == 1

r, g, b, a = 0, 0, 0, 255

elsif i == (@pal.size - 1)

c = 255 - rand(48)

r, g, b, a = c, c, c, 255

else

r = rr + rand(128)

g = gg + rand(128)

b = bb + rand(128)

a = 255

end

@pal[i] = [r, g, b, a]

end

# make pixel data

@h.times do |y|

@w.times do |x|

sx, sy = x, y

sx = (x >= ww and @mirror_x)? (ww - 1 - wwf - (x - ww)) : x

sy = (y >= hh and @mirror_y)? (hh - 1 - hhf - (y - hh)) : y

r, g, b, a = @pal[@canvas[sy][sx]]

@pixels[y][x] = [r, g, b, a]

end

end

end

end

if $0 == __FILE__

# ----------------------------------------

require 'dxruby'

def conv_pixels_to_image(pixels)

w, h = pixels[0].size, pixels.size

img = Image.new(w, h, [0, 0, 0, 0])

h.times do |y|

w.times do |x|

r, g, b, a = pixels[y][x]

img[x, y] = [a, r, g, b]

end

end

return img

end

def generate_images(n, seed)

sz = 16

imgs = []

n.times do |i|

pat = TinyPixelArtGen.new(

sz, sz,

mirror_x: (rand > 0.5)? true : false,

mirror_y: (rand > 0.5)? true : false,

seed: seed + i,

color: 8

)

imgs.push(conv_pixels_to_image(pat.pixels))

end

return imgs

end

Window.resize(640, 480)

Window.bgcolor = [32, 128, 196]

Window.minFilter = TEXF_POINT

Window.magFilter = TEXF_POINT

cnt = 96

seed = 0

imgs = generate_images(cnt, seed)

seed += cnt

Window.loop do

break if Input.keyPush?(K_ESCAPE)

if Input.keyPush?(K_SPACE)

imgs = generate_images(cnt, seed)

seed += cnt

end

scale = 3

x, y = 0, 0

imgs.each do |img|

Window.drawScale(x, y, img, scale, scale, 0, 0)

x += img.width * scale + 4

if (x + img.width * scale) >= Window.width

x = 0

y += img.height * scale + 4

end

end

end

end

結果は以下。

むっ。ちょっとはマシになってきた、そんな気がしないでもない。

が、これは 16x16ドットで生成して3倍に拡大表示してるからそれっぽく見えている、てなところもあって。例えば、32x32ドットで生成してみると…。

「なんじゃこりゃああ!(ジーパン刑事風に)」度が増してしまってダメダメ状態に近づいていくなと。

◎ 小さく作って拡大するのはどうだろう。 :

世の中には、昔の荒いドット絵を如何にそれらしく綺麗に拡大するか、てなアルゴリズムがいくつか存在していて。

_Scale2x

_Scale2x Algorithm

_HiEnd3D - hq3x (Internet Archive)

_Pixel Scalers

_Pixel art scaling algorithms - Wikipedia

もしかすると、小さいサイズで自動生成しておいて、そこからこれらのアルゴリズムで拡大、みたいなことをすれば多少はそれらしくなる、かもしれないと夢想してみたりもして。となると、まずはこれらのアルゴリズムを試しに書いて実験してみて、かな…。

_Scale2x

_Scale2x Algorithm

_HiEnd3D - hq3x (Internet Archive)

_Pixel Scalers

_Pixel art scaling algorithms - Wikipedia

もしかすると、小さいサイズで自動生成しておいて、そこからこれらのアルゴリズムで拡大、みたいなことをすれば多少はそれらしくなる、かもしれないと夢想してみたりもして。となると、まずはこれらのアルゴリズムを試しに書いて実験してみて、かな…。

◎ 最初から意味がありそうな断片を配置するのはどうだろう。 :

例えば四角を、それもグラデ塗りした四角を、ランダムにテキトーに場所にいくつか配置していって、ソレを横方向 or 縦方向で反転描画するだけでもそれっぽくならないだろうか。そのためには、四角をグラデ塗りする処理を書いてみて…かな…。明度、いや、輝度がちゃんと変わっていかないと立体感のあるグラデにならないだろうから、色相、彩度、輝度からRGB値を求める処理(HSL → RGB変換)も書いてみないと…。

[ ツッコむ ]

#2 [anime] 「AKIBA'S TRIP」アニメ版最終回を視聴

面白かった…。カットが変わるとパロディ、またカットが変わると別のパロディ、みたいな。よくまあここまでツッコめるもんだなと…。秋葉原を舞台にした作品らしいというか…。

[ ツッコむ ]

2017/04/08(土) [n年前の日記]

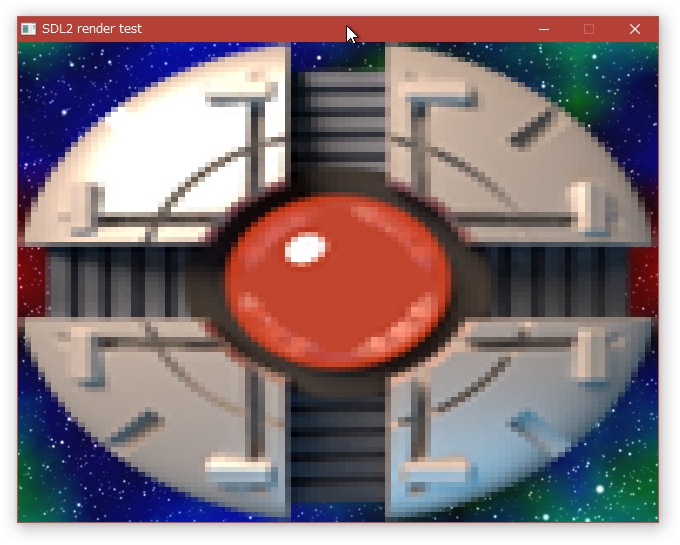

#1 [dxruby][ruby] Scale2x や Scale3x をRubyで書いてみたり

Ruby + DXRuby を使って、ドット絵専用の整数倍拡大アルゴリズム、Scale2x や Scale3x の処理を書いて試してみたり。

以下のページに書かれてる内容をそのままコピペ。

_Scale2x Algorithm

画像端の部分を読み取る際に、元画像をはみ出しながら読み取ろうとしてしまうので、ちょっと一手間入れる必要が。本来、画像端とソレ以外でループを分けて速度面の最適化をすべきだろうけど、動くかどうかをひとまず試したいだけなので遅くなるのは分かってるけど安易な書き方を。

ソースはこんな感じに。

_scalenx.rb

テスト用画像は、 _Hq3x - Oss4art で紹介されてる画像を使わせてもらったり。消えるとアレなので転載させてください…。

_hq3x_original.png

ruby scalenx.rb で実行すると、こんな結果に。

一応実装できた、ような気がする。

コレ、ライセンスはどうなるのかな…。 _scale2x-4.0.tar.gz をDLして中身を見てみたら、COPYING に GPL と書いてあったので、コレも GPL になるのだろうか。たぶん。自分が書いて公開・配布するアレコレは、できれば CC0 / Public Domain にしたいけど、コレを使ってしまうとソレができないなと…。これもいわゆるGPL汚染、だろうか…。

書いた後で気が付いたけど、 _Scale2x のページで、「Scale2x の結果と EPX の結果は全く同じになるんやで」と説明が。EPX を書いてみるべきだったか…。8点ではなくて4点を見るだけで済むみたいだし…。

以下のページに書かれてる内容をそのままコピペ。

_Scale2x Algorithm

画像端の部分を読み取る際に、元画像をはみ出しながら読み取ろうとしてしまうので、ちょっと一手間入れる必要が。本来、画像端とソレ以外でループを分けて速度面の最適化をすべきだろうけど、動くかどうかをひとまず試したいだけなので遅くなるのは分かってるけど安易な書き方を。

ソースはこんな感じに。

_scalenx.rb

# pixel scalking , Scale2x, Scale3x

module ScaleNx

# pixel scaling, Scale2x

# @param src [Array<Array>] pixel data array

# @return [Array<Array>] 2x pixel data array

def scale2x(src)

width, height = src[0].size, src.size

nwidth, nheight = width * 2, height * 2

dst = Array.new(nheight).map { Array.new(nwidth).map { Array.new(4, 0) } }

height.times do |y|

width.times do |x|

e = src[y][x]

d = (x - 1 >= 0)? src[y][x - 1] : e

f = (x + 1 < width)? src[y][x + 1] : e

if y - 1 >= 0

b = src[y - 1][x]

a = (x - 1 >= 0)? src[y - 1][x - 1] : b

c = (x + 1 < width)? src[y - 1][x + 1] : b

else

a = d

b = e

c = f

end

if y + 1 < height

h = src[y + 1][x]

g = (x - 1 >= 0)? src[y + 1][x - 1] : h

i = (x + 1 < width)? src[y + 1][x + 1] : h

else

g = d

h = e

i = f

end

if b != h && d != f

e0 = (d == b)? d : e

e1 = (b == f)? f : e

e2 = (d == h)? d : e

e3 = (h == f)? f : e

else

e0 = e

e1 = e

e2 = e

e3 = e

end

dx = x * 2

dy = y * 2

dst[dy][dx] = e0

dst[dy][dx + 1] = e1

dst[dy + 1][dx] = e2

dst[dy + 1][dx + 1] = e3

end

end

return dst

end

# pixel scaling, Scale3x

# @param src [Array<Array>] pixel data array

# @return [Array<Array>] 3x pixel data array

def scale3x(src)

width, height = src[0].size, src.size

nwidth, nheight = width * 3, height * 3

dst = Array.new(nheight).map { Array.new(nwidth).map { Array.new(4, 0) } }

height.times do |y|

width.times do |x|

e = src[y][x]

d = (x - 1 >= 0)? src[y][x - 1] : e

f = (x + 1 < width)? src[y][x + 1] : e

if y - 1 >= 0

b = src[y - 1][x]

a = (x - 1 >= 0)? src[y - 1][x - 1] : b

c = (x + 1 < width)? src[y - 1][x + 1] : b

else

a = d

b = e

c = f

end

if y + 1 < height

h = src[y + 1][x]

g = (x - 1 >= 0)? src[y + 1][x - 1] : h

i = (x + 1 < width)? src[y + 1][x + 1] : h

else

g = d

h = e

i = f

end

if b != h and d != f

e0 = (d == b)? d : e

e1 = ((d == b and e != c) or (b == f and e != a))? b : e

e2 = (b == f)? f : e

e3 = ((d == b and e != g) or (d == h and e != a))? d : e

e4 = e

e5 = ((b == f and e != i) or (h == f and e != c))? f : e

e6 = (d == h)? d : e

e7 = ((d == h and e != i) or (h == f and e != g))? h : e

e8 = (h == f)? f : e

else

e0 = e

e1 = e

e2 = e

e3 = e

e4 = e

e5 = e

e6 = e

e7 = e

e8 = e

end

dx = x * 3

dy = y * 3

dst[dy][dx] = e0

dst[dy][dx + 1] = e1

dst[dy][dx + 2] = e2

dst[dy + 1][dx] = e3

dst[dy + 1][dx + 1] = e4

dst[dy + 1][dx + 2] = e5

dst[dy + 2][dx] = e6

dst[dy + 2][dx + 1] = e7

dst[dy + 2][dx + 2] = e8

end

end

return dst

end

end

if $0 == __FILE__

# ----------------------------------------

require 'dxruby'

include ScaleNx

# convert DXRuby Image to array

def conv_image2array(img)

w, h = img.width, img.height

data = []

h.times do |y|

dt = []

w.times do |x|

a, r, g, b = img[x, y]

dt.push([r, g, b, a])

end

data.push(dt)

end

return data

end

# convert array to DXRuby Image

def conv_array2image(src)

w, h = src[0].size, src.size

img = Image.new(w, h, [0, 0, 0, 0])

h.times do |y|

src[y].each_with_index do |v, x|

r, g, b, a = v

img[x, y] = [a, r, g, b]

end

end

return img

end

srcimg = Image.load("hq3x_original.png")

src = conv_image2array(srcimg)

dst = scale2x(src)

dstimg2x = conv_array2image(dst)

dst = scale3x(src)

dstimg3x = conv_array2image(dst)

Window.resize(540, 360)

Window.minFilter = TEXF_POINT

Window.magFilter = TEXF_POINT

Window.scale = 2

Window.loop do

break if Input.keyPush?(K_ESCAPE)

x, y = 0, 0

Window.draw(0, 0, srcimg)

x += srcimg.width + 8

Window.draw(x, y, dstimg2x)

y += dstimg2x.height + 8

Window.draw(x, y, dstimg3x)

end

end

テスト用画像は、 _Hq3x - Oss4art で紹介されてる画像を使わせてもらったり。消えるとアレなので転載させてください…。

_hq3x_original.png

ruby scalenx.rb で実行すると、こんな結果に。

一応実装できた、ような気がする。

コレ、ライセンスはどうなるのかな…。 _scale2x-4.0.tar.gz をDLして中身を見てみたら、COPYING に GPL と書いてあったので、コレも GPL になるのだろうか。たぶん。自分が書いて公開・配布するアレコレは、できれば CC0 / Public Domain にしたいけど、コレを使ってしまうとソレができないなと…。これもいわゆるGPL汚染、だろうか…。

書いた後で気が付いたけど、 _Scale2x のページで、「Scale2x の結果と EPX の結果は全く同じになるんやで」と説明が。EPX を書いてみるべきだったか…。8点ではなくて4点を見るだけで済むみたいだし…。

◎ hqxも試してみたいけど。 :

hq2x、hq3x、hq4x も試してみたいけど、ソースをググってみたらなかなか複雑な感じで…。

一応、関連ページをメモ。

_Pixel art scaling algorithms - Wikipedia

_hqx - Wikipedia

_hq2x - HiEnd3D (Internet Archive)

_hq3x - HiEnd3D (Internet Archive)

_hq4x - HiEnd3D (Internet Archive)

_Usage - Arcnor/hqx-java Wiki

_Arcnor/hqx-java

ちなみに、hqx も GPL らしい。

一応、関連ページをメモ。

_Pixel art scaling algorithms - Wikipedia

_hqx - Wikipedia

_hq2x - HiEnd3D (Internet Archive)

_hq3x - HiEnd3D (Internet Archive)

_hq4x - HiEnd3D (Internet Archive)

_Usage - Arcnor/hqx-java Wiki

_Arcnor/hqx-java

ちなみに、hqx も GPL らしい。

◎ 処理をまとめたツールがあるらしい。 :

_2dimagefilter - Google Code Archive

_2dimagefilter by Hawkynt

_2dimagefilter - ImageResizer.wiki - Google Code Archive

GUI もしくは CUI で各アルゴリズムを試せる模様。ImageResizer-r133.exe をDLして実行してみたけど、Scale3x や hq3x が動くことを確認できた。

_2dimagefilter by Hawkynt

_2dimagefilter - ImageResizer.wiki - Google Code Archive

GUI もしくは CUI で各アルゴリズムを試せる模様。ImageResizer-r133.exe をDLして実行してみたけど、Scale3x や hq3x が動くことを確認できた。

[ ツッコむ ]

2017/04/09(日) [n年前の日記]

#1 [dxruby][ruby] ドット絵モドキを自動生成するRubyスクリプトを少し手直し

ドット絵モドキを自動生成するソレを Ruby + DXRuby で試しているところ。

_先日の実験 では、乱数でテキトーにドットを打っていくという安易なやり方でも、

結果はこんな感じに。前回は3倍表示してたけど、コレは原寸表示。(16x16 を Scale3x で3倍に拡大して生成。

意外とイケそうな…でもないかな…どうなんだ…ちと判断が難しい微妙な結果に。

ちなみに、8倍に拡大するとこんな感じに。

これはこれで味わい深い…のかな…どうなんだ…。

_先日の実験 では、乱数でテキトーにドットを打っていくという安易なやり方でも、

- 生成サイズを 8x8 〜 16x16ドットぐらいに小さくしておく。

- 輪郭と言うか、型と言うか、シルエットを大まかに決めておく。(今回はsinカーブで決めている)

- 境界線(黒い縁)をつける。

- 使う色数を少なくしておく。

結果はこんな感じに。前回は3倍表示してたけど、コレは原寸表示。(16x16 を Scale3x で3倍に拡大して生成。

意外とイケそうな…でもないかな…どうなんだ…ちと判断が難しい微妙な結果に。

ちなみに、8倍に拡大するとこんな感じに。

これはこれで味わい深い…のかな…どうなんだ…。

◎ ソースについて。 :

ソースは以下。tinypixelartgen_take3.rb と scalenx.rb の2つが必要。

_tinypixelartgen_take3.rb

_scalenx.rb

Ruby + DXRuby がインストールされてる環境で、ruby tinypixelartgen_take3.rb を実行すると生成される。スペースキーを押せば次々に生成し直し。

_tinypixelartgen_take3.rb

_scalenx.rb

Ruby + DXRuby がインストールされてる環境で、ruby tinypixelartgen_take3.rb を実行すると生成される。スペースキーを押せば次々に生成し直し。

◎ ライセンス面での問題。 :

惜しむらくは、Scale2x、Scale3x がGPLなので、Scale2x、Scale3x を利用してるこのドット絵自動生成スクリプトも GPL になるあたりが厳しいなと。いわゆるGPL汚染。

このスクリプトを何かに組み込んで利用したいと思っても、おそらくはそのアプリ全体までGPLで配布しないといけないのだろうと…。MIT License や CC0 / Public Domain に比べると、GPLは不便と言うか不自由だなと。

ん? 待てよ? 自分は _Scale2xのアルゴリズム解説ページ を参考にしてソースを書いたけど、 _Scale2x の exe のソース は一切見ないでソースを書いたわけで…。それでもこのスクリプトはGPLになるんだろうか?

いや、でも…。処理の肝心要の部分を解説ページ中から丸々コピペしてるのだから、コレはやっぱり GPL になるのかしらん。どうなんだろう。

まあ、ニアレストネイバー(Nearest neighbor)で拡大したほうがドットが強調されてドット絵らしさが増すのでは、という気もするので、いざとなれば Scale2x を使ってるあたりをゴッソリ削除してもいいんじゃないか、そうなれば自由に使えるやろ、と思ったりもしますが。

このスクリプトを何かに組み込んで利用したいと思っても、おそらくはそのアプリ全体までGPLで配布しないといけないのだろうと…。MIT License や CC0 / Public Domain に比べると、GPLは不便と言うか不自由だなと。

ん? 待てよ? 自分は _Scale2xのアルゴリズム解説ページ を参考にしてソースを書いたけど、 _Scale2x の exe のソース は一切見ないでソースを書いたわけで…。それでもこのスクリプトはGPLになるんだろうか?

いや、でも…。処理の肝心要の部分を解説ページ中から丸々コピペしてるのだから、コレはやっぱり GPL になるのかしらん。どうなんだろう。

まあ、ニアレストネイバー(Nearest neighbor)で拡大したほうがドットが強調されてドット絵らしさが増すのでは、という気もするので、いざとなれば Scale2x を使ってるあたりをゴッソリ削除してもいいんじゃないか、そうなれば自由に使えるやろ、と思ったりもしますが。

◎ 課題というか別の疑問。 :

「5x5ドットぐらいなら横方向3ドット分を作ってミラーするだけでもそれっぽくなるよ」てな方法があるのだけど。

_Space Invader Generator | The 8Bit Pimps Pixel Mine

たしか、GitHubのアイコンも同様の手法で生成されてたと思ったけど。

_Identicons!

それらの各1ドットに、事前に用意した8x8ドットのパターンをランダムに置いていったらどうなるかなと疑問が。例えば以下のようなパターンを使って…。

_mieki256's diary - DXRubyでキャラグラエディタを作ってみた

どうなるんでしょうね。

_Space Invader Generator | The 8Bit Pimps Pixel Mine

たしか、GitHubのアイコンも同様の手法で生成されてたと思ったけど。

_Identicons!

それらの各1ドットに、事前に用意した8x8ドットのパターンをランダムに置いていったらどうなるかなと疑問が。例えば以下のようなパターンを使って…。

_mieki256's diary - DXRubyでキャラグラエディタを作ってみた

どうなるんでしょうね。

[ ツッコむ ]

#2 [ruby] 配列の初期化って時間がかかるのだな

昨日書いた Scale2x の処理を行う Ruby スクリプトを、もうちょっと最適化できないものかと弄っていたのだけど。

ループ内をアレコレ弄って「あまり速くならねえな」とガッカリした直後、ふと、配列の初期化はしなくてもいいんじゃないかと気が付いて。配列の確保だけするようにしてみたら処理時間が二桁減って愕然。 *1

配列の初期化って結構処理時間を食うのだな…。いやまあ、メモリを確保して中身を書き換えていくわけだから当然だろうけど。にしても、まさか条件分岐が山ほど入ってるループ処理部分より配列の初期化で時間を食ってたとは…。

ループ内をアレコレ弄って「あまり速くならねえな」とガッカリした直後、ふと、配列の初期化はしなくてもいいんじゃないかと気が付いて。配列の確保だけするようにしてみたら処理時間が二桁減って愕然。 *1

配列の初期化って結構処理時間を食うのだな…。いやまあ、メモリを確保して中身を書き換えていくわけだから当然だろうけど。にしても、まさか条件分岐が山ほど入ってるループ処理部分より配列の初期化で時間を食ってたとは…。

◎ 測ってみた。 :

こんな感じで。環境は Windows10 x64 + Ruby 2.2.6-p396 mingw32版。

結果。

配列の中身をゼロクリアするとやっぱり遅くなるようで…。多次元配列じゃなく一次元配列にしてゼロクリアしたら速くならないか、と思ったけど甘かった。でもないか。いや、しかし、多次元配列の確保より、一次元配列でゼロクリアするほうが遅いんだよな…。

ちなみに、Ruby 2.2 ではなく Ruby 2.3 でも試してみたけど、さほど違いは無く。ていうかむしろ微妙に遅くなったり。まあ、誤差かもしれないけど。

# Array.new のベンチマーク

require 'benchmark'

w, h = 512, 256

Benchmark.bm(7) do |x|

# 最初にやってたソレ

x.report("[][][]") do

a = Array.new(h).map { Array.new(w).map { Array.new(4, 0) } }

end

# 書き方を変えてみた

x.report("[][][]B") do

a = Array.new(h) { Array.new(w) { Array.new(4, 0) } }

end

# ループを馬鹿みたいに回してみた

x.report("loop") do

a = []

h.times do

b = []

w.times do

b << [0, 0, 0, 0]

end

a << b

end

end

# 初期化を省いた

x.report("[][]") do

a = Array.new(h).map { Array.new(w) }

end

# 一次元配列にしてみた

x.report("[]") do

a = Array.new(w * h * 4, 0)

end

end

結果。

user system total real [][][] 0.047000 0.000000 0.047000 ( 0.049730) [][][]B 0.047000 0.000000 0.047000 ( 0.041508) loop 0.031000 0.000000 0.031000 ( 0.032914) [][] 0.000000 0.000000 0.000000 ( 0.000188) [] 0.000000 0.000000 0.000000 ( 0.000549)

配列の中身をゼロクリアするとやっぱり遅くなるようで…。多次元配列じゃなく一次元配列にしてゼロクリアしたら速くならないか、と思ったけど甘かった。でもないか。いや、しかし、多次元配列の確保より、一次元配列でゼロクリアするほうが遅いんだよな…。

ちなみに、Ruby 2.2 ではなく Ruby 2.3 でも試してみたけど、さほど違いは無く。ていうかむしろ微妙に遅くなったり。まあ、誤差かもしれないけど。

*1: もっとも、渡された配列の中身をそのまま使う形になった ―― ポインタだけを書き換えてる形になったようなものだから、元の配列の内容を弄られるとおかしなことになるけれど、それは元々そうなってたから今更だし。

[ ツッコむ ]

#3 [ruby][dxruby] RGBとHLS(HSL)を変換するRubyスクリプトを書いた

グラデ塗りを試す際に必要になりそうだったので、RGBと

_HLS(HSL)

を変換するRubyスクリプトを書いた。

HLSてのは…。、Hue(色相)、Lightness(輝度)、Saturation(彩度)で色を表す例のヤツ、という説明でいいのだろうか。お絵かきソフトでえてして用意されてたりするアレ。とはちょっと違うか。アレは _HSV か…。

とりあえず、変換処理のソースは以下。

_tinycolorsys.rb

_RGBとHSLの相互変換ツールと変換計算式 - PEKO STEP の解説を参考にして書きました。ありがたや。

使用例。

DXRuby を使って、マウスのx/y座標やカーソルキーの上下でHLSの値を変えて、背景色を変更してる。

require_relative 'tinycolorsys' を呼んで、include TinyColorSys しておくと、hls_to_rgb() と rgb_to_hls() が使えるようになる。

_test_colorsys.rb

HLSてのは…。、Hue(色相)、Lightness(輝度)、Saturation(彩度)で色を表す例のヤツ、という説明でいいのだろうか。お絵かきソフトでえてして用意されてたりするアレ。とはちょっと違うか。アレは _HSV か…。

とりあえず、変換処理のソースは以下。

_tinycolorsys.rb

_RGBとHSLの相互変換ツールと変換計算式 - PEKO STEP の解説を参考にして書きました。ありがたや。

使用例。

DXRuby を使って、マウスのx/y座標やカーソルキーの上下でHLSの値を変えて、背景色を変更してる。

require_relative 'tinycolorsys' を呼んで、include TinyColorSys しておくと、hls_to_rgb() と rgb_to_hls() が使えるようになる。

_test_colorsys.rb

# tinycolorsys.rb の動作テスト

require 'dxruby'

require_relative 'tinycolorsys'

include TinyColorSys

fnt = Font.new(28)

v2 = 0.5

set_hls = true

Window.loop do

break if Input.keyPush?(K_ESCAPE)

set_hls = !set_hls if Input.mousePush?(M_LBUTTON)

v0 = Input.mousePosX.to_f / (Window.width - 1)

v1 = Input.mousePosY.to_f / (Window.height - 1)

v2 += (Input.keyDown?(K_UP))? (1.0 / 255.0) : 0

v2 -= (Input.keyDown?(K_DOWN))? (1.0 / 255.0) : 0

v0 = [[v0, 1.0].min, 0.0].max

v1 = [[v1, 1.0].min, 0.0].max

v2 = [[v2, 1.0].min, 0.0].max

if set_hls

h = v0

l = v1

s = v2

r, g, b = hls_to_rgb(h, l, s)

h = (h * 360).to_i

l = (l * 100).to_i

s = (s * 100).to_i

else

r = (v0 * 255).to_i

g = (v1 * 255).to_i

b = (v2 * 255).to_i

h, l, s = rgb_to_hls(r, g, b)

h = (360 * h).to_i

l = (100 * l).to_i

s = (100 * s).to_i

end

Window.bgcolor = [r, g, b]

col = (l < 50)? C_WHITE : C_BLACK

msg = (set_hls)? "use HLS" : "use RGB"

Window.drawFont(4, 4, msg, fnt, :color => col)

Window.drawFont(4, 40, "RGB=#{r}, #{g}, #{b}", fnt, :color => col)

Window.drawFont(4, 80, "HLS=#{h}, #{l}, #{s}", fnt, :color => col)

Window.drawFont(4, 120, "(mouse x/y , Up/Down key)", fnt, :color => col)

end

◎ 既にgemがあった。 :

上記のスクリプトを書いた後で、ふと気になってググってみたら、既にそういう gem があった…。自分で書く必要は無かった…。

_color | RubyGems.org | your community gem host

_halostatue/color: Color tools for Ruby.

gem install color でインストールできる。

以下は、前述のソレを color を使って書き直した例。

ホント、最初からコレを使えばよかった…。

_color | RubyGems.org | your community gem host

_halostatue/color: Color tools for Ruby.

gem install color でインストールできる。

以下は、前述のソレを color を使って書き直した例。

# gem color の動作テスト

require 'dxruby'

require 'color'

fnt = Font.new(28)

v2 = 0.5

set_hls = true

Window.loop do

break if Input.keyPush?(K_ESCAPE)

set_hls = !set_hls if Input.mousePush?(M_LBUTTON)

v0 = Input.mousePosX.to_f / (Window.width - 1)

v1 = Input.mousePosY.to_f / (Window.height - 1)

v2 += (Input.keyDown?(K_UP))? (1.0 / 255.0) : 0

v2 -= (Input.keyDown?(K_DOWN))? (1.0 / 255.0) : 0

v0 = [[v0, 1.0].min, 0.0].max

v1 = [[v1, 1.0].min, 0.0].max

v2 = [[v2, 1.0].min, 0.0].max

if set_hls

h = v0 * 360.0

l = v1 * 100.0

s = v2 * 100.0

rgb = Color::HSL.new(h, s, l).to_rgb

r = rgb.red

g = rgb.green

b = rgb.blue

else

r = (v0 * 255).to_i

g = (v1 * 255).to_i

b = (v2 * 255).to_i

hsl = Color::RGB.new(r, g, b).to_hsl

h = hsl.hue

l = hsl.luminosity

s = hsl.saturation

end

r = r.to_i

g = g.to_i

b = b.to_i

h = h.to_i

l = l.to_i

s = s.to_i

Window.bgcolor = [r, g, b]

col = (l < 50)? C_WHITE : C_BLACK

msg = (set_hls)? "use HLS" : "use RGB"

Window.drawFont(4, 4, msg, fnt, :color => col)

Window.drawFont(4, 40, "RGB=#{r}, #{g}, #{b}", fnt, :color => col)

Window.drawFont(4, 80, "HLS=#{h}, #{l}, #{s}", fnt, :color => col)

Window.drawFont(4, 120, "(mouse x/y , Up/Down key)", fnt, :color => col)

end

- Color::HSL.new(hue, saturation, luminosity) で渡す値は、hue が 0〜360、saturation と luminosity が 0〜100。

- Color::RGB.new(red, green, blue) で渡す値は、0〜255。

- HSL.to_rgb で RGB になるし、RGB.to_hsl で HSL になる。

- RGB.red、RGB.green、RGB.blue で取り出した値は、0〜255。

- HSL.hue、HSL.luminosity、HSL.saturation で取り出し値は、0〜360、0〜100、0〜100。

- HSL も RGB も、0.0〜1.0を与えて生成するメソッドがあるらしい。hsl = Color:HSL.from_fraction(0.5, 1.0, 0.5) みたいな書き方をすればいいのかな? たぶん。ちと自信無し。

ホント、最初からコレを使えばよかった…。

[ ツッコむ ]

#4 [gimp] G'MICプラグインがQtベースになるっぽい

G'MICプラグインという、500種類以上のフィルタが使える画像フィルタ集があるのですが。

*1

えてしてGIMPと組わせて使うことが多い、のかな。Kritaにも同梱されてたりしますが。

_G'MIC - GREYC's Magic for Image Computing: A Full-Featured Open-Source Framework for Image Processing

_「G'MIC (GREYC's Magic Image Converter)」

最新版に更新してみようと公式サイトを開いて 2.0.0pre版をDLしようとしたら、gimp_gtk版とgimp_qt版の2つがあることに気が付いて。

_G'MIC - Google+ を眺めると…。どうやら 2.0.0版からはQtベースになるっぽい雰囲気。Qt、なんだか流行ってるなあ…。人気あるなあ…。

_G'MIC - GREYC's Magic for Image Computing: A Full-Featured Open-Source Framework for Image Processing

_「G'MIC (GREYC's Magic Image Converter)」

最新版に更新してみようと公式サイトを開いて 2.0.0pre版をDLしようとしたら、gimp_gtk版とgimp_qt版の2つがあることに気が付いて。

_G'MIC - Google+ を眺めると…。どうやら 2.0.0版からはQtベースになるっぽい雰囲気。Qt、なんだか流行ってるなあ…。人気あるなあ…。

*1: 今現在、手元の環境で確認してみたら、526種類のフィルタが有効になってた…。

[ ツッコむ ]

2017/04/10(月) [n年前の日記]

#1 [gimp] G'MICプラグインでアレコレ試したり

_GIMP 2.8.20 Portable

+

_G'MIC 2.0.0pre Qt版

で、使えそうなフィルタがあるか調べ始めてしまったり。環境は Windows10x 64。

ちなみに、目的のフィルタ名が分かってれば、フィルター → G'MIC で開いたウインドウの上のほうに「Search」と表示されてる入力欄があるので、そこにフィルタ名の一部を打ち込めば即座に候補がリストアップされる。G'MICプラグインは何百種類もフィルタを持ってるので、さすがにこういう検索機能を使わないと…。ていうかGIMPの側にもこういう検索機能が欲しい…。

ちなみに、目的のフィルタ名が分かってれば、フィルター → G'MIC で開いたウインドウの上のほうに「Search」と表示されてる入力欄があるので、そこにフィルタ名の一部を打ち込めば即座に候補がリストアップされる。G'MICプラグインは何百種類もフィルタを持ってるので、さすがにこういう検索機能を使わないと…。ていうかGIMPの側にもこういう検索機能が欲しい…。

◎ 邪魔な物体を消してしまう Repair/Inpaint(multi-scale) :

写真画像内の、比較的巨大な物体もそれっぽく消してしまう、Inpaint(multi-scale)というフィルタがなんだかイイ感じだなと。以下の動画で紹介されてた。

_Introducing a new (fast) inpainting method in the G'MIC plug-in for GIMP - YouTube

使い方は、消したい物体を特定のマスク色(例えば赤(#ff0000)など)で塗り潰してから、フィルター → G'MIC → Repair → Inpaint(multi-scale)。

一度使用すると、GIMPのショートカットキー、Ctrl + F に、前回利用したフィルタが割り当てられるので…。鉛筆ツールでちょこっと赤く塗りつぶして Ctrl + F、また鉛筆ツールでちょこっと赤く塗りつぶして Ctrl + F、てな操作で、次々に邪魔な部分を消していくことができる。

_Introducing a new (fast) inpainting method in the G'MIC plug-in for GIMP - YouTube

使い方は、消したい物体を特定のマスク色(例えば赤(#ff0000)など)で塗り潰してから、フィルター → G'MIC → Repair → Inpaint(multi-scale)。

一度使用すると、GIMPのショートカットキー、Ctrl + F に、前回利用したフィルタが割り当てられるので…。鉛筆ツールでちょこっと赤く塗りつぶして Ctrl + F、また鉛筆ツールでちょこっと赤く塗りつぶして Ctrl + F、てな操作で、次々に邪魔な部分を消していくことができる。

◎ 線画に自動で色を塗ってくれる Black & white/Colorize lineart [auto-fill] :

白黒の線画に、自動でテキトーな色を仮で塗ってくれる、Colorize lineart [auto-fill] というフィルタがなんだか凄いなと。以下の動画で紹介されてる。ちなみに動画の時点では Auto-fill lineart という名称だった模様。

_New G'MIC filter 'Auto-fill lineart' to help colorizing comics - YouTube

使い方は、白黒の線画レイヤーを用意して、フィルター → G'MIC → Black & white → Colorize lineart [auto-fill]。実行すると、線画レイヤーと色塗りレイヤーが作られる。

色塗りレイヤーは二値化されているので、好きな色を選んでバケツツールでクリックして塗っていけば、あっという間に下塗り完成。

ちなみに、動画を見れば分かるけど、線画が途切れていてもそれなりにイイ感じに塗ってくれる。素晴らしい。

Colorizeフィルタには、他にも操作方法がちょっと違うフィルタが色々あるようで…。

例えば、Colorize lineart [smart coloring] を使えば、あらかじめ塗りたい色を一番上の透明レイヤーに描き込んでおくことで、自動で色塗りする際にそれらの色を使って塗ってくれる。(Input/Outputの Input layers を All にしておく必要有。)

_Overview of new G'MIC filter 'Colorize lineart [smart paint]' for colorizing comics - YouTube

以下はGIMPじゃなくて Krita の例だけど、Colorize [Interactive] を使えば、「このあたりはこの色で」的にマウスでポチポチとクリックしていくだけで塗り分けできたり。

_Krita 2.9 tutorial -part1/2- Gmic colorize[interactive] - YouTube

_New G'MIC filter 'Auto-fill lineart' to help colorizing comics - YouTube

使い方は、白黒の線画レイヤーを用意して、フィルター → G'MIC → Black & white → Colorize lineart [auto-fill]。実行すると、線画レイヤーと色塗りレイヤーが作られる。

色塗りレイヤーは二値化されているので、好きな色を選んでバケツツールでクリックして塗っていけば、あっという間に下塗り完成。

ちなみに、動画を見れば分かるけど、線画が途切れていてもそれなりにイイ感じに塗ってくれる。素晴らしい。

Colorizeフィルタには、他にも操作方法がちょっと違うフィルタが色々あるようで…。

例えば、Colorize lineart [smart coloring] を使えば、あらかじめ塗りたい色を一番上の透明レイヤーに描き込んでおくことで、自動で色塗りする際にそれらの色を使って塗ってくれる。(Input/Outputの Input layers を All にしておく必要有。)

_Overview of new G'MIC filter 'Colorize lineart [smart paint]' for colorizing comics - YouTube

以下はGIMPじゃなくて Krita の例だけど、Colorize [Interactive] を使えば、「このあたりはこの色で」的にマウスでポチポチとクリックしていくだけで塗り分けできたり。

_Krita 2.9 tutorial -part1/2- Gmic colorize[interactive] - YouTube

◎ アンチジャギに使えそうな Repair/Smooth [antialias] :

GIMPのフィルタの中には、フィルター → 強調 → アンチエイリアス、てのがあるけれど。そのフィルタは調整パラメータが一切無いし、アルファチャンネルを持ってるレイヤーで使うとアルファチャンネルが消滅してしまうわけで。

対して、G'MIC の Smooth [antialias] は、効果の調整もできるし、アルファチャンネルもちゃんと残るあたりがイイ感じだなと。コレを二値化の線画にかけると多少はジャギを消せそうな予感。

_New filter Repair / Smooth [antialias] available in the G'MIC plug-in for +GI...

対して、G'MIC の Smooth [antialias] は、効果の調整もできるし、アルファチャンネルもちゃんと残るあたりがイイ感じだなと。コレを二値化の線画にかけると多少はジャギを消せそうな予感。

_New filter Repair / Smooth [antialias] available in the G'MIC plug-in for +GI...

◎ インタラクティブにマスクを作れる Colors/Color mask [interactive] :

Colors/Color mask [interactive] を使うと、画像の上をマウスでなぞるだけでリアルタイムにマスクの結果が表示される。

_New filter in G'MIC for interactive color masking - YouTube

_New filter in G'MIC for interactive color masking (with spatial masking) - YouTube

使い方は、フィルター → G'MIC → Colors → Color mask [interactive]。OKを押すとプレビューウインドウ?が開くので、この色をマスクしたいと思ったあたりを左ボタンドラッグ。右ボタンはマスク解除、だろうか。これでいいなと思ったら Enterキー、なのかな。たぶん。

もっとも、GIMP の場合、前景抽出選択、という選択機能もあったりするので…。

_【GIMP】パスより簡単!前景抽出選択で切り抜く方法 - YouTube

_New filter in G'MIC for interactive color masking - YouTube

_New filter in G'MIC for interactive color masking (with spatial masking) - YouTube

使い方は、フィルター → G'MIC → Colors → Color mask [interactive]。OKを押すとプレビューウインドウ?が開くので、この色をマスクしたいと思ったあたりを左ボタンドラッグ。右ボタンはマスク解除、だろうか。これでいいなと思ったら Enterキー、なのかな。たぶん。

もっとも、GIMP の場合、前景抽出選択、という選択機能もあったりするので…。

_【GIMP】パスより簡単!前景抽出選択で切り抜く方法 - YouTube

[ ツッコむ ]

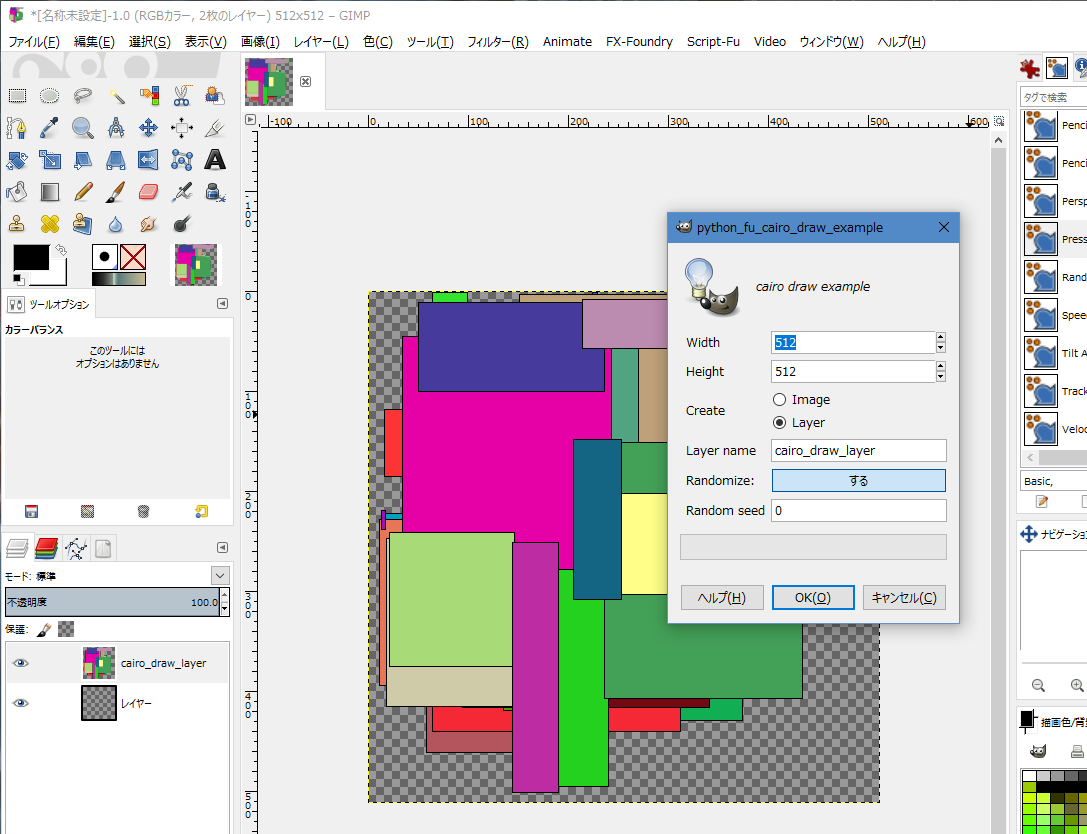

#2 [gimp] GIMPで宇宙空間を生成できるプラグインを試したり

Gimp Astronomy Plugins というプラグインを使うと、宇宙空間と言うか星空を簡単に生成してくれるらしいので、試しに導入してみたり。

_Gimp Plug-Ins - Programme - Georgs Homepage

_gimp-plugin-astronomy | GIMP Plugin Registry

昔は「星空作成プラグイン」として紹介されてたらしいけど…。

_星空作成プラグイン (Internet Arichive)

どうやら、 _GIMP2.6を使うよ! - Togetterまとめ によると、一時期はウイルス対策ソフトが反応したようで、おそらくそのせいで紹介されなくなったのかなと…。

一応今回、GIMP 2.8 にも対応したという gimp-plugin-astronomy-0.8.zip をDLして、 _オンラインで怪しいファイルのウィルスチェックをしてくれるWebサービスまとめ - ぼくんちのTV 別館 で紹介されてるウイルスチェックサイトに渡してみたけど、現行版は問題無いと判断された。

さておき。使い方は、何かしら新規画像を作成して、フィルター → 宇宙(もしくはAstronomy) → Artificial Stars。左下の「Smaple Distributions」で何かしらを選んで「Apply」ボタンを押すと、右側のパラメータにプリセット値が設定される。その状態で「Star Distribution」の下のボタンを押せば、星空が生成される。

こんな感じの画像が生成できるようで。

Artificial Galaxy や、フィルター → 照明と投影 → レンズフレア、超新星、等を、レイヤーのモードを「加算」にして追加してみたり。

結構イイ感じ。ボタンを数回クリックするだけで作れるのはありがたい。

_Gimp Plug-Ins - Programme - Georgs Homepage

_gimp-plugin-astronomy | GIMP Plugin Registry

昔は「星空作成プラグイン」として紹介されてたらしいけど…。

_星空作成プラグイン (Internet Arichive)

どうやら、 _GIMP2.6を使うよ! - Togetterまとめ によると、一時期はウイルス対策ソフトが反応したようで、おそらくそのせいで紹介されなくなったのかなと…。

一応今回、GIMP 2.8 にも対応したという gimp-plugin-astronomy-0.8.zip をDLして、 _オンラインで怪しいファイルのウィルスチェックをしてくれるWebサービスまとめ - ぼくんちのTV 別館 で紹介されてるウイルスチェックサイトに渡してみたけど、現行版は問題無いと判断された。

さておき。使い方は、何かしら新規画像を作成して、フィルター → 宇宙(もしくはAstronomy) → Artificial Stars。左下の「Smaple Distributions」で何かしらを選んで「Apply」ボタンを押すと、右側のパラメータにプリセット値が設定される。その状態で「Star Distribution」の下のボタンを押せば、星空が生成される。

こんな感じの画像が生成できるようで。

Artificial Galaxy や、フィルター → 照明と投影 → レンズフレア、超新星、等を、レイヤーのモードを「加算」にして追加してみたり。

結構イイ感じ。ボタンを数回クリックするだけで作れるのはありがたい。

[ ツッコむ ]

#3 [gimp] GIMP上でScale2xアルゴリズムを使ってドット絵を拡大

GIMP上で、Scale2x/Eagle2x等を利用してドット絵を拡大できるプラグインがあるようで。Pythonで書かれてるっぽい。

_Pixelart Scaler | GIMP Plugin Registry

_Pixelart Scaler (ScaleNx and EagleNx) for GIMP | OpenGameArt.org

導入してみたところ、たしかに Scale2xっぽい感じで拡大された。フィルター → 強調 → Scale Pixelart... で利用できる。

_Pixelart Scaler | GIMP Plugin Registry

_Pixelart Scaler (ScaleNx and EagleNx) for GIMP | OpenGameArt.org

導入してみたところ、たしかに Scale2xっぽい感じで拡大された。フィルター → 強調 → Scale Pixelart... で利用できる。

◎ ImageMagickもScale2xを持ってたらしい。 :

_Resizing or Scaling -- IM v6 Examples

によると、ImageMagick も Scale2x が利用できるようで。-magnify オプションをつけると、Scale2xアルゴリズムを利用して2倍に拡大するらしい。たくさん指定すると、4倍、8倍、16倍、になっていくのかな? たぶん。

_Pixel Art Scaling Algorithm - ImageMagick によると、どうやら 2013年頃に実装されたっぽいなと。元々、-magnify オプションは、200%に拡大するオプションのエイリアス、みたいなものだったらしいけど、「ImageMagick にもドット絵専用拡大アルゴリズムを入れてみたらどうスか?」てな提案が出た際に、「どうせこのオプション、ろくに使ってないだろうからコイツに割り当てるぜ」という流れになったらしい。

となると、hq3x等も実装されてないかなーと期待してしまうのだけど。

_hq2x, hq3x, hq4x scaling algos into imagemagic? - ImageMagick

「hqx は GPLだからダメ。ImageMagickのポリシーに反する」「アルゴリズムが別途説明されててソース見ないで実装できるなら話は別だが hqx は GPL のソースしかねえじゃん。無理」てなやり取りが2009年頃にあったようで。

より広い自由を求めるプログラマー達にとっても「GPL汚染」という問題は存在するのだなと再認識。

にしても、Scale2x のアルゴリズム解説ページを参考にしながらも、しかしソースは見ないで実装して、ImageMagick に機能を取り込めたということは…。自分が先日書いたソレも GPL にしないで済むのかな。だったら助かるのだけど、実際はどうなんだろう。

_Pixel Art Scaling Algorithm - ImageMagick によると、どうやら 2013年頃に実装されたっぽいなと。元々、-magnify オプションは、200%に拡大するオプションのエイリアス、みたいなものだったらしいけど、「ImageMagick にもドット絵専用拡大アルゴリズムを入れてみたらどうスか?」てな提案が出た際に、「どうせこのオプション、ろくに使ってないだろうからコイツに割り当てるぜ」という流れになったらしい。

となると、hq3x等も実装されてないかなーと期待してしまうのだけど。

_hq2x, hq3x, hq4x scaling algos into imagemagic? - ImageMagick

「hqx は GPLだからダメ。ImageMagickのポリシーに反する」「アルゴリズムが別途説明されててソース見ないで実装できるなら話は別だが hqx は GPL のソースしかねえじゃん。無理」てなやり取りが2009年頃にあったようで。

より広い自由を求めるプログラマー達にとっても「GPL汚染」という問題は存在するのだなと再認識。

にしても、Scale2x のアルゴリズム解説ページを参考にしながらも、しかしソースは見ないで実装して、ImageMagick に機能を取り込めたということは…。自分が先日書いたソレも GPL にしないで済むのかな。だったら助かるのだけど、実際はどうなんだろう。

[ ツッコむ ]

2017/04/11(火) [n年前の日記]

#1 [dxruby][ruby] ランダムにグラデーション塗りの矩形を描いたらドット絵っぽくなるかどうか実験

ランダムにグラデーション塗りの矩形を描いていったらドット絵っぽくならないかなと安易に思いついてしまったので、Ruby + DXRuby + color で実験してみたり。環境は Windows10 x64。

アルゴリズムとしては、ランダムな位置、サイズ、色相、彩度、輝度で、横もしくは縦方向のグラデーション塗り矩形(四角)を何度か描いて、最後にx、もしくはyでミラーするだけ。

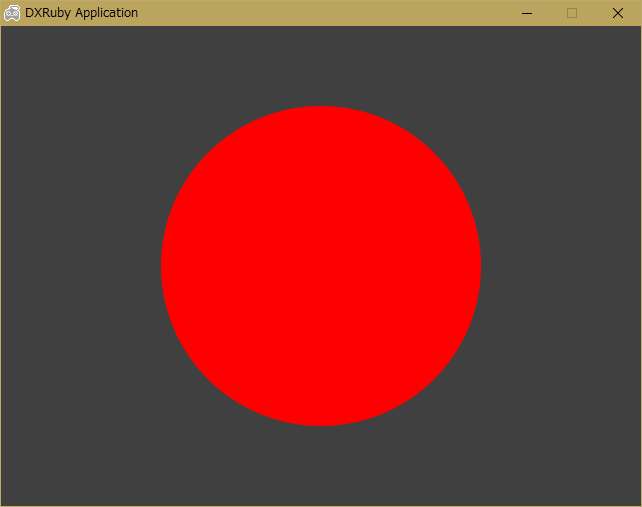

こんな感じの結果に。

予想より、きらびやかな結果が出力されて少々喜んだものの、使えるかと言うと…またしてもビミョーな…。何かのパーツとして使えそうな画像が生成された感じもするけど、単体で使えるかと言うと…。うーん。ビミョー。

アルゴリズムとしては、ランダムな位置、サイズ、色相、彩度、輝度で、横もしくは縦方向のグラデーション塗り矩形(四角)を何度か描いて、最後にx、もしくはyでミラーするだけ。

こんな感じの結果に。

予想より、きらびやかな結果が出力されて少々喜んだものの、使えるかと言うと…またしてもビミョーな…。何かのパーツとして使えそうな画像が生成された感じもするけど、単体で使えるかと言うと…。うーん。ビミョー。

◎ ソース。 :

ソースは以下。

_fillpixelrect.rb

実行には、color と dxruby が必要。Ruby がインストールされている Windows環境なら、以下でインストールできるかと。

ruby fillpixelrect.rb で実行。スペースキーを押すと次々にドット絵モドキを作り直す。

_fillpixelrect.rb

実行には、color と dxruby が必要。Ruby がインストールされている Windows環境なら、以下でインストールできるかと。

gem install dxruby gem install color

ruby fillpixelrect.rb で実行。スペースキーを押すと次々にドット絵モドキを作り直す。

◎ 課題というか案というか。 :

矩形を塗り潰す際に、矩形の輪郭を、黒、あるいは輝度を落とした色で描画してやれば、もうちょっとドット絵っぽくなる…かな…どうかな…。おそらくは輪郭の有無がドット絵らしさに関係してくるのではないかと推測してみたり。

矩形だけではなく、丸や三角をグラデーション塗りで描いてやれば、もうちょっと雰囲気が違ってくる…かな…どうかな…。今現在は矩形しか塗ってないので、ゴツゴツ感しか無いよなと。

そもそも、シルエットがどうも今一つだなと…。 _ランダムにドット単位で打っていくソレ も、事前にシルエットを決めてやるか否かで結果が随分違っていた感じがしたけど、このやり方もそういうところがあるのかもしれない。

矩形だけではなく、丸や三角をグラデーション塗りで描いてやれば、もうちょっと雰囲気が違ってくる…かな…どうかな…。今現在は矩形しか塗ってないので、ゴツゴツ感しか無いよなと。

そもそも、シルエットがどうも今一つだなと…。 _ランダムにドット単位で打っていくソレ も、事前にシルエットを決めてやるか否かで結果が随分違っていた感じがしたけど、このやり方もそういうところがあるのかもしれない。

[ ツッコむ ]

#2 [anime] 「アリスと蔵六」1話を視聴

録画したままだった1話を視聴。漫画が原作のアニメらしい。

スタッフ構成を見てちょっとビックリ。業界内で高評価を受けながらも何故か圧倒的に参加作品が少なくて _仙人と称されてる らしい、あの _高山文彦 監督がシリーズ構成・脚本を担当、とな…。それだけでもどうやらこれはフツーの企画じゃなさそうだなと…。 *1

_桜美かつし 監督の、以前の作品で階段を使った仕掛け云々の話を知り。するともしかしてこの回の、神社の階段のシーンはそういう意味が提示されているのかなと勝手な想像を。少女より高い段に居る老人 → 妥協案を提示しながら少女と同じ段に降りてくる → 少女と目線が合う高さまで降りてきて色々言い聞かせる、てなあたりが、なんだかそれっぽい。と思ったものの、もしかすると原作にあったシーンをそのまま描いてる可能性もあるからちょっと分からないなと。

少女が老人の仕事を目にするシーンが、個人的には少々残念だった気もしたり。白黒の漫画と違ってアニメは色を制御できるのだから、直前まで無彩色でまとめておけば、少女が受けたソレを視聴者にも感じさせることができただろうに、と…。いやまあ、寒色系の暗い道から電気のついた部屋に入って、その際に壁が暖色系に見えることで、なんだか暖かさを感じる場所に少女が足を踏み入れたことが伝わるはず、てなことを考えてたのかもしれないけど。しかしそうなると次のカットとの色彩的なコントラストが弱まって少女の受けた印象がそのままでは強調されず、仕方なく画面を白く飛ばし気味に、かつ、漫画的記号を追加、という若干わざとらしい強調方法になったということかなと…。 *2 なので、見せ方の意図はなんとなく分かる気もするけど、これはちと惜しい、みたいな。ぼんやりした何かを伝えることを優先するのか、ハッとする何かを伝えることを優先するのか…。しかし今後のアレコレを考えると前者を優先するのも全然アリだろうか。ハッとしたからと言って、少女の今後に意味があるかどうかはビミョーだし。それに、寒々とした場所でああいうのを作ってるかと考えるとそれも非現実的でツッコミが入りそうでもあるし。

カーアクションのシーンで、車が止まってるはずなのに、車内から外の風景が流れて見えてるカットは気になった。スケジュール、厳しそうだな…。にしても、背景が止まってるほうが作業的には楽だろうに、むしろ動かしちゃって、しかし間違ってるというのも不思議な話。いやまあ、TVアニメの制作現場はかなりの部分を並列処理でこなしてるということだろうけど。昨今のCPUの仕組みを ―― 使うか使わないか分からないけど事前に分岐先まで並列で計算しておいてどちらかの結果を捨ててしまうソレを連想してしまったり。

何にせよ、今後の展開や描写が楽しみなアニメだなと。少女と老人という組み合わせだけで、なんかもう…。いや、考えてみたらソレってアルプスの少女ハイジなのか。平成版SFハイジ、かもしれず。

スタッフ構成を見てちょっとビックリ。業界内で高評価を受けながらも何故か圧倒的に参加作品が少なくて _仙人と称されてる らしい、あの _高山文彦 監督がシリーズ構成・脚本を担当、とな…。それだけでもどうやらこれはフツーの企画じゃなさそうだなと…。 *1

_桜美かつし 監督の、以前の作品で階段を使った仕掛け云々の話を知り。するともしかしてこの回の、神社の階段のシーンはそういう意味が提示されているのかなと勝手な想像を。少女より高い段に居る老人 → 妥協案を提示しながら少女と同じ段に降りてくる → 少女と目線が合う高さまで降りてきて色々言い聞かせる、てなあたりが、なんだかそれっぽい。と思ったものの、もしかすると原作にあったシーンをそのまま描いてる可能性もあるからちょっと分からないなと。

少女が老人の仕事を目にするシーンが、個人的には少々残念だった気もしたり。白黒の漫画と違ってアニメは色を制御できるのだから、直前まで無彩色でまとめておけば、少女が受けたソレを視聴者にも感じさせることができただろうに、と…。いやまあ、寒色系の暗い道から電気のついた部屋に入って、その際に壁が暖色系に見えることで、なんだか暖かさを感じる場所に少女が足を踏み入れたことが伝わるはず、てなことを考えてたのかもしれないけど。しかしそうなると次のカットとの色彩的なコントラストが弱まって少女の受けた印象がそのままでは強調されず、仕方なく画面を白く飛ばし気味に、かつ、漫画的記号を追加、という若干わざとらしい強調方法になったということかなと…。 *2 なので、見せ方の意図はなんとなく分かる気もするけど、これはちと惜しい、みたいな。ぼんやりした何かを伝えることを優先するのか、ハッとする何かを伝えることを優先するのか…。しかし今後のアレコレを考えると前者を優先するのも全然アリだろうか。ハッとしたからと言って、少女の今後に意味があるかどうかはビミョーだし。それに、寒々とした場所でああいうのを作ってるかと考えるとそれも非現実的でツッコミが入りそうでもあるし。

カーアクションのシーンで、車が止まってるはずなのに、車内から外の風景が流れて見えてるカットは気になった。スケジュール、厳しそうだな…。にしても、背景が止まってるほうが作業的には楽だろうに、むしろ動かしちゃって、しかし間違ってるというのも不思議な話。いやまあ、TVアニメの制作現場はかなりの部分を並列処理でこなしてるということだろうけど。昨今のCPUの仕組みを ―― 使うか使わないか分からないけど事前に分岐先まで並列で計算しておいてどちらかの結果を捨ててしまうソレを連想してしまったり。

何にせよ、今後の展開や描写が楽しみなアニメだなと。少女と老人という組み合わせだけで、なんかもう…。いや、考えてみたらソレってアルプスの少女ハイジなのか。平成版SFハイジ、かもしれず。

[ ツッコむ ]

2017/04/12(水) [n年前の日記]

#1 [ruby] RubyInstaller2 を使って Ruby 2.4 を Windows上でインストールしてみたり

現在、

_RubyInstaller for Windows

でインストールできるのは、Ruby 2.3 まで、らしい。

_RubyInstaller2でWindows環境にRuby 2.4 + Rails 5.0.2をインストールする - Qiita

_Windows でも Ruby 2.4.0 が使えるんです。そう、RubyInstaller2 ならね。 - Qiita

Ruby 2.4 は RubyInstaller2 とやらを使うとインストールできるのだとか。試しにインストールしてみたり。環境は Windows10 x64。

_RubyInstaller2でWindows環境にRuby 2.4 + Rails 5.0.2をインストールする - Qiita

_Windows でも Ruby 2.4.0 が使えるんです。そう、RubyInstaller2 ならね。 - Qiita

Ruby 2.4 は RubyInstaller2 とやらを使うとインストールできるのだとか。試しにインストールしてみたり。環境は Windows10 x64。

◎ MSYS2のインストール。 :

Rubyのライブラリをビルドする際、RubyInstaller なら DevKit とやらをインストールすれば済んだけど。RubyInstaller2 の場合は MSYS2 とやらをインストールしないといけないらしくて。なので、まずは MSYS2 をインストール。

ちなみに自分の環境は、環境変数 HOME をあらかじめ指定してある。環境変数 HOME が指定されてない場合、C:\Users\アカウント名\ あたりがホームフォルダとして使われる、という話をどこかで見かけた、とメモ。

_MSYS2 homepage から、msys2-i686-20161025.exe と msys2-x86_64-20161025.exe をDL。

一応念のため書いとくけど、実行する前に .exe を右クリックして Windows Defender でスキャンして、問題無いと言ってきたら、右クリック → プロパティ → ブロックを解除。コレをしてから実行しないと、えてして「他のPCで作られたexeなんて今時怖くて実行できねえよ」とWindowsから怒られる。

デフォルトではインストール場所が C:\msys32 になってるけど、HDD容量が厳しいので今回は D:\msys32\ にインストールすることにした。が、コレは罠。デフォルトのままにしておけるなら、そのほうがいい…。

インストールが終わると、最後に「MSYS2 32bit を実行中」というボタンがあるのでクリック。ちなみに「実行中」は「実行する」の誤訳という説有り。

ターミナル(おそらくmintty)が起動。pacman -Syu と打ってパッケージを更新。最初の1回目は処理が完了すると無反応になる、というか「一旦exitしてくれよ」的な英文メッセージが表示されるので、ウインドウを閉じる。

スタートメニュー → MSYS2 32bit → MSYS2 MSYS を起動。再度、pacman -Syu と打つ。更にパッケージが更新される。処理が終わったら、Ctrl + D でターミナルを終了。

ちなみに、スタートメニュー内のショートカット先は以下のようになっていた。

以下、参考ページ。

_2. MSYS2 - とりあえず雑記帳

_MSYS2でWindows上にコマンドライン環境を作る - Qiita

ちなみに自分の環境は、環境変数 HOME をあらかじめ指定してある。環境変数 HOME が指定されてない場合、C:\Users\アカウント名\ あたりがホームフォルダとして使われる、という話をどこかで見かけた、とメモ。

_MSYS2 homepage から、msys2-i686-20161025.exe と msys2-x86_64-20161025.exe をDL。

- msys2-i686-20161025.exe が 32bit版。

- msys2-x86_64-20161025.exe が 64bit版。

一応念のため書いとくけど、実行する前に .exe を右クリックして Windows Defender でスキャンして、問題無いと言ってきたら、右クリック → プロパティ → ブロックを解除。コレをしてから実行しないと、えてして「他のPCで作られたexeなんて今時怖くて実行できねえよ」とWindowsから怒られる。

デフォルトではインストール場所が C:\msys32 になってるけど、HDD容量が厳しいので今回は D:\msys32\ にインストールすることにした。が、コレは罠。デフォルトのままにしておけるなら、そのほうがいい…。

インストールが終わると、最後に「MSYS2 32bit を実行中」というボタンがあるのでクリック。ちなみに「実行中」は「実行する」の誤訳という説有り。

ターミナル(おそらくmintty)が起動。pacman -Syu と打ってパッケージを更新。最初の1回目は処理が完了すると無反応になる、というか「一旦exitしてくれよ」的な英文メッセージが表示されるので、ウインドウを閉じる。

スタートメニュー → MSYS2 32bit → MSYS2 MSYS を起動。再度、pacman -Syu と打つ。更にパッケージが更新される。処理が終わったら、Ctrl + D でターミナルを終了。

ちなみに、スタートメニュー内のショートカット先は以下のようになっていた。

- MSYS2 MSYS : MSYS2インストールフォルダ\msys2_shell.cmd -msys

- MSYS2 MinGW 32-bit : MSYS2インストールフォルダ\msys2_shell.cmd -mingw32

以下、参考ページ。

_2. MSYS2 - とりあえず雑記帳

_MSYS2でWindows上にコマンドライン環境を作る - Qiita

◎ RubyInstaller2のインストール。 :

_Releases - oneclick/rubyinstaller2

から、rubyinstaller-2.4.0-8-x86.exe と rubyinstaller-2.4.0-8-x64.exe をDL。今回は32bit版の rubyinstaller-2.4.0-8-x86.exe をインストールした。

実行すると、RubyInstaller と同様に、ウイザード形式でインストールができる。

インストールが終わると、MSYS2のインストールだか設定画面だかが出てくるのだけど…。ここで、MSYS2のインストールフォルダをデフォルトから変えていたことが裏目に出た。

「MSYS2はインストール済みだから3番だな」と選んだところ、MSYS2がインストールされていないものと判断され、MSYS2のインストーラをDLしたあげく実行までしてきた。どうやらMSYS2のインストール場所を決め打ちで処理してるらしい。ひどいや。

仕方ないのでインストール済みの MSYS2 の場所から、C:\msys32 にシンボリックリンクを貼った。その状態で3番を選んだら先に進んでくれた。

が、しかし、やたらめったらパッケージがインストールされていく。しかも、Python2 や Perl までインストールしてる…。嘘だろ…マジかよ…。処理終了後、MSYS2 (mintty) を起動して、perl -v や python2 --version と打ったら、やっぱりインストールされてた。

つまり、「Windows上で Ruby 2.4 を使うためにはPerlやPythonも必要になりますぜ!」という状況らしい。だったら最初からPython使ったほうがいいのでは…? Rubyって一体何のために存在しているの? Rubyって何なの? *1 *2

それはともかく、何かビルドが必要になるライブラリをインストールしてみる。とりあえず nokogiri をインストール。 _oneclick/rubyinstaller2 の README.md を参考に、以下を入力。

ビルドされたっぽい。irb を実行して、require 'nokogiri' とやってみたら true と表示された。たしかに、RubyInstaller と同じ感覚で使えそうな雰囲気。

ちなみに、MSYS2 のフォルダ容量は 1.74GB になっていた。RubyInstaller 時代の DevKit2 は 370MB程度で済んでたのに…。なかなか厳しい。

Ruby 2.4 は 2.3 より5倍のHDD容量を消費するのだから…。2.3 → 2.4 で、例えば処理速度が5倍ぐらい速くなったりしないと割に合いませんなあ。なんちゃって。

実行すると、RubyInstaller と同様に、ウイザード形式でインストールができる。

インストールが終わると、MSYS2のインストールだか設定画面だかが出てくるのだけど…。ここで、MSYS2のインストールフォルダをデフォルトから変えていたことが裏目に出た。

「MSYS2はインストール済みだから3番だな」と選んだところ、MSYS2がインストールされていないものと判断され、MSYS2のインストーラをDLしたあげく実行までしてきた。どうやらMSYS2のインストール場所を決め打ちで処理してるらしい。ひどいや。

仕方ないのでインストール済みの MSYS2 の場所から、C:\msys32 にシンボリックリンクを貼った。その状態で3番を選んだら先に進んでくれた。

が、しかし、やたらめったらパッケージがインストールされていく。しかも、Python2 や Perl までインストールしてる…。嘘だろ…マジかよ…。処理終了後、MSYS2 (mintty) を起動して、perl -v や python2 --version と打ったら、やっぱりインストールされてた。

つまり、「Windows上で Ruby 2.4 を使うためにはPerlやPythonも必要になりますぜ!」という状況らしい。だったら最初からPython使ったほうがいいのでは…? Rubyって一体何のために存在しているの? Rubyって何なの? *1 *2

それはともかく、何かビルドが必要になるライブラリをインストールしてみる。とりあえず nokogiri をインストール。 _oneclick/rubyinstaller2 の README.md を参考に、以下を入力。

ridk exec pacman -S mingw-w64-i686-libxslt gem install nokogiri --platform ruby -- --use-system-libraries自分は32bit版をインストールしたから、x86_64 を i686 に置き換えて実行。

ビルドされたっぽい。irb を実行して、require 'nokogiri' とやってみたら true と表示された。たしかに、RubyInstaller と同じ感覚で使えそうな雰囲気。

ちなみに、MSYS2 のフォルダ容量は 1.74GB になっていた。RubyInstaller 時代の DevKit2 は 370MB程度で済んでたのに…。なかなか厳しい。

Ruby 2.4 は 2.3 より5倍のHDD容量を消費するのだから…。2.3 → 2.4 で、例えば処理速度が5倍ぐらい速くなったりしないと割に合いませんなあ。なんちゃって。

◎ 余談。 :

自分の環境では、シンボリックリンクについては以下のユーティリティをインストールして作成してる…と思ったけど、違ったかな…。たしかそのはず…。

_Link Shell Extension - k本的に無料ソフト・フリーソフト

_Link Shell Extension - k本的に無料ソフト・フリーソフト

*1: もちろん、Ruby本体だけを使うなら、ビルドに使うMSYS2までインストールせずに済むわけだけど、それではライブラリがビルドできない(時がある)ので、道具としてRubyを使うのは厳しい状態になるわけで。おそらく、ライブラリのビルド時に、Perl や Python2 が使われているのかな…? でも、ソレ、Ruby で処理できないの…? 何のために Ruby をインストールしてあるの…?

*2: もっとも、各ライブラリが mingw版のバイナリも含んだ状態で配布されていれば、各ユーザがビルド用にMSYS2をインストールする必要は無くなりそう…ではあるのだけど、今まで mingw版の Ruby2.4 がそもそも無かった・導入が難しかったわけで…。今後このあたり、改善されていくのかなあ…?

*2: もっとも、各ライブラリが mingw版のバイナリも含んだ状態で配布されていれば、各ユーザがビルド用にMSYS2をインストールする必要は無くなりそう…ではあるのだけど、今まで mingw版の Ruby2.4 がそもそも無かった・導入が難しかったわけで…。今後このあたり、改善されていくのかなあ…?

[ ツッコむ ]

#2 [tv][zatta] テロップが個人的に好き

思考メモ。

たまたまTVをつけたらNHKの朝の連続テレビ小説が映っていて。登場人物の前に「社会科の○○先生」「体育の○○先生」等のテロップが表示されて、なんだか感心してしまったり。と言うのも…。

娯楽映像作品においては、登場人物は知っているけど視聴者が知らない情報ってのがフツーにゴロゴロしていて。登場人物達の会話についてリアルっぽさを追求していくと、視聴者が知らない情報が何の説明もなくポンポン出てきて視聴者が置いてけぼりになる。ので、えてして脚本上で説明台詞と揶揄されるソレを盛り込んだりするわけだけど。その説明台詞のせいで、「ナウシカは独り言が多いなあ」とか「富野アニメはどうして突然フルネームで呼び始めるんだろう」とかそういうツッコミが…。 *1

かといって、「そんなツッコミするんやったら説明台詞を極力省いてやる! どうだ!? これで満足か!?」などとやってしまうと、近年の宮崎アニメのように観客置いてけぼり感が増してしまって…。アレ、ブランドになってるし大作家様だから許されてるけど、もし、PIXARのラセター監督がボスだったら、「コレ、お客さんに伝わるかな…? どう思う?」と笑顔でやんわりと諭されつつリテイク続出だよなあ…。

その点、テロップがポンと出てくるソレは、登場人物がリアルっぽい会話をしながらも、しかし視聴者の知らない情報について同時に補完することができる。ので、個人的には結構好きだったり。

ていうかテロップを出そうと判断して実行してる時点で、登場人物にとって自然な会話と、視聴者にとって分かりやすいやり取りは別なのだとちゃんと知った上で作ってることが伝わってくるし、映像作品制作における問題点を認識しつつも何かしらの手管を駆使してソレをクリアしていこうとする前向きさも感じて、スタッフの姿勢そのものに好感が持てるというか。この人達、まだ投げ出してないな、みたいな。

まあ、「テロップ出すなんて安易過ぎる」と馬鹿にしたり無意味に思い込んだりしてるクリエイター様の姿もチラホラ見かけるけど、そういう方々は違った方法で解決すればいいだけの話で。映像作品って総合芸術だから解決策は一つじゃないし。各人好きなように工夫していただければ…。お客さんが話の流れを理解できて、かつ、作品に乗ってくれるなら、なんでもOK。どれも正解。だよなと。

たまたまTVをつけたらNHKの朝の連続テレビ小説が映っていて。登場人物の前に「社会科の○○先生」「体育の○○先生」等のテロップが表示されて、なんだか感心してしまったり。と言うのも…。

娯楽映像作品においては、登場人物は知っているけど視聴者が知らない情報ってのがフツーにゴロゴロしていて。登場人物達の会話についてリアルっぽさを追求していくと、視聴者が知らない情報が何の説明もなくポンポン出てきて視聴者が置いてけぼりになる。ので、えてして脚本上で説明台詞と揶揄されるソレを盛り込んだりするわけだけど。その説明台詞のせいで、「ナウシカは独り言が多いなあ」とか「富野アニメはどうして突然フルネームで呼び始めるんだろう」とかそういうツッコミが…。 *1

かといって、「そんなツッコミするんやったら説明台詞を極力省いてやる! どうだ!? これで満足か!?」などとやってしまうと、近年の宮崎アニメのように観客置いてけぼり感が増してしまって…。アレ、ブランドになってるし大作家様だから許されてるけど、もし、PIXARのラセター監督がボスだったら、「コレ、お客さんに伝わるかな…? どう思う?」と笑顔でやんわりと諭されつつリテイク続出だよなあ…。

その点、テロップがポンと出てくるソレは、登場人物がリアルっぽい会話をしながらも、しかし視聴者の知らない情報について同時に補完することができる。ので、個人的には結構好きだったり。

ていうかテロップを出そうと判断して実行してる時点で、登場人物にとって自然な会話と、視聴者にとって分かりやすいやり取りは別なのだとちゃんと知った上で作ってることが伝わってくるし、映像作品制作における問題点を認識しつつも何かしらの手管を駆使してソレをクリアしていこうとする前向きさも感じて、スタッフの姿勢そのものに好感が持てるというか。この人達、まだ投げ出してないな、みたいな。

まあ、「テロップ出すなんて安易過ぎる」と馬鹿にしたり無意味に思い込んだりしてるクリエイター様の姿もチラホラ見かけるけど、そういう方々は違った方法で解決すればいいだけの話で。映像作品って総合芸術だから解決策は一つじゃないし。各人好きなように工夫していただければ…。お客さんが話の流れを理解できて、かつ、作品に乗ってくれるなら、なんでもOK。どれも正解。だよなと。

◎ 連続テレビ小説ならではの問題がありそう。 :

テロップを出したことを褒めるようなソレを書いた直後にアレだけど。連続テレビ小説でテロップを出すのはどうなんだろう、とも思えてきたり。