2023/05/01(月) [n年前の日記]

#1 [nitijyou] 自宅サーバ止めてました

雷が鳴ったので、16:55 - 18:50の間、自宅サーバを止めてました。申し訳ないです。

いきなり近くで雷が落ち始めてヒヤヒヤしました…。

いきなり近くで雷が落ち始めてヒヤヒヤしました…。

[ ツッコむ ]

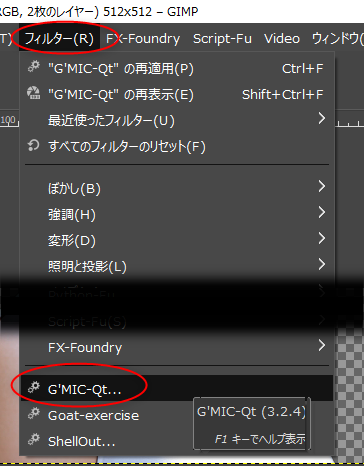

#2 [cg_tools][gimp][krita] Paint.NET、GIMP、CLIP STUDIO PAINT、Kritaについて調べてた

Paint.NET、GIMP、CLIP STUDIO PAINT、Krita について、色々調べてた。

◎ Paint.NET + G'MICプラグインの設定について :

Paint.NET + G'MICプラグインで、複数レイヤーを出力するフィルタを利用した際、複数の画像ファイルを保存させられるあたりが気になった。設定で回避できないのかなと調べていたのだけど、現状では無理らしい。

Paint.NETは、複数の入力レイヤーをフィルタに渡すことも、フィルタから複数の出力レイヤーを受け取ることも ―― フィルタが新規レイヤーを作成することすら許さない仕様だそうで。

_G'MIC (2023-04-28) - Page 3 - Plugins - Publishing ONLY! - paint.net Forum

そんな制限が付いて回るものだから、Paint.NET + G'MIC で、上と下の2つのレイヤーを渡して処理させる場合、アクティブレイヤーを下のレイヤー、クリップボード内のデータを上のレイヤーとして扱って処理をするらしい。

一々手作業で、クリップボードにレイヤーをコピーして、アクティブレイヤーを変更してからG'MICを呼ばないといけないなんて、不便過ぎる…。Paint.NETは、どうしてそんなストイックなフィルタ仕様にしてしまったのだろう…。

Paint.NETは、複数の入力レイヤーをフィルタに渡すことも、フィルタから複数の出力レイヤーを受け取ることも ―― フィルタが新規レイヤーを作成することすら許さない仕様だそうで。

_G'MIC (2023-04-28) - Page 3 - Plugins - Publishing ONLY! - paint.net Forum

そんな制限が付いて回るものだから、Paint.NET + G'MIC で、上と下の2つのレイヤーを渡して処理させる場合、アクティブレイヤーを下のレイヤー、クリップボード内のデータを上のレイヤーとして扱って処理をするらしい。

一々手作業で、クリップボードにレイヤーをコピーして、アクティブレイヤーを変更してからG'MICを呼ばないといけないなんて、不便過ぎる…。Paint.NETは、どうしてそんなストイックなフィルタ仕様にしてしまったのだろう…。

◎ GIMPのスレッド数設定 :

GIMP 2.10.34 Portable を導入したものの、画像ファイルを開く際になんだか数秒待たされる感じがして、改善できないのかなと調べていたところ、GIMPが使用するスレッド数の指定を1にすると改善する時期もあった、という話を見かけた。

_RyzenのSMTを無効化したらGIMPの動作が良くなった。 | 迷惑堂本舗

_GIMP:フリーズする場合の設定 | うっかりやっちゃうブログ

_GIMP slow and unrespsonsive when working with AMD CPU (#4979) - Issues - GNOME / GIMP - GitLab

_Slow import times on CPUs with high core/thread count (on Windows) (#8358) - Issues - GNOME / GIMP - GitLab

全体的なパフォーマンスは悪くなるけれど、例えば色調補正フィルタ等を利用した際にフリーズする症状も改善されるのだとか。

ただ、GIMP 2.10.34 では改善されたとか、GIMP起動直後はフリーズしないが長時間起動しっぱなしにして作業しているとフリーズしやすくなる、という話もあるようで…。

GIMP 2.10.34 で改善されてるなら、特に設定を変えなくてもいいかな…。

ちなみに、自分の環境は、CPU が AMD Ryzen 5 5600X (6コア12スレッド)。GIMPが使用するスレッド数は、12にしてある状態。

余談。昔はスレッド数じゃなくてCPUの個数を指定する仕様だったっぽい…。CPUコア数じゃなくてCPUの数、というのがややこしい…。

_tangram_pieces: GIMPの環境設定でのプロセッサ数について(2015-Dec-8: 追記)

_RyzenのSMTを無効化したらGIMPの動作が良くなった。 | 迷惑堂本舗

_GIMP:フリーズする場合の設定 | うっかりやっちゃうブログ

_GIMP slow and unrespsonsive when working with AMD CPU (#4979) - Issues - GNOME / GIMP - GitLab

_Slow import times on CPUs with high core/thread count (on Windows) (#8358) - Issues - GNOME / GIMP - GitLab

全体的なパフォーマンスは悪くなるけれど、例えば色調補正フィルタ等を利用した際にフリーズする症状も改善されるのだとか。

ただ、GIMP 2.10.34 では改善されたとか、GIMP起動直後はフリーズしないが長時間起動しっぱなしにして作業しているとフリーズしやすくなる、という話もあるようで…。

GIMP 2.10.34 で改善されてるなら、特に設定を変えなくてもいいかな…。

ちなみに、自分の環境は、CPU が AMD Ryzen 5 5600X (6コア12スレッド)。GIMPが使用するスレッド数は、12にしてある状態。

余談。昔はスレッド数じゃなくてCPUの個数を指定する仕様だったっぽい…。CPUコア数じゃなくてCPUの数、というのがややこしい…。

_tangram_pieces: GIMPの環境設定でのプロセッサ数について(2015-Dec-8: 追記)

◎ CLIP STUDIO PAINTの自動着色機能 :

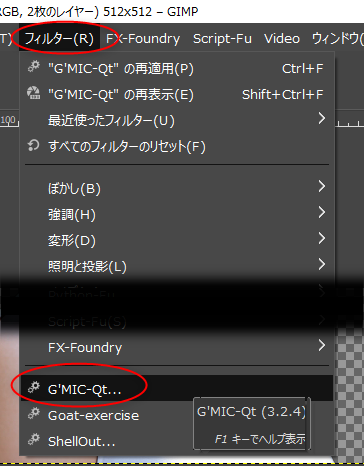

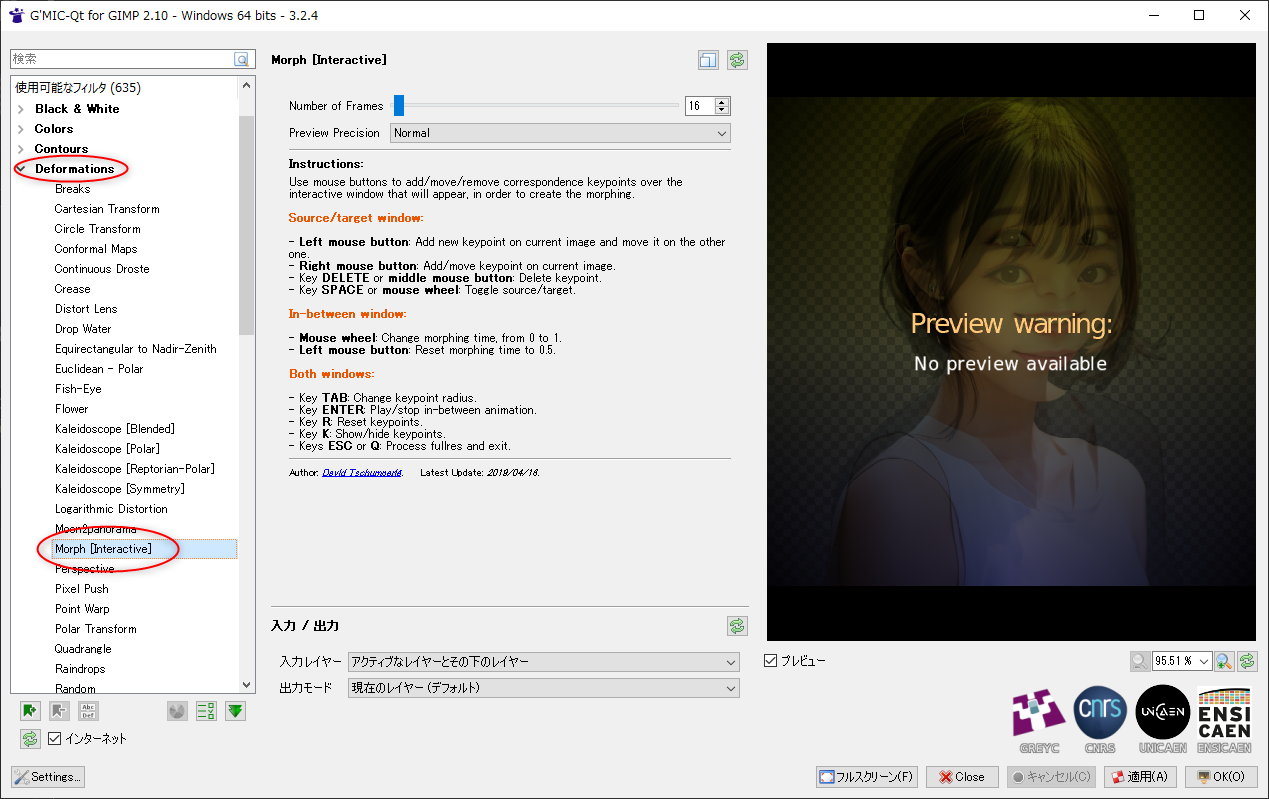

GIMP 2.10.34 + G'MICプラグインで、Colorize [Interactive] を使って色の塗り分け作業をしていた際、「そういえば CLIP STUDIO PAINT にはこういった機能は無いのだろうか」と気になった。ググってみたら、そもそも自動着色機能があるそうで、気になったので試用してみた。CLIP STUDIO PAINT PRO 1.13.2 で動作確認。

_クリスタ自動彩色機能の使い方解説!メリットやデメリットについて - イラスト・マンガ教室なび|おすすめ専門学校一覧

_クリップスタジオ自動彩色やり方とコツ!面白いから試してみよう | コンテアニメ工房

_自動彩色を活用した着色 by iroha_ - お絵かきのコツ | CLIP STUDIO TIPS

AIで自動着色してくれるらしい。スゴイな…。

ただ、データをセルシスのサーバに送信して、サーバ側で着色処理をして返してくるそうで。インターネット接続環境が無いと使えないし、セルシスが倒産しても使えなくなるなと…。いやまあ、会社が無くなったら、そもそもアクティベーションできない状態になって、CLIP STUDIO PAINT自体が使えなくなるのだから、そのあたりを気にしてみても無意味か…。

感想としては…。期待した塗りには程遠い結果が出てきて、なんというか、うーん。 *1 あらかじめ指定色(ヒント画像)を置いておく方法もあるけれど、それでも…。うーん。

パーツ毎の塗り分け領域を自動生成してくれるだけでも助かりそうな気もするのだけど、それよりレベルの高い処理をして、しかし今一つな結果になって、これではなんだかもったいない気もする。一歩手前の状態で止めておけば、十分ありがたいのに…。もっとも、この自動着色機能も、見た目はグラデーションがかかってるけど、魔法の杖でクリックすればパーツ毎の選択領域を得られるようだから、この状態でも結構助かるところがあるのかもしれない。

_クリスタ自動彩色機能の使い方解説!メリットやデメリットについて - イラスト・マンガ教室なび|おすすめ専門学校一覧

_クリップスタジオ自動彩色やり方とコツ!面白いから試してみよう | コンテアニメ工房

_自動彩色を活用した着色 by iroha_ - お絵かきのコツ | CLIP STUDIO TIPS

AIで自動着色してくれるらしい。スゴイな…。

ただ、データをセルシスのサーバに送信して、サーバ側で着色処理をして返してくるそうで。インターネット接続環境が無いと使えないし、セルシスが倒産しても使えなくなるなと…。いやまあ、会社が無くなったら、そもそもアクティベーションできない状態になって、CLIP STUDIO PAINT自体が使えなくなるのだから、そのあたりを気にしてみても無意味か…。

感想としては…。期待した塗りには程遠い結果が出てきて、なんというか、うーん。 *1 あらかじめ指定色(ヒント画像)を置いておく方法もあるけれど、それでも…。うーん。

パーツ毎の塗り分け領域を自動生成してくれるだけでも助かりそうな気もするのだけど、それよりレベルの高い処理をして、しかし今一つな結果になって、これではなんだかもったいない気もする。一歩手前の状態で止めておけば、十分ありがたいのに…。もっとも、この自動着色機能も、見た目はグラデーションがかかってるけど、魔法の杖でクリックすればパーツ毎の選択領域を得られるようだから、この状態でも結構助かるところがあるのかもしれない。

◎ Kritaの自動塗り分けマスク機能を試用 :

Windows10 x64 22H2 + Krita 5.1.5 64bit版で、自動塗り分けマスク編集ツールを試用してみた。結構長い間、Krita を使ってなくて知らなかったのだけど、こんな機能を持っていたのね…。

_Krita 4: 自動塗り分けマスクの使い方 - Kritaでぐるぐるお絵かきブログ

G'MICプラグインや CLIP STUDIO PAINT と同様、指定色を線画の上に描き込んでいくことで、領域を判定して塗り分けてくれた。更に、領域毎に別レイヤーに分割してくれる機能もありがたい。サクサク作業が出来そう。さすがKrita。お絵描き用を意識して機能を揃えているなあ、と…。

_Krita 4: 自動塗り分けマスクの使い方 - Kritaでぐるぐるお絵かきブログ

G'MICプラグインや CLIP STUDIO PAINT と同様、指定色を線画の上に描き込んでいくことで、領域を判定して塗り分けてくれた。更に、領域毎に別レイヤーに分割してくれる機能もありがたい。サクサク作業が出来そう。さすがKrita。お絵描き用を意識して機能を揃えているなあ、と…。

*1: もっとも、絵描きさん達の色塗りを超える結果をポンと出したら炎上必至だろうし、あえて本気を出してないのかも。絵描きさんのプライドを傷つけない程度の出力結果に抑えるというのも面倒臭い話だなと…。

[ ツッコむ ]

2023/05/02(火) [n年前の日記]

#1 [pc] HDMIセレクターを導入してみたけど正常動作せず

弟から貰ったHDMIセレクター、GREENHOUSE GH-HSWB3-BK を箱から出して動作確認してみた。HDMI入力が3つ、HDMI出力が1つ。4K2K 2160p映像対応、と謳っている製品。リモコン付き。

_セレクタ, セレクタ(切替機) | GH-HSWB3-BK | GREEN HOUSE グリーンハウス

液晶ディスプレイ MITSUBISHI MDT243WG-SB と、Intel Core i5-2500機(Ubuntu Linux 18.04 LTS、画面表示は内蔵GPU使用) の間に入れてみたけど、Ubuntu Linux が起動する際のVGA前後の解像度なら問題無く映ったものの、1920x1200のデスクトップ画面が出てきたあたりで、盛大なノイズだらけの画面になってしまった…。

ケーブルコネクタの接触不良を疑って、入力と出力のケーブルを何度か抜き差ししてみたり、電流が足りてない可能性を疑って、付属のUSB接続ケーブルで給電してみたけれど、改善はしなかった。

HDMIセレクター自体は、4K対応を謳っているぐらいだから、スペック的には問題無さそうな気もする。手持ちのHDMIケーブルが低品質で、伝送に失敗してるのだろうか…。それとも、1920x1200という解像度が異質なのだろうか。

レビューをググってみたところ、数ヶ月使っていたらノイズが出始めたという事例がチラホラ。弟が使っていた中古品だし、ノイズが出てしまう状態に劣化している可能性もありそう…。

_セレクタ, セレクタ(切替機) | GH-HSWB3-BK | GREEN HOUSE グリーンハウス

液晶ディスプレイ MITSUBISHI MDT243WG-SB と、Intel Core i5-2500機(Ubuntu Linux 18.04 LTS、画面表示は内蔵GPU使用) の間に入れてみたけど、Ubuntu Linux が起動する際のVGA前後の解像度なら問題無く映ったものの、1920x1200のデスクトップ画面が出てきたあたりで、盛大なノイズだらけの画面になってしまった…。

ケーブルコネクタの接触不良を疑って、入力と出力のケーブルを何度か抜き差ししてみたり、電流が足りてない可能性を疑って、付属のUSB接続ケーブルで給電してみたけれど、改善はしなかった。

HDMIセレクター自体は、4K対応を謳っているぐらいだから、スペック的には問題無さそうな気もする。手持ちのHDMIケーブルが低品質で、伝送に失敗してるのだろうか…。それとも、1920x1200という解像度が異質なのだろうか。

レビューをググってみたところ、数ヶ月使っていたらノイズが出始めたという事例がチラホラ。弟が使っていた中古品だし、ノイズが出てしまう状態に劣化している可能性もありそう…。

[ ツッコむ ]

2023/05/03(水) [n年前の日記]

#1 [nitijyou] 弟が帰省

夕方頃、自分が犬の散歩に行ってた間に到着したらしい。

PCパーツを色々持ってきてくれた。ありがたい…。2.5インチSSD x 1、3.5インチHDD x 4、2.5インチHDD x 2、HDDケース x 2。弟と話し合って、外付けHDDは親父さんにプレゼントしよう、という話に。

PCパーツを色々持ってきてくれた。ありがたい…。2.5インチSSD x 1、3.5インチHDD x 4、2.5インチHDD x 2、HDDケース x 2。弟と話し合って、外付けHDDは親父さんにプレゼントしよう、という話に。

◎ お袋さん用ノートPCをメンテナンス :

せっかく茶の間に居るのだからと、弟と近況報告をしつつ、お袋さん用のノートPC(DELL製)をメンテナンス。案の定、バッテリーが切れかけていた。とりあえずバッテリーを100%まで充電。充電できたということは、まだバッテリーは完全死亡してない、ということかな…。

Windows10も、21H2 から 22H2 にアップデートしておいた。

Windows10も、21H2 から 22H2 にアップデートしておいた。

[ ツッコむ ]

2023/05/04(木) [n年前の日記]

#1 [pc] デフラグが終わらない

一般的にSSDはデフラグをする必要はないと言われているのだけど、SSDも空き領域の断片化は解消したほうが良い、という話をどこかで見かけて、メインPC(Windows10 x64 22H2)のCドライブのSSD、Crucial MX500 CT500MX500SSD1JP 500GB をデフラグしてみようと思い立った。

Auslogics Disk Defrag 8.0.24.0 を起動して、「SSDの最適化」を選択。

しかし、やたらと時間がかかる。総ファイル数は、1,797,136ファイル。5時間経っても、6%ぐらいしか最適化できてない。これはおかしい。SSDなのに…。何故こんなに遅いのか…。

もう一つ積んであるSSD、PLEXTOR PX-256M2P 256GB に対して、以前同じ処理をした際は、数分で終わった記憶がある。SSDをデフラグする場合、本来であればそのくらいの時間で終わるのでは…?

もしかすると、ひっきりなしにCドライブにアクセスして、ファイルを書き込んでるプロセスが居るのではないか。一度止めて調べてみたほうがいいのだろうか。いや、ここまでやってしまったのだから、いっそこのまま続けてみよう…。

Auslogics Disk Defrag 8.0.24.0 を起動して、「SSDの最適化」を選択。

しかし、やたらと時間がかかる。総ファイル数は、1,797,136ファイル。5時間経っても、6%ぐらいしか最適化できてない。これはおかしい。SSDなのに…。何故こんなに遅いのか…。

もう一つ積んであるSSD、PLEXTOR PX-256M2P 256GB に対して、以前同じ処理をした際は、数分で終わった記憶がある。SSDをデフラグする場合、本来であればそのくらいの時間で終わるのでは…?

もしかすると、ひっきりなしにCドライブにアクセスして、ファイルを書き込んでるプロセスが居るのではないか。一度止めて調べてみたほうがいいのだろうか。いや、ここまでやってしまったのだから、いっそこのまま続けてみよう…。

◎ 2023/05/05追記 :

20時間38分かかって処理が終わった。長かった。しかし、おかしい…。SSDなのに…。

「SSDの最適化」だけでは、空き領域がほとんどまとまってくれなかった。そのまま続けて、「デフラグ 最適化 (遅い/週1回使用)」を選んで処理をさせたところ、今度は20分ぐらいで空き領域も奇麗にまとめてくれたように見えた。

「SSDの最適化」だけでは、空き領域がほとんどまとまってくれなかった。そのまま続けて、「デフラグ 最適化 (遅い/週1回使用)」を選んで処理をさせたところ、今度は20分ぐらいで空き領域も奇麗にまとめてくれたように見えた。

[ ツッコむ ]

#2 [nitijyou] 弟が仙台に戻った

19:20頃出発。21:20頃到着したと電話があったらしい。

[ ツッコむ ]

2023/05/05(金) [n年前の日記]

#1 [windows] Windows10の回復ドライブを作成してみた

Windows10 x64 22H2機の、CドライブのSSDに対してデフラグをかけた際、異様に時間がかかっていた点が気になる。もしかすると、Windowsのセーフモード云々でデフラグをかけたらサクサクと処理してくれたりしないか。

そのあたりを調べてみたら、回復ドライブを作ってそこからPCを起動すれば、コマンドプロンプトだけが起動している状態にできると知った。そのコマンドプロンプト上で defrag.exe を実行すれば状況が変わるだろうか。まずは回復ドライブを作成してみないと…。

机の引き出しから、16GBの、USB3.0メモリを発掘。貼ってある紙には、20H1と書いてある。コレの中身を更新して使おう…。

PCケースが古いので、前面にはUSB2.0ポートしかない。せっかくのUSB3.0対応メモリだけど、USB2.0ポートで使うことにする。しかし、そのまま差したら「認識できない」と言われてしまった。仕方ないのでUSB2.0ハブを経由して差し込んでみた。

USBメモリを差しておいた状態で、Windwos10左下の検索欄に、「回復ドライブの作成」と打ち込んで検索して起動。後はウィザード形式で尋ねてくる。ちなみに、USBメモリはフォーマットされて、中身が全消去される。

1時間30分ほどかかって、回復ドライブを作成できた。

そのあたりを調べてみたら、回復ドライブを作ってそこからPCを起動すれば、コマンドプロンプトだけが起動している状態にできると知った。そのコマンドプロンプト上で defrag.exe を実行すれば状況が変わるだろうか。まずは回復ドライブを作成してみないと…。

机の引き出しから、16GBの、USB3.0メモリを発掘。貼ってある紙には、20H1と書いてある。コレの中身を更新して使おう…。

PCケースが古いので、前面にはUSB2.0ポートしかない。せっかくのUSB3.0対応メモリだけど、USB2.0ポートで使うことにする。しかし、そのまま差したら「認識できない」と言われてしまった。仕方ないのでUSB2.0ハブを経由して差し込んでみた。

USBメモリを差しておいた状態で、Windwos10左下の検索欄に、「回復ドライブの作成」と打ち込んで検索して起動。後はウィザード形式で尋ねてくる。ちなみに、USBメモリはフォーマットされて、中身が全消去される。

1時間30分ほどかかって、回復ドライブを作成できた。

◎ defrag.exeは無かった :

PCのBIOS起動時にF12キーを押してブートメニューを表示。ちなみにどのキーでブートメニューが出てくるかはマザーボードによって違う。

起動に使うUSBメモリを選び、回復ドライブから起動して、コマンドプロンプトのみの画面にすることはできた。IMEを選んで、「トラブルシューティング」→「詳細オプション」→「コマンドプロンプト」を選ぶのだったかな…。ちょっと記憶が怪しい。

_Windows 10が起動しない時の修復方法 | パソコン工房 NEXMAG

ただ、回復ドライブ内に defrag.exe は入ってなくて、デフラグの動作確認はできなかった。chkdsk は入っていたのだけど…。

起動に使うUSBメモリを選び、回復ドライブから起動して、コマンドプロンプトのみの画面にすることはできた。IMEを選んで、「トラブルシューティング」→「詳細オプション」→「コマンドプロンプト」を選ぶのだったかな…。ちょっと記憶が怪しい。

_Windows 10が起動しない時の修復方法 | パソコン工房 NEXMAG

ただ、回復ドライブ内に defrag.exe は入ってなくて、デフラグの動作確認はできなかった。chkdsk は入っていたのだけど…。

◎ 回復ドライブを作る際に必要な容量が分からない :

巷の解説記事を眺めると、「回復ドライブの作成には32GB以上のUSBメモリが必要」と書いてある場合が多いのだけど。

自分の環境で、以前、回復ドライブ作成を試した際は、何故か32GBのUSBメモリだと作成に失敗してしまって、16GBのUSBメモリなら作成に成功する、という症状に見舞われた記憶があって…。 *1

どういう環境なら、32GBが必要と言われてしまうのだろう…? 自分の環境では、そもそも回復ドライブ作成ツールが、途中で「16GB以上が必要」と言ってきて、「32GB以上が必要」とは言ってこないのだよな…。でも、どの解説ページも、「32GB以上が必要」と書いてるし。これはどういうことなのだろう。

自分の環境で、以前、回復ドライブ作成を試した際は、何故か32GBのUSBメモリだと作成に失敗してしまって、16GBのUSBメモリなら作成に成功する、という症状に見舞われた記憶があって…。 *1

どういう環境なら、32GBが必要と言われてしまうのだろう…? 自分の環境では、そもそも回復ドライブ作成ツールが、途中で「16GB以上が必要」と言ってきて、「32GB以上が必要」とは言ってこないのだよな…。でも、どの解説ページも、「32GB以上が必要」と書いてるし。これはどういうことなのだろう。

*1: 回復ドライブを作成するために、わざわざ32GBのUSBメモリを新規購入したのに、そういう結果になってしまって、「なんだそりゃ」「16GBで済むならそう言ってくれ」「手元にあったUSBメモリでも間に合ったじゃんよ」と憤慨した記憶が…。

[ ツッコむ ]

#2 [pc] 弟から貰ったPCパーツについてメモ

弟が帰省した際に譲ってくれたPCパーツの型番をメモ。メモしておかないと絶対に忘れるので…。

_価格.com - 東芝 CANVIO DESK HD-ED20TK [ブラック] スペック・仕様

_価格.com - crucial CT512M550SSD1 スペック・仕様

_ハイエンド並みの性能を発揮――「Crucial M550 SSD」徹底検証:注目SSD速攻レビュー(1/2 ページ) - ITmedia PC USER

_価格.com - 東芝 MD03ACA400 [4TB SATA600 7200] スペック・仕様

_東芝(TOSHIBA)製HDD_リテール品_MD03ACAシリーズ

_価格.com - 東芝 DT01ACA300 [3TB SATA600 7200] スペック・仕様

_DT01 シリーズ | 東芝デバイス&ストレージ株式会社 | 日本

_価格.com - HGST HTS721010A9E630 [1TB 9.5mm] スペック・仕様

_価格.com - HGST HTS541515A9E630 [1.5TB 9.5mm] スペック・仕様

_eSATA活してUSB3.0 (CCA-ESU3) - 株式会社センチュリー

_Owltech ドライブケース OWL-EGP35/EU ガチャポンパッ! (WebArchive)

_オウルテック、ネジ不要のHDDケース「3ステップケース ガチャポンパッ! 」

- USB3.0接続外付けHDD TOSHIBA CANVIO DESK HD-ED20TK (2TB, TOSHIBA DT01ABA200, Cache 32MB, SATA600, 5700rpm, 使用時間188時間)

- 2.5インチSSD crucial M550 CT512M550SSD1 (2.5インチ, 512GB, MLC, SATA600, 初期ファームウェア MU01)

- 3.5インチHDD TOSHIBA MD03ACA400 (3.5インチ, 4TB, SATA600, 7200rpm, Cache 64MB) x 2

- 3.5インチHDD TOSHIBA DT01ACA300 (3.5インチ, 3TB, SATA600, 7200rpm, CMR, Cache 64MB)

- 2.5インチHDD HGST 7K1000-1000 HTS721010A9E630 (2.5インチ, 1TB, SATA600, 7200rpm, 9.5mm)

- 2.5インチHDD HGST 5K1500-1500 HTS541515A9E630 (2.5インチ, 1.5TB, SATA600, 5400rpm, 9.5mm, Cache 32MB)

- HDDリムーバブルケーストレイ RATOC REX-SATA SA-RC1 (3.5インチSATA HDD対応)

- eSATA USB3.0変換アダプタ センチュリー eSATA活してUSB3.0 CCA-ESU3

- 3.5インチHDDケース 型番不明だけどおそらく オウルテック 3ステップケース ガチャポンパッ! OWL-EGP35/EU (3.5インチHDD対応、eSATA, USB2.0, 側面にファン付, 色はシルバー, ※ 同じ見た目の OWL-EGP35/CEU はSATAとIDEの両方に対応。OWL-EGP35/EU はSATAのみ対応)

_価格.com - 東芝 CANVIO DESK HD-ED20TK [ブラック] スペック・仕様

_価格.com - crucial CT512M550SSD1 スペック・仕様

_ハイエンド並みの性能を発揮――「Crucial M550 SSD」徹底検証:注目SSD速攻レビュー(1/2 ページ) - ITmedia PC USER

_価格.com - 東芝 MD03ACA400 [4TB SATA600 7200] スペック・仕様

_東芝(TOSHIBA)製HDD_リテール品_MD03ACAシリーズ

_価格.com - 東芝 DT01ACA300 [3TB SATA600 7200] スペック・仕様

_DT01 シリーズ | 東芝デバイス&ストレージ株式会社 | 日本

_価格.com - HGST HTS721010A9E630 [1TB 9.5mm] スペック・仕様

_価格.com - HGST HTS541515A9E630 [1.5TB 9.5mm] スペック・仕様

_eSATA活してUSB3.0 (CCA-ESU3) - 株式会社センチュリー

_Owltech ドライブケース OWL-EGP35/EU ガチャポンパッ! (WebArchive)

_オウルテック、ネジ不要のHDDケース「3ステップケース ガチャポンパッ! 」

◎ HDD-SCANで不良セクタが無いかチェック :

USB3.0接続外付けHDD TOSHIBA CANVIO DESK HD-ED20TK は、親父さんに渡す予定なので、渡す前に不良セクタがないか一応チェック。今回は HDD-SCAN 2.0 というツールを利用させてもらった。

_世界で一番使いやすいハードディスク故障診断ソフトHDD-Scan

_HDD-SCANのインストールと使い方を解説!不良セクタのチェックができるフリーソフト | 名古屋市パソコン修理専門店「かおるや」のブログ

USB3.0接続、2TB、5700rpmのHDDで、約4時間半ほどかかった。初回利用時はログを保存する段階で不正終了してしまった。

チェック中のHDDの温度は48度。ちょっと怖いな…。経験的にHDDは、60度を超えると転送エラーをガンガン出し始めるので、50度を超えそうだと、少しハラハラしてくる。

余談。チェックする前に、「ディスクの管理」から「ボリュームの削除」「シンプルボリュームの作成」(クイックフォーマット付き)をしておいてから、該当ドライブのプロパティ → セキュリティ、で、ユーザとして Everyone を追加してフルコントロールを指定。かつ、所有者を Everyone にしておいた。

もしかすると、こういうことはやらなくていいのかもしれないけど、昔、普段使ってるPCとは違うPCに外付けHDDを繋いだら、ファイルやフォルダの書き換えができなかったことがあるので…。一応念のため。それと、「コンテンツにインデックスをつける」のチェックも外しておいた。

_世界で一番使いやすいハードディスク故障診断ソフトHDD-Scan

_HDD-SCANのインストールと使い方を解説!不良セクタのチェックができるフリーソフト | 名古屋市パソコン修理専門店「かおるや」のブログ

USB3.0接続、2TB、5700rpmのHDDで、約4時間半ほどかかった。初回利用時はログを保存する段階で不正終了してしまった。

チェック中のHDDの温度は48度。ちょっと怖いな…。経験的にHDDは、60度を超えると転送エラーをガンガン出し始めるので、50度を超えそうだと、少しハラハラしてくる。

余談。チェックする前に、「ディスクの管理」から「ボリュームの削除」「シンプルボリュームの作成」(クイックフォーマット付き)をしておいてから、該当ドライブのプロパティ → セキュリティ、で、ユーザとして Everyone を追加してフルコントロールを指定。かつ、所有者を Everyone にしておいた。

もしかすると、こういうことはやらなくていいのかもしれないけど、昔、普段使ってるPCとは違うPCに外付けHDDを繋いだら、ファイルやフォルダの書き換えができなかったことがあるので…。一応念のため。それと、「コンテンツにインデックスをつける」のチェックも外しておいた。

◎ eSATAをUSB3.0に変換できるアダプタについて :

今回貰ったパーツの中に、「センチュリー eSATA活してUSB3.0 CCA-ESU3」という製品があって、「そんな変換アダプタがあるのか…」と驚いた。

こういったアダプタを使えば、自分の部屋で埃を被っている、eSATA + USB2.0 の外付けHDDケース数台も、まだまだ有効活用できそう。eSATA接続ならともかく、USB2.0接続で数TBのHDDを使うのは厳しいわけだけど、自分の手持ちのPC群は、もはやeSATA接続端子が無くなっているわけで…。

しかし、値段を調べて悩んでしまった。新品のUSB3.0接続外付けHDDケースと同じくらいの値段なのね…。だったら外付けHDDケースを買ってしまったほうが話が早いのでは…。

いや、昔の外付けHDDケースにはファンがついてたりするから、冷却面を考えると、eSATA-USB3.0変換アダプタを使ったほうがマシかもしれないか…。冷却ファン付きのHDDケースって、今ではもう数種類しか販売されてない状態だし。

とは言え、この変換アダプタ、他のUSB3.0ポートを塞いでしまうぐらいに横幅があるのはちょっとアレだなと…。かと言って、USB3.0延長ケーブルを使うとエラーが出そうだし…。

こういったアダプタを使えば、自分の部屋で埃を被っている、eSATA + USB2.0 の外付けHDDケース数台も、まだまだ有効活用できそう。eSATA接続ならともかく、USB2.0接続で数TBのHDDを使うのは厳しいわけだけど、自分の手持ちのPC群は、もはやeSATA接続端子が無くなっているわけで…。

しかし、値段を調べて悩んでしまった。新品のUSB3.0接続外付けHDDケースと同じくらいの値段なのね…。だったら外付けHDDケースを買ってしまったほうが話が早いのでは…。

いや、昔の外付けHDDケースにはファンがついてたりするから、冷却面を考えると、eSATA-USB3.0変換アダプタを使ったほうがマシかもしれないか…。冷却ファン付きのHDDケースって、今ではもう数種類しか販売されてない状態だし。

とは言え、この変換アダプタ、他のUSB3.0ポートを塞いでしまうぐらいに横幅があるのはちょっとアレだなと…。かと言って、USB3.0延長ケーブルを使うとエラーが出そうだし…。

◎ HDDケース OWL-EGP35/EUにHDDを入れた :

オウルテック OWL-EGP35/EU に、4TB HDD、TOSHIBA MD03ACA400 を入れてみた。

HDDケースの型番が分かる情報はどこにもついてないのだけど、ググった感じではおそらくこの製品だろうなと…。

最初、開け方が分からなかったけど、USB端子やeSATA端子がある側に、ロック用のスライドスイッチがあって、そこを動かせばスポンと抜ける模様。スライドスイッチを動かしたら物凄い勢いで下にスポーンと抜けて、中身が床の上にゴンッと落ちてしまった…。ケース前面に傷がついてしまったかもしれない…。

脇のプラスチックパーツを開け閉めすることで、ネジ不要でHDDを固定できる。HDDの取付作業は物凄く簡単。イイ感じ。

「センチュリー eSATA活してUSB3.0 CCA-ESU3」を経由させてeSATAをUSB3.0に変換して、サブPC(Windows10 x64 22H2機、CPU: Athlon 5350 Quad-Core (2GHz, 4core, TDP 25W))に繋いでみた。

CrystalDiskInfo 8.17.14 x64 で確認したところ、「SATA/150 | SATA/600」と表示された。中のHDDは SATA/600 だけど、HDDケースのインターフェイスは SATA/150、ということかな…。HDDケース側が古くてSATA/150になってしまうのか、それともUSB3.0接続は大体SATA/150になってしまうのか。あるいは変換アダプタを通すとそうなるのだろうか。

とりあえず、HDD-Scan V2.0 を使って不良セクタが無さそうかチェック開始。12時間ぐらいかかると表示されてる。2TBのHDDをチェックした時は4時間半で済んだけど、それと比べると遅い気がする。eSATAとUSB3.0の変換をしているから遅くなってるのか、それともサブPCのCPUがメインPCのCPUと比べると圧倒的に非力だから遅いのだろうか。

HDDケースの型番が分かる情報はどこにもついてないのだけど、ググった感じではおそらくこの製品だろうなと…。

最初、開け方が分からなかったけど、USB端子やeSATA端子がある側に、ロック用のスライドスイッチがあって、そこを動かせばスポンと抜ける模様。スライドスイッチを動かしたら物凄い勢いで下にスポーンと抜けて、中身が床の上にゴンッと落ちてしまった…。ケース前面に傷がついてしまったかもしれない…。

脇のプラスチックパーツを開け閉めすることで、ネジ不要でHDDを固定できる。HDDの取付作業は物凄く簡単。イイ感じ。

「センチュリー eSATA活してUSB3.0 CCA-ESU3」を経由させてeSATAをUSB3.0に変換して、サブPC(Windows10 x64 22H2機、CPU: Athlon 5350 Quad-Core (2GHz, 4core, TDP 25W))に繋いでみた。

CrystalDiskInfo 8.17.14 x64 で確認したところ、「SATA/150 | SATA/600」と表示された。中のHDDは SATA/600 だけど、HDDケースのインターフェイスは SATA/150、ということかな…。HDDケース側が古くてSATA/150になってしまうのか、それともUSB3.0接続は大体SATA/150になってしまうのか。あるいは変換アダプタを通すとそうなるのだろうか。

とりあえず、HDD-Scan V2.0 を使って不良セクタが無さそうかチェック開始。12時間ぐらいかかると表示されてる。2TBのHDDをチェックした時は4時間半で済んだけど、それと比べると遅い気がする。eSATAとUSB3.0の変換をしているから遅くなってるのか、それともサブPCのCPUがメインPCのCPUと比べると圧倒的に非力だから遅いのだろうか。

[ ツッコむ ]

#3 [ubuntu][linux] Ubuntu 22.04 LTSのパーティションサイズを縮小

Ubuntu Linux 22.04 LTS をインストールしてあるサブPC(Intel Core i3-6100T機)のHDDに対して、パーティションサイズを480GBから240GBに縮小しようとした。いつかSSDに引っ越しできる程度のサイズにしておきたい。

ただ、GParted を使えばパーティションサイズの縮小ができるものと思い込んでいたけど、これがすんなり行かなくて。

結論を先に書くと、GParted の公式サイトから gparted-live-1.5.0-1-i686.iso を入手して、USBメモリに Unetbootin を使って書き込んで、起動時に VGA 云々と表示されている項目を選んで起動したら、パーティションサイズを縮小することができた。

_GParted -- Download

以下は失敗した手順。

たしか以前、別PCでパーティションサイズの縮小をした際も、GParted公式版じゃないと作業できなかった記憶があるので、この手の作業をする場合は GParted公式版を使ったほうがいいのかも。

ただ、GParted を使えばパーティションサイズの縮小ができるものと思い込んでいたけど、これがすんなり行かなくて。

結論を先に書くと、GParted の公式サイトから gparted-live-1.5.0-1-i686.iso を入手して、USBメモリに Unetbootin を使って書き込んで、起動時に VGA 云々と表示されている項目を選んで起動したら、パーティションサイズを縮小することができた。

_GParted -- Download

以下は失敗した手順。

- Ubuntu Linux 22.04 LTS に入ってる GParted は、Ubuntu が使ってる最中のパーティションに対して処理ができないので、これで作業をするのは無理。何か方法があるのかもしれないけど…。

- UBCD (Ultimate Boot CD) 5.3.9 の中に入っている GParted を使ったら、パーティションサイズを縮小する段階でエラーが出て失敗した。縮小処理をする際に、最初に動かすべきプログラムがあるらしいけど、そのプログラムが存在しないか、もしくはエラーを出していたように見えた。

- KNOPPIX 9.1 に入ってる GParted を使ったら、こちらもエラー。UBCD に入ってる版よりは先まで処理が進んだけど、それでも途中でエラーが出る。

- GParted 公式サイトからDLした版も、初回起動時はデスクトップ画面(X Window)が表示されなくて失敗。再チャレンジした際、最初にVGA云々を選んだら、デスクトップ画面が表示される状態になった。

たしか以前、別PCでパーティションサイズの縮小をした際も、GParted公式版じゃないと作業できなかった記憶があるので、この手の作業をする場合は GParted公式版を使ったほうがいいのかも。

◎ デスクトップ画面が表示されない問題 :

GParted公式版を利用した際、最初の起動時はデスクトップ画面が表示されなかったのだけど。それについては、ひょっとすると Intel製CPUの内蔵GPU用ドライバに何か問題があるのかもしれない。別PCではデスクトップ画面がすんなり表示された記憶があるので…。

Intel Core i3-6100T の内蔵GPUは、Intel HD Graphics 530。ググってみたら、Linux を動かすには少し問題がありそうな…。i3-6100T は TDP 35W のCPUだから、この不具合を踏んでたりするのだろうか…?

_Intel graphics - ArchWiki

_Dell XPS 15 (9550) - ArchWiki

_Gentoo Linux で Intel Core i5-6500 の Intel HD Graphics 530 を使うメモ - Yuichiro_S の Twitterでは文字数が足りないもの

Intel Core i3-6100T の内蔵GPUは、Intel HD Graphics 530。ググってみたら、Linux を動かすには少し問題がありそうな…。i3-6100T は TDP 35W のCPUだから、この不具合を踏んでたりするのだろうか…?

_Intel graphics - ArchWiki

低消費電力 Intel CPU でクラッシュ/フリーズ

低消費電力 Intel プロセッサやノート PC プロセッサは、低消費電力 Intel チップで使用されている電源管理機能に関する問題によりランダムにハングアップ/クラッシュする傾向にあります。そのようなクラッシュが発生する場合、この問題を報告するログは見られないでしょう。以下のカーネルパラメータを追加することで、この問題を解決できるかもしれません。

ノート: 以下のカーネルパラメータを3つすべて一緒に使用することは推奨されません。

intel_idle.max_cstate=1

i915.enable_dc=0

ahci.mobile_lpm_policy=1

_Dell XPS 15 (9550) - ArchWiki

ブートパラメータ

以下のカーネルパラメータを使用することで解決できる問題があります:

i915.edp_vswing=2 i915.preliminary_hw_support=1 intel_idle.max_cstate=1 acpi_backlight=vendor acpi_osi=Linux

i915.edp_vswing=2 画面のちらつきを抑えます。

i915.preliminary_hw_support=1 Intel Graphics の問題を解決します。

intel_idle.max_cstate=1 CPU の C ステート が 1 より大きくならなくなります。

acpi_backlight=vendor acpi_osi=Linux バックライトが制御できるようになります。

_Gentoo Linux で Intel Core i5-6500 の Intel HD Graphics 530 を使うメモ - Yuichiro_S の Twitterでは文字数が足りないもの

[ ツッコむ ]

2023/05/06(土) [n年前の日記]

#1 [ubuntu][linux] Ubuntu LinuxでHDDに不良セクタが無いかチェックした

Ubuntu Linux 22.04 LTS を使って、4TB 3.5インチHDD、TOSHIBA MD03ACA400 に不良セクタがないかチェックしたい。ちなみにHDDは、外付けHDDケースを使わず、M/BにSATAで接続してある。

*1

ググってみたら、badblocks というツールがあるらしい。

_Linuxでディスクのエラーや不良セクタのチェックと修正をする方法 - Ubuntu入門

_LinuxでHDDの不具合を特定する作業の覚え書き -- ぺけみさお

_badblocks - ArchWiki

_badblocks - Ubuntu入門

_似非管理者の寂しい夜:ubuntu 12.04でbadblocksコマンドを使う - livedoor Blog(ブログ)

_Linux - HDD 不良セクタのチェック等! - mk-mode BLOG

これを使えばいいのだな…。

Ubuntu Linux 22.04 LTS上で、GParted を起動して、対象とするHDD(/dev/sdb)に対して、パーティションを新規作成。ext4でフォーマット。

hdparm を使って、HDDの情報を確認。

badblocks を実行。

5時間ぐらいかかってチェック終了。不良セクタは無い、と言ってきた。

もし不良セクタがあった場合は、そのセクタを使わないようにマークをつけてやる必要があるらしい。そのあたりは前述の参考ページで解説されてる。

ググってみたら、badblocks というツールがあるらしい。

_Linuxでディスクのエラーや不良セクタのチェックと修正をする方法 - Ubuntu入門

_LinuxでHDDの不具合を特定する作業の覚え書き -- ぺけみさお

_badblocks - ArchWiki

_badblocks - Ubuntu入門

_似非管理者の寂しい夜:ubuntu 12.04でbadblocksコマンドを使う - livedoor Blog(ブログ)

_Linux - HDD 不良セクタのチェック等! - mk-mode BLOG

これを使えばいいのだな…。

Ubuntu Linux 22.04 LTS上で、GParted を起動して、対象とするHDD(/dev/sdb)に対して、パーティションを新規作成。ext4でフォーマット。

hdparm を使って、HDDの情報を確認。

$ sudo hdparm -i /dev/sdb1

/dev/sdb1:

Model=TOSHIBA DT01ACA300, FwRev=MX6OABB0, SerialNo=xxxxxxxxx

Config={ HardSect NotMFM HdSw>15uSec Fixed DTR>10Mbs }

RawCHS=16383/16/63, TrkSize=0, SectSize=0, ECCbytes=56

BuffType=DualPortCache, BuffSize=unknown, MaxMultSect=16, MultSect=16

CurCHS=16383/16/63, CurSects=16514064, LBA=yes, LBAsects=5860533168

IORDY=on/off, tPIO={min:120,w/IORDY:120}, tDMA={min:120,rec:120}

PIO modes: pio0 pio1 pio2 pio3 pio4

DMA modes: mdma0 mdma1 mdma2

UDMA modes: udma0 udma1 udma2 udma3 udma4 udma5 *udma6

AdvancedPM=yes: disabled (255) WriteCache=enabled

Drive conforms to: unknown: ATA/ATAPI-2,3,4,5,6,7

* signifies the current active mode

badblocks を実行。

sudo badblocks -s -o badblocks-DT01ACA300.txt /dev/sdb1

- -s : スキャンの進捗を表示

- -o hoge.txt : 不良セクタの場所をテキストファイルに保存

5時間ぐらいかかってチェック終了。不良セクタは無い、と言ってきた。

もし不良セクタがあった場合は、そのセクタを使わないようにマークをつけてやる必要があるらしい。そのあたりは前述の参考ページで解説されてる。

*1: サブPCの5インチベイにリムーバブルケースを入れてあるので、そこにHDDを差し込んだ。

[ ツッコむ ]

#2 [ubuntu] Ubuntu Linux 22.04 LTSを動かしてるサブPCにカーネルオプションを指定

Ubuntu Linux 22.04 LTS を動かしてるサブPCには、Intel Core i3-6100T が載ってる。内蔵GPUは、Intel HD Graphics 530。このGPUについてググってたら、カーネルオプションとやらを渡すと不具合が解決する、という話を見かけたので、一応そのあたりを設定してみた。

_Dell XPS 15 (9550) - ArchWiki

自分のサブPCは、Dell XPS 15 (9550) ではないけれど、Intel HD Graphics 530 が入ってるCPUという点は同じであろう気がする。grub の設定で、このあたりの指定を追加してみた。バックライト云々は関係ないから、それ以外の3つを列挙してみよう…。

「Intel HD Graphics 530 では、*-video-intel ドライバを使えば良い」と書いてあるので、パッケージ、xserver-xorg-video-intel もインストール。ただ、これは既にインストール済みだった。

_Dell XPS 15 (9550) - ArchWiki

ブートパラメータ

以下のカーネルパラメータを使用することで解決できる問題があります:

i915.edp_vswing=2 i915.preliminary_hw_support=1 intel_idle.max_cstate=1 acpi_backlight=vendor acpi_osi=Linux

i915.edp_vswing=2 画面のちらつきを抑えます。

i915.preliminary_hw_support=1 Intel Graphics の問題を解決します。

intel_idle.max_cstate=1 CPU の C ステート が 1 より大きくならなくなります。

acpi_backlight=vendor acpi_osi=Linux バックライトが制御できるようになります。

グラフィック設定

Dell XPS 15 9550 は Intel HD Graphics 530 内蔵グラフィックを搭載しています。モデルによっては Nvidia GeForce GTX 960 カードが接続されていたりハイブリッド構成になっています。

内蔵グラフィックしか存在しないコンピュータでは、xf86-video-intel ドライバーをインストールしてください。

自分のサブPCは、Dell XPS 15 (9550) ではないけれど、Intel HD Graphics 530 が入ってるCPUという点は同じであろう気がする。grub の設定で、このあたりの指定を追加してみた。バックライト云々は関係ないから、それ以外の3つを列挙してみよう…。

sudo vi /etc/default/grub

... GRUB_CMDLINE_LINUX_DEFAULT="noquiet nosplash i915.edp_vswing=2 i915.preliminary_hw_support=1 intel_idle.max_cstate=1" ...

sudo update-grub

「Intel HD Graphics 530 では、*-video-intel ドライバを使えば良い」と書いてあるので、パッケージ、xserver-xorg-video-intel もインストール。ただ、これは既にインストール済みだった。

sudo apt install xserver-xorg-video-intel

[ ツッコむ ]

2023/05/07(日) [n年前の日記]

#1 [pc] HDDに不良セクタがないかチェック

3.5インチHDD、TOSHIBA MD03ACA400 (4TB, SATA600, 7600rpm)に不良セクタが無いかチェックしておいた。

7時間10分ほどかかって処理終了。不良セクタ数は0。問題無し。

ちなみに、CrystalDiskInfo で調べたところ、「SATA/600 | SATA/600」「使用時間 9871時間」と表示されていた。9,000時間以上動いていたなら、すぐに壊れてしまう個体では無さそう。

- OS : Windows10 x64 22H2

- CPU : AMD Ryzen 5 5600X

- HDDスタンド : Logitec LGB-1BSTU3 (USB3.0接続)

- ツール : HDD Scan V2.0

7時間10分ほどかかって処理終了。不良セクタ数は0。問題無し。

ちなみに、CrystalDiskInfo で調べたところ、「SATA/600 | SATA/600」「使用時間 9871時間」と表示されていた。9,000時間以上動いていたなら、すぐに壊れてしまう個体では無さそう。

◎ OWL-EGP35/EUとの比較 :

今回、USB3.0接続のHDDスタンドを使って作業したわけだけど。別PC + HDDケース オウルテック OWL-EGP35/EU + センチュリー eSATA活してUSB3.0 CCA-ESU3 を使って、同じ型番のHDDをチェックした時は12時間ぐらいかかっていたので、それと比べると結構早い。前回と比べて、約6割程度の時間で処理が終わった。

今回、「SATA/600 | SATA/600」と表示されていたので、HDDもインターフェイスもSATA/600として検出されているらしい。前述の OWL-EGP35/EU + CCA-ESU3 の場合は「SATA/150 | SATA/600」と表示されていたので…。USB3.0で接続すると、必ず SATA/150 になってしまう、というわけではなさそう。USB3.0接続でも、SATA/600 として検出される場合もあるらしい。というか、ソレがフツーなのかもしれない。

やはり、OWL-EGP35/EU + CCA-ESU3 を使うと、フツーのUSB3.0接続外付けHDDケースより速度が遅くなってしまうようだなと。インターフェイスの種類も古くなるし、アクセス速度も約1.7倍ぐらい余計に時間がかかってしまう。HDDケースが古くてそうなるのか、それとも eSATA - USB3.0変換アダプタを使うとそうなるのかは分からんけど。

今回、「SATA/600 | SATA/600」と表示されていたので、HDDもインターフェイスもSATA/600として検出されているらしい。前述の OWL-EGP35/EU + CCA-ESU3 の場合は「SATA/150 | SATA/600」と表示されていたので…。USB3.0で接続すると、必ず SATA/150 になってしまう、というわけではなさそう。USB3.0接続でも、SATA/600 として検出される場合もあるらしい。というか、ソレがフツーなのかもしれない。

やはり、OWL-EGP35/EU + CCA-ESU3 を使うと、フツーのUSB3.0接続外付けHDDケースより速度が遅くなってしまうようだなと。インターフェイスの種類も古くなるし、アクセス速度も約1.7倍ぐらい余計に時間がかかってしまう。HDDケースが古くてそうなるのか、それとも eSATA - USB3.0変換アダプタを使うとそうなるのかは分からんけど。

[ ツッコむ ]

2023/05/08(月) [n年前の日記]

#1 [cg_tools] 画像生成AIをまた触り始めた

画像生成AI、Stable Diffusion web UI をまた触り始めた。いくつか気になる拡張やLoRA(追加学習データ)の話を見かけたので。

◎ flatを試した :

flatというLoRAを使うと、画像のディティールを細かくすることができるらしい。本来は、生成画像をフラットに、というか、のっぺりした感じにしてくれるものだけど、マイナス値を指定することで逆にフラット感を減らしてくれるのだとか。

_【Stable Diffusion】LoRAだけで手軽に画質をUPできるflat | ジコログ

_「flat」 LoRA による画風の変化と画像の精緻化【Stable Diffusion web UI】

_イラストに精緻なディテールを追加できる「flat LoRA」の紹介【Stable Diffusion】 | くろくまそふと

実写寄りのモデルデータで試してみたけど、違いがよく分からない…。イラスト/アニメ風のモデルデータで試さないと効果のほどが分かりづらいのかな…。

_【Stable Diffusion】LoRAだけで手軽に画質をUPできるflat | ジコログ

_「flat」 LoRA による画風の変化と画像の精緻化【Stable Diffusion web UI】

_イラストに精緻なディテールを追加できる「flat LoRA」の紹介【Stable Diffusion】 | くろくまそふと

実写寄りのモデルデータで試してみたけど、違いがよく分からない…。イラスト/アニメ風のモデルデータで試さないと効果のほどが分かりづらいのかな…。

◎ LowRAを試した :

LowRAというLoRAを使うと、生成画像を暗めな感じにしてくれるらしい。

_【LoRA】重厚感のあるローキー画像を生成できるLowRA | ジコログ

試してみたけど、たしかにダークな感じの生成画像が得られた。しかし、顔が崩れたり、手足その他がおかしくなる確率が上がってしまう気がする…。なかなか厳しい。

_【LoRA】重厚感のあるローキー画像を生成できるLowRA | ジコログ

試してみたけど、たしかにダークな感じの生成画像が得られた。しかし、顔が崩れたり、手足その他がおかしくなる確率が上がってしまう気がする…。なかなか厳しい。

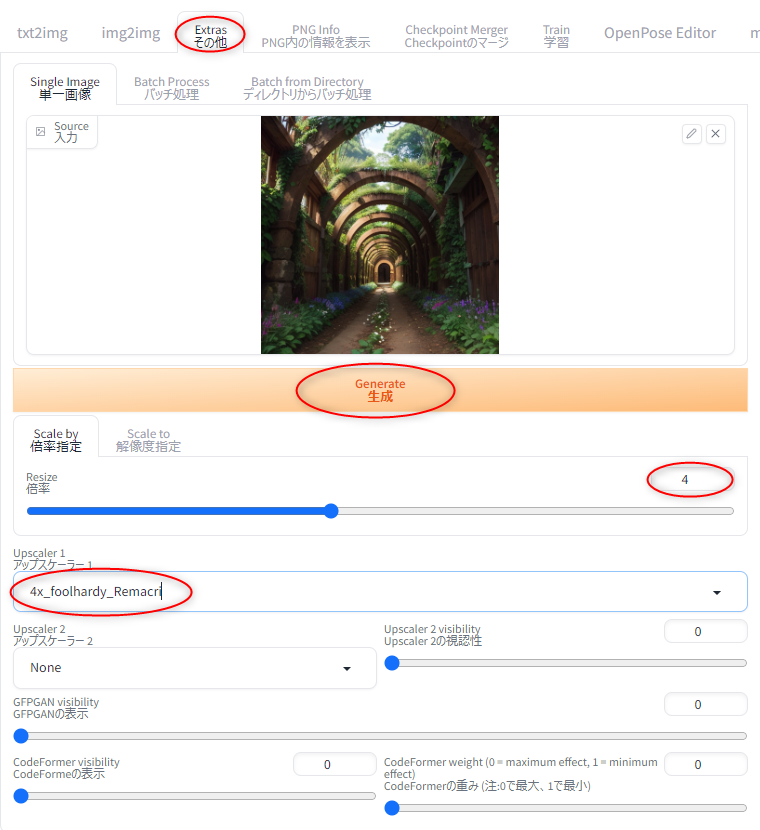

◎ Ultimate SD Upscaleを試した :

Ultimate SD Upscale という拡張機能を使うと、画像の高解像度化が早く、かつ、元画像より崩れにくくなるらしい。

_Ultimate SD Upscale【拡張機能のアップスケーラー】 | ジコログ

_【Stable Diffusion】「Ultimate SD Upscaler」を使って生成したAIイラストを高画質化する方法!【img2img】 | 悠々ログ

たしかにそれらしい画像が得られた。

ただ、画像を分割して処理していくので、分割した画像内で別人を生成してしまったりもするそうで。そんな時は ControlNet (tile_resample) と組み合わせると解決できる可能性があるのだとか。

_ControlNetとUltimate SD Upscaleを使った画像の高画質化 | ジコログ

_Ultimate SD Upscale【拡張機能のアップスケーラー】 | ジコログ

_【Stable Diffusion】「Ultimate SD Upscaler」を使って生成したAIイラストを高画質化する方法!【img2img】 | 悠々ログ

たしかにそれらしい画像が得られた。

ただ、画像を分割して処理していくので、分割した画像内で別人を生成してしまったりもするそうで。そんな時は ControlNet (tile_resample) と組み合わせると解決できる可能性があるのだとか。

_ControlNetとUltimate SD Upscaleを使った画像の高画質化 | ジコログ

◎ Loopback Scalerを試した :

Loopback Scaler という拡張機能を利用することで、高解像度の生成画像を得ることもできるらしい。

_Loopback Scalerによる画像の解像度・品質UP | ジコログ

_【Stable Diffusion】img2imgで簡単に高画質化できる拡張機能「Loopback scaler」の使い方を紹介! | 悠々ログ

試したところ、目標の画像サイズまで、少しずつ画像を拡大して生成していくようで…。たしかに目標の画像サイズにはなったものの、何度も何度も img2img を繰り返すせいか、元画像から随分とかけ離れた結果になった。まあ、これはこれで、予測不能な結果が出てくるから、何か使い道があるのかもしれない。

_Loopback Scalerによる画像の解像度・品質UP | ジコログ

_【Stable Diffusion】img2imgで簡単に高画質化できる拡張機能「Loopback scaler」の使い方を紹介! | 悠々ログ

試したところ、目標の画像サイズまで、少しずつ画像を拡大して生成していくようで…。たしかに目標の画像サイズにはなったものの、何度も何度も img2img を繰り返すせいか、元画像から随分とかけ離れた結果になった。まあ、これはこれで、予測不能な結果が出てくるから、何か使い道があるのかもしれない。

◎ Clip skipを変更できるようにした :

学習モデルデータによっては、Clip skip なる値を変更するとイイ感じの結果が得られたりすることもあるらしい。ただ、Stable Diffusion web UIは標準で、その値を変更できるようになってない。設定を変更して、Clip skipを変更できるようにした。

_Stable Diffusion Clip Skipについて: 設定方法と影響 | Gift by Gifted

_stable-diffusion-webui を素早く使いこなすためのtips - Qiita

結果は…。何が変わったのかちょっとよく分からないな…。

_Stable Diffusion Clip Skipについて: 設定方法と影響 | Gift by Gifted

_stable-diffusion-webui を素早く使いこなすためのtips - Qiita

結果は…。何が変わったのかちょっとよく分からないな…。

[ ツッコむ ]

#2 [pc] HDDに不良セクタがないかチェックその2

2.5インチHDDに不良セクタが無いかチェックしてた。

各HDDは、HDDスタンド Logitec LGB-1BSTU3 (2.5/3.5インチSATA接続HDD対応, USB3.0接続) に差して、メインPC(Windows10 x64 22H2)上で HDD-Scan V2.0 を起動してチェックした。

エラーは無し。不良セクタはまだ無いっぽい。

1.5TBのほうは、5時間前後でチェックが終わった。

2TBの3.5インチHDD + USB3.0接続の場合、4時間半で終わっていたので…。2.5インチHDDは、3.5インチHDDよりもアクセス速度が遅いことが、実測でも再認識できた。

さて、このHDD、どうしようか…。自分、2.5インチHDDケースを何も持ってないので、このままでは常用できない…。何かケースを買うしかないわな…。

以前、Logitec LGB-PBPU3 というHDDケースを持ってたこともあるのだけど、使っているうちに壊れてしまったのだよな…。おそらくはコントローラが死んでしまったのだろうと思うけど。できれば壊れにくいHDDケースが欲しいところだけど、どの製品も五十歩百歩なのでは、という予感も…。

- 2.5インチHDD HGST 7K1000-1000 HTS721010A9E630 (2.5インチ, 1TB, SATA600, 7200rpm, 9.5mm, 使用時間17321時間)

- 2.5インチHDD HGST 5K1500-1500 HTS541515A9E630 (2.5インチ, 1.5TB, SATA600, 5400rpm, 9.5mm, Cache 32MB, 使用時間328時間)

各HDDは、HDDスタンド Logitec LGB-1BSTU3 (2.5/3.5インチSATA接続HDD対応, USB3.0接続) に差して、メインPC(Windows10 x64 22H2)上で HDD-Scan V2.0 を起動してチェックした。

エラーは無し。不良セクタはまだ無いっぽい。

1.5TBのほうは、5時間前後でチェックが終わった。

2TBの3.5インチHDD + USB3.0接続の場合、4時間半で終わっていたので…。2.5インチHDDは、3.5インチHDDよりもアクセス速度が遅いことが、実測でも再認識できた。

さて、このHDD、どうしようか…。自分、2.5インチHDDケースを何も持ってないので、このままでは常用できない…。何かケースを買うしかないわな…。

以前、Logitec LGB-PBPU3 というHDDケースを持ってたこともあるのだけど、使っているうちに壊れてしまったのだよな…。おそらくはコントローラが死んでしまったのだろうと思うけど。できれば壊れにくいHDDケースが欲しいところだけど、どの製品も五十歩百歩なのでは、という予感も…。

[ ツッコむ ]

2023/05/09(火) [n年前の日記]

#1 [pc] 「排紙トレイが閉じている」とエラーが出る

親父さんからPC相談を受けた。親父さんが使っているインクジェットプリンタ、Canon PIXUS PRO-100S で、印刷しようとするとエラーが出るそうで。

エラーメッセージは以下。

_キヤノン:PIXUS マニュアル|PRO-100S series|1250

もちろん、排紙トレイはちゃんと開けてある。

ググってみたところ、Canon製プリンタには、排紙トレイが閉じているか/開いているかを検出するセンサがついていて、そのセンサの位置がおかしくなって正常に検出できない状態になると、こういったエラーメッセージが表示されて詰んでしまうらしい…。

_canon PiXUS 排紙トレイが閉じているため、印刷を行うことができません。 - パソコン出張サポート、パソポート代表の気まま日記

_インクジェットプリンタ徒然日記 レビュー PIXUS ip4100の修理 (WebArchive)

_『排紙トレーが閉じています』のエラーが出て印刷できないときの対処 | 使える無料ソフト&無料サービス

_『排紙トレイが閉じているため...』とは何だ?プリンターの不具合編1: Automatic

_PIXUS ip4200の自力修理を強行!『排紙トレイが閉じているため...』とは何だ?プリンターの不具合編2<解決版>: Automatic

iP4xxxx番台の製品なら、情報もそこそこあって、大体このあたりにセンサがあると分かるから、自力でどうにか解決できそうな気配があるのだけど。Canon PRO-100S という製品は、A3ノビまで印刷可能、8色インクと、ちょっとグレードが高い製品なので、関連情報は皆無。排紙トレイの周辺を眺めてみたけど、これがそのセンサだろう、というものは全く見つからなかった。

修理に出すしかなさそうだな…。

ちなみに、先日弟が帰省した際もこの問題は発生していて…。弟が少しググって調べたけれど、「センサの位置も種類も分からんから手詰まり」という結論になっていた。自分も今回調べてみたけど、やはり弟と同じ結論になってしまったなと…。

エラーメッセージは以下。

サポート番号 : 1250 排紙トレイが閉じているため、印刷を行うことができません。 排紙トレイを開けてください。印刷が再開されます。

_キヤノン:PIXUS マニュアル|PRO-100S series|1250

もちろん、排紙トレイはちゃんと開けてある。

ググってみたところ、Canon製プリンタには、排紙トレイが閉じているか/開いているかを検出するセンサがついていて、そのセンサの位置がおかしくなって正常に検出できない状態になると、こういったエラーメッセージが表示されて詰んでしまうらしい…。

_canon PiXUS 排紙トレイが閉じているため、印刷を行うことができません。 - パソコン出張サポート、パソポート代表の気まま日記

_インクジェットプリンタ徒然日記 レビュー PIXUS ip4100の修理 (WebArchive)

_『排紙トレーが閉じています』のエラーが出て印刷できないときの対処 | 使える無料ソフト&無料サービス

_『排紙トレイが閉じているため...』とは何だ?プリンターの不具合編1: Automatic

_PIXUS ip4200の自力修理を強行!『排紙トレイが閉じているため...』とは何だ?プリンターの不具合編2<解決版>: Automatic

iP4xxxx番台の製品なら、情報もそこそこあって、大体このあたりにセンサがあると分かるから、自力でどうにか解決できそうな気配があるのだけど。Canon PRO-100S という製品は、A3ノビまで印刷可能、8色インクと、ちょっとグレードが高い製品なので、関連情報は皆無。排紙トレイの周辺を眺めてみたけど、これがそのセンサだろう、というものは全く見つからなかった。

修理に出すしかなさそうだな…。

ちなみに、先日弟が帰省した際もこの問題は発生していて…。弟が少しググって調べたけれど、「センサの位置も種類も分からんから手詰まり」という結論になっていた。自分も今回調べてみたけど、やはり弟と同じ結論になってしまったなと…。

[ ツッコむ ]

2023/05/10(水) [n年前の日記]

#1 [pc] ダイソーのHDMIケーブルを入手しでHDMIセレクタの動作確認をした

ダイソーでHDMIケーブルを購入。300円商品。パッケージには「4K対応」とあちこちに印刷されてる。長さは1.5m。

コレを使って、HDMIセレクタ(HDMI切替器) GREEN HOUSE GH-HSWB3-BK の動作確認をしたい。先日動作確認した際は、Linuxのデスクトップ画面がノイズだらけになってしまって、HDMIケーブルがダメなのかなと気になったわけで…。

手持ちのHDMIケーブルは3つ。

接続した機器は以下。

結論を書くと、ダメだった。HDMIケーブルの組み合わせを色々変えてみたり、USB端子からHDMIセレクタの電源を取ってみたり、等々やってみたけど、ノイズは消えてくれないし、画面がそもそも映らなかったりで…。

どのHDMIケーブルも、ディスプレイと機器の間で、HDMIセレクタを介さずに直接繋げると、ちゃんとすんなり画面が映る。HDMIセレクタを通すとダメ。となると、HDMIケーブルには問題が無いと思われる。

コレも相性問題なのだろうか。それとも、HDMIセレクタが壊れているのだろうか。ググった感じでは、このHDMIセレクタ、数ヶ月でノイズが増えてきてそのまま壊れたという報告事例もチラホラ見かけるのだよな…。何をどうしたら正常動作しているのか、それとも壊れているのかが判別できるのだろう。

コレを使って、HDMIセレクタ(HDMI切替器) GREEN HOUSE GH-HSWB3-BK の動作確認をしたい。先日動作確認した際は、Linuxのデスクトップ画面がノイズだらけになってしまって、HDMIケーブルがダメなのかなと気になったわけで…。

手持ちのHDMIケーブルは3つ。

- 今回ダイソーで購入したHDMIケーブル。

- ELECOM製スリムタイプ HDMIケーブル。

- 弟から貰った謎のHDMIケーブル。

接続した機器は以下。

- 液晶ディスプレイ MITSUBISHI MDT243WG-SB

- Intel Core i5-2500機 (Ubuntu Linux 18.04 LTS)

- Raspberry Pi Zero W (Raspberry Pi OS, Debian系だったはず)

結論を書くと、ダメだった。HDMIケーブルの組み合わせを色々変えてみたり、USB端子からHDMIセレクタの電源を取ってみたり、等々やってみたけど、ノイズは消えてくれないし、画面がそもそも映らなかったりで…。

どのHDMIケーブルも、ディスプレイと機器の間で、HDMIセレクタを介さずに直接繋げると、ちゃんとすんなり画面が映る。HDMIセレクタを通すとダメ。となると、HDMIケーブルには問題が無いと思われる。

コレも相性問題なのだろうか。それとも、HDMIセレクタが壊れているのだろうか。ググった感じでは、このHDMIセレクタ、数ヶ月でノイズが増えてきてそのまま壊れたという報告事例もチラホラ見かけるのだよな…。何をどうしたら正常動作しているのか、それとも壊れているのかが判別できるのだろう。

[ ツッコむ ]

#2 [pc] 親父さんがプリンタを修理に出した

親父さんが使っているインクジェットプリンタ、Canon PIXUS PRO-100S が、「排紙トレイが閉じている」とエラーメッセージを出して印刷できない状態になっている問題について。

_「排紙トレイが閉じている」とエラーが出る - mieki256's diary

今日、親父さんが、ケーズデンキにプリンタを持ち込んで、メーカーに修理してもらうよう頼んできたらしい。

とりあえず、持っていく前に、自分も底面を眺めてセンサらしきものがないか調べてみたのだけど、残念ながらソレらしいものは見当たらず。一体どこにセンサがあるんだ…。

修理代は23,100円かかるらしい。修理料金が19,800円、配送が3,300円。プリンタの型番によって代金は違う。

_【インクジェットプリンター】 修理料金について

_「排紙トレイが閉じている」とエラーが出る - mieki256's diary

今日、親父さんが、ケーズデンキにプリンタを持ち込んで、メーカーに修理してもらうよう頼んできたらしい。

とりあえず、持っていく前に、自分も底面を眺めてセンサらしきものがないか調べてみたのだけど、残念ながらソレらしいものは見当たらず。一体どこにセンサがあるんだ…。

修理代は23,100円かかるらしい。修理料金が19,800円、配送が3,300円。プリンタの型番によって代金は違う。

_【インクジェットプリンター】 修理料金について

◎ 新しいプリンタを買ったほうが良さそうなのだけど :

価格.comで調べてみたら、A3ノビ印刷可能なCanon製プリンタとして、PIXUS iX6830、PIXUS iP8730 もあるようで。発売日は2014年。約10年前から売られている製品。お値段は、24,000 - 26,000円台。

PRO-100S の修理代を考えたら、新しいプリンタを買ってしまったほうがいいのでは…?

もっとも、PRO-100Sと比べてお安い分、当然スペックは違う。上記の2つは、インクが5色、6色らしい。PRO-100Sは8色だから、2〜3色分は我慢することになる。

もっとも、PRO-100S の印刷解像度は 4800 x 2400 dpi。上記の2つは 9600 x 2400 dpi。PRO-100Sより最小インク滴サイズとやらが小さいから、インク数が少ない分は解像度の高さでカバー、と捉えることもできそう。

大体にして、A3等で印刷して壁に飾ってある写真に、わざわざ顔を近づけて、「あー、インクジェットの粒々が見えちゃうなあ。コイツはダメだ」なんて言い出すヤツはまず居ない…。それに、親父さんは目が悪くなって、せっかくの一眼レフデジカメでピンボケ写真ばかり撮ってる状態。インクジェットプリンタの粒々なんて、もう視認できないし、そんなところを気にするぐらいなら、まず写真のピンボケを気にするべきで…。

そんなわけで、「新しいプリンタを買ったほうがいいのではないか」「どうせ PRO-100Sは色々くたびれてきてるから、この後もまた壊れて修理に出す羽目になるかもしれない」とアドバイスしてみたのだけど。「PRO-100S用のインクを買ったばかりだからもったいない」と言い出して…。

まあ、修理するにしても、新品を買うにしても、同程度の出費は必須なので、今回は修理に出すことにした模様。

A3で印刷しなければならない機会がどのくらいあるのかと考えると、無駄な出費のような気もするのだけど…。

PRO-100S の修理代を考えたら、新しいプリンタを買ってしまったほうがいいのでは…?

もっとも、PRO-100Sと比べてお安い分、当然スペックは違う。上記の2つは、インクが5色、6色らしい。PRO-100Sは8色だから、2〜3色分は我慢することになる。

もっとも、PRO-100S の印刷解像度は 4800 x 2400 dpi。上記の2つは 9600 x 2400 dpi。PRO-100Sより最小インク滴サイズとやらが小さいから、インク数が少ない分は解像度の高さでカバー、と捉えることもできそう。

大体にして、A3等で印刷して壁に飾ってある写真に、わざわざ顔を近づけて、「あー、インクジェットの粒々が見えちゃうなあ。コイツはダメだ」なんて言い出すヤツはまず居ない…。それに、親父さんは目が悪くなって、せっかくの一眼レフデジカメでピンボケ写真ばかり撮ってる状態。インクジェットプリンタの粒々なんて、もう視認できないし、そんなところを気にするぐらいなら、まず写真のピンボケを気にするべきで…。

そんなわけで、「新しいプリンタを買ったほうがいいのではないか」「どうせ PRO-100Sは色々くたびれてきてるから、この後もまた壊れて修理に出す羽目になるかもしれない」とアドバイスしてみたのだけど。「PRO-100S用のインクを買ったばかりだからもったいない」と言い出して…。

まあ、修理するにしても、新品を買うにしても、同程度の出費は必須なので、今回は修理に出すことにした模様。

A3で印刷しなければならない機会がどのくらいあるのかと考えると、無駄な出費のような気もするのだけど…。

◎ ドライバの作りで回避できそうな気もする :

ググったところ、Canon製プリンタにおいて「排紙トレイが閉じてますエラー」は結構な頻度で発生してしまう故障らしいけど、こんなに故障が多いなら、センサの検出結果を無視する機能をドライバにつけておいてもいいのではないかと思えてきた。

例えば、エラーメッセージダイアログに、「強制的に印刷を続ける」ボタンでも追加してあれば…。あるいは、レジストリを弄るとセンサ結果を無視して動くようになるとか…。

大体にして、これから印刷しようとしてるのに、排紙トレイを閉じているユーザのほうがおかしい。うっかり閉じていて、紙が中でグシャグシャになっても、それこそ自己責任だろう…。トイレに入って大をするなら、誰でもパンツを下ろすわけで、パンツを履いたまま大をして「どうしてくれる!」と怒り出すほうがおかしい。パンツを下ろしてないお前が悪い。

でもまあ、そういった、センサの検出結果を無視する機能をつけないことで、Canonさんは修理代金を貰えるわけだし。ただでさえプリンタ本体は赤字覚悟で販売してるのだから、少しでも別の何かで儲ける仕組みを作らないとアレだよな…。

いや、でも、この手の修理を引き受けるのも、それはそれで結構面倒臭くないのだろうか…。修理不要な状態に近づけていくことも、コスト削減の一環だったりしないか…。

例えば、エラーメッセージダイアログに、「強制的に印刷を続ける」ボタンでも追加してあれば…。あるいは、レジストリを弄るとセンサ結果を無視して動くようになるとか…。

大体にして、これから印刷しようとしてるのに、排紙トレイを閉じているユーザのほうがおかしい。うっかり閉じていて、紙が中でグシャグシャになっても、それこそ自己責任だろう…。トイレに入って大をするなら、誰でもパンツを下ろすわけで、パンツを履いたまま大をして「どうしてくれる!」と怒り出すほうがおかしい。パンツを下ろしてないお前が悪い。

でもまあ、そういった、センサの検出結果を無視する機能をつけないことで、Canonさんは修理代金を貰えるわけだし。ただでさえプリンタ本体は赤字覚悟で販売してるのだから、少しでも別の何かで儲ける仕組みを作らないとアレだよな…。

いや、でも、この手の修理を引き受けるのも、それはそれで結構面倒臭くないのだろうか…。修理不要な状態に近づけていくことも、コスト削減の一環だったりしないか…。

[ ツッコむ ]

2023/05/11(木) [n年前の日記]

#1 [linux] Linux MintとiPhoneをケーブル接続して画像を取り出したい

Linux Mint と iPhone をケーブル接続して iPhone からファイルを取り出したい、という相談を受けた。そんなこと、できるのだろうか…?

ググってみたら、フツーにできるっぽい。Linux、スゴイな…。そんなこともできるぐらいに整備されていたとは…。

_iphone→debianへ写真をUSB経由でコピーする - Super Action Shooting Game 4

_iPhone 7(iOS12)をUbuntu 19.10でmountしてデータコピー - matoken's meme

_#linux iPhoneが再接続できないときの対症療法 - Kotet's Personal Blog

_iOS - ArchWiki

_Ubuntu18.04からiPhone(iOS 10.2)にアクセスする - Qiita

_LinuxでiPhoneを接続して写真などを転送する方法 - Qiita

_LinuxMint でiPhoneのバックアップをする方法【画像、動画、音楽、書類など】 - meotoblog

せっかくだから、以下の環境で、iPhone 5 をケーブル接続して試してみた。

ググってみたら、フツーにできるっぽい。Linux、スゴイな…。そんなこともできるぐらいに整備されていたとは…。

_iphone→debianへ写真をUSB経由でコピーする - Super Action Shooting Game 4

_iPhone 7(iOS12)をUbuntu 19.10でmountしてデータコピー - matoken's meme

_#linux iPhoneが再接続できないときの対症療法 - Kotet's Personal Blog

_iOS - ArchWiki

_Ubuntu18.04からiPhone(iOS 10.2)にアクセスする - Qiita

_LinuxでiPhoneを接続して写真などを転送する方法 - Qiita

_LinuxMint でiPhoneのバックアップをする方法【画像、動画、音楽、書類など】 - meotoblog

せっかくだから、以下の環境で、iPhone 5 をケーブル接続して試してみた。

- VMware Player 17.0.2 build-21581411 + Linux Mint 21.1 "Vera" Cinnamon 64bit

- 実機(CPU: AMD A6-3500) + Linux Mint 21.1 "Vera" Cinnamon 64bit

◎ 事前準備 :

まず、必要なソフトウェアをインストールしないといけない。ifuse と libimobiledevice-utils が必要らしい。端末上で以下を打つ。

ただ、Linux Mint 21.1 の場合、どちらも最初からデフォルトで入っていた。このインストール作業をする必要は無さそう。

次に、USB機器関連サービス、usbmuxd.service とやらが動作してるのか確認。

「Active」のところで、「inactive (dead)」と出てきた。コレって動いてるの…? どうなの? 「dead」って出てるから死んでるんじゃないの?

よく分からないけど、とりあえず、該当サービスを再起動して、もう一度状態を確認。

「active (running)」と表示されてる。たぶん動いているんだろう…。ちなみに、そのままだとログの一部を表示して止まるので、qキーを叩いて抜ける。

とりあえず、このあたりの動作が不安定な時は、usbmuxd.service を再起動すると状況が変わるらしい。

sudo apt install ifuse libimobiledevice-utils

ただ、Linux Mint 21.1 の場合、どちらも最初からデフォルトで入っていた。このインストール作業をする必要は無さそう。

$ sudo apt list --installed | grep -e 'ifuse' -e 'imobile' ifuse/jammy,now 1.1.4~git20181007.3b00243-1 amd64 [インストール済み] libimobiledevice-utils/jammy,now 1.3.0-6build3 amd64 [インストール済み] libimobiledevice6/jammy,now 1.3.0-6build3 amd64 [インストール済み]

次に、USB機器関連サービス、usbmuxd.service とやらが動作してるのか確認。

sudo systemctl status usbmuxd.service

$ sudo systemctl status usbmuxd.service

○ usbmuxd.service - Socket daemon for the usbmux protocol used by Apple devices

Loaded: loaded (/lib/systemd/system/usbmuxd.service; static)

Active: inactive (dead)

Docs: man:usbmuxd(8)

「Active」のところで、「inactive (dead)」と出てきた。コレって動いてるの…? どうなの? 「dead」って出てるから死んでるんじゃないの?

よく分からないけど、とりあえず、該当サービスを再起動して、もう一度状態を確認。

sudo systemctl restart usbmuxd.service sudo systemctl status usbmuxd.service

$ sudo systemctl status usbmuxd.service

● usbmuxd.service - Socket daemon for the usbmux protocol used by Apple devices

Loaded: loaded (/lib/systemd/system/usbmuxd.service; static)

Active: active (running) since Thu 2023-05-11 19:54:32 JST; 2s ago

Docs: man:usbmuxd(8)

Main PID: 1853 (usbmuxd)

Tasks: 2 (limit: 4512)

Memory: 940.0K

CPU: 2ms

CGroup: /system.slice/usbmuxd.service

└─1853 /usr/sbin/usbmuxd --user usbmux --systemd

5月 11 19:54:32 linuxmintonvm systemd[1]: Started Socket daemon for the usbmux protocol used by Apple devices.

5月 11 19:54:33 linuxmintonvm usbmuxd[1853]: [19:54:33.023][3] usbmuxd v1.1.1 starting up

5月 11 19:54:33 linuxmintonvm usbmuxd[1853]: [19:54:33.023][3] Successfully dropped privileges to 'usbmux'

5月 11 19:54:33 linuxmintonvm usbmuxd[1853]: [19:54:33.023][3] Using libusb 1.0.25

5月 11 19:54:33 linuxmintonvm usbmuxd[1853]: [19:54:33.024][3] Initialization complete

5月 11 19:54:33 linuxmintonvm usbmuxd[1853]: [19:54:33.024][3] Enabled exit on SIGUSR1 if no devices are attac>

「active (running)」と表示されてる。たぶん動いているんだろう…。ちなみに、そのままだとログの一部を表示して止まるので、qキーを叩いて抜ける。

とりあえず、このあたりの動作が不安定な時は、usbmuxd.service を再起動すると状況が変わるらしい。

◎ 接続してみる :

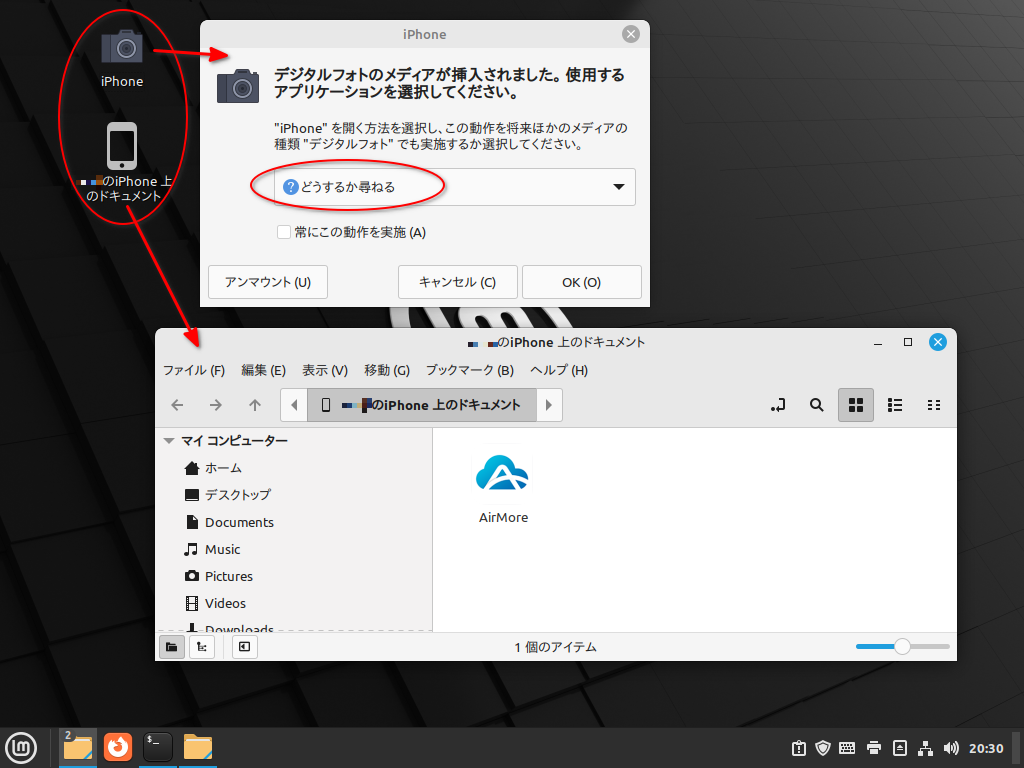

iPhone 5 と Linux Mint を、ケーブルで接続してみる。

Linux Mint のデスクトップ画面に、「〜がロックされてる」的なメッセージが表示された。「再試行」をクリックすればいいのだけど、その前に、iPhone の画面上に「接続を許可するか?」「このコンピュータを信頼するか?」的なポップアップが表示されているはずなので、「許可」や「信頼」をタップ。

ちなみに、このポップアップ、一定時間が経過すると、「ずっと放置されるってことは、この相手は信頼できないってことですかね?」的に、自動で不許可/ブロック扱いにしてくれる模様。だから、iPhone の画面をちゃんと監視して、ポップアップが出たら即座に対応しないといけない。

Linux Mint のデスクトップに、スマホっぽい形のアイコンが1つ表示された。ただ、この状態では正常に繋がってないっぽい。

iPhone からケーブルを外して、再度ケーブルを差し込んで接続。

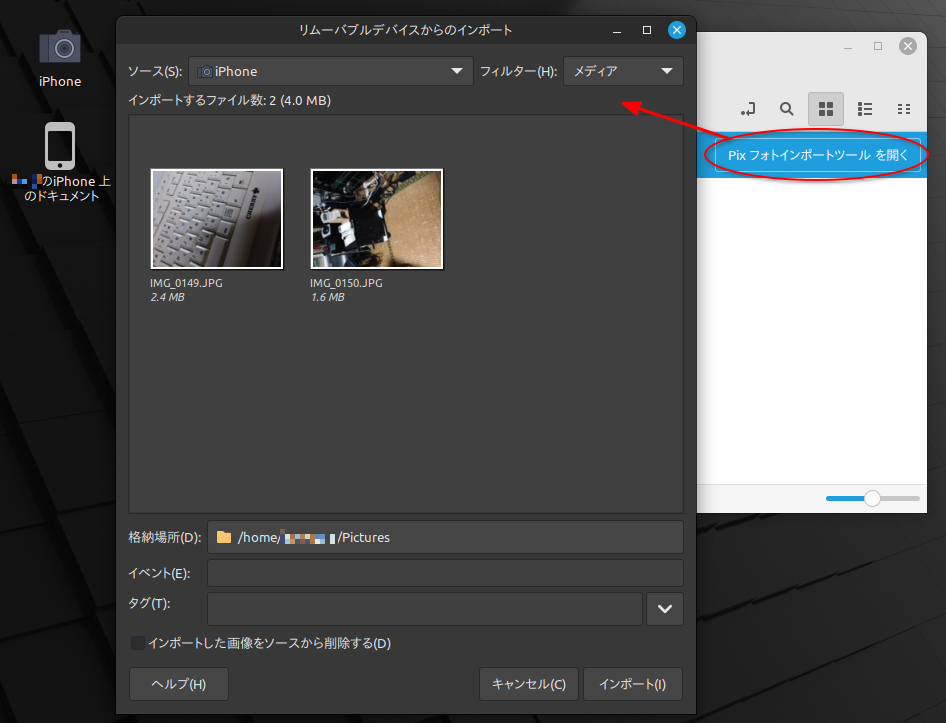

Linux Mint のデスクトップ画面に、スマホっぽい形のアイコンと、カメラっぽいアイコン(iPhoneと書いてある)が表示された。この状態が正常らしい。同時に、ファイルマネージャのウインドウが一つ、画像フォルダの扱いをどうするか尋ねてくるウインドウが一つ、自動で表示された。

画像フォルダをどう扱うか尋ねてきたウインドウに対して、「フォルダーを開く」を選択して「OK」をクリックすると…。

「画像が入っている『DCIM』というフォルダがあるよ」的なウインドウが開く。「DCIM」は、「Digital Camera IMage」の略なんだろうか?

DCIMをダブルクリックして中に入ると、100APPLE というフォルダがあって、更にその中に入ると、iPhoneで撮影した画像ファイルの一覧が表示される。

「Pix フォトインポートツールを開く」というボタンが気になる…。クリックしてみた。

画像ファイルをインポートできる専用ツールが起動してくれた。これを使って、iPhone の中の画像ファイルを、Linux Mint側の任意のフォルダにインポートできるらしい。Linux Mint、至れり尽くせりだな…。

Linux Mint のデスクトップ画面に、「〜がロックされてる」的なメッセージが表示された。「再試行」をクリックすればいいのだけど、その前に、iPhone の画面上に「接続を許可するか?」「このコンピュータを信頼するか?」的なポップアップが表示されているはずなので、「許可」や「信頼」をタップ。

ちなみに、このポップアップ、一定時間が経過すると、「ずっと放置されるってことは、この相手は信頼できないってことですかね?」的に、自動で不許可/ブロック扱いにしてくれる模様。だから、iPhone の画面をちゃんと監視して、ポップアップが出たら即座に対応しないといけない。

Linux Mint のデスクトップに、スマホっぽい形のアイコンが1つ表示された。ただ、この状態では正常に繋がってないっぽい。

iPhone からケーブルを外して、再度ケーブルを差し込んで接続。

Linux Mint のデスクトップ画面に、スマホっぽい形のアイコンと、カメラっぽいアイコン(iPhoneと書いてある)が表示された。この状態が正常らしい。同時に、ファイルマネージャのウインドウが一つ、画像フォルダの扱いをどうするか尋ねてくるウインドウが一つ、自動で表示された。

画像フォルダをどう扱うか尋ねてきたウインドウに対して、「フォルダーを開く」を選択して「OK」をクリックすると…。

「画像が入っている『DCIM』というフォルダがあるよ」的なウインドウが開く。「DCIM」は、「Digital Camera IMage」の略なんだろうか?

DCIMをダブルクリックして中に入ると、100APPLE というフォルダがあって、更にその中に入ると、iPhoneで撮影した画像ファイルの一覧が表示される。

「Pix フォトインポートツールを開く」というボタンが気になる…。クリックしてみた。

画像ファイルをインポートできる専用ツールが起動してくれた。これを使って、iPhone の中の画像ファイルを、Linux Mint側の任意のフォルダにインポートできるらしい。Linux Mint、至れり尽くせりだな…。

◎ 切断してみる :

画面の右下のタスクトレイ(?)に、「リムーバブルドライブ」のアイコンが増えている。

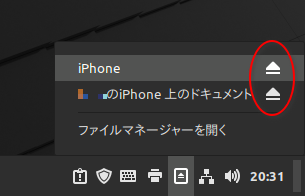

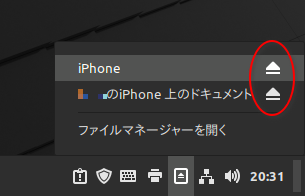

クリックすると、「iPhone」と「xxxxのiPhone上のドキュメント」の2つがリスト表示される。右側の、上向きの三角をクリックすれば、それぞれアンマウントすることができる。まあ、iPhoneからケーブルを抜いちゃったほうが早い気もするけど…。

そんなわけで、Linu Mint に iPhone 5 をケーブル接続して、中の画像ファイルを取り出すことができそうだと分かった。

クリックすると、「iPhone」と「xxxxのiPhone上のドキュメント」の2つがリスト表示される。右側の、上向きの三角をクリックすれば、それぞれアンマウントすることができる。まあ、iPhoneからケーブルを抜いちゃったほうが早い気もするけど…。

そんなわけで、Linu Mint に iPhone 5 をケーブル接続して、中の画像ファイルを取り出すことができそうだと分かった。

◎ 問題点 :

どうも一発で認識してくれない時がある…。そんな時は…。

ちゃんと接続できるかどうか、成功率は半々な印象。

- iPhone側でケーブルを何度か抜き差ししてみる。

- ケーブルを外した状態で、sudo systemctl restart usbmuxd.service を実行して usbmuxd.service を再起動してから試してみる。

ちゃんと接続できるかどうか、成功率は半々な印象。

◎ 他の方法 :

ケーブル接続を使わなくても、iPhone の中のファイルを取り出すことはできる。例えば自分は AirMore というアプリを iPhone 5 にインストールして使ってる。

この AirMore を起動すると、PC側のWebブラウザから iPhone にアクセスして、画像ファイルその他を取り出せる。

_「AirMore - PCに接続」をApp Storeで

Apowersoft Limited という会社(?)が作ってる点に注意。Apple Store で「airmore」で検索すると、別作者の別アプリがリストアップされる…。怪しい…。

また、本来はPC側Webブラウザで、 _http://web.airmore.com/ にアクセスするとQRコードが表示され、それをiPhoneでスキャンすれば利用できるはずが…。ここ最近、QRコードが表示されない状態で…。その際は、iPhone側右上の「…」をタップしてIPアドレスを確認後、PC側Webブラウザのアドレスバーに直接打ち込めばいいらしい。

_AirMoreに繋がらない→IPアドレスで接続する方法 | TeraDas

ちなみに、Windows10 + Firefox/GoogleChrome の他に、Linux Mint + Firefox でもiPhoneにアクセスできることを確認できた。今時のWebブラウザさえ動けば、PC側のOS種類を問わない点はメリットかなと。

この AirMore を起動すると、PC側のWebブラウザから iPhone にアクセスして、画像ファイルその他を取り出せる。

_「AirMore - PCに接続」をApp Storeで

Apowersoft Limited という会社(?)が作ってる点に注意。Apple Store で「airmore」で検索すると、別作者の別アプリがリストアップされる…。怪しい…。

また、本来はPC側Webブラウザで、 _http://web.airmore.com/ にアクセスするとQRコードが表示され、それをiPhoneでスキャンすれば利用できるはずが…。ここ最近、QRコードが表示されない状態で…。その際は、iPhone側右上の「…」をタップしてIPアドレスを確認後、PC側Webブラウザのアドレスバーに直接打ち込めばいいらしい。

_AirMoreに繋がらない→IPアドレスで接続する方法 | TeraDas

ちなみに、Windows10 + Firefox/GoogleChrome の他に、Linux Mint + Firefox でもiPhoneにアクセスできることを確認できた。今時のWebブラウザさえ動けば、PC側のOS種類を問わない点はメリットかなと。

[ ツッコむ ]

2023/05/12(金) [n年前の日記]

#1 [cg_tools] 画像生成AIで漫画画像を実写っぽくしたかったけど難しそう

画像生成AI、Stable Diffusion web UIを使って実験中。白黒で描かれた漫画っぽい画像の1コマを入力して実写っぽい画像を出力できたりしないものかな、と…。

ちょっと作業した感じでは、いくつか問題点がありそうだなと思えてきた。

問題その1。吹き出しや擬音をどうするか問題。

イラストならともかく、漫画の場合は吹き出しや擬音が描き込まれているので、漫画の1コマをそのまま画像生成AIに入力、と言うわけにはいかないよなと。AIは、ここが吹き出し、ここは擬音、などと判別できないのだろうから、そのあたりを奇麗に除去した画像を渡してやらないといかん気がする。

ということで、既存の画像編集ツールを起動して、吹き出しや擬音を消して、それらの後ろにあったのかもしれない何かしらを描き加えていく、という作業が発生してしまって…。これでは全然お手軽ではないよなあ、と…。

問題その2。線には色んな種類がある問題。

自分達は、線と言うと、形状の輪郭線を表現するために描かれた線ばかりを想像してしまうけど。漫画の場合、それ以外の線も多数描き込まれているわけで…。

漫画と言うメディアの表現力を増すために、漫画家さんが創意工夫で考案して、せっせと描き込まれた様々な種類の線が、AIに処理させる際には単に盛大なノイズになってしまうこの状況は、なんだか興味深いものがあるなと…。先人達の発明品を特に使ってない、漫画としてはダメダメな漫画絵ほど、AIにとっては処理しやすいかもしれない、という…。

問題その3。各コマの縦横比問題。

現状の画像生成AIは、512x512、1:1という縦横比で画像を学習してるわけだけど。漫画の各コマは、縦横比がバラエティに富んでいるわけで…。1:1にする際に、足りない部分はどうするか、という問題が…。

そんなわけで、少し試してみただけでも、白黒漫画をサクッと実写風に、というのは結構面倒臭い作業が発生するなと思えてきた。漫画という表現の、技の豊かさを再認識したというか…。似たようなものとして扱われがちだけど、只のイラストとは全然違うのですよ。みたいな。

それにしても、何でもそうだけど実際に手を動かして試してみると、そこでようやく色々な問題が見えてくるものなんだなと思ったりもして…。「そんなのAI任せでワンクリック」なんてまだまだ遠いなと。

ちょっと作業した感じでは、いくつか問題点がありそうだなと思えてきた。

問題その1。吹き出しや擬音をどうするか問題。

イラストならともかく、漫画の場合は吹き出しや擬音が描き込まれているので、漫画の1コマをそのまま画像生成AIに入力、と言うわけにはいかないよなと。AIは、ここが吹き出し、ここは擬音、などと判別できないのだろうから、そのあたりを奇麗に除去した画像を渡してやらないといかん気がする。

ということで、既存の画像編集ツールを起動して、吹き出しや擬音を消して、それらの後ろにあったのかもしれない何かしらを描き加えていく、という作業が発生してしまって…。これでは全然お手軽ではないよなあ、と…。

問題その2。線には色んな種類がある問題。

自分達は、線と言うと、形状の輪郭線を表現するために描かれた線ばかりを想像してしまうけど。漫画の場合、それ以外の線も多数描き込まれているわけで…。

- 陰影や色の違いを表現するためのハッチングの線。

- 汗だの動作だのを表現する漫符的な線。

漫画と言うメディアの表現力を増すために、漫画家さんが創意工夫で考案して、せっせと描き込まれた様々な種類の線が、AIに処理させる際には単に盛大なノイズになってしまうこの状況は、なんだか興味深いものがあるなと…。先人達の発明品を特に使ってない、漫画としてはダメダメな漫画絵ほど、AIにとっては処理しやすいかもしれない、という…。

問題その3。各コマの縦横比問題。

現状の画像生成AIは、512x512、1:1という縦横比で画像を学習してるわけだけど。漫画の各コマは、縦横比がバラエティに富んでいるわけで…。1:1にする際に、足りない部分はどうするか、という問題が…。

そんなわけで、少し試してみただけでも、白黒漫画をサクッと実写風に、というのは結構面倒臭い作業が発生するなと思えてきた。漫画という表現の、技の豊かさを再認識したというか…。似たようなものとして扱われがちだけど、只のイラストとは全然違うのですよ。みたいな。

それにしても、何でもそうだけど実際に手を動かして試してみると、そこでようやく色々な問題が見えてくるものなんだなと思ったりもして…。「そんなのAI任せでワンクリック」なんてまだまだ遠いなと。

[ ツッコむ ]

2023/05/13(土) [n年前の日記]

#1 [cg_tools] 画像生成AIを触ってる

画像生成AI Stable Diffusion web UI で、白黒漫画を実写画像っぽくできないものかなと実験中。

キャラが床に寝転がってる系の画像を入力すると、とんでもない結果が出てくるなと…。それはまあ、当然のような気もする。巷で公開されてる実写画像/写真の類は、頭が上、足が下になっているものが大多数なので…。頭が下、足が上になっている画像を渡してみても、学習データの中にそんな構図の画像は無いから、それでも無理矢理画像を作ろうとして、ホラー画像が生成されてしまうのだろう…。

ならばと、入力画像を180度回転して、天地が逆になっている状態にして渡してみたのだけど、これまたとんでもない画像が生成された。おそらくは人物のポーズがよくあるポーズではなくて、漫画らしい特殊なポーズだから、ホラー画像になってしまうのだろう…。

結局のところ、AIは、学習してない構図やポーズは出力できませんよ、ということだろうなと。人間のように、「3次元的にはこういう物体がそこに存在しているのだろうから、ソレをこっちから見たらおそらくこんな形で見えるはずだよね」みたいな類推は、まだほとんどできないのだろう。

となると、人間の絵描きさんがAIに勝つための道も、なんだかうっすら見えてくる。AIが苦手な構図、苦手なポーズは、まだまだたくさんあるはずで。こういう構図、こういうポーズは、やっぱり人間じゃないと描けないよなあ、などと感心される場面は絶対にあるよなと。

キャラが床に寝転がってる系の画像を入力すると、とんでもない結果が出てくるなと…。それはまあ、当然のような気もする。巷で公開されてる実写画像/写真の類は、頭が上、足が下になっているものが大多数なので…。頭が下、足が上になっている画像を渡してみても、学習データの中にそんな構図の画像は無いから、それでも無理矢理画像を作ろうとして、ホラー画像が生成されてしまうのだろう…。

ならばと、入力画像を180度回転して、天地が逆になっている状態にして渡してみたのだけど、これまたとんでもない画像が生成された。おそらくは人物のポーズがよくあるポーズではなくて、漫画らしい特殊なポーズだから、ホラー画像になってしまうのだろう…。

結局のところ、AIは、学習してない構図やポーズは出力できませんよ、ということだろうなと。人間のように、「3次元的にはこういう物体がそこに存在しているのだろうから、ソレをこっちから見たらおそらくこんな形で見えるはずだよね」みたいな類推は、まだほとんどできないのだろう。

となると、人間の絵描きさんがAIに勝つための道も、なんだかうっすら見えてくる。AIが苦手な構図、苦手なポーズは、まだまだたくさんあるはずで。こういう構図、こういうポーズは、やっぱり人間じゃないと描けないよなあ、などと感心される場面は絶対にあるよなと。

[ ツッコむ ]

2023/05/14(日) [n年前の日記]

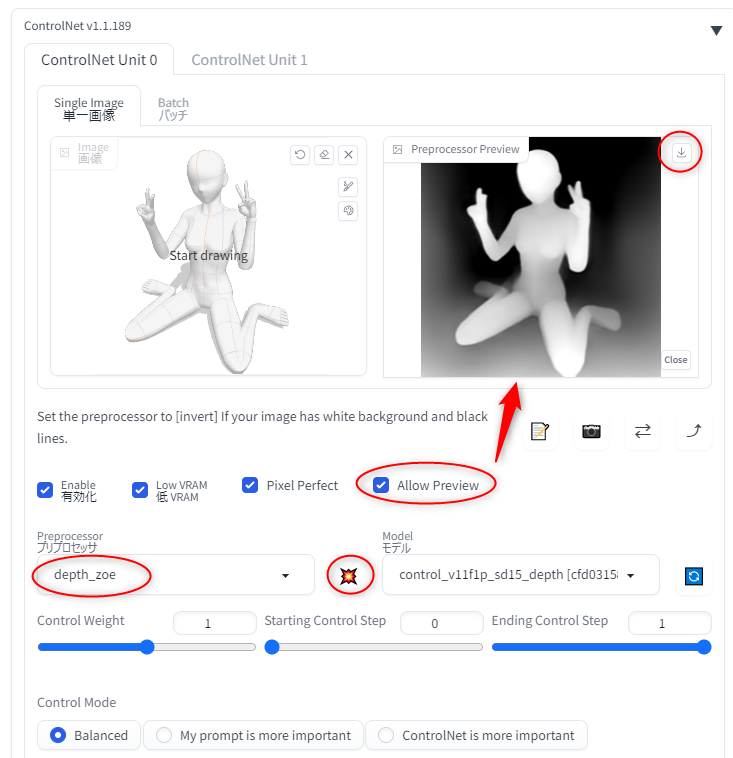

#1 [cg_tools] ControlNet+OpenPoseでちょっとハマった

画像生成AI Stable Diffusion web UI 上で、天地が逆になってるポーズの指定って本当にできないのかなと気になって、そのあたりを試してた。

OpenPose を使えば、棒人間? 棒人形? 相当を使ってポーズを指定できるはずなので…。Openpose Editor という拡張機能を使って、ポーズを作って、ControlNet に転送して、ということをやっていたのだけど…。生成画像にポーズが全く反映されなくて悩んでしまった。ControlNetを最新版にアップデート等々、アレコレやってみたけど改善されず。

何のことはない。ControlNet のプリプロセッサで、OpenPose関係を選んで指定するという、トホホなミスをしていた…。

プリプロセッサの OpenPose 云々は、写真やイラストから、OpenPose を抽出するために指定するものであって…。この場合、既に自分でOpenPose画像を用意しているのだから、プリプロセッサは「None」にして、モデルデータだけ OpenPose を選ばないといけなかった。

そんなわけで、OpenPose で指定したポーズが反映される状態にはなったのだけど…。予想通り、天地が逆になったポーズは、見た瞬間悲鳴を挙げたくなるような、とんでもない画像を生成してしまう…。そういったポーズの学習データが皆無なんだろう…。そりゃまあ、そうだよな。そんな奇天烈な構図/ポーズでわざわざ写真を撮る人なんて居るわけないし。写真がほぼ存在しないのだから、学習するはずもない。

学習していないものをAIは出せない、と再認識。

OpenPose を使えば、棒人間? 棒人形? 相当を使ってポーズを指定できるはずなので…。Openpose Editor という拡張機能を使って、ポーズを作って、ControlNet に転送して、ということをやっていたのだけど…。生成画像にポーズが全く反映されなくて悩んでしまった。ControlNetを最新版にアップデート等々、アレコレやってみたけど改善されず。

何のことはない。ControlNet のプリプロセッサで、OpenPose関係を選んで指定するという、トホホなミスをしていた…。

プリプロセッサの OpenPose 云々は、写真やイラストから、OpenPose を抽出するために指定するものであって…。この場合、既に自分でOpenPose画像を用意しているのだから、プリプロセッサは「None」にして、モデルデータだけ OpenPose を選ばないといけなかった。

そんなわけで、OpenPose で指定したポーズが反映される状態にはなったのだけど…。予想通り、天地が逆になったポーズは、見た瞬間悲鳴を挙げたくなるような、とんでもない画像を生成してしまう…。そういったポーズの学習データが皆無なんだろう…。そりゃまあ、そうだよな。そんな奇天烈な構図/ポーズでわざわざ写真を撮る人なんて居るわけないし。写真がほぼ存在しないのだから、学習するはずもない。

学習していないものをAIは出せない、と再認識。

[ ツッコむ ]

#2 [anime] 「劇場版 マジンガーZ / INFINITY」を視聴

BS12で放送されていたので視聴。ロボットアニメの名作、マジンガーZを、CGでリメイクしたアニメ映画。キャラは手描きで、マジンガーZ等の巨大ロボットを、おそらくはセルルックに近いCGで描写してる。

*1

今の時代に合わせて設定を作り込んでいる印象を受けた。それら設定の説明シーンが結構長くてちょっとアレだったけど、そういったお膳立て/下準備 が終わったら、いよいよ血沸き肉躍る戦闘シーンに突入、そしてそのままラストに、という構成なので、見た人の満足度は高かったのではないかなと想像できた。

CGで描かれたマジンガーZの映像はなかなかイイ感じ。この線密度を手描きで動かそうとしたら、手描きアニメーターさん達が次々と病院送りになるだろうなと…。CG万歳。

ただ、この手のCGによる戦闘シーンのあるあるだけど、何をやってるかさっぱり分らないカットも多々…。ギュンギュン動かして派手にはなるのだけど…。大まかな流れは止めず、しかし、「コイツラ、ここでこういうことやってますよ」と、その都度伝える演出上の手管が必要になると思うのだけど、そこらへんは今一つな印象を受けた。

プールの底が開いて発進するシーンや、ジェットスクランダーが発進するシーンは、もうちょっと何か付け加えてほしかった気もする。いやまあ、あえてオリジナル版の流れを踏襲して見せてるのだろうとは想像したのだけど、今の感覚でコンテを切ったら、もっと細かい、リアリティを感じさせる描写も多々入れられるよなと。もっとも、どこを変えるか、どこを変えないかの判断は難しいだろうし…。

光子力云々の設定は、聞いててなんだかもやもやした。もしかして、原子力を比喩していたつもりなんだろうか…。2017年〜2018年に公開されていた作品らしいので、東日本大震災のソレは取り入れた設定/脚本ではあるのだろうなと。ただ、ググってみたら、企画自体は2008年頃から始まっているとのことで…。途中で路線変更等があったのか、それとも元々こういう設定だったのか…。

何にせよ、CGのマジンガーZがガンガン動くだけで、個人的には満足。こんな映像を作れる時代になったんじゃのう…。眼福眼福。みたいな。

今の時代に合わせて設定を作り込んでいる印象を受けた。それら設定の説明シーンが結構長くてちょっとアレだったけど、そういったお膳立て/下準備 が終わったら、いよいよ血沸き肉躍る戦闘シーンに突入、そしてそのままラストに、という構成なので、見た人の満足度は高かったのではないかなと想像できた。

CGで描かれたマジンガーZの映像はなかなかイイ感じ。この線密度を手描きで動かそうとしたら、手描きアニメーターさん達が次々と病院送りになるだろうなと…。CG万歳。

ただ、この手のCGによる戦闘シーンのあるあるだけど、何をやってるかさっぱり分らないカットも多々…。ギュンギュン動かして派手にはなるのだけど…。大まかな流れは止めず、しかし、「コイツラ、ここでこういうことやってますよ」と、その都度伝える演出上の手管が必要になると思うのだけど、そこらへんは今一つな印象を受けた。

プールの底が開いて発進するシーンや、ジェットスクランダーが発進するシーンは、もうちょっと何か付け加えてほしかった気もする。いやまあ、あえてオリジナル版の流れを踏襲して見せてるのだろうとは想像したのだけど、今の感覚でコンテを切ったら、もっと細かい、リアリティを感じさせる描写も多々入れられるよなと。もっとも、どこを変えるか、どこを変えないかの判断は難しいだろうし…。

光子力云々の設定は、聞いててなんだかもやもやした。もしかして、原子力を比喩していたつもりなんだろうか…。2017年〜2018年に公開されていた作品らしいので、東日本大震災のソレは取り入れた設定/脚本ではあるのだろうなと。ただ、ググってみたら、企画自体は2008年頃から始まっているとのことで…。途中で路線変更等があったのか、それとも元々こういう設定だったのか…。

何にせよ、CGのマジンガーZがガンガン動くだけで、個人的には満足。こんな映像を作れる時代になったんじゃのう…。眼福眼福。みたいな。

*1: 完全なセルルックではなくて、光沢等をグラデーションで反映させてるスタイルに見えたけど…。ただ、輪郭線はあるので、一見するとセルルックに近い印象を受けた。

[ ツッコむ ]

2023/05/15(月) [n年前の日記]

#1 [cg_tools] OpenPoseについて少し調べてた

画像生成AI Stable Diffusion web UIでは、ControlNetという拡張機能とOpenPose画像を使うと、任意のポーズを指定できるけど、その OpenPose の各点が何と対応しているのか分からなくて少し調べてた。

以下のページが参考になった。

_ヨガポーズのクラス分類 - なるように、なる

_機械の目が見たセカイ -コンピュータビジョンがつくるミライ(47) 人物の姿勢推定(1)- OpenPose | TECH+ (テックプラス)

_OpenPose はどこまでの画像に耐えられるのか Pose Estimation の紹介 - Qiita

_Learn "Openpose" from scratch with MobileNetv2 + MS-COCO and deploy it to OpenVINO/TensorflowLite (Inference by OpenVINO/NCS2) Part.2 - Qiita

肩や首の点はなんとなく分かったけど、顔の点が分からなかったわけで…。鼻が1つ、目が2つ、耳が2つ、だったのだな…。ただ、それぞれ、鼻や目の中央を示しているのか、それとも各パーツの上端や先端なのか、そのあたりがまだ分からない。

以下のページが参考になった。

_ヨガポーズのクラス分類 - なるように、なる

_機械の目が見たセカイ -コンピュータビジョンがつくるミライ(47) 人物の姿勢推定(1)- OpenPose | TECH+ (テックプラス)

_OpenPose はどこまでの画像に耐えられるのか Pose Estimation の紹介 - Qiita

_Learn "Openpose" from scratch with MobileNetv2 + MS-COCO and deploy it to OpenVINO/TensorflowLite (Inference by OpenVINO/NCS2) Part.2 - Qiita

肩や首の点はなんとなく分かったけど、顔の点が分からなかったわけで…。鼻が1つ、目が2つ、耳が2つ、だったのだな…。ただ、それぞれ、鼻や目の中央を示しているのか、それとも各パーツの上端や先端なのか、そのあたりがまだ分からない。

[ ツッコむ ]

2023/05/16(火) [n年前の日記]

#1 [cg_tools] 学習モデルデータの特徴を調べ直してた

画像生成AI Stable Diffusion web UIの学習モデルデータについて、それぞれ特徴を調べ直してた。ググってるうちに目に入って良さそうだなと思ったら即ダウンロードしてたけど、どのデータがどういう属性なのか忘れてしまって…。アニメ系なのか実写系なのかすら忘れてしまったりして…。

ファイル名を頼りに、以下のページを参考にしつつ、Evernote に種類を書き込んでおいた、とメモ。

_リアル系モデル比較・雑感 - NovelAI 5ch Wiki

_モデルについて - としあきdiffusion Wiki*

_【Stable Diffusion】イラスト生成AIのモデル一覧。どれがお好み?

_【2023年版】Stable Diffusion モデルまとめ | BLOG CAKE

_StableDiffusionのおすすめ最新モデルを紹介 | アニメ調イラストのクオリティを劇的に向上させるカスタムモデル | Murasan Lab

_【Stable Diffusion】美少女イラスト生成におすすめのモデルデータまとめ30選+α【実写(フォトリアル) 2.5D アニメイラスト】 | 悠々ログ

_StableDiffusion実写リアル系モデルおすすめ12選|川瀬ゆうえんち

_StableDiffushionモデル25種類×5枚ずつで比較メモ|川瀬ゆうえんち

_AOM3系のモデル比較 - 動かざることバグの如し

_画像生成ai【Stable Diffusion web ui】 モデルまとめ - BLOGWORK by Wis-Labo

_#StableDiffusion で 実写風女性画像生成に適したモデル3選 と モデルのマージ #ControlNet による姿勢の指定に便利な openpose-editor | Digital Life Innovator

_AIグラビア画像 違う顔 の作り方Stable Diffusion - ぶいろぐ

ファイル名を頼りに、以下のページを参考にしつつ、Evernote に種類を書き込んでおいた、とメモ。

_リアル系モデル比較・雑感 - NovelAI 5ch Wiki

_モデルについて - としあきdiffusion Wiki*

_【Stable Diffusion】イラスト生成AIのモデル一覧。どれがお好み?

_【2023年版】Stable Diffusion モデルまとめ | BLOG CAKE

_StableDiffusionのおすすめ最新モデルを紹介 | アニメ調イラストのクオリティを劇的に向上させるカスタムモデル | Murasan Lab

_【Stable Diffusion】美少女イラスト生成におすすめのモデルデータまとめ30選+α【実写(フォトリアル) 2.5D アニメイラスト】 | 悠々ログ

_StableDiffusion実写リアル系モデルおすすめ12選|川瀬ゆうえんち

_StableDiffushionモデル25種類×5枚ずつで比較メモ|川瀬ゆうえんち

_AOM3系のモデル比較 - 動かざることバグの如し

_画像生成ai【Stable Diffusion web ui】 モデルまとめ - BLOGWORK by Wis-Labo

_#StableDiffusion で 実写風女性画像生成に適したモデル3選 と モデルのマージ #ControlNet による姿勢の指定に便利な openpose-editor | Digital Life Innovator

_AIグラビア画像 違う顔 の作り方Stable Diffusion - ぶいろぐ

[ ツッコむ ]

#2 [nitijyou] 親父さんのスマホに地図アプリをインストールしておいた

親父さんが喜多方のほうまで写真撮影に行っていたらしいのだけど、カーナビの示す道が現状と合ってなくて、道に迷って困った、と愚痴っていたので、親父さんのAndroidスマホに Google Map と Yahoo! Map をインストールして、最低限の使い方を説明しておいた、とメモ。親父さんの車のカーナビよりは、スマホアプリのほうが、まだ多少は新しい地図データを見れるんじゃないのかなと…。目的地の入力も、スマホなら音声入力が使えるから多少は楽だろうし。

もっとも、親父さんのことだから、それらアプリをインストールしたことを、3日後にはすっかり忘れてそうな気もする…。というか、自分もそのうち忘れそう。一応こうしてメモしておくことで、自分の記憶に多少は残ってくれることを期待…。

もっとも、親父さんのことだから、それらアプリをインストールしたことを、3日後にはすっかり忘れてそうな気もする…。というか、自分もそのうち忘れそう。一応こうしてメモしておくことで、自分の記憶に多少は残ってくれることを期待…。

[ ツッコむ ]

2023/05/17(水) [n年前の日記]

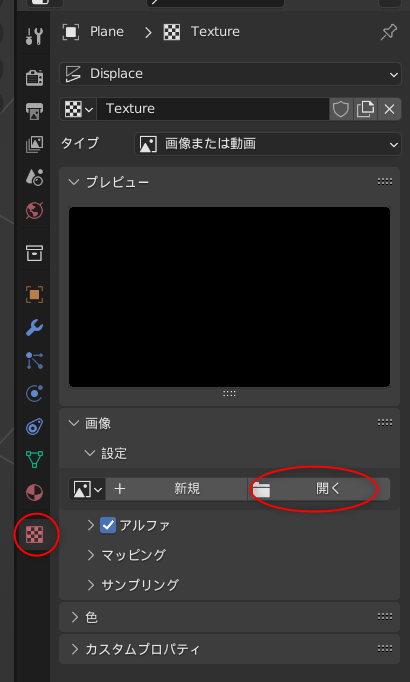

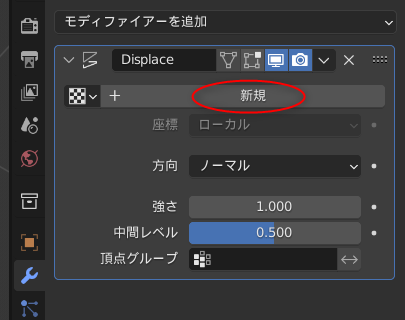

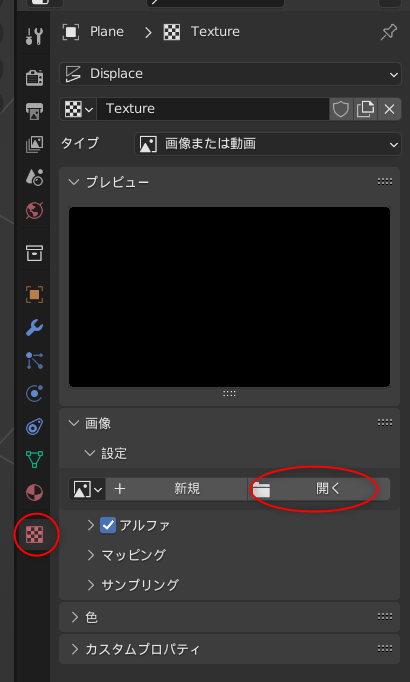

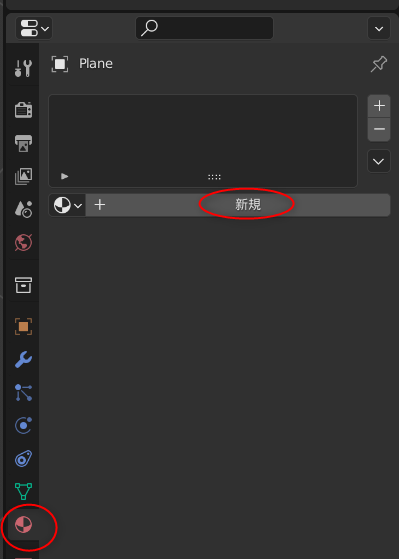

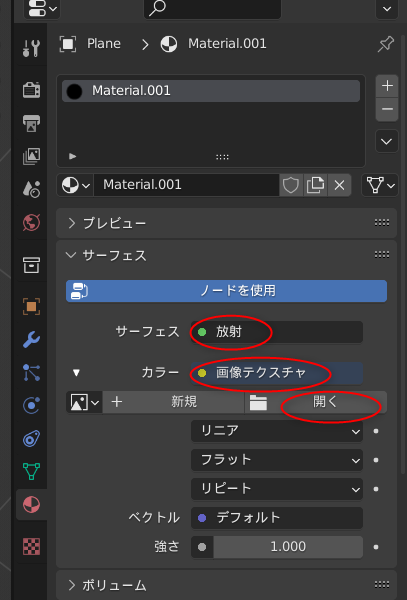

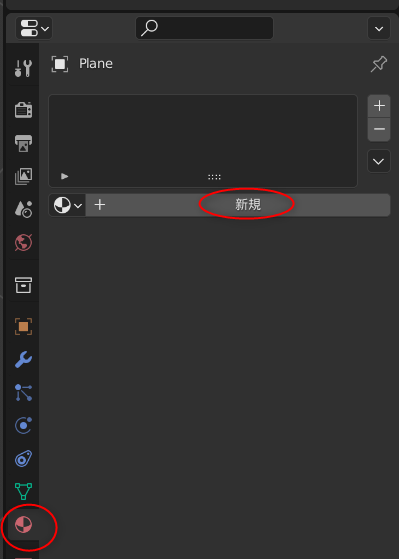

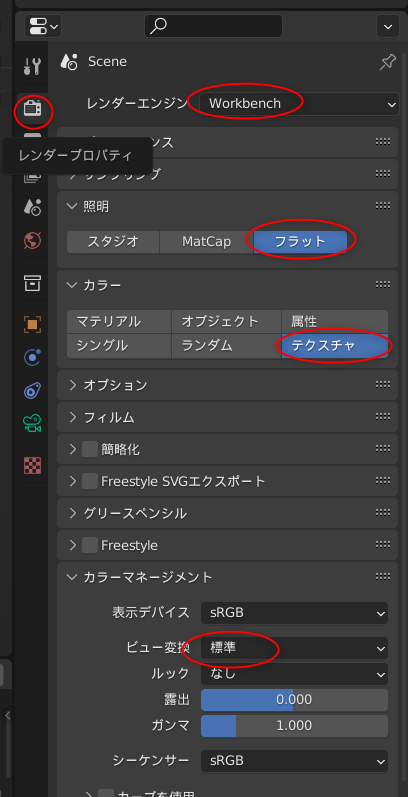

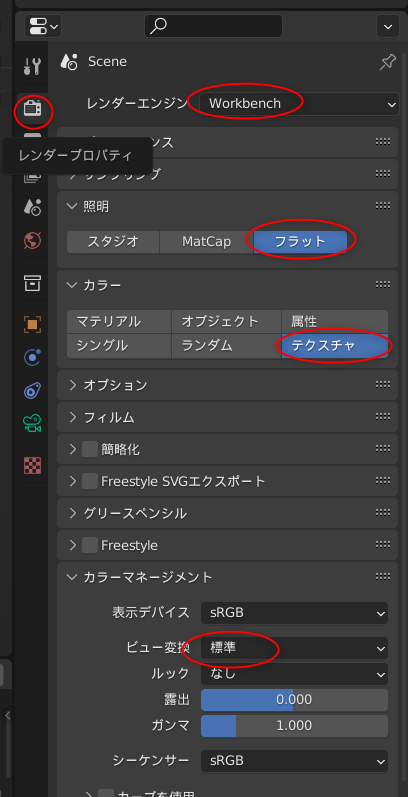

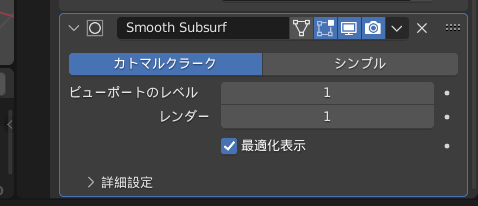

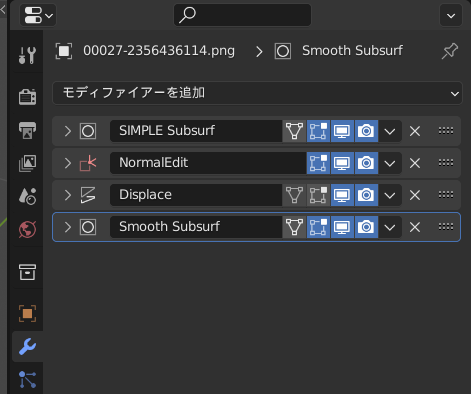

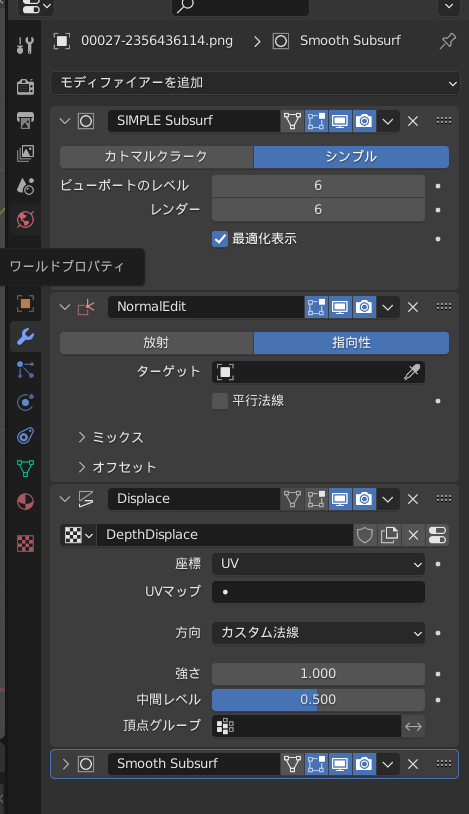

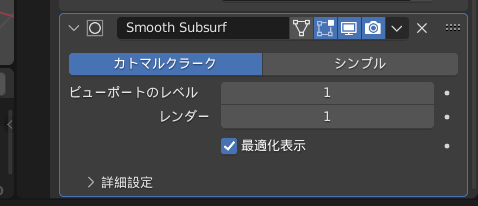

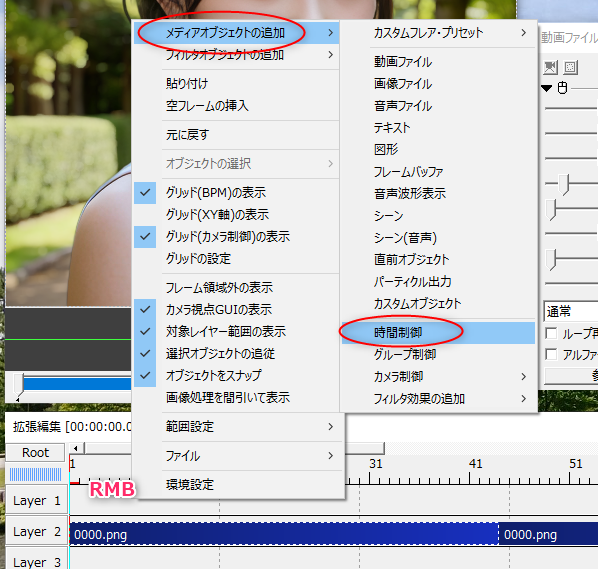

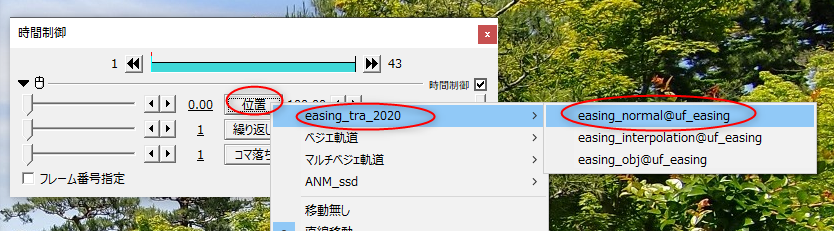

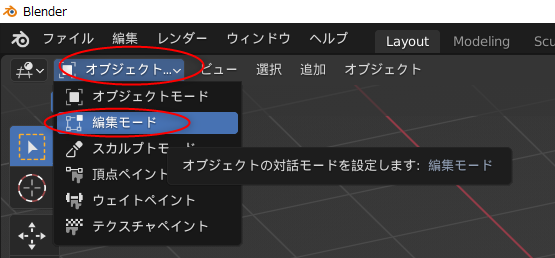

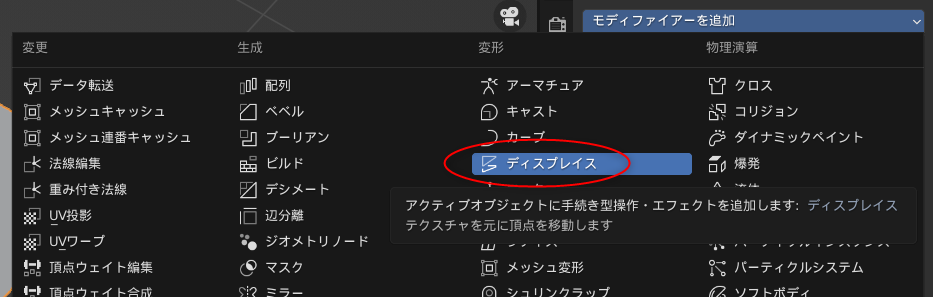

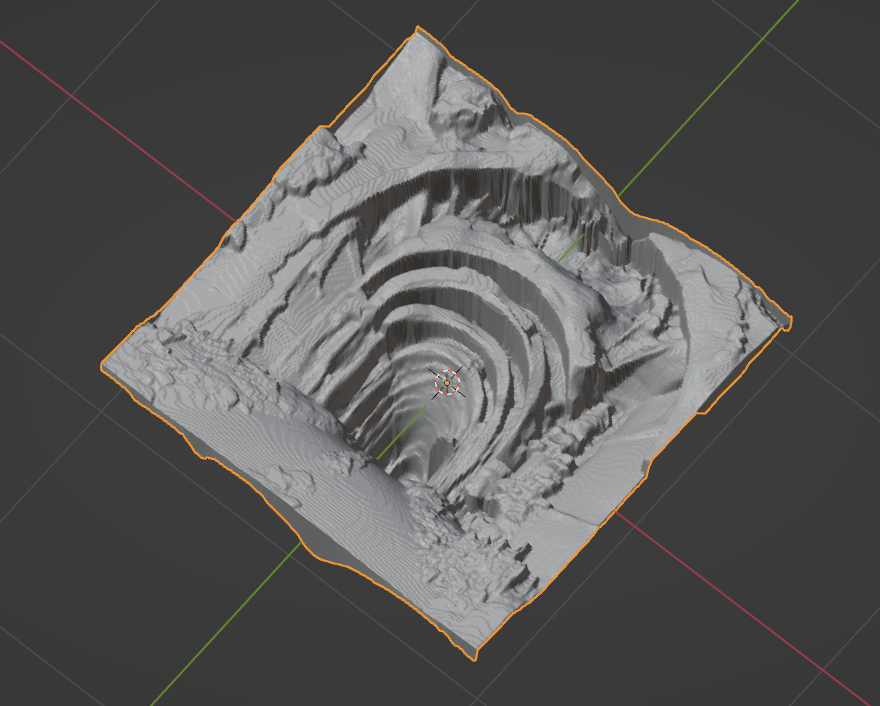

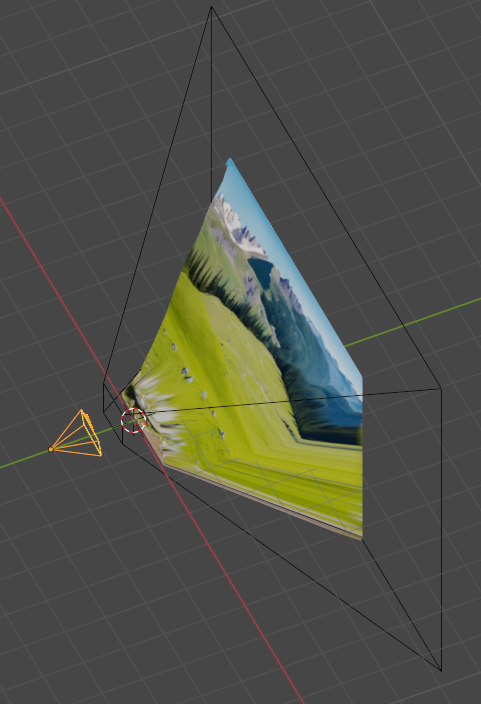

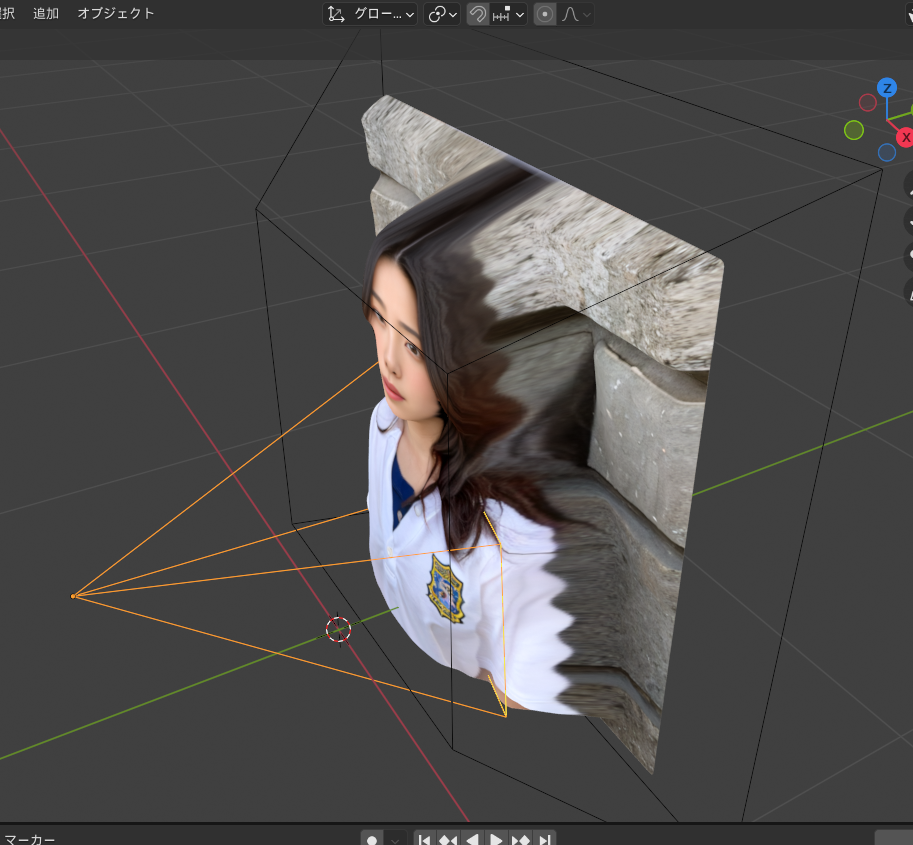

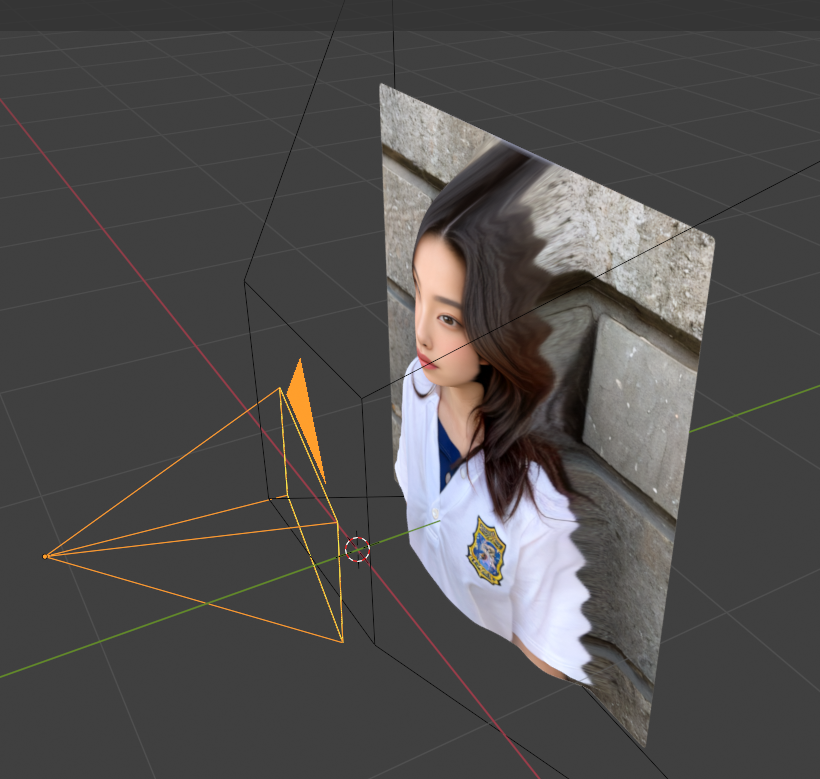

#1 [cg_tools][blender] blenderでOpenPoseのアニメーションを作ってみたい

無料で利用できる3DCGソフト、blender を使って、OpenPose のアニメーションを作成できないものかなと思いついた。そういうことができれば、画像生成AIに、その OpenPose動画を渡して、動画を生成できるんじゃないのかなと。

ググってみたら、挑戦してる方々が居るらしい。

_ControlNetで使うカラフル棒人間を簡単に作れる Blenderアドオン 導入&使用方法紹介 - 7mm blog

_Blender+ControlNetを用いたアニメーションの作り方

_Blenderで好きなポーズつけてControlNetで出力させる|rockreef|pixivFANBOX

_toyxyz - ControlNet M2M Brief Workflow ... / Twitter

_Stable Diffusion WebUIのControlNetのm2mでショート動画を作ってみた | 鷹の目週末プログラマー

自分も少し試してみたい。環境は、Windows10 x64 22H2。CPU は AMD Ryzen 5 5600X。GPU は NVIDIA GeForce GTX 1060 6GB。

ググってみたら、挑戦してる方々が居るらしい。

_ControlNetで使うカラフル棒人間を簡単に作れる Blenderアドオン 導入&使用方法紹介 - 7mm blog

_Blender+ControlNetを用いたアニメーションの作り方

_Blenderで好きなポーズつけてControlNetで出力させる|rockreef|pixivFANBOX

_toyxyz - ControlNet M2M Brief Workflow ... / Twitter

_Stable Diffusion WebUIのControlNetのm2mでショート動画を作ってみた | 鷹の目週末プログラマー

自分も少し試してみたい。環境は、Windows10 x64 22H2。CPU は AMD Ryzen 5 5600X。GPU は NVIDIA GeForce GTX 1060 6GB。

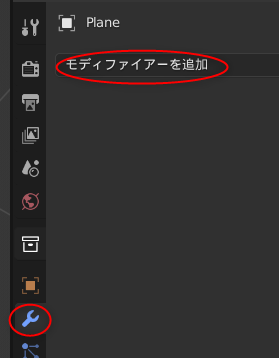

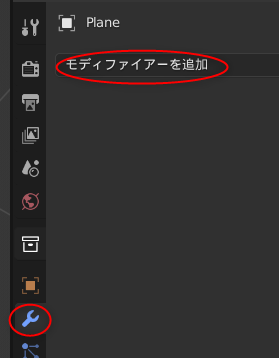

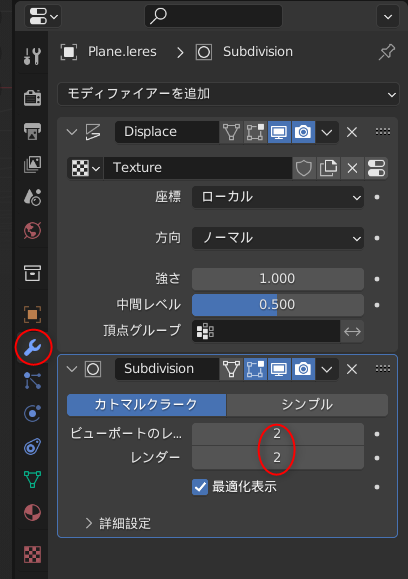

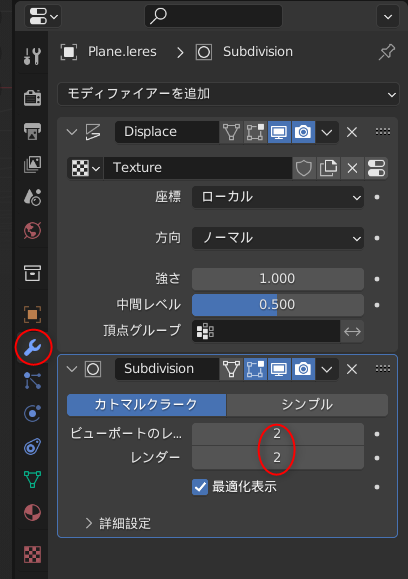

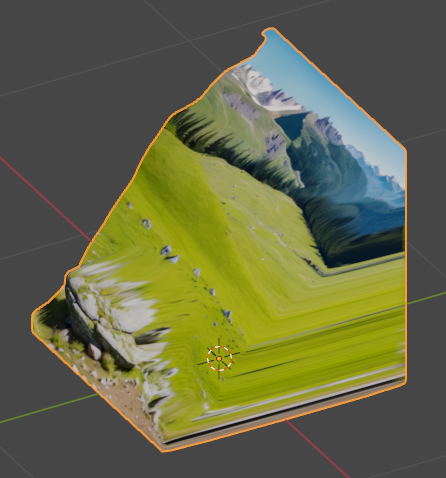

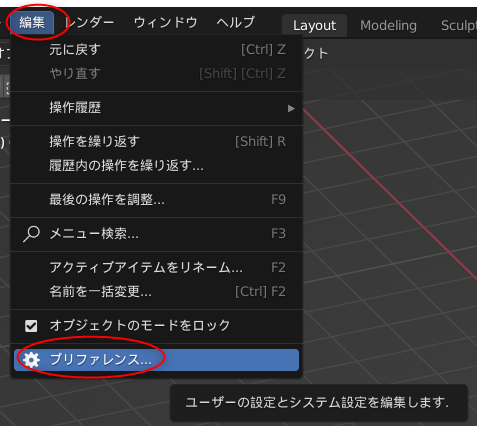

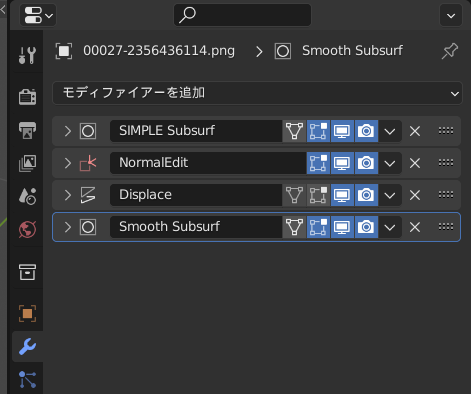

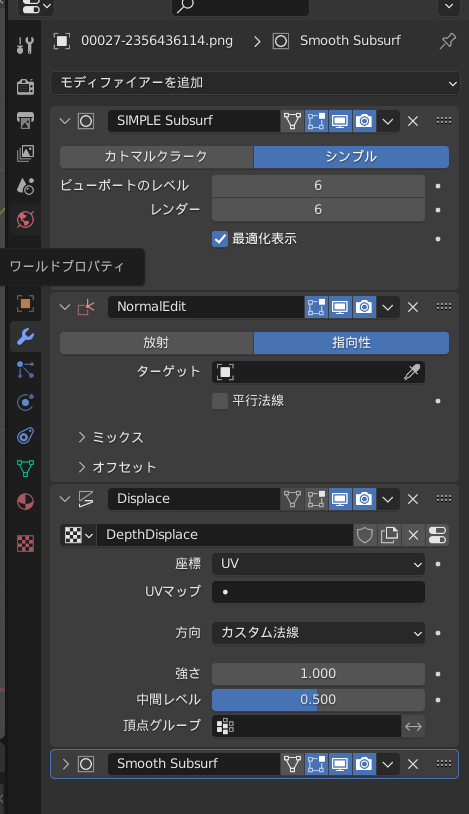

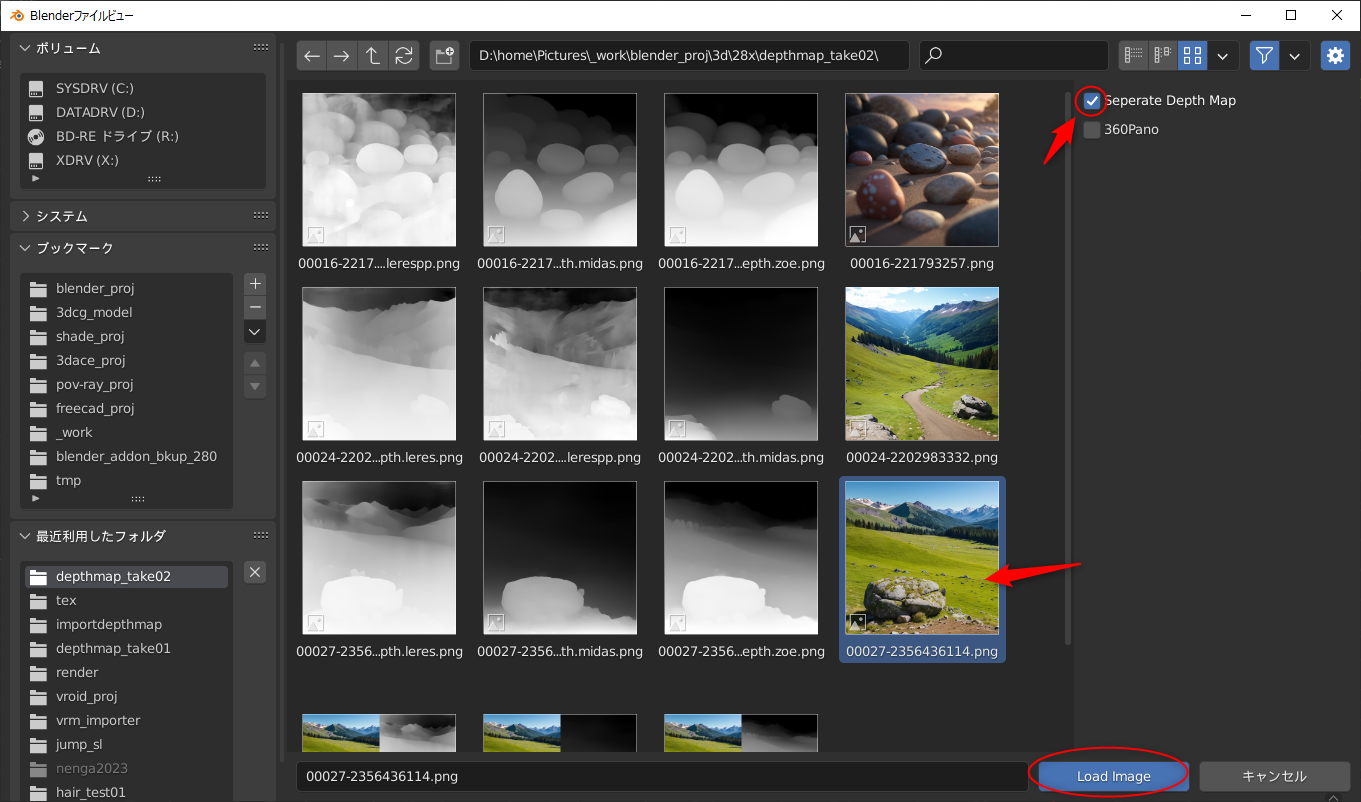

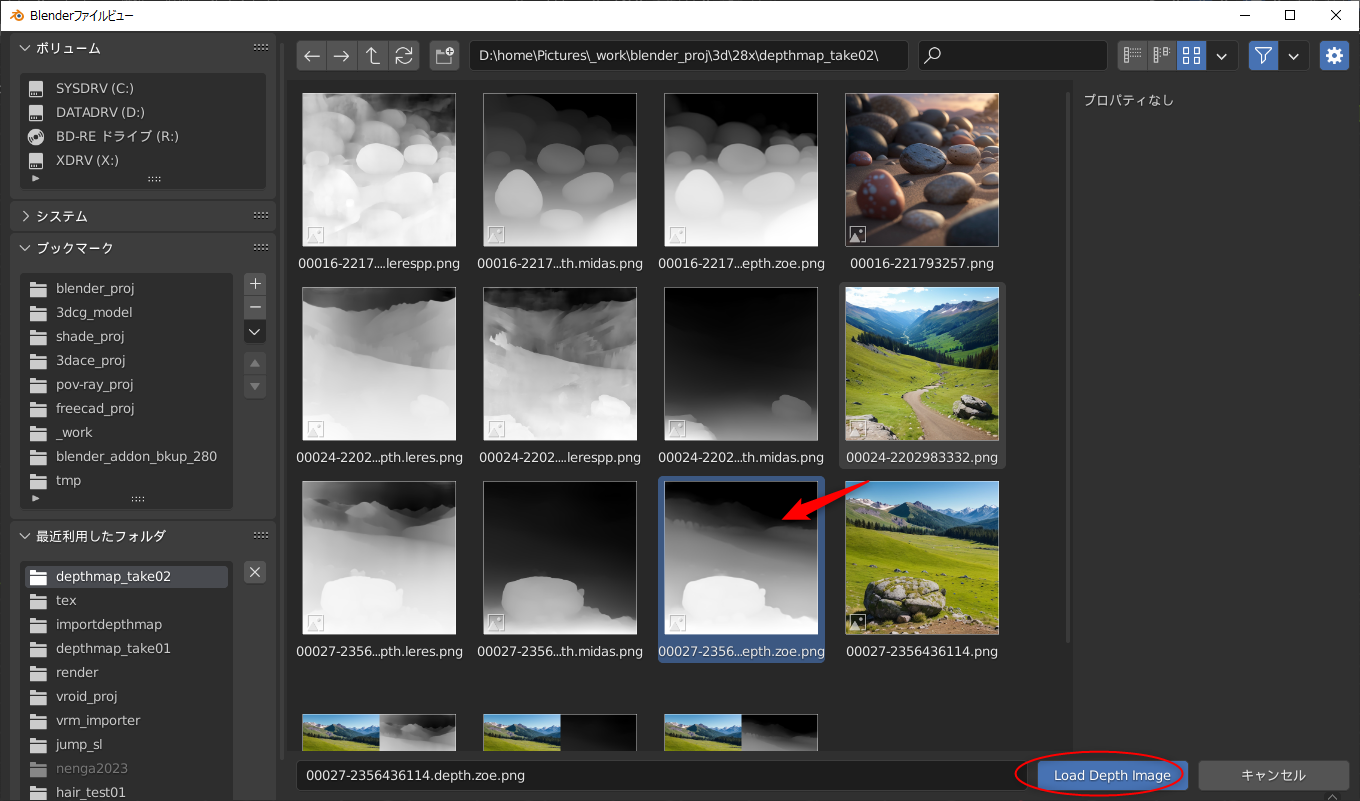

◎ モデルデータとアドオンを入手 :

以下のページから、こういった作業をするためのモデルデータとアドオンを入手できる模様。入手にはメールアドレスの入力が必要。

_Character bones that look like Openpose for blender _ Ver_9 Depth+Canny+Landmark+MediaPipeFace+finger

0を入力すれば無料でDLできるけど、支援したい方は好きな代金を入力して寄付してほしい、とのこと。

ダウンロードページには、過去バージョンから現行バージョンまで並んでいたけれど、今回は現行バージョンらしい OpenPoseBones_v9.zip というファイルをDLしてみた。

ちなみに、「Blender 3.5 以上じゃないと動かないよ」と書かれていたので…。blender 3.5.1 x64 (blender-3.5.1-windows-x64.zip) を入手して、任意のフォルダに解凍して、blender.exe を実行して、動かせるようにしておいた。できれば blender LTS版で動くバージョンが欲しかった…。自分、手元の環境に、LTS版しかインストールしてなかったので…。

OpenPoseBones_v9.zip を解凍すると、中には2つのファイルが入っている。

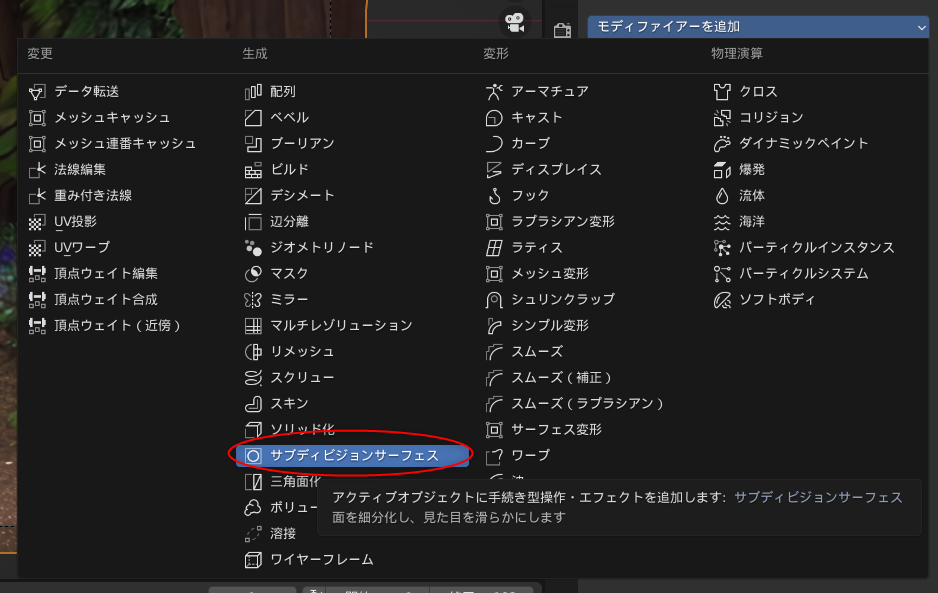

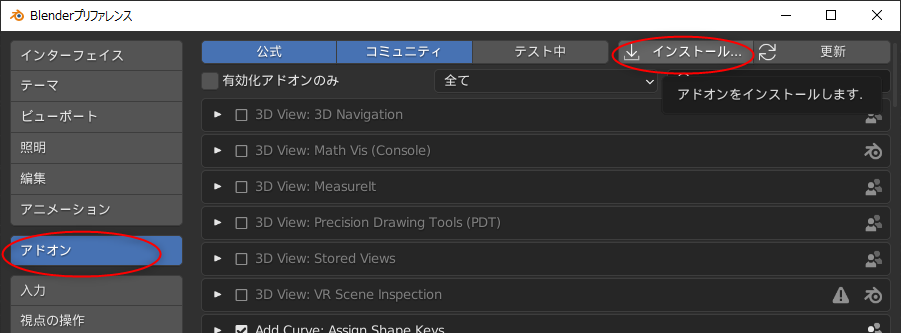

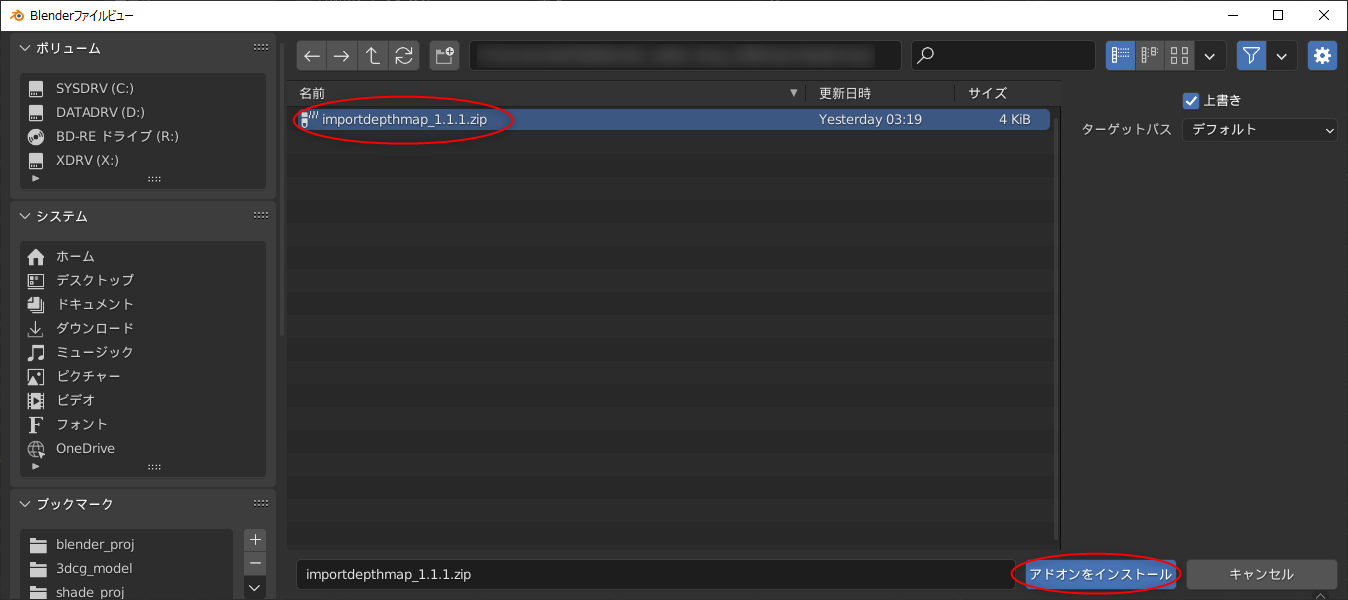

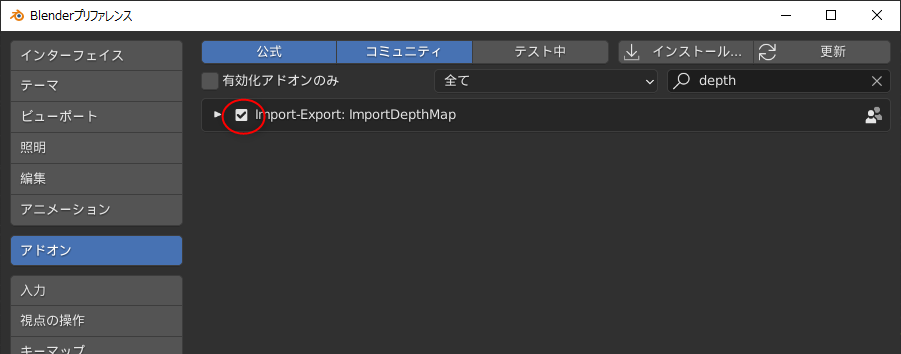

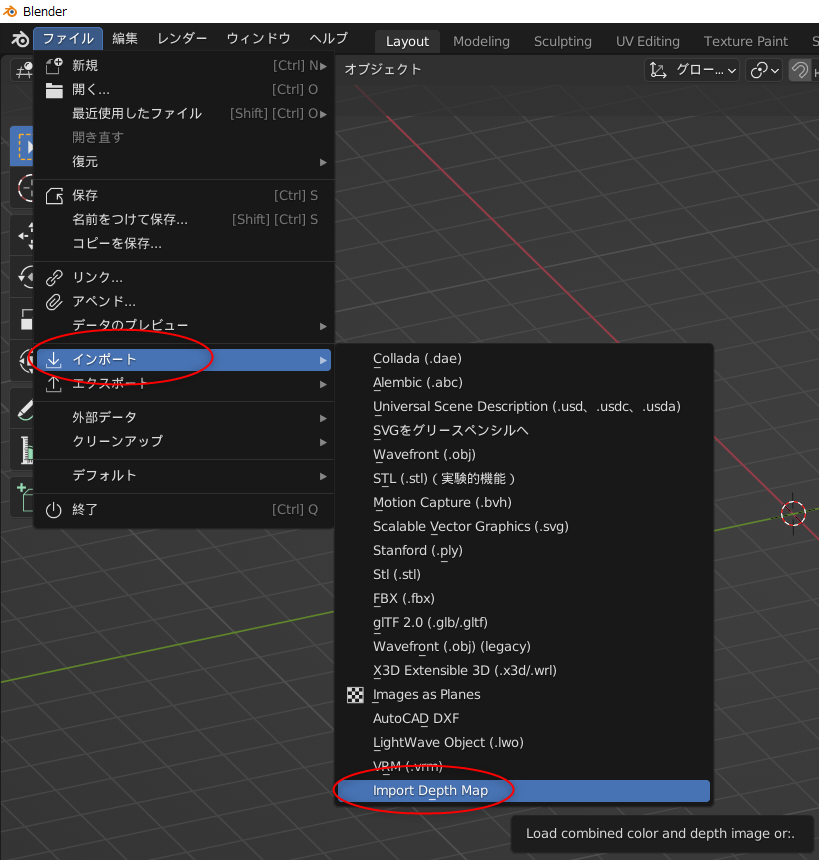

blender 3.5.1 x64 を起動して、設定画面を開いて、rig_tools_3.68.12.zip をアドオンとしてインストール。

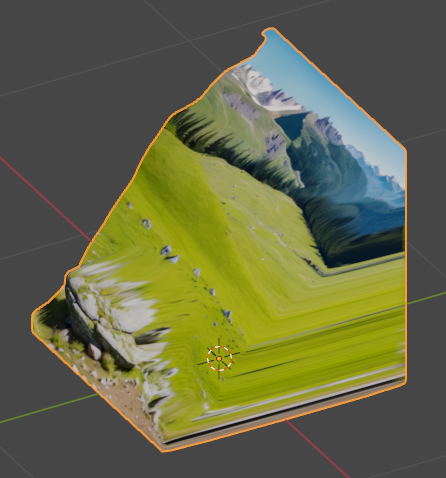

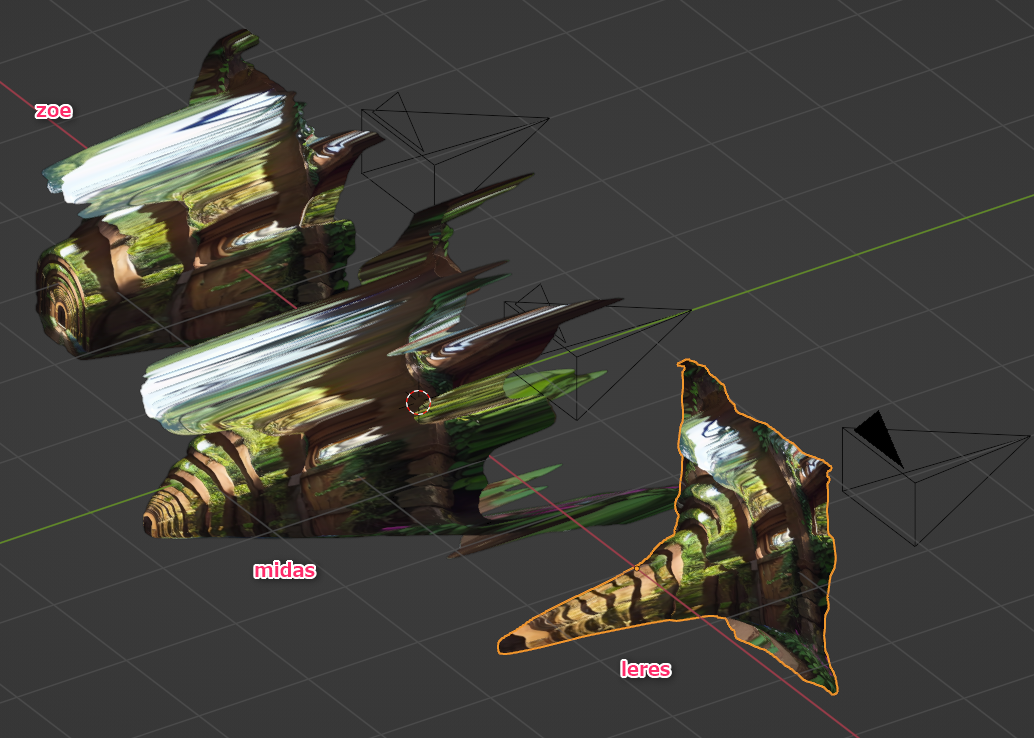

その後、Openpose_bones_ver_09.blend を開くと、ザ・OpenPose って感じのモデルデータが現れる。

これを別名保存して、作業をしていく。

_Character bones that look like Openpose for blender _ Ver_9 Depth+Canny+Landmark+MediaPipeFace+finger

0を入力すれば無料でDLできるけど、支援したい方は好きな代金を入力して寄付してほしい、とのこと。

ダウンロードページには、過去バージョンから現行バージョンまで並んでいたけれど、今回は現行バージョンらしい OpenPoseBones_v9.zip というファイルをDLしてみた。

ちなみに、「Blender 3.5 以上じゃないと動かないよ」と書かれていたので…。blender 3.5.1 x64 (blender-3.5.1-windows-x64.zip) を入手して、任意のフォルダに解凍して、blender.exe を実行して、動かせるようにしておいた。できれば blender LTS版で動くバージョンが欲しかった…。自分、手元の環境に、LTS版しかインストールしてなかったので…。

OpenPoseBones_v9.zip を解凍すると、中には2つのファイルが入っている。

- Openpose_bones_ver_09.blend : OpenPoseの見た目を再現してるモデルデータ。

- rig_tools_3.68.12.zip : OpenPoseモデルデータをリグで動かすためのアドオン。

blender 3.5.1 x64 を起動して、設定画面を開いて、rig_tools_3.68.12.zip をアドオンとしてインストール。

その後、Openpose_bones_ver_09.blend を開くと、ザ・OpenPose って感じのモデルデータが現れる。

これを別名保存して、作業をしていく。

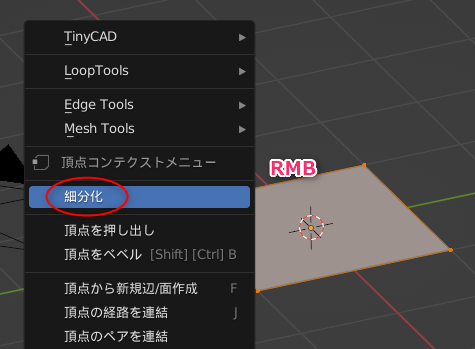

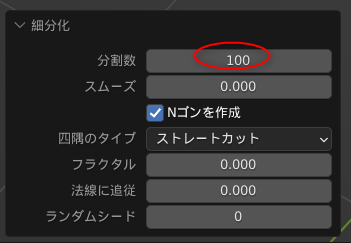

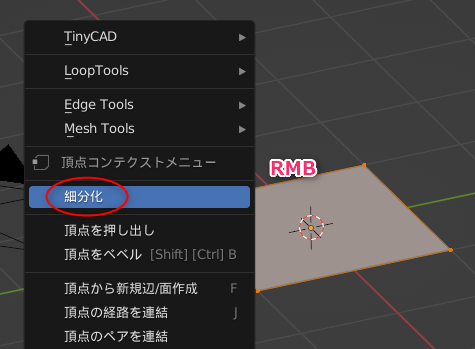

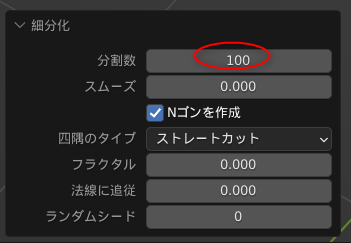

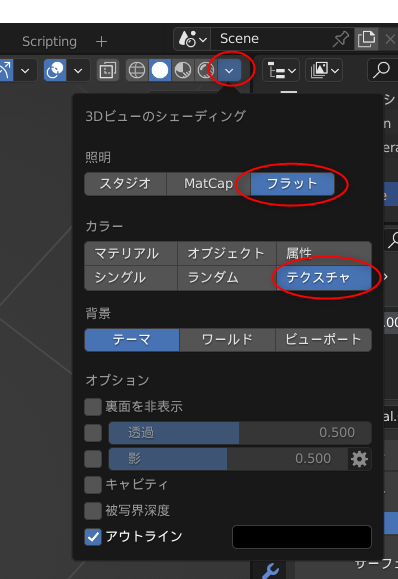

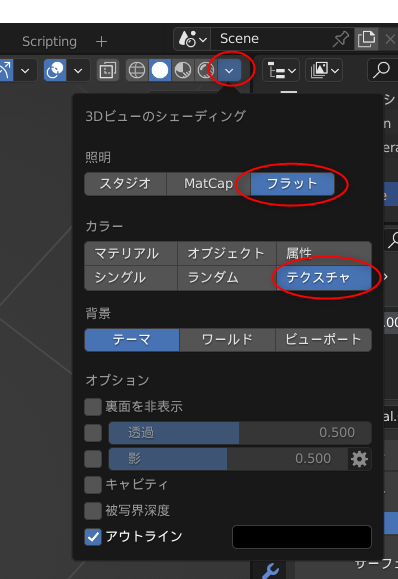

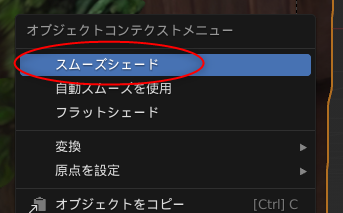

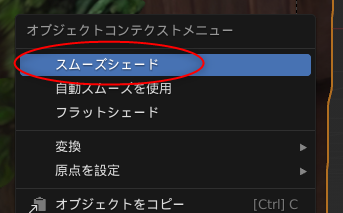

◎ ポーズをつけてみる :

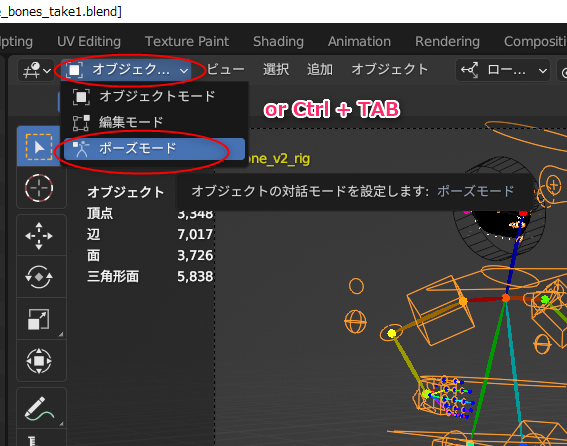

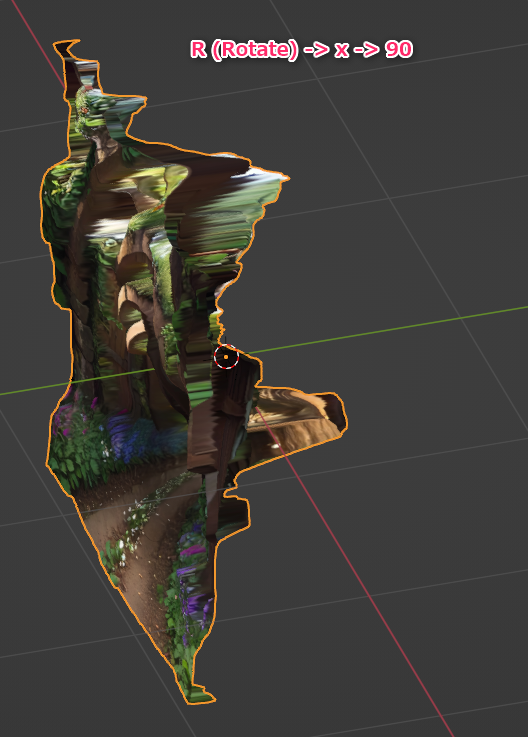

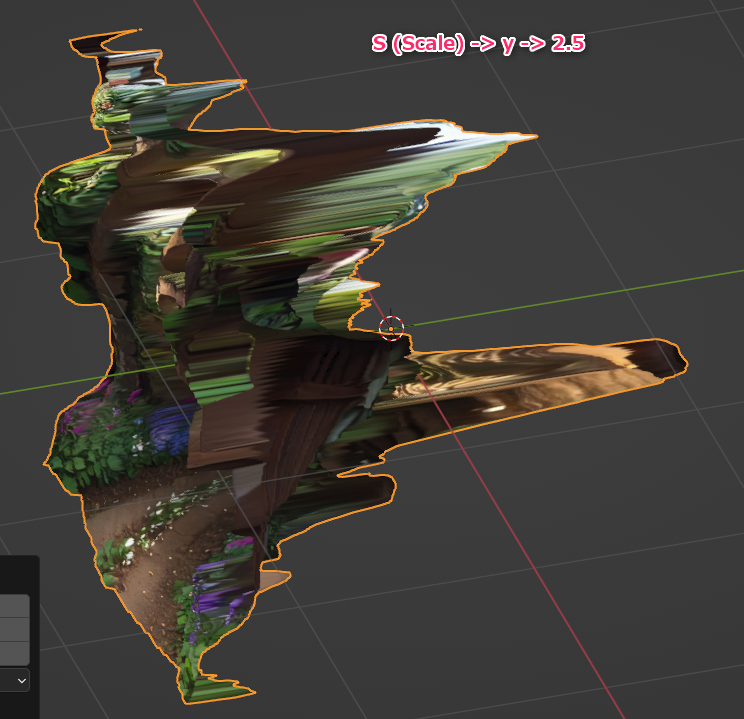

OpenPoseモデルを左クリックして選択してから、ポーズモードに切り替える。ウインドウ左上の選択メニューから選んでもいいし、Ctrl + TABキーを押して切り替えてもいい。

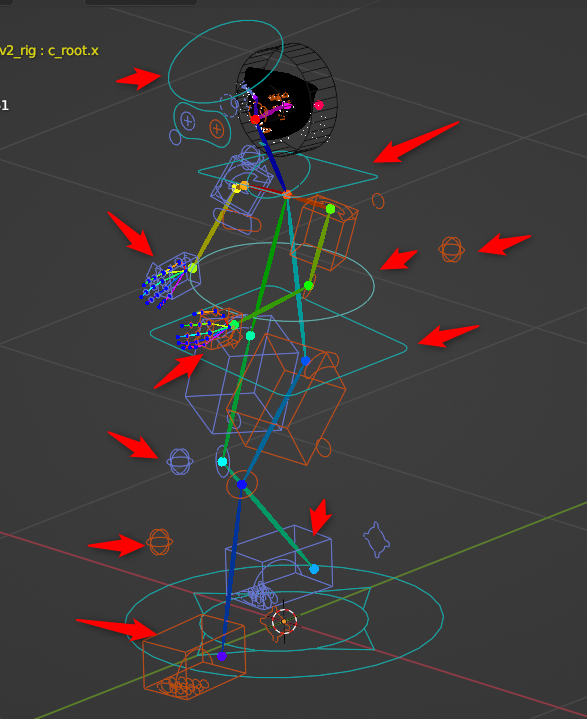

関節をクリックしても回転させることができなくて、どうやってポーズをつけていけばいいのか分らなくてちょっと悩んだけれど。どうやら既にIKが指定してあって、手足の先の箱や、腰や頭の周りにある輪っかを左クリックで選択してから、移動したり回転させたりすることで、ポーズをつけていけるようだと分かった。

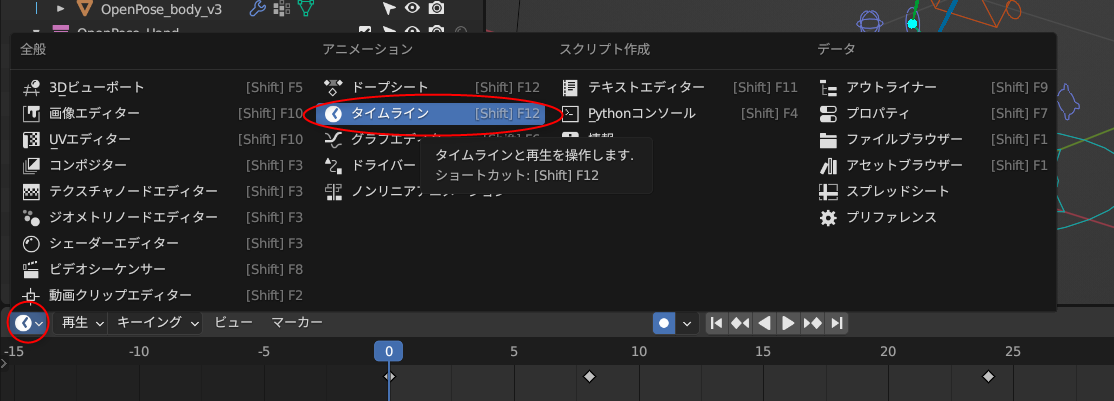

アニメーションにしたいので、画面の下のほうのウインドウを、タイムラインにする。各ウインドウの、左上隅のアイコンをクリックすれば、ウインドウの種類を変更できる。

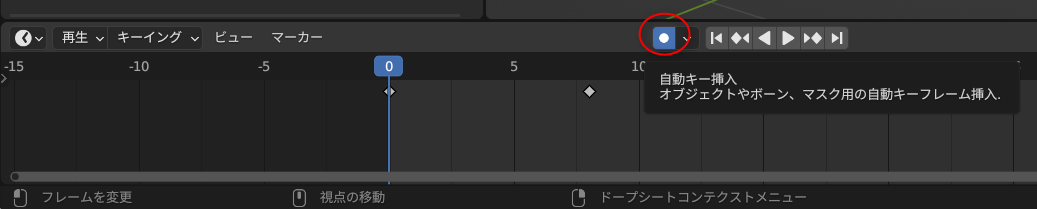

タイムラインウインドウの真ん中あたりにある丸アイコンをクリックして有効にすれば、自動キー挿入が有効になって、ポーズを変更する度に、自動でキーフレームを挿入/上書きしてくれる。

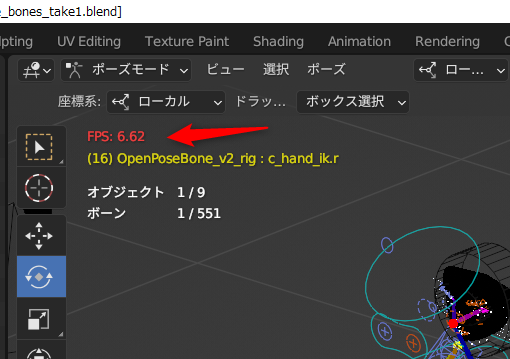

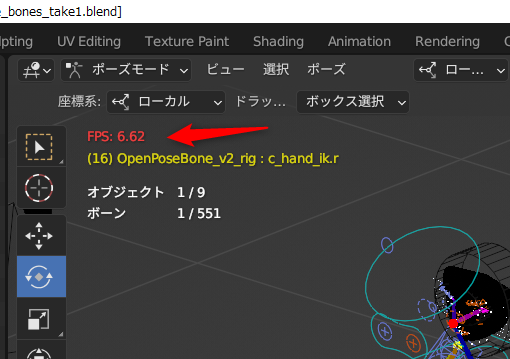

そんな感じで、8FPSを前提にして、アニメーションをつけてみたのだけど…。試しにプレビュー再生してみたら、左上に出ている表示FPSが…。

8FPSで設定してあるのに、6FPSしか出てない…。blender、重い…。これではどんなアニメになったのか、よく分からない…。いや、自分の環境が非力なのかもしれんけど。AMD Ryzen 5 5600X + NVIDIA GeForce GTX 1060 ではこんなものなのか…。

でもまあ、ワイヤーフレーム表示にしたら8FPSが出てくれたので、どうにかなりそう。

何にせよ、アニメーションをプレビュー再生する時は、左上に出ている表示FPSをチェックして、本来のFPSが出てるのかどうか気にしながら作業していきたい。

関節をクリックしても回転させることができなくて、どうやってポーズをつけていけばいいのか分らなくてちょっと悩んだけれど。どうやら既にIKが指定してあって、手足の先の箱や、腰や頭の周りにある輪っかを左クリックで選択してから、移動したり回転させたりすることで、ポーズをつけていけるようだと分かった。

アニメーションにしたいので、画面の下のほうのウインドウを、タイムラインにする。各ウインドウの、左上隅のアイコンをクリックすれば、ウインドウの種類を変更できる。

タイムラインウインドウの真ん中あたりにある丸アイコンをクリックして有効にすれば、自動キー挿入が有効になって、ポーズを変更する度に、自動でキーフレームを挿入/上書きしてくれる。

そんな感じで、8FPSを前提にして、アニメーションをつけてみたのだけど…。試しにプレビュー再生してみたら、左上に出ている表示FPSが…。

8FPSで設定してあるのに、6FPSしか出てない…。blender、重い…。これではどんなアニメになったのか、よく分からない…。いや、自分の環境が非力なのかもしれんけど。AMD Ryzen 5 5600X + NVIDIA GeForce GTX 1060 ではこんなものなのか…。

でもまあ、ワイヤーフレーム表示にしたら8FPSが出てくれたので、どうにかなりそう。

何にせよ、アニメーションをプレビュー再生する時は、左上に出ている表示FPSをチェックして、本来のFPSが出てるのかどうか気にしながら作業していきたい。

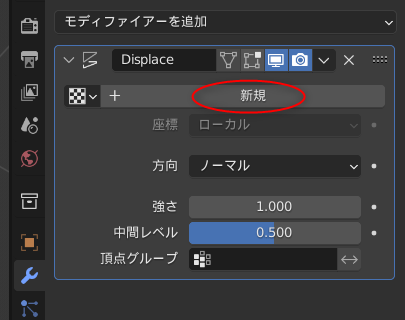

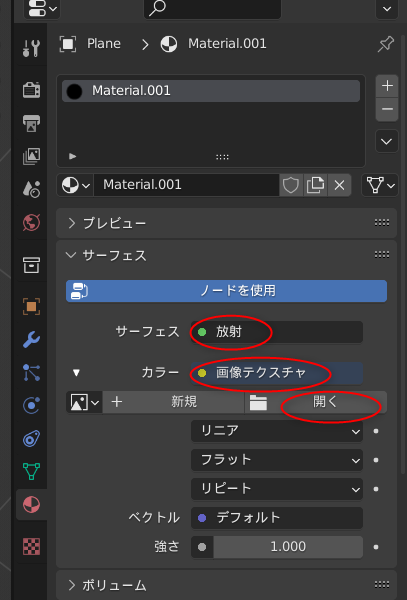

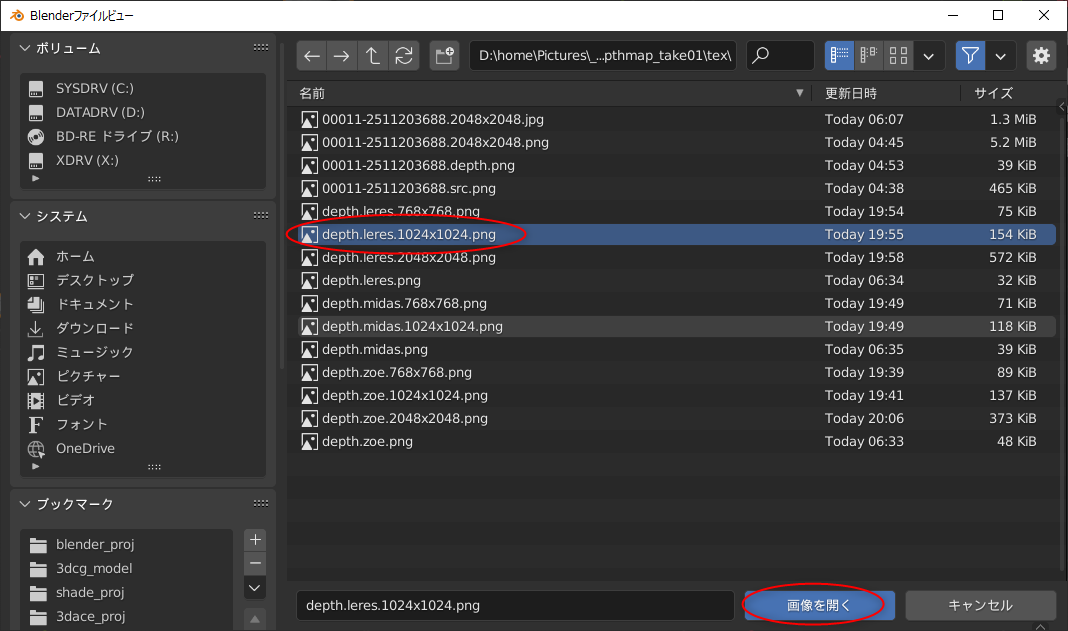

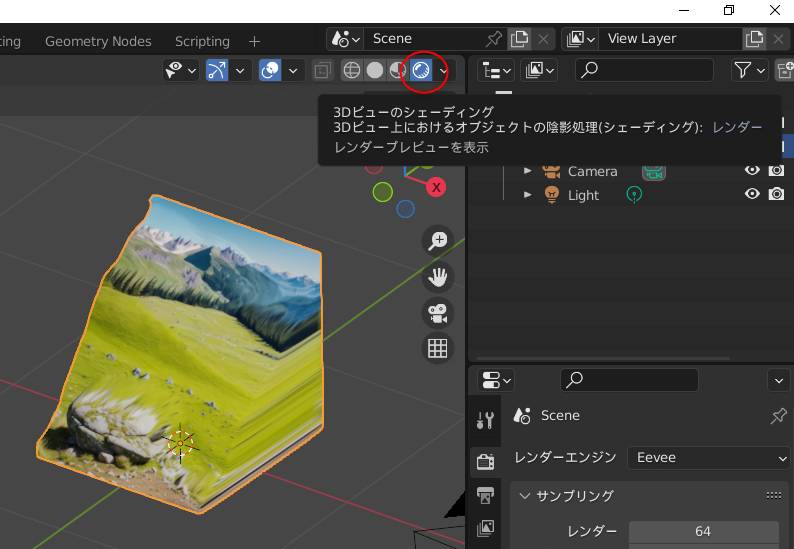

◎ レンダリングしてみる :

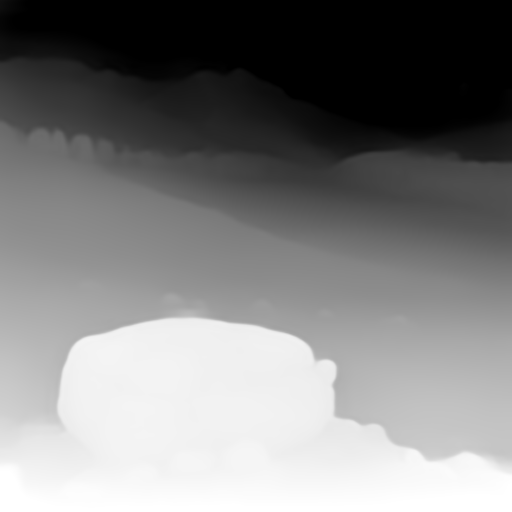

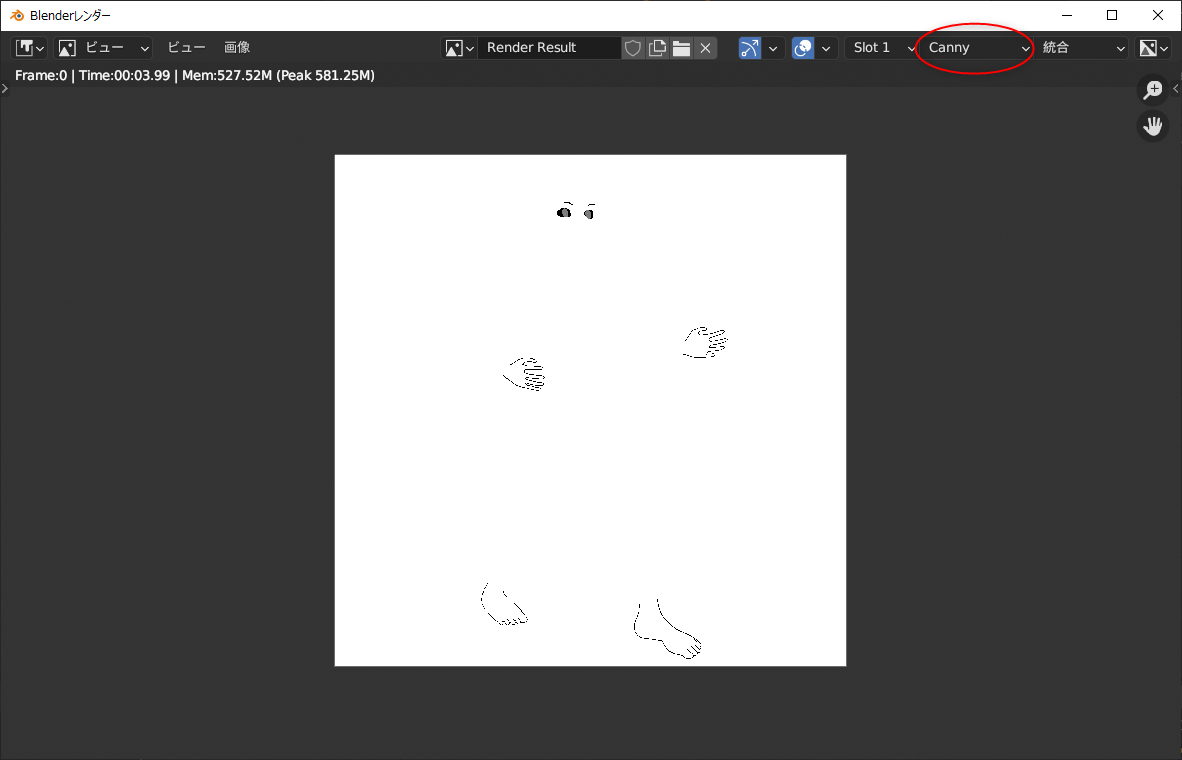

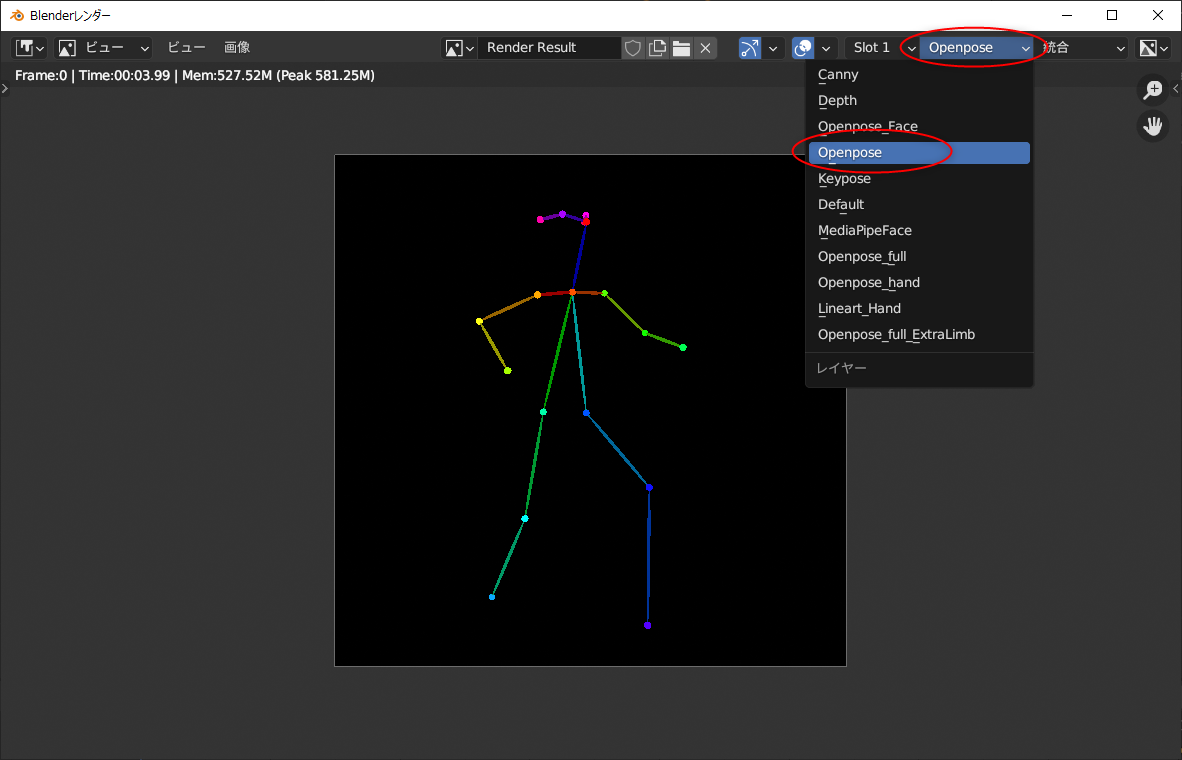

F12キーを押して、レンダリングしてみる。

なんだか変な画像がレンダリングされた…。ナニコレ…。

右上のほうで、出力画像の種類を選ぶことができるらしい。最初に出ていたのは canny 用で、OpenPose を見たかったら、種類を選べ直せばいい。

これらのレンダリング画像は、.blend ファイルの保存場所に、MultiControlnet というフォルダが作られて、その中に種類別フォルダも作成されて、それら各フォルダ内に画像が保存されていく模様。

ちなみに、MultiControlnet\ フォルダの中には、以下のフォルダが作られていた。

つまり、OpenPose画像が欲しかったら、MultiControlnet 内の openposeフォルダの中を探せばいい。

なんだか変な画像がレンダリングされた…。ナニコレ…。

右上のほうで、出力画像の種類を選ぶことができるらしい。最初に出ていたのは canny 用で、OpenPose を見たかったら、種類を選べ直せばいい。

これらのレンダリング画像は、.blend ファイルの保存場所に、MultiControlnet というフォルダが作られて、その中に種類別フォルダも作成されて、それら各フォルダ内に画像が保存されていく模様。

ちなみに、MultiControlnet\ フォルダの中には、以下のフォルダが作られていた。

canny depth keypose Lineart MediaPipe_face openpose openpose_face openpose_full openpose_full_Extra_Limb openpose_hand

つまり、OpenPose画像が欲しかったら、MultiControlnet 内の openposeフォルダの中を探せばいい。

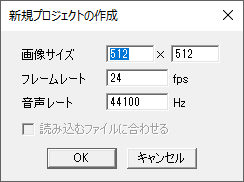

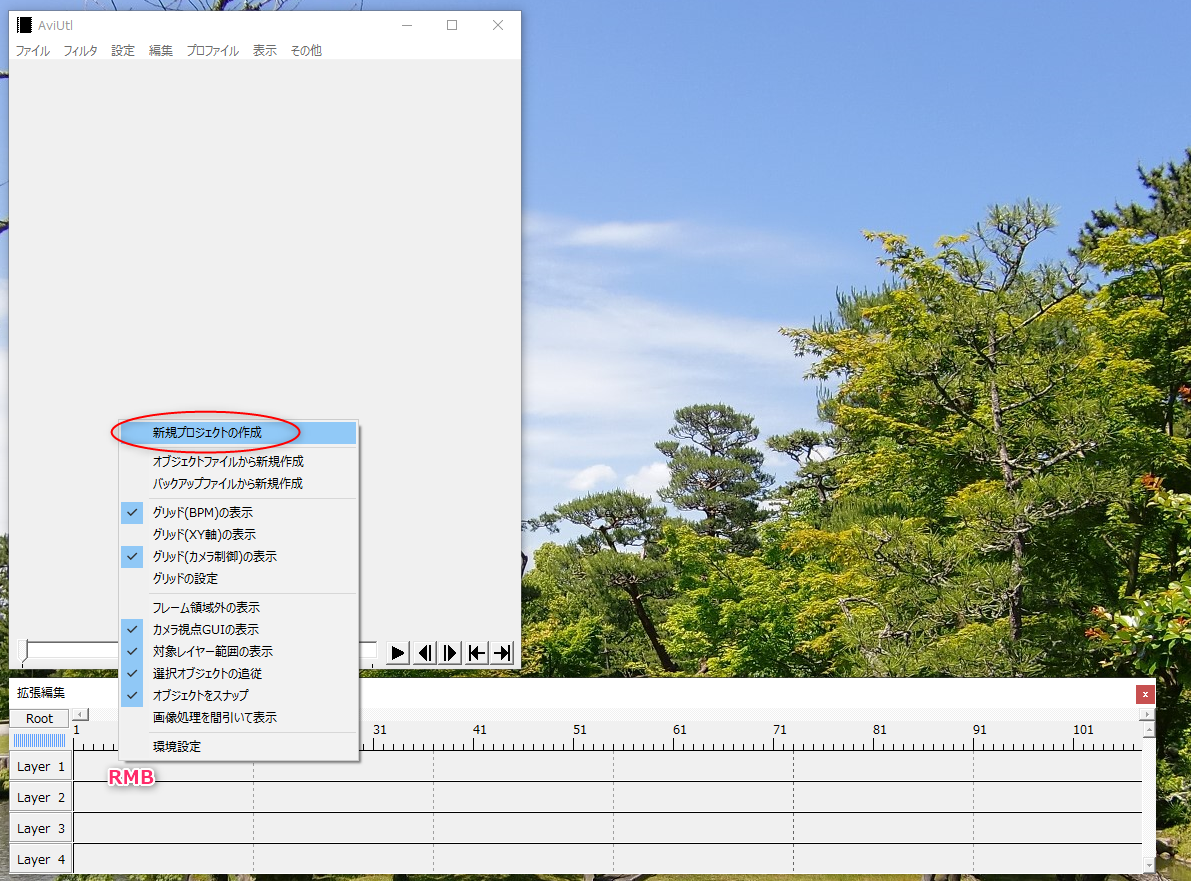

◎ 動画でレンダリングしてみる :

blender の上のほうのメニューの中から、レンダリング → アニメーション、を選んで、動画をレンダリングしてみる。

.blend の保存場所に、canny用の連番画像が大量に生成されてしまった…。これは…要らないなあ…。

一応、MultiControlnet\openpose\ 以下に、OpenPoseの連番画像も出力された。これを使って動画を作ればいいか…。

ffmpeg を利用して、連番画像から動画を生成する。

8fps、40フレームのmp4動画が得られた。

.blend の保存場所に、canny用の連番画像が大量に生成されてしまった…。これは…要らないなあ…。

一応、MultiControlnet\openpose\ 以下に、OpenPoseの連番画像も出力された。これを使って動画を作ればいいか…。

ffmpeg を利用して、連番画像から動画を生成する。

ffmpeg -framerate 8 -i MultiControlnet\openpose\Image%04d.png -vcodec libx264 -pix_fmt yuv420p -r 8 out_openpose.mp4 -y

- -framerate 8 : 入力する連番画像のフレームレートを指定。ここでは 8FPS を指定している。

- -i hoge%04d.png : hoge0000.png - hogeXXXX.png を入力画像として渡す。%04d と書けば、0000 - 9999 まで対応できる。

- -vcodec libx264 -pix_fmt yuv420p : Webブラウザでも再生できるmp4動画を指定。

- -r 8 : 出力動画のフレームレートを指定。8FPSにしている。

- out_openpose.mp4 : 出力ファイル名。

- -y : 既に出力ファイルが存在していたら上書きする。

8fps、40フレームのmp4動画が得られた。

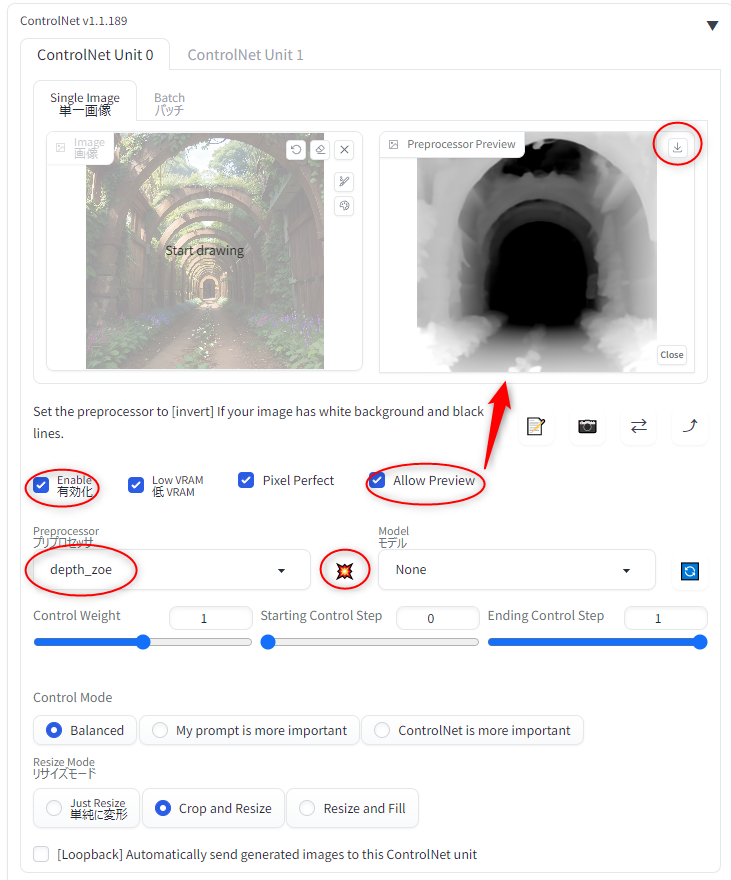

◎ Stable Diffusion web UIに渡してみる :

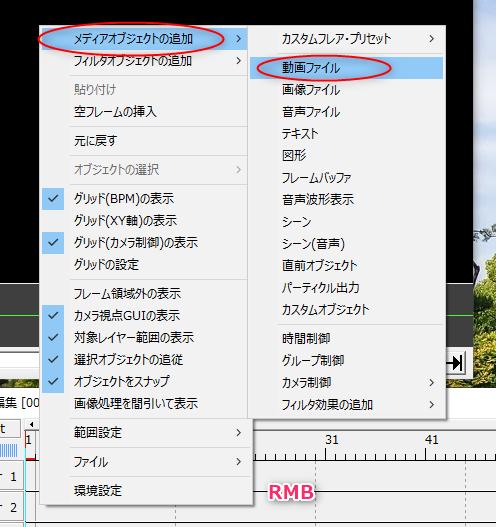

得られた OpenPose動画を、画像生成AI Stable Diffusion web UIに渡して、動画を生成してみたい。

ControlNet には、ControlNet m2m というスクリプトが付属している。このスクリプトを選んで動画を渡してやれば、動画の1フレームを取り出して、ControlNet に転送して、画像生成して ―― これを動画の全フレーム分繰り返してくれる。

ただ、Stable Diffusion web UIの設定画面 → ControlNet で、スクリプトからの操作を許可しておかないといけない。この設定が必要なことを知らなくて、実行してみたら「ControlNetに画像が指定されてないぞ」とエラーが出て悩んでしまった。

設定については以下が参考になった。ありがたや。

_【ControlNet m2m】動画を直接Aiに渡す!【Stable Diffusion】 | 謎の技術研究部

_ControlNet - としあきdiffusion Wiki*

"Allow other script to control this extension" にチェックを入れておくらしい。

他に、ググって分かったことをメモ。

そんな感じで、txt2img で試してみたのだけど…。1枚生成するのに58秒 = 約1分。それが40フレームあるので、フツーに40分ぐらいかかった。

生成された画像は、以下の場所に保存されていた。

そんなわけで、連番画像からmp4動画を生成してみたけれど…。

うーん。予想通りではあるけれど、各フレームの連続性というか、一貫性が皆無…。元のOpenPose動画の動きがビミョーすぎて、こういう実験に不向きなせいもありそうだけど、現状ではまだまだ色々と厳しいものがあるなと…。

それはそれとして、これを書いてる段階でトホホなミスをしていることに気が付いた。

アニメを作りたいなら、24コマ/秒で3コマベース、8fpsでOpenPose動画を作っておけばいいのかなと安易に思って作業してしまったけれど。だったら最後に、アニメ系と言うか、手描きに見える学習モデルデータを使って画像生成しないと…。実写系の学習モデルデータ、ChilloutMix系で生成しちゃダメじゃん…。実写系の画像を、ジャパニメーションのリミテッドアニメ風フレームレートで動かすとか、自分、何をやってるんだか…。

ControlNet には、ControlNet m2m というスクリプトが付属している。このスクリプトを選んで動画を渡してやれば、動画の1フレームを取り出して、ControlNet に転送して、画像生成して ―― これを動画の全フレーム分繰り返してくれる。

ただ、Stable Diffusion web UIの設定画面 → ControlNet で、スクリプトからの操作を許可しておかないといけない。この設定が必要なことを知らなくて、実行してみたら「ControlNetに画像が指定されてないぞ」とエラーが出て悩んでしまった。

設定については以下が参考になった。ありがたや。

_【ControlNet m2m】動画を直接Aiに渡す!【Stable Diffusion】 | 謎の技術研究部

_ControlNet - としあきdiffusion Wiki*

"Allow other script to control this extension" にチェックを入れておくらしい。

他に、ググって分かったことをメモ。

- txt2img, img2img のどちらでも、ControlNet m2m を使って動画を作れる。

- img2imgで出力したほうが背景が崩れにくい、らしい。

- 出力する時は、seed を固定して、似た画像が出やすい状態にする。

- プロンプトにも、服装や背景等、固定しやすくなるワードを多々打ち込んでおく。

- ControlNet m2m を使う時は、ControlNet の画像指定欄は空欄にしておく。そこは m2m から各フレームが入力されるので。

- ControlNet m2m の Duration という設定項目は、1フレームあたりの表示時間をミリ秒で指定する。らしい。8fpsなら125ms。12fpsなら83〜84ms。24fpsなら41〜42ms。おそらくアニメgifを生成する際に使われる値ではなかろうか。

- ControlNet の Control Weight は大き目の数値にしておくといいらしい。1.6とか。

そんな感じで、txt2img で試してみたのだけど…。1枚生成するのに58秒 = 約1分。それが40フレームあるので、フツーに40分ぐらいかかった。

生成された画像は、以下の場所に保存されていた。

- outputs\txt2img-images\日付\ : いつもの保存場所。

- outputs\txt2img-images\controlnet-m2m\ : アニメgifファイルが保存されている。

- outputs\txt2img-images\tmp\ : 生成画像が連番画像として保存されていた。もしかするとアニメgifを作るための仮保存場所…?

そんなわけで、連番画像からmp4動画を生成してみたけれど…。

うーん。予想通りではあるけれど、各フレームの連続性というか、一貫性が皆無…。元のOpenPose動画の動きがビミョーすぎて、こういう実験に不向きなせいもありそうだけど、現状ではまだまだ色々と厳しいものがあるなと…。

それはそれとして、これを書いてる段階でトホホなミスをしていることに気が付いた。

アニメを作りたいなら、24コマ/秒で3コマベース、8fpsでOpenPose動画を作っておけばいいのかなと安易に思って作業してしまったけれど。だったら最後に、アニメ系と言うか、手描きに見える学習モデルデータを使って画像生成しないと…。実写系の学習モデルデータ、ChilloutMix系で生成しちゃダメじゃん…。実写系の画像を、ジャパニメーションのリミテッドアニメ風フレームレートで動かすとか、自分、何をやってるんだか…。

◎ 2023/05/18追記 :

せっかくだから、アニメ系の学習モデルデータ、MeinaMix を使って試してみた。更に今回は、txt2imgではなくて、img2imgで生成してみた。

うーん。これは…どうなんだ…。まあ、色々と厳しいのは間違いない…。

うーん。これは…どうなんだ…。まあ、色々と厳しいのは間違いない…。

[ ツッコむ ]

2023/05/18(木) [n年前の日記]

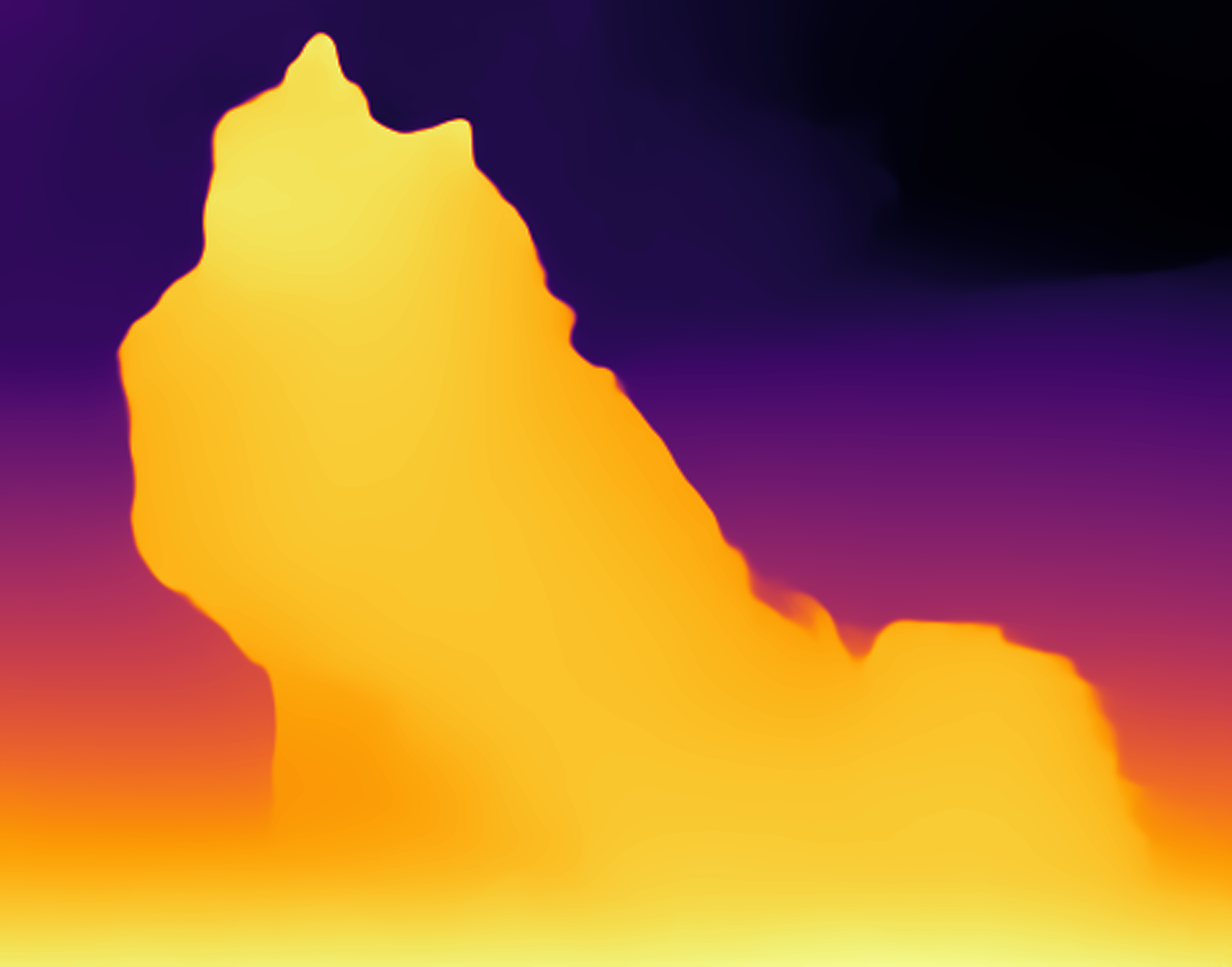

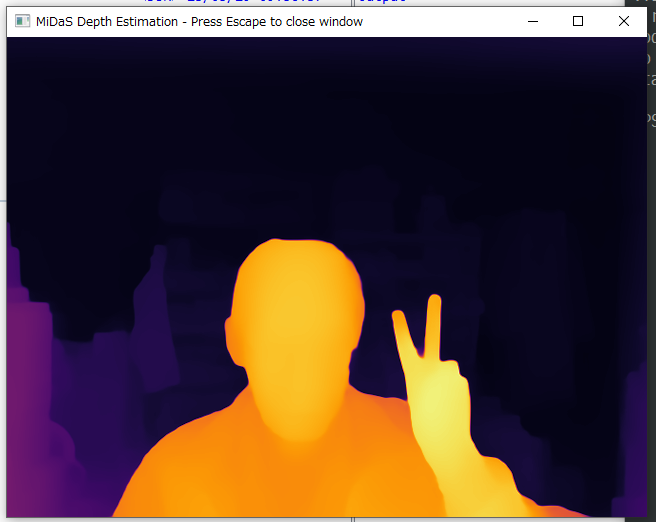

#1 [cg_tools] OpenPose動画を作りたい

blenderを使ってOpenPose動画を作成する手順は分かったけれど、手作業でポーズを指定してアニメーションを作らないといけないあたりが面倒臭い。既存の動画を分析してOpenPose動画を生成することはできないものだろうか。というか、本来のOpenPoseって、現実に存在する人体の動きを解析して作るものだろうし…。

そんなわけで、OpenPose動画を生成するためのツールがあるのかどうかググってみた。

環境は、Windows10 x64 22H2。CPU : AMD Ryzen 5 5600X。GPU : NVIDIA GeForce GTX 1060 6GB。

以下のページが参考になりそう。ありがたや。

_OpenPoseを使って手っ取り早く姿勢推定をしてみる(Windows10) | 技術的特異点

_OpenPose による姿勢推定(Windows 上)

_OpenPose 1.7.0 のインストール,デモの実行(Windows 上)

_OpenPose の使い方 - nomlab

_Advent Calendar | 濱川研究室Webページ

_OpenPoseの使い方メモ - .com-pound

よく分からんけど、OpenPoseDemo.exe なるものを動かせば OpenPose画像/動画が得られるようだなと…。

そんなわけで、OpenPose動画を生成するためのツールがあるのかどうかググってみた。

環境は、Windows10 x64 22H2。CPU : AMD Ryzen 5 5600X。GPU : NVIDIA GeForce GTX 1060 6GB。

以下のページが参考になりそう。ありがたや。

_OpenPoseを使って手っ取り早く姿勢推定をしてみる(Windows10) | 技術的特異点

_OpenPose による姿勢推定(Windows 上)

_OpenPose 1.7.0 のインストール,デモの実行(Windows 上)

_OpenPose の使い方 - nomlab

_Advent Calendar | 濱川研究室Webページ

_OpenPoseの使い方メモ - .com-pound

よく分からんけど、OpenPoseDemo.exe なるものを動かせば OpenPose画像/動画が得られるようだなと…。

◎ OpenPoseのバイナリを入手 :

以下のページから、OpenPoseを生成できる、Windows用のバイナリが入手できるらしい。

_GitHub - CMU-Perceptual-Computing-Lab/openpose: OpenPose: Real-time multi-person keypoint detection library for body, face, hands, and foot estimation

_Releases - CMU-Perceptual-Computing-Lab/openpose - GitHub

OpenPose v1.7.0 を入手。CPUを使って処理する版と、GPUを使って処理する版があるらしいけど、よく分からないので両方DLしておいた。

解凍して任意の場所に置く。今回は、D:\aiwork\openpose\cpu\ と、D:\aiwork\openpose\gpu\ に置いてみた。

_GitHub - CMU-Perceptual-Computing-Lab/openpose: OpenPose: Real-time multi-person keypoint detection library for body, face, hands, and foot estimation

_Releases - CMU-Perceptual-Computing-Lab/openpose - GitHub

OpenPose v1.7.0 を入手。CPUを使って処理する版と、GPUを使って処理する版があるらしいけど、よく分からないので両方DLしておいた。

- openpose-1.7.0-binaries-win64-cpu-python3.7-flir-3d.zip : CPU使用版

- openpose-1.7.0-binaries-win64-gpu-python3.7-flir-3d_recommended.zip : GPU使用版

解凍して任意の場所に置く。今回は、D:\aiwork\openpose\cpu\ と、D:\aiwork\openpose\gpu\ に置いてみた。

◎ 学習モデルデータをダウンロード :

動かすには、学習モデルデータを入手しないといけない。modelsフォルダの中に入って、getBaseModels.bat を実行すると、拡張子が .caffemodel のファイルがいくつかDLされる。全部で400MBほどのファイルがDLされた。

◎ サンプル画像やサンプル動画 :

examples\media\ というフォルダの中に、動作確認用のサンプル画像、サンプル動画が入っていた。jpgファイルが20ファイル、aviファイルが1ファイル入ってる。

◎ 動かしてみる :

とりあえず、動かしてみる。GPU使用版は何か色々必要になりそうなので、まずはCPU使用版を使ってみる。

サンプル画像の中の COCO_val2014_000000000328.jpg だけを、test\ というフォルダを作って、その中にコピー。

bin\ の中に実行バイナリ、OpenPoseDemo.exe が入ってるらしいので、ソレを実行。

--write_images OUTDIR をつければ、結果画像を保存できるらしい。outputsフォルダを作成して、指定してみる。

outputs\ の中にpng画像が保存された。元画像の上に、OpenPose が描き込まれている状態の画像が得られた。ちゃんと人体姿勢を検出できてる。スゴイ。

ただ、OpenPose画像だけを取得したいのだけど…。そんなことはできるのだろうか。

以下のページで、該当オプションが解説されてた。

_openpose/01_demo.md at master - CMU-Perceptual-Computing-Lab/openpose - GitHub

--disable_blending をつけてやると、元画像との合成を無効にしてくれるらしい。

OpenPoseだけが描き込まれた画像が得られた。

解析結果を数値で欲しい場合は、.yml か .json で書き出すことができる模様。--write_keypoint OUTDIR か --write_json OUTDIR を使う。

サンプル画像の中の COCO_val2014_000000000328.jpg だけを、test\ というフォルダを作って、その中にコピー。

bin\ の中に実行バイナリ、OpenPoseDemo.exe が入ってるらしいので、ソレを実行。

bin\OpenPoseDemo.exe --image_dir test--image_dir INDIR を指定すれば、画像が入ってるフォルダを指定できる。ファイル単位で指定できるわけではなくて、フォルダ単位でしか指定できないようだなと…。

> bin\OpenPoseDemo.exe --image_dir test Starting OpenPose demo... Configuring OpenPose... Starting thread(s)... ---------------------------------- WARNING ---------------------------------- We have introduced an additional boost in accuracy in the CUDA version of about 0.2% with respect to the CPU/OpenCL versions. We will not port this to CPU given the considerable slow down in speed it would add to it. Nevertheless, this accuracy boost is almost insignificant so the CPU/OpenCL versions can be safely used. -------------------------------- END WARNING -------------------------------- OpenPose demo successfully finished. Total time: 3.299756 seconds.3.299756秒かかって、OpenPose が描き込まれた感じの画像ウインドウが一瞬表示されて消えてしまった。ひとまず、動いてはいるようだなと…。CPU使用版でもちゃんと動いてくれる。しかし、結果画像がどこにも保存されてない気がする…。

--write_images OUTDIR をつければ、結果画像を保存できるらしい。outputsフォルダを作成して、指定してみる。

bin\OpenPoseDemo.exe --image_dir test --write_images outputs

outputs\ の中にpng画像が保存された。元画像の上に、OpenPose が描き込まれている状態の画像が得られた。ちゃんと人体姿勢を検出できてる。スゴイ。

ただ、OpenPose画像だけを取得したいのだけど…。そんなことはできるのだろうか。

以下のページで、該当オプションが解説されてた。

_openpose/01_demo.md at master - CMU-Perceptual-Computing-Lab/openpose - GitHub

--disable_blending をつけてやると、元画像との合成を無効にしてくれるらしい。

bin\OpenPoseDemo.exe --image_dir test --write_images outputs --disable_blending

OpenPoseだけが描き込まれた画像が得られた。

解析結果を数値で欲しい場合は、.yml か .json で書き出すことができる模様。--write_keypoint OUTDIR か --write_json OUTDIR を使う。

bin\OpenPoseDemo.exe --image_dir test --write_images outputs --disable_blending --write_keypoint outputs --write_json outputs

◎ 2023/05/19追記 :

[ ツッコむ ]

#2 [nitijyou] 暑い

昨日、今日と、気温が30度超え。暑い。さすがにエアコンを入れた。

5月中旬なのにこの暑さ…。どうなってしまうのか…。

5月中旬なのにこの暑さ…。どうなってしまうのか…。

[ ツッコむ ]

2023/05/19(金) [n年前の日記]

#1 [cg_tools] OpenPose動画を作りたい。その2

_昨日

の続き。OpenPoseの静止画像を作成することはできたので、今度は動画を生成したい。

環境は、Windows10 x64 22H2。CPU : AMD Ryzen 5 5600X。GPU : NVIDIA GeForce GTX 1060 6GB。

OpenPoseDemo.exe は、CPU使用版。

環境は、Windows10 x64 22H2。CPU : AMD Ryzen 5 5600X。GPU : NVIDIA GeForce GTX 1060 6GB。

OpenPoseDemo.exe は、CPU使用版。

◎ サンプル動画を入手 :

OpenPose のバイナリと一緒に、examples\media\video.avi というサンプル動画も入っているけれど。今回は、ソレとは別の動画を渡して処理してみたい。

今回は、以下の動画を使わせてもらうことにした。25fpsの動画。1920x1080版をDL。

_Video Of Person Running In The Park Free Stock Video Footage, Royalty-Free 4K & HD Video Clip

ちなみに、以下のサイトで検索して探したのだけど…。何故にどの動画もスローモーションなのか…。

_Running Videos, Download The BEST Free 4k Stock Video Footage & Running HD Video Clips

今回は、以下の動画を使わせてもらうことにした。25fpsの動画。1920x1080版をDL。

_Video Of Person Running In The Park Free Stock Video Footage, Royalty-Free 4K & HD Video Clip

ちなみに、以下のサイトで検索して探したのだけど…。何故にどの動画もスローモーションなのか…。

_Running Videos, Download The BEST Free 4k Stock Video Footage & Running HD Video Clips

◎ 512x512に加工 :

後々、画像生成AI Stable Diffusion web UI に渡したいので、元動画を、512x512の動画に加工したい。

今回は、Avidemux 2.7.8 を使って作業した。ちなみに、現行版は 2.8.1 の模様。

_Avidemux のダウンロードと使い方 - k本的に無料ソフト・フリーソフト

フィルターを設定。1:1にトリミングしてから、512x512に拡大縮小。人物が出ていない時間(?)ができてしまったので、動画の前後を削除。

大体以下のような雰囲気の動画になった。これは256x256に縮小してるけど…。

今回は、Avidemux 2.7.8 を使って作業した。ちなみに、現行版は 2.8.1 の模様。

_Avidemux のダウンロードと使い方 - k本的に無料ソフト・フリーソフト

フィルターを設定。1:1にトリミングしてから、512x512に拡大縮小。人物が出ていない時間(?)ができてしまったので、動画の前後を削除。

大体以下のような雰囲気の動画になった。これは256x256に縮小してるけど…。

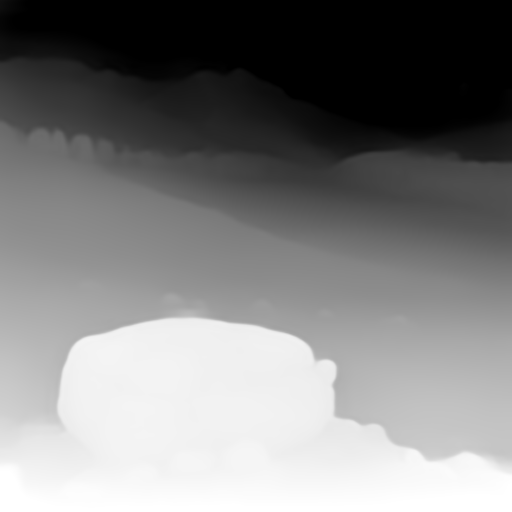

◎ OpenPose動画を作成 :

動画を解析して、OpenPose動画を出力する。

このままだと、MotionJPEG の avi なので、Webブラウザでも再生できるように、ffmpeg 6.0 を使ってmp4に変換した。

こんな感じの動画になった。動きをバッチリ抽出できてる。

bin\OpenPoseDemo.exe --video test\src.mp4 --write_video outputs\dst.avi --disable_blending

- --video IN.avi : 入力動画。一般的には .avi を渡すようだけど、.mp4 もイケた。

- --write_video OUT.avi : 出力動画。MotionJPEGで保存されるっぽい。

- --disable_blending : OpenPose部分のみを出力。

このままだと、MotionJPEG の avi なので、Webブラウザでも再生できるように、ffmpeg 6.0 を使ってmp4に変換した。

ffmpeg -i dst.avi -vcodec libx264 -pix_fmt yuv420p dst.mp4

こんな感じの動画になった。動きをバッチリ抽出できてる。

◎ 連番画像として出力 :

後々、Stable Diffusion web UI で作業をする際に、OpenPose の静止画像があったほうが調整しやすいはずなので、ffmpeg を使って、動画を連番画像として出力。

ffmpeg -i results.avi seq\%04d.png or ffmpeg -i results.avi -vcodec png -r 25 %04d.png

- -i IN.avi : 入力動画

- -vcodec png : 出力フォーマットをpngにする

- -r N : フレームレート

- %04d.png : 4桁の数字で示された連番画像として保存

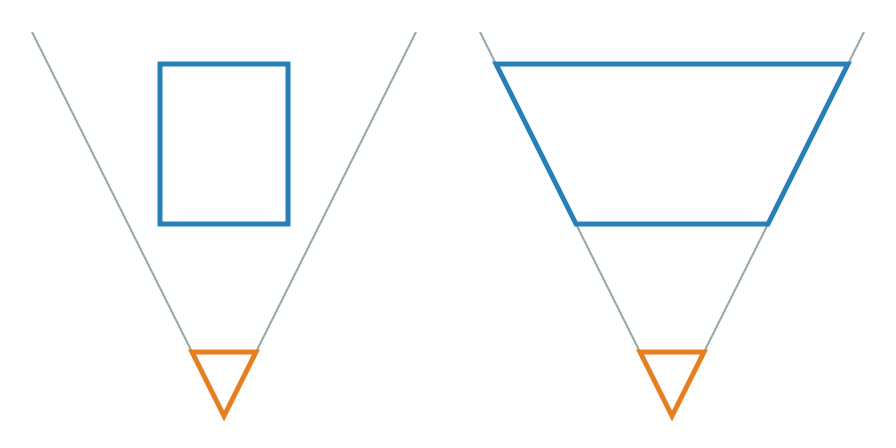

◎ 形が違うことに気づいた :

今頃になって気づいたけれど、Stable Diffusion web UI で指定する OpenPose と、OpenPoseDemo.exe が生成する OpenPose は、形がちょっと違う…。

_Windows への OpenPose導入手順【2018/12/30追記】 - Qiita

_Windows10にてGPU版OpenPoseを動かしてみた - Qiita

どうやら、1.3.0 から 1.4.0 になった時点で、形が変わったように見える。

であれば、OpenPose 1.3.0 のバイナリを入手すれば、Stable Diffusion web UI のソレに一致させることができるのだろうか。しかし、そう上手くはいかないようで。

_Releases - CMU-Perceptual-Computing-Lab/openpose - GitHub

1.3.0までは、GPU版しかなくて、1.4.0からCPU版のバイナリも公開されるようになったっぽい。CPU版を使いたいのだけど、困った…。

GPU版 OpenPose 1.3.0 を動かすためには、CUDA 8.0、cuDNN 5.1 が必要になるようで…。自分の環境は、Stable Diffusion web UI を動かすために、CUDA 11.8 をインストール済みなんだよな…。異なるバージョンをインストールすることってできるのかな…。

前述のページを書いた方が、コメント欄でCPU版を公開してくれているので、DLして実行してみたけれど、以下の .dll が無いと言われてしまった…。

どうやら CUDA の複数バージョンを共存させる方法を実現して、GPU版を使うしかないようだなと…。

- Stable Diffusion web UI + ControlNet : 首から足の根元まで2本の線が出てる。

- OpenPose 1.7.0 : 首から腰まで1本の線になっている。

_Windows への OpenPose導入手順【2018/12/30追記】 - Qiita

_Windows10にてGPU版OpenPoseを動かしてみた - Qiita

どうやら、1.3.0 から 1.4.0 になった時点で、形が変わったように見える。

であれば、OpenPose 1.3.0 のバイナリを入手すれば、Stable Diffusion web UI のソレに一致させることができるのだろうか。しかし、そう上手くはいかないようで。

_Releases - CMU-Perceptual-Computing-Lab/openpose - GitHub

1.3.0までは、GPU版しかなくて、1.4.0からCPU版のバイナリも公開されるようになったっぽい。CPU版を使いたいのだけど、困った…。

GPU版 OpenPose 1.3.0 を動かすためには、CUDA 8.0、cuDNN 5.1 が必要になるようで…。自分の環境は、Stable Diffusion web UI を動かすために、CUDA 11.8 をインストール済みなんだよな…。異なるバージョンをインストールすることってできるのかな…。

前述のページを書いた方が、コメント欄でCPU版を公開してくれているので、DLして実行してみたけれど、以下の .dll が無いと言われてしまった…。

cublas64_80.dll cudart64_80.dll curand64_80.dll

どうやら CUDA の複数バージョンを共存させる方法を実現して、GPU版を使うしかないようだなと…。

◎ COCOモデルを使えばいいらしい :

調べてみたら、現行版の OpenPose 1.7.0 でも、COCOモデルなるものを使えば、Stable Diffusion web UI + ControlNet と同じ形状で OpenPose を出力できそうだと分かった。

COCOモデルを使うには、OpenPoseインストールフォルダ\models\ 内で、getCOCO_and_MPII_optional.bat を実行して、モデルデータを追加ダウンロードする必要がある。

また、OpnePoseDemo.exe には、--model_pose COCO を渡してやる。

Stable Diffusion web UI + ControlNet + OpenPose で利用できる形状のソレを得ることができた。

しかし、そもそも、Stable Diffusion web UI で、動画に基づいて各ポーズを指定したいだけなら、ControlNet のプリプロセッサで OpenPose を通せば良いのではないか。わざわざ別途、OpenPoseDemo.exe を動かす必要も無いのでは…。

COCOモデルを使うには、OpenPoseインストールフォルダ\models\ 内で、getCOCO_and_MPII_optional.bat を実行して、モデルデータを追加ダウンロードする必要がある。

また、OpnePoseDemo.exe には、--model_pose COCO を渡してやる。

bin\OpenPoseDemo.exe --image_dir test --write_images outputs --model_pose COCO

bin\OpenPoseDemo.exe --video src.mp4 --write_video dst.avi --model_pose COCO --disable_blending

Stable Diffusion web UI + ControlNet + OpenPose で利用できる形状のソレを得ることができた。

しかし、そもそも、Stable Diffusion web UI で、動画に基づいて各ポーズを指定したいだけなら、ControlNet のプリプロセッサで OpenPose を通せば良いのではないか。わざわざ別途、OpenPoseDemo.exe を動かす必要も無いのでは…。

この記事へのツッコミ

[ ツッコミを読む(1) | ツッコむ ]

#2 [nitijyou] ワサビ作戦失敗

ウチでは、電動アシスト自転車が車の横に止めてあるのだけど、風が強い日に倒れてしまって、車の側面を傷つけてしまったことがあって。それ以来、100円ショップで買ったフック付きゴム紐を使って、自転車を縁側に固定してる。

しかし、飼い犬が、稀にそのゴム紐を齧り切ってしまって…。昨日も噛み切られてしまった…。もう10回ぐらいは噛み切られている気がする…。どうにか齧らないようにできないものかな…。

ググってみたら、テーブルの足、椅子の足等、犬に齧られると困る部分にワサビを塗っておく策を考えた方が居るようで。一般的には、ワサビの刺激臭が犬にとってはキツイらしい。

もちろん刺激物なので、犬に日常的に食べさせるなんてもってのほか。下手すると犬の内臓を痛めてしまう可能性があるらしいけど。そもそも犬が嫌がるなら、食べることもないだろう…。

そんなわけで、試しに、買ってきたばかりのゴム紐にワサビを塗りつけてみた。

しかし、朝になったら、また噛み切られていた…。しかも、普段は買ってきたばかりのゴム紐を齧ることなんてなかったのに、交換した途端にやらかしてくれるとは…。そんなにも齧りたくなる匂いだったのか…。

稀に居るらしいけど、どうやらウチの犬も、ワサビ大好きな個体だったようだなと…。作戦失敗。

しかし、飼い犬が、稀にそのゴム紐を齧り切ってしまって…。昨日も噛み切られてしまった…。もう10回ぐらいは噛み切られている気がする…。どうにか齧らないようにできないものかな…。

ググってみたら、テーブルの足、椅子の足等、犬に齧られると困る部分にワサビを塗っておく策を考えた方が居るようで。一般的には、ワサビの刺激臭が犬にとってはキツイらしい。

もちろん刺激物なので、犬に日常的に食べさせるなんてもってのほか。下手すると犬の内臓を痛めてしまう可能性があるらしいけど。そもそも犬が嫌がるなら、食べることもないだろう…。

そんなわけで、試しに、買ってきたばかりのゴム紐にワサビを塗りつけてみた。

しかし、朝になったら、また噛み切られていた…。しかも、普段は買ってきたばかりのゴム紐を齧ることなんてなかったのに、交換した途端にやらかしてくれるとは…。そんなにも齧りたくなる匂いだったのか…。

稀に居るらしいけど、どうやらウチの犬も、ワサビ大好きな個体だったようだなと…。作戦失敗。

[ ツッコむ ]

2023/05/20(土) [n年前の日記]

#1 [cg_tools] OpenPoseで画像生成したい

_一昨日、

_昨日

と、OpenPose動画を得るための実験をしていたけれど。画像生成AI Stable Diffusion web UIに、OpenPose動画を渡して画像を生成したいだけなら、そもそも元動画をControlNetに渡してしまって、OpenPoseのプリプロセッサを通せば話が早いのではと気づいてしまって…。その方向でアニメーションを作成できそうか実験。

*1

環境は、Windows10 x64 22H2。CPU AMD Ryzen 5 5600X。GPU NVIDIA GeForcet GTX1060 6GB。RAM 16GB。

環境は、Windows10 x64 22H2。CPU AMD Ryzen 5 5600X。GPU NVIDIA GeForcet GTX1060 6GB。RAM 16GB。

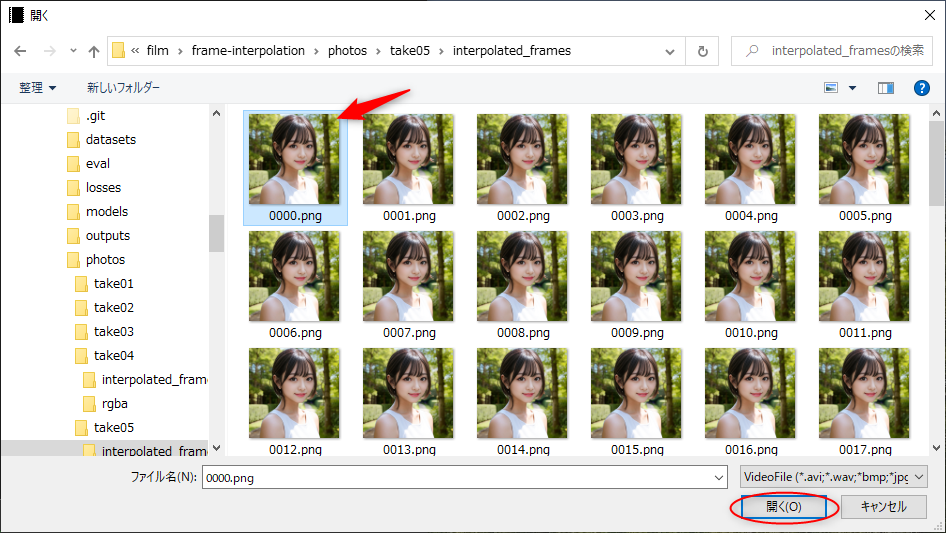

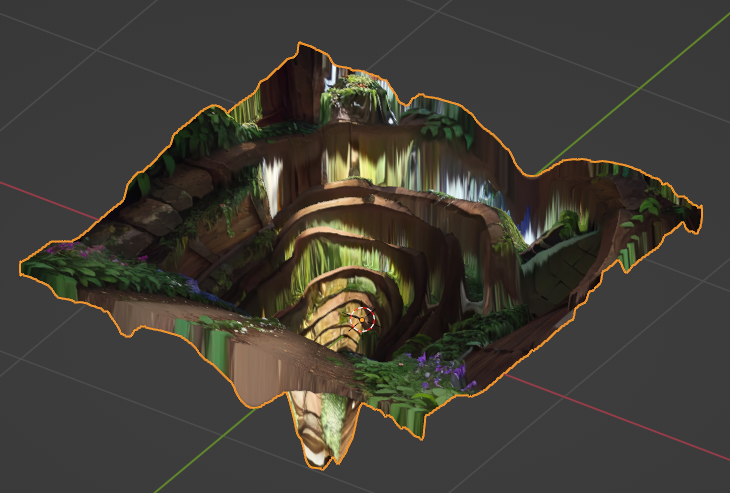

◎ 元動画 :

元動画は、以下のような雰囲気の動画。上半身裸の黒人おじさんがランニングをしている。これは256x256に縮小してあるけれど、実際に作業に使った動画は512x512。25fps。全31フレーム。

元々のオリジナル動画は以下から入手できる。

_Video Of Person Running In The Park Free Stock Video Footage, Royalty-Free 4K & HD Video Clip

元々のオリジナル動画は以下から入手できる。

_Video Of Person Running In The Park Free Stock Video Footage, Royalty-Free 4K & HD Video Clip

◎ テストその1 :

txt2img上で、ControlNet m2m スクリプトを使ってアニメーションを作成。ControlNet でプリプロセッサと学習モデルデータに openpose を指定。

学習モデルデータは、animelike25D_animelike25DV11Pruned.safetensors を使わせてもらった。

こんな感じになった。24fps。全31フレーム。

一応ランニングしてるように見えなくもないけど、それはそれとして、背景が1フレーム毎にパカパカ変わってしまって、とても見辛い…。この背景はどうにかしたい…。

学習モデルデータは、animelike25D_animelike25DV11Pruned.safetensors を使わせてもらった。

parameters 1 girl, solo, black short hair, red camisole, red miniskirt, black globes, white sneakers, running, (((background is simple and flat and white))), ((masterpiece, bets best quality)), Negative prompt: (worst quality:1.4), (low quality:1.4), (normal quality:1.4), lowers, (monochrome), (grayscale), bad anatomy, extra arms, extra legs, missing arms, missing legs, bad arms, bad legs, Steps: 25, Sampler: DPM++ SDE Karras, CFG scale: 9, Seed: 1434010576, Size: 512x512, Model hash: 4f24a26d75, Model: animelike25D_animelike25DV11Pruned, Clip skip: 2, ControlNet 0: "preprocessor: openpose, model: control_v11p_sd15_openpose [cab727d4], weight: 1, starting/ending: (0, 1), resize mode: Crop and Resize, pixel perfect: False, control mode: Balanced, preprocessor params: (512, 64, 64)"

こんな感じになった。24fps。全31フレーム。

一応ランニングしてるように見えなくもないけど、それはそれとして、背景が1フレーム毎にパカパカ変わってしまって、とても見辛い…。この背景はどうにかしたい…。

◎ テストその2 :

ネガティブプロンプトに与えるワードを色々試して、背景をスッキリさせられないか試行錯誤してみた。

white background, no background を指定してみたり、ネガティブプロンプトに、時々出現する謎物体を分かる範囲で指定してみたり、人物が2人出現しないように、思いつくワードを入れてみたり。

そんなわけで、こうなった。24fps。全31フレーム。

かなり背景をスッキリさせることができた。しかし、これでも時々妙な物体が描かれる…。なんだろうコレは…。言葉で説明できる物体なら、ネガティブプロンプトに追加することで消せるかもしれないけど…。

さておき。フツーの手描きアニメは、フィルム時代の名残りで、24コマ/秒で作られてるけど、1秒間につき24枚の動画を真面目に描いてるカットは稀だったりする。例えば、ディズニーの手描きアニメですら、動画1枚を2コマ撮影していて ―― 2コマベース、12fpsを基本として作られてるので…。1枚ずつ間引いて、12fps、全15フレームにしてみた。

12fpsにしたことで、ちょっとは手描きアニメっぽい雰囲気に近づいた気がする。

ちなみに、日本のアニメは、鉄腕アトムの頃から3コマベース、8fpsを基本として作られているので、2枚ずつ間引いて8fps、全11フレームにしてみた。

これでもまあ、そこそこアニメーションっぽい感じにはなるなと…。

もっとも…。

それでも、例えばミュージックビデオ等の1カットでチラッと流してみるとか、エヴァTV版の最終回近辺のように、混乱しているキャラの精神世界を表現、といった使い方なら、こういう動画もイケそうな気もする。

それはそれとして。黒人のおじさんが走ってる動画から、こういう動画を生成できてしまうという点は、結構悪くないのではないかと。