2022/06/01(水) [n年前の日記]

#1 [xscreensaver][xlib] Xlibについて調べてる

xscreensaver用のスクリーンセーバで何かしらを描画する時は Xlib なるものを使って描画するのが一般的らしいのだけど。その Xlib とやらで拡大縮小描画みたいなことはできないのかなとググってるところ。

スクリーンセーバの面倒なところは、ディスプレイの解像度/ウインドウサイズが、環境によって異なる点。例えば 1920x1080 のサイズで画像等をイイ感じにレイアウトしても、1024x768 だの 3840×2160 だの、そういったディスプレイで表示しようとすると、見た目は滅茶苦茶になってしまう。どうにかならんか。

そこで思いつくのが、320x240、640x480、1280x720等のお決まりのサイズで一旦画面を作っておいて、ソレを目的のウインドウサイズに拡大、もしくは縮小して描画する方法。love2d や Unity では、そういうことをして全画面表示にする場合もちょくちょくあったりする。

そんなわけで、Xlib にそういう機能は無いのかな、拡大縮小描画ができれば楽になるよなとググっているわけだけど…。どうやらそんな機能は存在していない模様。あくまで等倍でしか画像の描画はできませんよ、みたいな話をチラホラ目にした。

そういうことをしたいなら、OpenGL だか glx だか、そのあたりを使わないといかんのだろうか。

ただ、hacks/*.c を眺めたところ、自力で拡大縮小処理をしているものもあるように思えた。例えば apple2-main.c の中には scale_image() という関数があるし、xscreensaver-getimage.c の中にも scale_ximage() という関数がある。名前からして画像の拡大縮小処理をしてそう。1ドットずつ処理をしていくから処理時間がかかりそうではあるけれど。

スクリーンセーバの面倒なところは、ディスプレイの解像度/ウインドウサイズが、環境によって異なる点。例えば 1920x1080 のサイズで画像等をイイ感じにレイアウトしても、1024x768 だの 3840×2160 だの、そういったディスプレイで表示しようとすると、見た目は滅茶苦茶になってしまう。どうにかならんか。

そこで思いつくのが、320x240、640x480、1280x720等のお決まりのサイズで一旦画面を作っておいて、ソレを目的のウインドウサイズに拡大、もしくは縮小して描画する方法。love2d や Unity では、そういうことをして全画面表示にする場合もちょくちょくあったりする。

そんなわけで、Xlib にそういう機能は無いのかな、拡大縮小描画ができれば楽になるよなとググっているわけだけど…。どうやらそんな機能は存在していない模様。あくまで等倍でしか画像の描画はできませんよ、みたいな話をチラホラ目にした。

そういうことをしたいなら、OpenGL だか glx だか、そのあたりを使わないといかんのだろうか。

ただ、hacks/*.c を眺めたところ、自力で拡大縮小処理をしているものもあるように思えた。例えば apple2-main.c の中には scale_image() という関数があるし、xscreensaver-getimage.c の中にも scale_ximage() という関数がある。名前からして画像の拡大縮小処理をしてそう。1ドットずつ処理をしていくから処理時間がかかりそうではあるけれど。

[ ツッコむ ]

2022/06/02(木) [n年前の日記]

#1 [nitijyou] 自宅サーバ止めてました

雷が鳴ったので、17:00-21:00の間、自宅サーバを止めてました。申し訳ないです。

[ ツッコむ ]

#2 [pc] 自宅サーバの電源が入らなくなって四苦八苦

雷が鳴り止んだので、自宅サーバの電源を入れようとしたところ、妙な動作になった。電源タップのスイッチをONにした途端に電源が入って、しかしその数秒後に勝手に電源が切れてしまう。

まさか、またM/Bが壊れてしまったのか。それともACアダプタが弱まって起動できない状態になったのか。それとも、実は外出中に雷が落ちて壊れてしまったのか…。電源タップはOFFにしてたし、LANケーブルも引っこ抜いておいたはずだけどなあ…。

PCデスクの足元から、PCケースごと ―― SilverStone SST-SG05W ごと引っ張り出して眺めてみたら原因が分かった。単に、電源スイッチのカバーが押し込まれたまま戻らない状態になっていた模様。なるほど、電源スイッチがずっと押されっぱなしになっていたから、コンセントに電源ケーブルを差すと途端に電源が入ってしまうし、その後きっかり4秒後に電源が落ちていたのだな…。 *1

それにしても、電源スイッチがLEDで光るお洒落なデザインを追求した結果、そもそも電源スイッチとして機能しない・電源のON/OFFすら怪しい設計になりましたというのは、安物PCケースのあるあるネタだなあ、と。

さておき。どうしたもんか。引っ込んだ電源スイッチカバーがするする出てくるようにならないかと、モイスチャーオイルとやらを垂らしてみたけど全く効果無し。相変わらず引っ込んだまま。

これはもう電源スイッチを全く別のモノと交換するしかないかな、この電源スイッチカバーは取り外して、その穴から別の電源スイッチのケーブルを通そう…。

と思って、電源スイッチカバーを繋ぎとめてる2本のプラスチックの棒をニッパーで切ってみたところ、電源スイッチカバーがパカパカスルスルと動くようになった。これでいいんじゃないかな。

メーカは何故に最初からこういう設計にしておかなかったのだろう。まあ、この状態だと工場での組み立て時にポロポロ落ちて作業員が困るだろうと考えたのかもしれないけれど。その結果、ちょっと強く押したら戻ってこなくなる電源スイッチになってしまったら、それもなんだかトホホだろうに…。

電源ケーブル等を繋ぎ直して再設置。フツーに起動してくれた。やっぱり電源スイッチのせいだったらしい。一安心。

まさか、またM/Bが壊れてしまったのか。それともACアダプタが弱まって起動できない状態になったのか。それとも、実は外出中に雷が落ちて壊れてしまったのか…。電源タップはOFFにしてたし、LANケーブルも引っこ抜いておいたはずだけどなあ…。

PCデスクの足元から、PCケースごと ―― SilverStone SST-SG05W ごと引っ張り出して眺めてみたら原因が分かった。単に、電源スイッチのカバーが押し込まれたまま戻らない状態になっていた模様。なるほど、電源スイッチがずっと押されっぱなしになっていたから、コンセントに電源ケーブルを差すと途端に電源が入ってしまうし、その後きっかり4秒後に電源が落ちていたのだな…。 *1

それにしても、電源スイッチがLEDで光るお洒落なデザインを追求した結果、そもそも電源スイッチとして機能しない・電源のON/OFFすら怪しい設計になりましたというのは、安物PCケースのあるあるネタだなあ、と。

さておき。どうしたもんか。引っ込んだ電源スイッチカバーがするする出てくるようにならないかと、モイスチャーオイルとやらを垂らしてみたけど全く効果無し。相変わらず引っ込んだまま。

これはもう電源スイッチを全く別のモノと交換するしかないかな、この電源スイッチカバーは取り外して、その穴から別の電源スイッチのケーブルを通そう…。

と思って、電源スイッチカバーを繋ぎとめてる2本のプラスチックの棒をニッパーで切ってみたところ、電源スイッチカバーがパカパカスルスルと動くようになった。これでいいんじゃないかな。

メーカは何故に最初からこういう設計にしておかなかったのだろう。まあ、この状態だと工場での組み立て時にポロポロ落ちて作業員が困るだろうと考えたのかもしれないけれど。その結果、ちょっと強く押したら戻ってこなくなる電源スイッチになってしまったら、それもなんだかトホホだろうに…。

電源ケーブル等を繋ぎ直して再設置。フツーに起動してくれた。やっぱり電源スイッチのせいだったらしい。一安心。

*1: えてしてPCの電源は、電源スイッチを4秒ほど押しっぱなしにすると電源が強制的に切れるようになっている。

[ ツッコむ ]

#3 [xscreensaver][xlib] Xlibについて勉強中

Linuxのデスクトップ画面で何かしらを描く時は Xlib を使うらしいので勉強中。

以下のサイトやページを参考にしつつコピペして動作確認。

_Xlib Programming Lectures

_X11で始めるGUIプログラミング|コアダンプの数だけ強くなれるよ

_X Window Systemプログラミングを勉強してみた - ウィンドウを表示する - Tomitomi's blog

以下のサイトやページを参考にしつつコピペして動作確認。

_Xlib Programming Lectures

_X11で始めるGUIプログラミング|コアダンプの数だけ強くなれるよ

_X Window Systemプログラミングを勉強してみた - ウィンドウを表示する - Tomitomi's blog

[ ツッコむ ]

2022/06/03(金) [n年前の日記]

#1 [xlib] Xlibについて勉強中その2

Xlibについて勉強中。

環境は、Ubuntu Linux 20.04 LTS。Windows10 x64 21H2 + VMware Player 上で動かしている。

環境は、Ubuntu Linux 20.04 LTS。Windows10 x64 21H2 + VMware Player 上で動かしている。

◎ ウインドウの表示と画像の描画。 :

とりあえず、ウインドウを表示して、四角、円、画像を描画するところまで動作確認してみた。

_02win.c

使用画像: _ufo2.xpm

Makefile: _Makefile

コンパイルは以下。

実行は以下。

少し解説。

xpm画像は中身がテキストファイル。C言語のソースファイル内で include して画像データのバイナリにアクセスすることができる。ちなみに、GIMP で xpm としてエクスポートすれば xpm画像を作れる。

画像を扱う時は Pixmap か XImage を使うらしいけど、今回は Pixmap を使って処理してみた。

xpm から Pixmap に変換しているのは以下。

透過画像を描画する時は、XSetClipMask()、XSetClipOrigin()、XCopyArea()、XSetClipMask() を使う。

Pixmap や GC は、プログラムを終了する前に、利用していたメモリ領域を解放しておかないといけない。XFreePixmap()、XFreeGC() を使って解放する。

_02win.c

#include <stdio.h>

#include <stdlib.h>

#include <unistd.h>

#include <X11/Xlib.h>

#include <X11/xpm.h>

#include <math.h>

/* include ufo2_xpm */

#include "ufo2.xpm"

#define WIN_W 512

#define WIN_H 512

#define WIN_X 100

#define WIN_Y 100

#define BORDER 4

#ifndef M_PI

#define M_PI 3.14159265358979

#endif

#define deg2rad(x) (x * M_PI / 180.0)

typedef struct _Pixmaps

{

Pixmap pix;

Pixmap mask;

} Pixmaps;

static void update(Display *dpy, Drawable win, GC gc, double ang, Pixmaps pixs);

/* get a color value from a color name */

static unsigned long

get_color(Display *dpy, char *colorname)

{

Colormap cmap;

XColor near_color, true_color;

cmap = DefaultColormap(dpy, DefaultScreen(dpy));

XAllocNamedColor(dpy, cmap, colorname, &near_color, &true_color);

return near_color.pixel;

}

int main(void)

{

Display *dpy;

Window root;

Window win;

int screen;

XEvent evt;

unsigned long black, white;

GC gc;

Pixmaps pixs;

int busy_loop;

double ang;

/* open display */

dpy = XOpenDisplay(NULL);

root = DefaultRootWindow(dpy);

screen = DefaultScreen(dpy);

/* get color black and white */

white = WhitePixel(dpy, screen);

black = BlackPixel(dpy, screen);

/* create window */

win = XCreateSimpleWindow(dpy, root,

WIN_X, WIN_Y, WIN_W, WIN_H, BORDER,

black, white);

XSelectInput(dpy, win, KeyPressMask | ExposureMask);

XMapWindow(dpy, win);

/* wait display window */

do

{

XNextEvent(dpy, &evt);

} while (evt.type != Expose);

XMoveWindow(dpy, win, WIN_X, WIN_Y);

/* create graphics context */

gc = XCreateGC(dpy, win, 0, 0);

XSetGraphicsExposures(dpy, gc, False);

/* load image */

if (XpmCreatePixmapFromData(dpy, win, ufo2_xpm,

&pixs.pix, &pixs.mask, NULL))

{

fprintf(stderr, "Error not load xpm.");

return 1;

}

ang = 0;

busy_loop = 1;

while (busy_loop)

{

/* event */

while (XPending(dpy))

{

XNextEvent(dpy, &evt);

switch (evt.type)

{

/*

case Expose:

if (evt.xexpose.count == 0)

{

}

break;

*/

case KeyPress:

busy_loop = 0;

break;

default:

break;

}

}

update(dpy, win, gc, ang, pixs);

ang += 1.0;

if (ang >= 360)

ang -= 360;

XFlush(dpy);

usleep(16 * 1000); /* wait */

}

XFreePixmap(dpy, pixs.pix);

XFreePixmap(dpy, pixs.mask);

XFreeGC(dpy, gc);

XDestroyWindow(dpy, win);

XCloseDisplay(dpy);

return 0;

}

/* update and draw */

static void

update(Display *dpy, Drawable win, GC gc, double ang, Pixmaps pixs)

{

XWindowAttributes xgwa;

int scrw, scrh;

int r, x, y, w, h;

int r2, x2, y2, w2, h2;

/* get window attributes */

XGetWindowAttributes(dpy, win, &xgwa);

scrw = xgwa.width; /* window width */

scrh = xgwa.height; /* window height */

w = 96;

h = 96;

r = 200;

x = r * cos(deg2rad(ang)) + (scrw / 2) - (w / 2);

y = r * sin(deg2rad(ang)) + (scrh / 2) - (h / 2);

w2 = 128;

h2 = 128;

r2 = 128;

x2 = r2 * cos(deg2rad(-ang)) + (scrw / 2) - (w2 / 2);

y2 = r2 * sin(deg2rad(-ang)) + (scrh / 2) - (h2 / 2);

/* clear window */

XClearWindow(dpy, win);

/* draw shape */

XSetForeground(dpy, gc, get_color(dpy, "blue"));

XFillRectangle(dpy, win, gc, x - 8, y - 8, w + 16, h + 16);

XSetForeground(dpy, gc, get_color(dpy, "cyan"));

XFillArc(dpy, win, gc, x, y, w, h, 0, 360 * 64);

/* draw image (Pixmap) */

XSetClipMask(dpy, gc, pixs.mask); /* set clip mask */

XSetClipOrigin(dpy, gc, x2, y2); /* set clip origin */

XCopyArea(dpy, pixs.pix, win, gc, 0, 0, w2, h2, x2, y2); /* copy Pixmap */

XSetClipMask(dpy, gc, None); /* reset clip */

}

使用画像: _ufo2.xpm

Makefile: _Makefile

コンパイルは以下。

gcc 02win.c -o 02win -I /usr/include/X11 -lX11 -lXext -lm -lXpmUbuntu Linux だから上のような指定になっているけれど、別のディストリでは「-I /usr/include/X11」のあたりを変えることになるのかもしれない。巷の解説ページでは別の場所を指定している場合がほとんどなので…。

実行は以下。

./02win

少し解説。

- Xlib を使う時は、#include <X11/Xlib.h> を最初のあたりで書く。コンパイラ(リンカ)には、-lX11 -lXext を追加。

- xpm画像を扱う時は、#include <X11/xpm.h> を以下略。コンパイラ(リンカ)には、-lXpm を追加。

- sin,cos 等の数学関数を使う時は、#include <math.h> を以下略。コンパイラ(リンカ)には、-lm を追加。

xpm画像は中身がテキストファイル。C言語のソースファイル内で include して画像データのバイナリにアクセスすることができる。ちなみに、GIMP で xpm としてエクスポートすれば xpm画像を作れる。

画像を扱う時は Pixmap か XImage を使うらしいけど、今回は Pixmap を使って処理してみた。

xpm から Pixmap に変換しているのは以下。

/* load image */

if (XpmCreatePixmapFromData(dpy, win, ufo2_xpm,

&pixs.pix, &pixs.mask, NULL))

{

fprintf(stderr, "Error not load xpm.");

return 1;

}

- ufo2_xpm が、xpm のバイナリが入ってる変数名。

- pixs.pix に非透過部分が、pixs.mask に透過部分が入るように指定してる。

- XpmCreatePixmapFromData() は、処理成功で0、失敗でエラーコードが返る。ちなみにC言語は、0は偽、0以外は真になる仕様。

透過画像を描画する時は、XSetClipMask()、XSetClipOrigin()、XCopyArea()、XSetClipMask() を使う。

/* draw image (Pixmap) */

XSetClipMask(dpy, gc, pixs.mask); /* set clip mask */

XSetClipOrigin(dpy, gc, x2, y2); /* set clip origin */

XCopyArea(dpy, pixs.pix, win, gc, 0, 0, w2, h2, x2, y2); /* copy Pixmap */

XSetClipMask(dpy, gc, None); /* reset clip */

- XSetClipMask() で、透過部分が入ってる Pixmap を指定して、クリップマスクを設定。

- XSetClipOrigin() で、クリップマスクの原点を設定。

- XCopyArea() で、Pixmap を別の何か(Drawable。ウインドウかPixmap。今回はウインドウが転送先)にコピー。この時、クリップマスクが反映されて、透過ではない部分だけがコピーされる。

- 最後にクリップマスクをリセットしておかないと、次回、別の何かを描画する際に前回のクリップマスクが働いていしまうので注意。

Pixmap や GC は、プログラムを終了する前に、利用していたメモリ領域を解放しておかないといけない。XFreePixmap()、XFreeGC() を使って解放する。

◎ Pixmapを拡大縮小してみる。 :

画像の描画ができたので、画像を拡大縮小できないか試してみる。

どうしてそんなことをしたいのかというと、例えばスクリーンセーバを作る際に、ウインドウサイズ(ディスプレイサイズ)が異なると画像レイアウトが違ってきてしまうからで…。一旦小さい画面(Pixmap)に描いておいて、その小さい画面をウインドウサイズのPixmapに拡大して、それをウインドウに描画することができれば、ウインドウサイズ(ディスプレイサイズ)が違っていても、画像のレイアウトがめちゃくちゃにならずに済むのではないかと。

処理時間的に厳しいのではないかと予想しながら書き始めてみたけど、やり方次第ではどうにかなりそうな気配を感じた。以下のキャプチャ動画は、640 x 360 の Pixmap を 1440 x 900 の Pixmap に拡大してる例。上下にふわふわしてるけど、これでも毎フレーム拡大処理をしている。

_04scale.c

使用画像は以下。

_bg01.xpm

_bg02.xpm

コンパイルは以下。

実行は以下。

少し解説。

最初に処理を書いた時は、愚直に、1ドットずつ XCopyArea() を呼んでみたけれど、このやり方だと圧倒的に処理時間がかかってしまって話にならなかった。

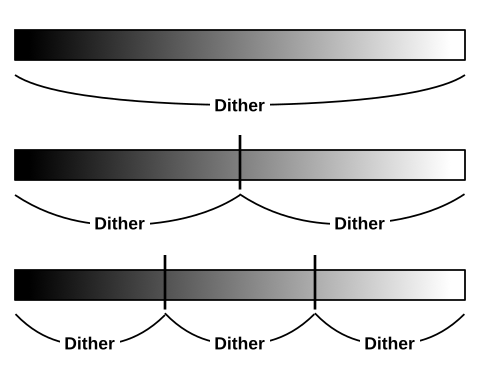

そこでふと、xscreensaver のソース群の中で目にした処理を思い出した。一旦横方向にのみ引き延ばして、その横方向に引き延ばしたものを縦に引き延ばすというやり方。

後者は、前者と比べて圧倒的に速かった。時間を測定してみたところ、以下のような感じになった。

考えてみたら、例えば 1920x1080のサイズの場合、前者は XCopyArea() を 2073600回呼んでしまうけど、後者なら3000回呼ぶだけで済むわけで、そのあたりが効いてるのかなと。ただ、Pixmap へのアクセス回数は、横に引き延ばす段階が入ってくる分、増えてしまうはずなのだけど…。Xlib関係はCPUだけが必死に頑張って処理をしてるものと思い込んでたけど、もしかしてGPUが頑張ってる時もあるのだろうか。それとも、Pixmap間の転送は処理が速くなるように何か工夫してるのだろうか。

何にせよ、このぐらいの速さで拡大描画できるなら、一旦ファミコンレベルの解像度の画面を作っておいて、ソレをデスクトップ一杯に拡大描画しても、60FPS程度なら出せるかもしれない。大昔の2Dゲーム画面っぽいスクリーンセーバを作れそうな予感。

どうしてそんなことをしたいのかというと、例えばスクリーンセーバを作る際に、ウインドウサイズ(ディスプレイサイズ)が異なると画像レイアウトが違ってきてしまうからで…。一旦小さい画面(Pixmap)に描いておいて、その小さい画面をウインドウサイズのPixmapに拡大して、それをウインドウに描画することができれば、ウインドウサイズ(ディスプレイサイズ)が違っていても、画像のレイアウトがめちゃくちゃにならずに済むのではないかと。

処理時間的に厳しいのではないかと予想しながら書き始めてみたけど、やり方次第ではどうにかなりそうな気配を感じた。以下のキャプチャ動画は、640 x 360 の Pixmap を 1440 x 900 の Pixmap に拡大してる例。上下にふわふわしてるけど、これでも毎フレーム拡大処理をしている。

_04scale.c

/*

Scaling Pixmap.

Ryzen 5 5600x + VMware Player + Ubuntu Linux 20.04 LTS.

1920 x 1080.

slow result : 0.510753 sec

fast result : 0.000045 sec

*/

#include <stdio.h>

#include <stdlib.h>

#include <unistd.h>

#include <X11/Xlib.h>

#include <X11/xpm.h>

#include <math.h>

#include <time.h>

/* include xpm binary */

#include "bg01.xpm"

#define XPM_W 640

#define XPM_H 360

#define XPM_NAME bg01_xpm

/*

#include "bg02.xpm"

#define XPM_W 320

#define XPM_H 180

#define XPM_NAME bg02_xpm

*/

/* kind. 0: slow, 1: fast */

#define SCALING_KIND 1

#define WIN_X 0

#define WIN_Y 64

#define BORDER 0

#ifndef M_PI

#define M_PI 3.14159265358979

#endif

#define deg2rad(x) (x * M_PI / 180.0)

/* get a color value from a color name */

static unsigned long

get_color(Display *dpy, char *colorname)

{

Colormap cmap;

XColor near_color, true_color;

cmap = DefaultColormap(dpy, DefaultScreen(dpy));

XAllocNamedColor(dpy, cmap, colorname, &near_color, &true_color);

return near_color.pixel;

}

/* scale Pixmap */

static void

scale_pixmap(Display *dpy, Drawable win,

Pixmap *src, Pixmap *dst,

int src_w, int src_h, int dst_w, int dst_h)

{

GC gc;

float xscale, yscale;

int x, y;

struct timespec start, end;

double diff;

xscale = (float)src_w / dst_w;

yscale = (float)src_h / dst_h;

gc = XCreateGC(dpy, win, 0, 0);

XSetGraphicsExposures(dpy, gc, False);

timespec_get(&start, TIME_UTC);

switch (SCALING_KIND)

{

case 0:

/* slow */

for (y = 0; y < dst_h; y++)

{

int sy = (int)(y * yscale);

for (x = 0; x < dst_w; x++)

XCopyArea(dpy, *src, *dst, gc, (int)(x * xscale), sy, 1, 1, x, y);

}

break;

case 1:

/* fast */

for (x = dst_w - 1; x >= 0; x--)

XCopyArea(dpy, *src, *dst, gc, (int)(x * xscale), 0, 1, src_h, x, 0);

for (y = dst_h - 1; y >= 0; y--)

XCopyArea(dpy, *dst, *dst, gc, 0, (int)(y * yscale), dst_w, 1, 0, y);

break;

default:

break;

}

XFreeGC(dpy, gc);

timespec_get(&end, TIME_UTC);

diff = (end.tv_sec + (double)end.tv_nsec / 1000000000) - (start.tv_sec + (double)start.tv_nsec / 1000000000);

printf("%lf sec\n", diff);

}

/* update and draw */

static void

update(Display *dpy, Drawable win, GC gc, double ang, Pixmap pix, Pixmap buf)

{

XWindowAttributes xgwa;

int r, x, y;

int buf_w, buf_h;

/* get window attributes */

XGetWindowAttributes(dpy, win, &xgwa);

buf_w = xgwa.width; /* window width */

buf_h = xgwa.height; /* window height */

scale_pixmap(dpy, win, &pix, &buf, XPM_W, XPM_H, buf_w, buf_h);

r = 64;

x = 0;

/* x = r * cos(deg2rad(ang)); */

y = r * sin(deg2rad(ang));

/* clear window */

XClearWindow(dpy, win);

/* draw image (Pixmap) */

XSetGraphicsExposures(dpy, gc, False);

XCopyArea(dpy, buf, win, gc, 0, 0, buf_w, buf_h, x, y); /* copy Pixmap */

}

int main(void)

{

Display *dpy;

Window root;

Window win;

int screen;

int display_w, display_h;

XEvent evt;

unsigned long black, white;

XWindowAttributes xgwa;

GC gc;

Pixmap pix;

Pixmap buf;

int busy_loop;

double ang;

/* open display */

dpy = XOpenDisplay(NULL);

root = DefaultRootWindow(dpy);

screen = DefaultScreen(dpy);

/* get display size */

display_w = DisplayWidth(dpy, screen);

display_h = DisplayHeight(dpy, screen);

printf("Screen: %d x %d\n", display_w, display_h);

/* get color black and white */

white = WhitePixel(dpy, screen);

black = BlackPixel(dpy, screen);

/* create window */

win = XCreateSimpleWindow(dpy, root,

WIN_X, WIN_Y, display_w, display_h, BORDER,

white, black);

XSelectInput(dpy, win, KeyPressMask | ExposureMask);

XMapWindow(dpy, win);

/* wait display window */

do

{

XNextEvent(dpy, &evt);

} while (evt.type != Expose);

XMoveWindow(dpy, win, WIN_X, WIN_Y);

/* create graphics context */

gc = XCreateGC(dpy, win, 0, 0);

XSetGraphicsExposures(dpy, gc, False);

/* load image */

if (XpmCreatePixmapFromData(dpy, win, XPM_NAME, &pix, NULL, NULL))

{

fprintf(stderr, "Error not load xpm.");

return 1;

}

XGetWindowAttributes(dpy, win, &xgwa);

buf = XCreatePixmap(dpy, win, display_w, display_h, xgwa.depth);

XSetForeground(dpy, gc, get_color(dpy, "green"));

XFillRectangle(dpy, buf, gc, 0, 0, display_w, display_h);

ang = 0;

busy_loop = 1;

while (busy_loop)

{

/* event */

while (XPending(dpy))

{

XNextEvent(dpy, &evt);

switch (evt.type)

{

/*

case Expose:

if (evt.xexpose.count == 0)

{

}

break;

*/

case KeyPress:

busy_loop = 0;

break;

default:

break;

}

}

update(dpy, win, gc, ang, pix, buf);

ang += 4.0;

if (ang >= 360)

ang -= 360;

XFlush(dpy);

usleep(16 * 1000); /* wait */

}

XFreePixmap(dpy, pix);

XFreePixmap(dpy, buf);

XFreeGC(dpy, gc);

XDestroyWindow(dpy, win);

XCloseDisplay(dpy);

return 0;

}

使用画像は以下。

_bg01.xpm

_bg02.xpm

コンパイルは以下。

gcc 04scale.c -o 04scale -I /usr/include/X11 -lX11 -lXext -lm -lXpm

実行は以下。

./04scale

少し解説。

最初に処理を書いた時は、愚直に、1ドットずつ XCopyArea() を呼んでみたけれど、このやり方だと圧倒的に処理時間がかかってしまって話にならなかった。

/* slow */

for (y = 0; y < dst_h; y++)

{

int sy = (int)(y * yscale);

for (x = 0; x < dst_w; x++)

XCopyArea(dpy, *src, *dst, gc, (int)(x * xscale), sy, 1, 1, x, y);

}

そこでふと、xscreensaver のソース群の中で目にした処理を思い出した。一旦横方向にのみ引き延ばして、その横方向に引き延ばしたものを縦に引き延ばすというやり方。

/* fast */

for (x = dst_w - 1; x >= 0; x--)

XCopyArea(dpy, *src, *dst, gc, (int)(x * xscale), 0, 1, src_h, x, 0);

for (y = dst_h - 1; y >= 0; y--)

XCopyArea(dpy, *dst, *dst, gc, 0, (int)(y * yscale), dst_w, 1, 0, y);

後者は、前者と比べて圧倒的に速かった。時間を測定してみたところ、以下のような感じになった。

- slow result : 0.510753 sec

- fast result : 0.000045 sec

- CPU: AMD Ryzen 5 5600x

- OS: Ubuntu Linux 20.04 LTS (Windows10 x64 21H2 + VMware Player上で動作)

- 画面解像度 : 1920 x 1080

考えてみたら、例えば 1920x1080のサイズの場合、前者は XCopyArea() を 2073600回呼んでしまうけど、後者なら3000回呼ぶだけで済むわけで、そのあたりが効いてるのかなと。ただ、Pixmap へのアクセス回数は、横に引き延ばす段階が入ってくる分、増えてしまうはずなのだけど…。Xlib関係はCPUだけが必死に頑張って処理をしてるものと思い込んでたけど、もしかしてGPUが頑張ってる時もあるのだろうか。それとも、Pixmap間の転送は処理が速くなるように何か工夫してるのだろうか。

何にせよ、このぐらいの速さで拡大描画できるなら、一旦ファミコンレベルの解像度の画面を作っておいて、ソレをデスクトップ一杯に拡大描画しても、60FPS程度なら出せるかもしれない。大昔の2Dゲーム画面っぽいスクリーンセーバを作れそうな予感。

◎ 2022/06/05追記。 :

Ubuntu Linux 20.04 LTSの場合、xpm画像を扱う時は、libxpm-dev をインストールしておかないとコンパイルできない模様。

sudo apt install libxpm-dev

[ ツッコむ ]

2022/06/04(土) [n年前の日記]

#1 [xlib] Xlibについて勉強中その3

_昨日、

Pixmapを拡大縮小する関数を書いて実験していたけれど、本当に毎フレーム拡大縮小処理ができているのかが気になってきたので、見た目で分かるように処理を書き換えてみた。

環境は、Ubuntu Linux 20.04 LTS。Windows10 x64 21H2 + VMware Player 上で動かしている。

結果はこんな感じに。それなりの速度で拡大縮小できていることが視覚的にも分かった。

環境は、Ubuntu Linux 20.04 LTS。Windows10 x64 21H2 + VMware Player 上で動かしている。

結果はこんな感じに。それなりの速度で拡大縮小できていることが視覚的にも分かった。

◎ ソース。 :

ソースは以下。

_06scale3.c

使用画像は以下。

_bg01.xpm

_bg02.xpm

Makefileの例。

_Makefile

コンパイルは以下。実行バイナリ 06scale3 が生成される。

実行は以下。

_06scale3.c

#include <stdio.h>

#include <stdlib.h>

#include <unistd.h>

#include <X11/Xlib.h>

#include <X11/xpm.h>

#include <math.h>

#include <time.h>

/* include xpm binary */

#include "bg01.xpm"

#define XPM_W 640

#define XPM_H 360

#define XPM_NAME bg01_xpm

/*

#include "bg02.xpm"

#define XPM_W 320

#define XPM_H 180

#define XPM_NAME bg02_xpm

*/

/* kind. 0: slow, 1: fast */

#define SCALING_KIND 1

#define WIN_X 0

#define WIN_Y 64

#define BORDER 0

#ifndef M_PI

#define M_PI 3.14159265358979

#endif

#define deg2rad(x) (x * M_PI / 180.0)

/* get a color value from a color name */

static unsigned long

get_color(Display *dpy, char *colorname)

{

Colormap cmap;

XColor near_color, true_color;

cmap = DefaultColormap(dpy, DefaultScreen(dpy));

XAllocNamedColor(dpy, cmap, colorname, &near_color, &true_color);

return near_color.pixel;

}

/* scale Pixmap */

static void

scale_pixmap(Display *dpy, Drawable win,

Pixmap *src, Pixmap *dst,

int src_w, int src_h, int dst_w, int dst_h)

{

GC gc;

float xscale, yscale;

int x, y;

struct timespec start, end;

double diff;

xscale = (float)src_w / dst_w;

yscale = (float)src_h / dst_h;

gc = XCreateGC(dpy, win, 0, 0);

XSetGraphicsExposures(dpy, gc, False);

timespec_get(&start, TIME_UTC);

switch (SCALING_KIND)

{

case 0:

/* slow */

for (y = 0; y < dst_h; y++)

{

int sy = (int)(y * yscale);

for (x = 0; x < dst_w; x++)

XCopyArea(dpy, *src, *dst, gc, (int)(x * xscale), sy, 1, 1, x, y);

}

break;

case 1:

/* fast */

for (x = dst_w - 1; x >= 0; x--)

XCopyArea(dpy, *src, *dst, gc, (int)(x * xscale), 0, 1, src_h, x, 0);

if (src_h <= dst_h)

{

for (y = dst_h - 1; y >= 0; y--)

XCopyArea(dpy, *dst, *dst, gc, 0, (int)(y * yscale), dst_w, 1, 0, y);

}

else

{

for (y = 0; y < dst_h; y++)

XCopyArea(dpy, *dst, *dst, gc, 0, (int)(y * yscale), dst_w, 1, 0, y);

}

break;

default:

break;

}

XFreeGC(dpy, gc);

timespec_get(&end, TIME_UTC);

diff = (end.tv_sec + (double)end.tv_nsec / 1000000000) - (start.tv_sec + (double)start.tv_nsec / 1000000000);

printf("%lf sec\n", diff);

}

/* update and draw */

static void

update(Display *dpy, Drawable win, GC gc,

Pixmap pix, Pixmap buf,

int new_w, int new_h)

{

XWindowAttributes xgwa;

int r, x, y;

int scrw, scrh;

/* get window attributes */

XGetWindowAttributes(dpy, win, &xgwa);

scrw = xgwa.width; /* window width */

scrh = xgwa.height; /* window height */

scale_pixmap(dpy, win, &pix, &buf, XPM_W, XPM_H, new_w, new_h);

/* centering */

x = scrw - ((scrw + new_w) / 2);

y = scrh - ((scrh + new_h) / 2);

/* clear window */

XClearWindow(dpy, win);

/* draw image (Pixmap) */

XSetGraphicsExposures(dpy, gc, False);

XCopyArea(dpy, buf, win, gc, 0, 0, new_w, new_h, x, y);

}

int main(void)

{

Display *dpy;

Window root;

Window win;

int screen;

int display_w, display_h;

XEvent evt;

unsigned long black, white;

XWindowAttributes xgwa;

GC gc;

Pixmap pix;

Pixmap buf;

int busy_loop;

double new_w, new_h;

double dx;

/* open display */

dpy = XOpenDisplay(NULL);

root = DefaultRootWindow(dpy);

screen = DefaultScreen(dpy);

/* get display size */

display_w = DisplayWidth(dpy, screen);

display_h = DisplayHeight(dpy, screen);

printf("Screen: %d x %d\n", display_w, display_h);

/* get color black and white */

white = WhitePixel(dpy, screen);

black = BlackPixel(dpy, screen);

/* create window */

win = XCreateSimpleWindow(dpy, root,

WIN_X, WIN_Y, display_w, display_h, BORDER,

white, black);

XSelectInput(dpy, win, KeyPressMask | ExposureMask);

XMapWindow(dpy, win);

/* wait display window */

do

{

XNextEvent(dpy, &evt);

} while (evt.type != Expose);

XMoveWindow(dpy, win, WIN_X, WIN_Y);

/* create graphics context */

gc = XCreateGC(dpy, win, 0, 0);

XSetGraphicsExposures(dpy, gc, False);

/* load image */

if (XpmCreatePixmapFromData(dpy, win, XPM_NAME, &pix, NULL, NULL))

{

fprintf(stderr, "Error not load xpm.");

return 1;

}

XSetForeground(dpy, gc, get_color(dpy, "green"));

XGetWindowAttributes(dpy, win, &xgwa);

buf = XCreatePixmap(dpy, win, display_w, display_h, xgwa.depth);

XFillRectangle(dpy, buf, gc, 0, 0, display_w, display_h);

new_w = display_w;

new_h = display_h;

dx = -6;

busy_loop = 1;

while (busy_loop)

{

/* event */

while (XPending(dpy))

{

XNextEvent(dpy, &evt);

switch (evt.type)

{

/*

case Expose:

if (evt.xexpose.count == 0)

{

}

break;

*/

case KeyPress:

busy_loop = 0;

break;

default:

break;

}

}

update(dpy, win, gc, pix, buf, new_w, new_h);

new_w += dx;

if (new_w <= 32)

{

new_w = 32;

dx *= -1;

}

if (new_w >= display_w)

{

new_w = display_w;

dx *= -1;

}

new_h = display_h * new_w / display_w;

XFlush(dpy);

usleep(16 * 1000); /* wait */

}

XFreePixmap(dpy, pix);

XFreePixmap(dpy, buf);

XFreeGC(dpy, gc);

XDestroyWindow(dpy, win);

XCloseDisplay(dpy);

return 0;

}

使用画像は以下。

_bg01.xpm

_bg02.xpm

Makefileの例。

_Makefile

コンパイルは以下。実行バイナリ 06scale3 が生成される。

gcc 06scale3.c -o 06scale3 -I /usr/include/X11 -lX11 -lXext -lm -lXpm

実行は以下。

./06scale3

◎ バグを見つけた。 :

_昨日、

書いた処理は、少しバグがあった。元画像より小さい縦サイズに縮小しようとすると、見た目がおかしなことになってしまう。

以下の処理では、(縦方向の)拡大はともかく、縮小はおかしなことになる。参照される部分を上書きコピーで破壊してしまう。

_05scale2.c

以下のように修正。拡大時と縮小時で処理を分けて、拡大時は下から上に向かってスキャン、縮小時は上から下に向かってスキャンしていけばおかしなことにはならない。

以下の処理では、(縦方向の)拡大はともかく、縮小はおかしなことになる。参照される部分を上書きコピーで破壊してしまう。

_05scale2.c

/* fast */

for (x = dst_w - 1; x >= 0; x--)

XCopyArea(dpy, *src, *dst, gc, (int)(x * xscale), 0, 1, src_h, x, 0);

for (y = dst_h - 1; y >= 0; y--)

XCopyArea(dpy, *dst, *dst, gc, 0, (int)(y * yscale), dst_w, 1, 0, y);

以下のように修正。拡大時と縮小時で処理を分けて、拡大時は下から上に向かってスキャン、縮小時は上から下に向かってスキャンしていけばおかしなことにはならない。

/* fast */

for (x = dst_w - 1; x >= 0; x--)

XCopyArea(dpy, *src, *dst, gc, (int)(x * xscale), 0, 1, src_h, x, 0);

if (src_h <= dst_h)

{

for (y = dst_h - 1; y >= 0; y--)

XCopyArea(dpy, *dst, *dst, gc, 0, (int)(y * yscale), dst_w, 1, 0, y);

}

else

{

for (y = 0; y < dst_h; y++)

XCopyArea(dpy, *dst, *dst, gc, 0, (int)(y * yscale), dst_w, 1, 0, y);

}

[ ツッコむ ]

#2 [nitijyou] 自転車でパソコン工房まで行ってきた

天気予報では、今日は雨が降らないとのことだったので、電動自転車に乗ってパソコン工房郡山店まで行ってきた。

新しい電動自転車を購入する際、郡山まで行ける程度のバッテリー容量が欲しいと要望を出したのだけど、その願いは叶ったのかどうかを一度確認してみたかった。ちなみに以前の電動自転車は、帰り道でバッテリーが切れて、しかも前輪駆動だったから、バッテリーが切れると鬼のようにペダルが重くなって地獄だった…。

一応、時間や、走った道をメモ。

09:46-10:42 (55分) : 家からパソコン工房まで、旧・旧国道沿い(須賀川-二本松線、県道355号)を移動。バッテリー残り90%の状態で出発。行きは、Autoモードで ―― アシストが弱いけれどバッテリーの持ちはそこそこらしいモードを利用。パソコン工房郡山店に着いた時点で残り80%。たった10%のバッテリー容量で移動できてしまって驚いた。以前の電動自転車とは違うな…。

ヨドバシカメラ郡山店に寄って、そこから帰ろうとした時点で、残り70%になった。

12:32-13:20 (47分) : ヨドバシカメラから安積永盛のHARD-OFFまで、旧・国道4号線(県道17号線、郡山の街中を通っている道路)を移動。店についてからタイマーを止めるのを忘れてたので、実際はもっと短いはず。

13:27-14:04 (36分) : HARD-OFFから家まで、現・国道4号線(バイパス)を移動。ここからはパワーモードで移動。家に到着した時点で残り60%。

つまり、行きは55分、帰りは83分かかった。ただ、帰りは、他の店に寄った上に、車向けの道を ―― 登ったり下りたりが頻繁にある道を選んで走ってきたので、単純に比較できない。

何にせよ、新しい電動自転車の、今現在のバッテリーの状態なら、バッテリーの1/3程度の容量で、郡山まで行って帰ってくることができると分かった。

ただ、体のほうが全然持たない。右膝が痛い…。行きの時点で、安積永盛のあたりで膝に違和感が…。バッテリーはともかく、自分の体の状態からして、気軽に行けるわけではないなと…。

新しい電動自転車を購入する際、郡山まで行ける程度のバッテリー容量が欲しいと要望を出したのだけど、その願いは叶ったのかどうかを一度確認してみたかった。ちなみに以前の電動自転車は、帰り道でバッテリーが切れて、しかも前輪駆動だったから、バッテリーが切れると鬼のようにペダルが重くなって地獄だった…。

一応、時間や、走った道をメモ。

09:46-10:42 (55分) : 家からパソコン工房まで、旧・旧国道沿い(須賀川-二本松線、県道355号)を移動。バッテリー残り90%の状態で出発。行きは、Autoモードで ―― アシストが弱いけれどバッテリーの持ちはそこそこらしいモードを利用。パソコン工房郡山店に着いた時点で残り80%。たった10%のバッテリー容量で移動できてしまって驚いた。以前の電動自転車とは違うな…。

ヨドバシカメラ郡山店に寄って、そこから帰ろうとした時点で、残り70%になった。

12:32-13:20 (47分) : ヨドバシカメラから安積永盛のHARD-OFFまで、旧・国道4号線(県道17号線、郡山の街中を通っている道路)を移動。店についてからタイマーを止めるのを忘れてたので、実際はもっと短いはず。

13:27-14:04 (36分) : HARD-OFFから家まで、現・国道4号線(バイパス)を移動。ここからはパワーモードで移動。家に到着した時点で残り60%。

つまり、行きは55分、帰りは83分かかった。ただ、帰りは、他の店に寄った上に、車向けの道を ―― 登ったり下りたりが頻繁にある道を選んで走ってきたので、単純に比較できない。

何にせよ、新しい電動自転車の、今現在のバッテリーの状態なら、バッテリーの1/3程度の容量で、郡山まで行って帰ってくることができると分かった。

ただ、体のほうが全然持たない。右膝が痛い…。行きの時点で、安積永盛のあたりで膝に違和感が…。バッテリーはともかく、自分の体の状態からして、気軽に行けるわけではないなと…。

◎ 余談。 :

帰りにHARD-OFFに寄ったけれど、相変わらずヨサゲなPCケースが見当たらなくて残念。通販なら新品でも、一番安いミニタワーPCケースなら3,000円ぐらいで買えるけど。見た目が傷だらけで、今となっては巨大に感じるミドルタワーATXケースで、フロントベイカバーがポツポツ無くなっている中古のケースが3,300円とか5,500円では…。なかなか厳しい。

[ ツッコむ ]

#3 [pc] パソコン工房の買取サービスを利用してみた

パソコン工房郡山店の店頭で、買取サービスを初めて利用してみた。一応、流れをメモ。

今回持ち込んだ品は以下の3点。

レジの前で「こちらの店舗で買取サービスはしてますか?」と尋ねたところ、店員さんが買取用カウンターに誘導してくれた。担当者が不在だったけれど、用紙を渡されて記入。名前、生年月日、住所、電話番号、職業、を書いた気がする。

10:47頃に受け付け。「査定に1時間ほどかかる」と言われた。「11:47〜」とメモされた、申し込み用紙の控えを渡された。

店内をウロウロしたり、隣のダイソーで買い物を済ませたりして時間を潰した。

11:47頃、買取サービス用カウンターの前に行った。今度は担当者が居たようで、査定内容が印刷された用紙を見せられつつ、査定額を伝えられた。それでいいですと答えたら、担当の方がそこから5分ほどPCに何かを入力。その後、譲渡証明書の控えと、現金を受け取った。

買取金額は以下。

今回持ち込んだ品は以下の3点。

- CPU AMD Ryzen 7 1700 BOX

- CPU AMD Ryzen 3 2200G BOX

- DDR4-2400メモリ 8GB x 2枚。パッケージ付き

レジの前で「こちらの店舗で買取サービスはしてますか?」と尋ねたところ、店員さんが買取用カウンターに誘導してくれた。担当者が不在だったけれど、用紙を渡されて記入。名前、生年月日、住所、電話番号、職業、を書いた気がする。

10:47頃に受け付け。「査定に1時間ほどかかる」と言われた。「11:47〜」とメモされた、申し込み用紙の控えを渡された。

店内をウロウロしたり、隣のダイソーで買い物を済ませたりして時間を潰した。

11:47頃、買取サービス用カウンターの前に行った。今度は担当者が居たようで、査定内容が印刷された用紙を見せられつつ、査定額を伝えられた。それでいいですと答えたら、担当の方がそこから5分ほどPCに何かを入力。その後、譲渡証明書の控えと、現金を受け取った。

買取金額は以下。

- Ryzen 7 1700 BOX : 7,700円

- Ryzen 3 2200G BOX : 6,600円

- DDR4-2400 8GBx2メモリ : 1,870円

- 合計 16,170円

◎ 余談。 :

相場より高いのか、それとも安いのか、そのあたりはよく分からない…。譲渡証明書の控えに査定内容が書いてあるのだけど、読み方が分からなくて…。Ryzen 3 2200G が特に分からない。買取基準金額と買取査定額が1,000円と書かれてるけど、最後の品目名で6,600円になってる。最初に1,000円の記述が目に入って、「え。そんなに低いの」と驚いてしまったけど、そういうわけではなかったらしい。

質問したかったけれど、後ろに他の買取客が並んでたので、迷惑になったらいかんよなと、質問しないまま店を出た。ただ、ちょっともやもやする…。自分はちゃんと奇麗な状態で持ち込めたのか、そうでもなかったのか等々、一言二言でいいから聞いておきたかったなと…。

譲渡証明書には「Sofmap U-FRONT」と書かれてた。パソコン工房の実店舗で買取してるけど、パソコン工房が買取してるわけではないということだろうか。パソコン工房の買取なら、土日祝日は買取価格上乗せ云々とサイトに書いてあったけど、郡山店ではSofmapの買取サービスを提供してるからそういうオマケは無し、ということかもしれない。

持ち込む前は、やれここが汚れてるだのなんだの言われて、下手すると全部合わせても3千円にすらならないのではと結構不安だったけど。パソコン工房やドスパラのサイトで確認した際の額と大体似たような結果になってホッとした。わざわざIPAやキムワイプを新規購入して掃除した甲斐はあった…のかどうかそのあたり結局何も分からないままだけど、まあ、結果には満足。

もっとも、この額では現行CPUの最低ランク品すら購入できないわけで、以前、弟が、「PCパーツを買取サービスに持ち込むぐらいなら欲しい人にタダでプレゼントしたほうがマシ」と言った感覚も、なんだかちょっと分かったような気もする。

とは言え今回、M/Bさえあれば手元に残してサブPC用として使っただろうけど、空いてる Socket AM4対応M/Bは無く、このままだとCPUもメモリも使われないまま埃を被ってしまうので、だったら別の誰かの手に渡ったほうが、と思った次第。

質問したかったけれど、後ろに他の買取客が並んでたので、迷惑になったらいかんよなと、質問しないまま店を出た。ただ、ちょっともやもやする…。自分はちゃんと奇麗な状態で持ち込めたのか、そうでもなかったのか等々、一言二言でいいから聞いておきたかったなと…。

譲渡証明書には「Sofmap U-FRONT」と書かれてた。パソコン工房の実店舗で買取してるけど、パソコン工房が買取してるわけではないということだろうか。パソコン工房の買取なら、土日祝日は買取価格上乗せ云々とサイトに書いてあったけど、郡山店ではSofmapの買取サービスを提供してるからそういうオマケは無し、ということかもしれない。

持ち込む前は、やれここが汚れてるだのなんだの言われて、下手すると全部合わせても3千円にすらならないのではと結構不安だったけど。パソコン工房やドスパラのサイトで確認した際の額と大体似たような結果になってホッとした。わざわざIPAやキムワイプを新規購入して掃除した甲斐はあった…のかどうかそのあたり結局何も分からないままだけど、まあ、結果には満足。

もっとも、この額では現行CPUの最低ランク品すら購入できないわけで、以前、弟が、「PCパーツを買取サービスに持ち込むぐらいなら欲しい人にタダでプレゼントしたほうがマシ」と言った感覚も、なんだかちょっと分かったような気もする。

とは言え今回、M/Bさえあれば手元に残してサブPC用として使っただろうけど、空いてる Socket AM4対応M/Bは無く、このままだとCPUもメモリも使われないまま埃を被ってしまうので、だったら別の誰かの手に渡ったほうが、と思った次第。

[ ツッコむ ]

#4 [pc] USB2.0ハブを購入

ヨドバシカメラ郡山店でUSB2.0ハブを購入。

_4ポートUSB2.0ハブ ホワイト | ナカバヤシ株式会社

値札は\485-だったのだけど、レジに持っていったら580円と言われて困惑。さては税抜き価格の値札だったかと、その場では思いながらそのまま帰ってきてしまったけれど、帰宅後、ヨドバシのサイトで確認したら580円だった。この値段で正しいらしい。もしかすると値札が古いままだったのかもしれない。店頭で購入するとこういうことがあるのだな。今後は極力、店頭では買わないようにしようか…。もっとも、初期不良品に当たった時のことを考えたら、件の店舗は距離的に遠いので、そもそもそこで買うのはマズかった気もする。今回ちょっと考え無しだったかも。

メインPCの背面に差して、キーボードとプリンタを接続して動作確認したが、どちらも問題無く動いてくれた。これで、現在使用しているM/B、GIGABYTE B450M S2H rev.1.0 の、USB2.0ポートが不足している問題は解決できそう。

ただ、USB2.0ハブごと抜けて動作がおかしくなる可能性はあるなと。キーボードやプリンタの動作がおかしくなったらUSBハブの差し込み具合を確認のこと>未来の自分。まあ、そのうち絶対忘れてドタバタしそうだな…。

- ナカバヤシ株式会社 Digio2 UH-2354W (USB2.0対応、4port、バスパワー、ケーブル長10cm、W15 x D93 x H13mm, 20g)。580円。

_4ポートUSB2.0ハブ ホワイト | ナカバヤシ株式会社

値札は\485-だったのだけど、レジに持っていったら580円と言われて困惑。さては税抜き価格の値札だったかと、その場では思いながらそのまま帰ってきてしまったけれど、帰宅後、ヨドバシのサイトで確認したら580円だった。この値段で正しいらしい。もしかすると値札が古いままだったのかもしれない。店頭で購入するとこういうことがあるのだな。今後は極力、店頭では買わないようにしようか…。もっとも、初期不良品に当たった時のことを考えたら、件の店舗は距離的に遠いので、そもそもそこで買うのはマズかった気もする。今回ちょっと考え無しだったかも。

メインPCの背面に差して、キーボードとプリンタを接続して動作確認したが、どちらも問題無く動いてくれた。これで、現在使用しているM/B、GIGABYTE B450M S2H rev.1.0 の、USB2.0ポートが不足している問題は解決できそう。

ただ、USB2.0ハブごと抜けて動作がおかしくなる可能性はあるなと。キーボードやプリンタの動作がおかしくなったらUSBハブの差し込み具合を確認のこと>未来の自分。まあ、そのうち絶対忘れてドタバタしそうだな…。

[ ツッコむ ]

2022/06/05(日) [n年前の日記]

#1 [xlib] Xlibでラスタースクロールっぽい処理

_昨日、

_一昨日

と、Xlib を使って小さい画面(Pixmap)をディスプレイ一杯に拡大して描画できるか試してたけど、小さい画面を対象にして処理するならラスタースクロールっぽい処理もできるかなと思えてきたので試してみた。

環境は、Ubuntu Linux 20.04 LTS。Windows10 x64 21H2 + VMware Player 上で動かしている。

こんな感じになった。

動画の解像度が小さくて見辛いかもしれんけど、画面下半分がチラチラと動いてることぐらいは分かるかなと。元画面は640x360で、ディスプレイ解像度は1440x900。

環境は、Ubuntu Linux 20.04 LTS。Windows10 x64 21H2 + VMware Player 上で動かしている。

こんな感じになった。

動画の解像度が小さくて見辛いかもしれんけど、画面下半分がチラチラと動いてることぐらいは分かるかなと。元画面は640x360で、ディスプレイ解像度は1440x900。

◎ ソース。 :

ソースと使用画像は以下。

_08rasterscroll.c

_bg03.xpm.txt

コンパイルは以下。

実行は以下。

ラスタースクロールと言っても、あくまでモドキで…。画面の下半分は、元画像を参照する際のx座標をcos()で変化させて、縦幅1ドットずつ、Pixmap から Pixmap にコピーしてるだけ。

元画像は、640x360の左右に32ドットずつ足して、704x360で作成。左右にcos()で揺らして描画するので、横640ドットぴったりで作ってしまうと描画されない部分が出てきてしまう。左右に少しだけ絵を追加しておかないといけない。

_08rasterscroll.c

_bg03.xpm.txt

コンパイルは以下。

gcc 08rasterscroll.c -o 08rasterscroll -I /usr/include/X11 -lX11 -lXext -lm -lXpm

実行は以下。

./08rasterscroll

ラスタースクロールと言っても、あくまでモドキで…。画面の下半分は、元画像を参照する際のx座標をcos()で変化させて、縦幅1ドットずつ、Pixmap から Pixmap にコピーしてるだけ。

元画像は、640x360の左右に32ドットずつ足して、704x360で作成。左右にcos()で揺らして描画するので、横640ドットぴったりで作ってしまうと描画されない部分が出てきてしまう。左右に少しだけ絵を追加しておかないといけない。

[ ツッコむ ]

#2 [linux][windows] pecoの代わりにfzyを使ってみた

Windows10 x64 21H2 + MSYS2上で peco を使おうとしたけれど動いてくれなかった。ググってみたら MSYS2上で(というか mintty上で?) peco は動かないらしい。ただ、peco の代わりに fzy というツールが使えるという話を見かけたので導入してみた。

余談。pecoについては以下でメモしてあった。

_mieki256's diary - pecoを導入してみた

余談。pecoについては以下でメモしてあった。

_mieki256's diary - pecoを導入してみた

◎ 使い方。 :

- pcd add . : カレントディレクトリを登録リストに追加。

- pcd edit : 登録リストファイルを編集。

- pcd : 登録リストからインクリメンタルサーチで絞り込んでディレクトリ移動。

- cdp : カレントディレクトリ内からインクリメンタルサーチで絞り込んでディレクトリ移動。

◎ インストール。 :

pacman -S fzy

$ fzy --version fzy 1.0 (C) 2014-2018 John Hawthorn

◎ pcdをインストール。 :

pcd を使えば、自分で登録したディレクトリリストをインクリメンタルサーチで絞り込んでディレクトリ移動ができる。

登録リストファイル、~/.peco/.peco-cd ファイルを作成。

~/.bash_pcd を作成。以下を記述。

~/.bashrc に以下を追記。~/.bash_pcd が存在していたら読み込むようにする。

source ~/.bashrc で反映。

登録リストファイル、~/.peco/.peco-cd ファイルを作成。

mkdir ~/.peco touch ~/.peco/.peco-cd

~/.bash_pcd を作成。以下を記述。

- peco を呼び出している場所で fzy を呼ぶように変更。

- pcd edit と打った際は nanoエディタを呼び出すように変更。

function pcd() {

local PCD_FILE=$HOME/.peco/.peco-cd

local PCD_RETURN

if [ $1 ] && [ $1 = "add" ]; then

if [ $2 ]; then

ADD_DIR=$2

if [ $2 = "." ]; then

ADD_DIR=$(pwd)

fi

echo "add $ADD_DIR to $PCD_FILE"

echo $ADD_DIR >> $PCD_FILE

fi

elif [ $1 ] && [ $1 = "edit" ]; then

if [ $EDITOR ]; then

$EDITOR $PCD_FILE

else

# editor $PCD_FILE

nano $PCD_FILE

fi

elif [ $1 ] && [ $1 = "." ]; then

PCD_RETURN=$(/bin/ls -F | grep /$ | fzy -l 20)

else

PCD_RETURN=$(cat $PCD_FILE | fzy -l 20)

fi

if [ $PCD_RETURN ]; then

cd $PCD_RETURN

fi

}

function cdp {

local dir="$( find . -maxdepth 1 -type d | sed -e 's;\./;;' | sort | fzy -l 20 )"

if [ ! -z "$dir" ] ; then

cd "$dir"

fi

}

~/.bashrc に以下を追記。~/.bash_pcd が存在していたら読み込むようにする。

if [ -f "${HOME}/.bash_pcd" ]; then

source "${HOME}/.bash_pcd"

fi

source ~/.bashrc で反映。

◎ 参考ページ。 :

[ ツッコむ ]

#3 [zatta] ユニクロで買い物をして驚いた

ユニクロに寄ってTシャツを買ってきたのだけど、初めてセルフレジを使ってみて驚いてしまった。商品を指定の場所に置いただけで、何点置かれてるか、何が置かれてるかが自動で液晶画面に出てきて、「えっ。なんで?」と。これどうやってるんだ…。バーコードをあらゆる方向から読み取ってるんだろうか。いや、でも、バーコードが必ず見えるような状態で置いてなかったと思うけど…。もしかして、魔法…?

夕食時にその話をしたところ、妹曰く「ICタグが導入されてる」「特許絡みで裁判になってた」とのことで。

_ユニクロの「レジ待ち行列」を解消したRFIDタグの威力 | Agenda note (アジェンダノート)

_ユニクロだからできるRFIDタグの破壊力 | GASKET

_ユニクロを特許侵害で訴えた下請け社長語る「ゼロ円でライセンスを要求された」 | Close-Up Enterprise | ダイヤモンド・オンライン

_ユニクロのセルフレジ特許権侵害訴訟を現状整理する 知財高裁で勝っても戦況が明るくない理由(1/2 ページ) - ITmedia NEWS

_ユニクロのセルフレジ特許侵害訴訟、和解へ 互いに訴訟・請求を取り下げ - ITmedia NEWS

_RFID - Wikipedia

RFID/RFIDタグなる技術があるのか…。ゴミ箱に捨ててしまったタグを発掘して光に透かしてみたら、たしかに何かが中に入ってた。スゴイな…。「今頃知ったのかよ」と笑われそうだけど、勉強になりました。あまりに驚いてしまったので、こうしてメモ。

夕食時にその話をしたところ、妹曰く「ICタグが導入されてる」「特許絡みで裁判になってた」とのことで。

_ユニクロの「レジ待ち行列」を解消したRFIDタグの威力 | Agenda note (アジェンダノート)

_ユニクロだからできるRFIDタグの破壊力 | GASKET

_ユニクロを特許侵害で訴えた下請け社長語る「ゼロ円でライセンスを要求された」 | Close-Up Enterprise | ダイヤモンド・オンライン

_ユニクロのセルフレジ特許権侵害訴訟を現状整理する 知財高裁で勝っても戦況が明るくない理由(1/2 ページ) - ITmedia NEWS

_ユニクロのセルフレジ特許侵害訴訟、和解へ 互いに訴訟・請求を取り下げ - ITmedia NEWS

_RFID - Wikipedia

RFID/RFIDタグなる技術があるのか…。ゴミ箱に捨ててしまったタグを発掘して光に透かしてみたら、たしかに何かが中に入ってた。スゴイな…。「今頃知ったのかよ」と笑われそうだけど、勉強になりました。あまりに驚いてしまったので、こうしてメモ。

[ ツッコむ ]

2022/06/06(月) [n年前の日記]

#1 [python] ファイルサイズでソートしてリネームするPythonスクリプトを作成

複数の画像ファイルに対して、手作業でリネームしていく作業が面倒臭くなってきたので、自動化すべくPythonスクリプトを書いた。hoge_1920x1080_[0-9]_*.jpg というファイル群に対し、ファイルサイズを元にしてリネームしていくスクリプト。以下のような感じでリネームする。

動作確認環境は、Windows10 x64 21H2 + Python 3.9.13 64bit。

まあ、自分しか使わない・使えないスクリプトだけど、その手の処理の参考事例になりそうな気もするし、一応メモ。

_sortrename.py

python sortrename.py PATH0 PATH1 PATH2

hoge_1920x1080_2_.jpg -> hoge_1920x1080_2.jpg hoge_1920x1080_2.jpg -> hoge_1920x1080_3.jpg hoge_1920x1080_3.jpg -> hoge_1920x1080_4.jpg

動作確認環境は、Windows10 x64 21H2 + Python 3.9.13 64bit。

まあ、自分しか使わない・使えないスクリプトだけど、その手の処理の参考事例になりそうな気もするし、一応メモ。

_sortrename.py

import sys

import os

import re

def main():

renamelist = []

cnt = len(sys.argv)

if cnt <= 2:

print("Error : Please select two or more files.")

else:

lst = []

for i in range(1, cnt):

path = sys.argv[i]

size = os.path.getsize(path)

lst.append([path, size])

slist = sorted(lst, key=lambda x: x[1])

count = len(slist) + 1

for v in slist:

path, size = v

dirname = os.path.dirname(path)

filename = os.path.basename(path)

newfile = re.sub("_\d_*\.jpg", "_%d.jpg" % count, filename)

newpath = os.path.join(dirname, newfile)

print("%s -> %s : %d byte" % (filename, newfile, size))

renamelist.append([path, newpath])

count -= 1

if len(renamelist) >= 1:

v = input("\nRename ? (Y/n)")

if v == "y" or v == "Y" or v == "":

for v in renamelist:

oldpath, newpath = v

os.rename(oldpath, newpath)

print("\n%d file renamed." % len(renamelist))

else:

print("\nCancel.")

v = input("\nPush any key")

if __name__ == '__main__':

main()

- コマンドライン引数を取得 : import sys をしてから sys.argv を参照

- コマンドライン引数の個数を取得 : len(sys.argv)

- python hoge.py で実行した場合、sys.argv[0] には "hoge.py" が入る。

- ファイルサイズ取得 : import os をしてから os.path.getsize(PATH)

- ソート : sorted(リスト)

- 指定のキーでソート : sorted(リスト, key=lambda x: x[1])

- パスからディレクトリ名を取得: os.path.dirname(PATH)

- パスからファイル名を取得 : os.path.basename(PATH)

- パスの結合 : os.path.join(ディレクトリ名, ファイル名)

- 正規表現で置換 : import re してから re.sub(置換前, 置換後, 文字列)

- ファイルリネーム : os.rename(元ファイル名, リネーム名)

- キー入力 : v = input("hoge")

◎ 2022/06/07追記。 :

このスクリプトは、リネーム後のファイル名が既に存在していた場合、妙な動作になりそうだなと気づいた。おそらく、「リネームできねえよ」とエラーを出しそうな気もするけど…。一旦、重複しないであろう仮ファイル名でリネームしておいて、そこから本当に変更したいファイル名にリネームしたほうがいいのかもしれない。元ファイル名と新ファイル名の他に、仮ファイル名も作ってリストに入れておけば処理ができそう。

[ ツッコむ ]

2022/06/07(火) [n年前の日記]

#1 [moho] Moho 13.5.5が公開されたっぽい

_Moho 13.5.5 is available. Update now! - Moho Forum

Windows版のインストーラ、Moho1355_Win.exe をDLして実行してみたところ、Moho 13.5.4 に対して上書きアップデートできた。

修正内容は…相対パスが云々と書いてあるような…よく分からん…。

Windows版のインストーラ、Moho1355_Win.exe をDLして実行してみたところ、Moho 13.5.4 に対して上書きアップデートできた。

修正内容は…相対パスが云々と書いてあるような…よく分からん…。

[ ツッコむ ]

#2 [linux][ubuntu] VMware Player上のUbuntuにディスプレイ解像度を追加したい

Windows10 x64 21H2 + VMware Player上で Ubuntu Linux 20.04 LTS + Xfce4 を動かして色々実験してるけど、画面解像度を 1600x900 (16:9) にしたいなと。しかし、Ubuntu のディスプレイ設定で選べるリストの中に、1600x900の解像度は無い。そんなわけで、追加する方法をググって試してみた。

◎ 参考ページ。 :

_Set guest client area to 1600 x 900 (exact resolut... - VMware Technology Network VMTN

_Custom resolution in monitor configuration - KDE Community Forums

_xfce:xfce4-settings:display [Xfce Docs]

_Ubuntuディスプレイ解像度を自動で1920x1080に変更させる - BioErrorLog Tech Blog

_Custom resolution in monitor configuration - KDE Community Forums

_xfce:xfce4-settings:display [Xfce Docs]

_Ubuntuディスプレイ解像度を自動で1920x1080に変更させる - BioErrorLog Tech Blog

◎ 設定手順。 :

どうやら、cvt でパラメータを調べて、xrandr で解像度を追加すればいいらしい。

これで、ディスプレイ設定の解像度のリストの中に 1600x900 が増えて、1600x900を選んで「適用」をクリックしたら、それらしい解像度に変わってくれた。

ただ、OSを再起動すると設定は消えてしまう。

/etc/profile.d/ 以下に 何かしらの .sh を作成しておいて、そこに xrandr --newmode ... と xrandr --addmode ... を記述しておくことで、起動時から該当解像度を有効にしておくことができるらしい。

試しに、mydisplay.sh というファイルを作成して、そこに前述の内容を記述してみた。

Ubuntu 再起動後も 1600x900 が選べるようになった。

cvt 1600 900 59 or cvt 1600 900

$ cvt 1600 900 59 # 1600x900 58.93 Hz (CVT) hsync: 55.04 kHz; pclk: 116.25 MHz Modeline "1600x900_59.00" 116.25 1600 1696 1856 2112 900 903 908 934 -hsync +vsync $ cvt 1600 900 # 1600x900 59.95 Hz (CVT 1.44M9) hsync: 55.99 kHz; pclk: 118.25 MHz Modeline "1600x900_60.00" 118.25 1600 1696 1856 2112 900 903 908 934 -hsync +vsync

xrandr --newmode "1600x900" 116.25 1600 1696 1856 2112 900 903 908 934 -hsync +vsync or xrandr --newmode "1600x900" 118.25 1600 1696 1856 2112 900 903 908 934 -hsync +vsync

xrandr --addmode Virtual1 "1600x900"

これで、ディスプレイ設定の解像度のリストの中に 1600x900 が増えて、1600x900を選んで「適用」をクリックしたら、それらしい解像度に変わってくれた。

ただ、OSを再起動すると設定は消えてしまう。

/etc/profile.d/ 以下に 何かしらの .sh を作成しておいて、そこに xrandr --newmode ... と xrandr --addmode ... を記述しておくことで、起動時から該当解像度を有効にしておくことができるらしい。

試しに、mydisplay.sh というファイルを作成して、そこに前述の内容を記述してみた。

sudo vi /etc/profile.d/mydisplay.sh

xrandr --newmode "1600x900" 118.25 1600 1696 1856 2112 900 903 908 934 -hsync +vsync xrandr --addmode Virtual1 "1600x900"

Ubuntu 再起動後も 1600x900 が選べるようになった。

[ ツッコむ ]

2022/06/08(水) [n年前の日記]

#1 [xlib] Xlibでタイルマップを描画

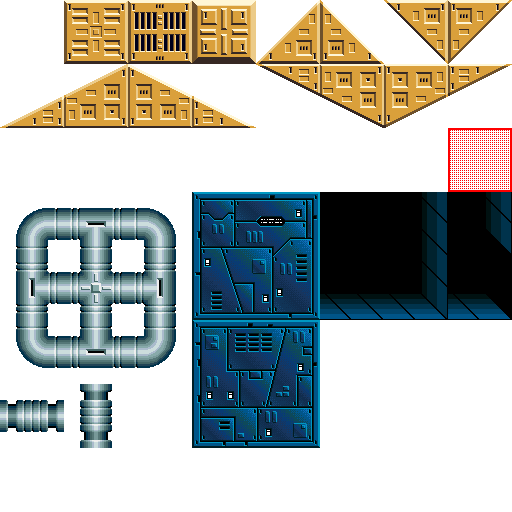

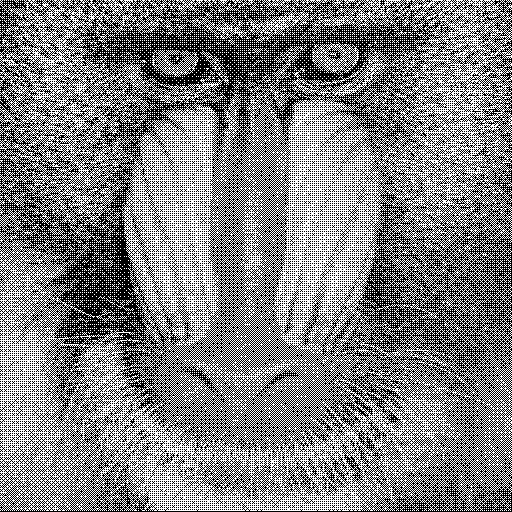

Xlibを使ってタイルマップ描画ができるか試してみた。タイルマップ描画ができれば、一気に2Dゲーム風の画面になる。はず。たぶん。おそらく。

環境は、Ubuntu Linux 20.04 LTS。Windows10 x64 21H2 + VMware Player 16.2.3 build-19376536 上で動かしてる。

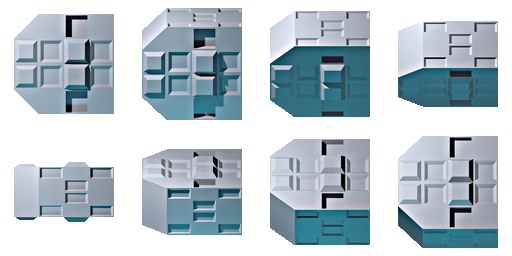

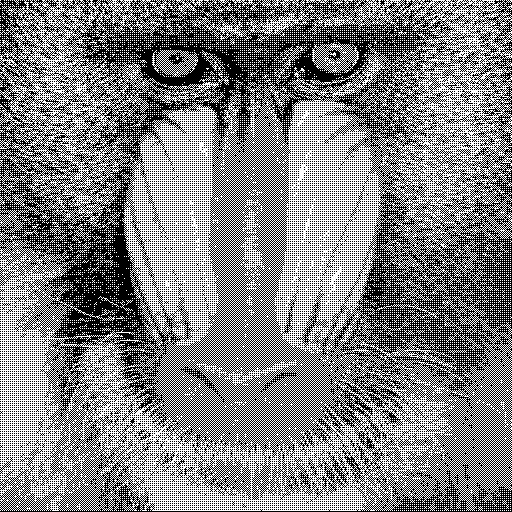

こんな感じになった。

元画面は640x360。それを、ディスプレイ解像度 1440x900に拡大して描画してる。

BG相当を3枚も描画できれば、2Dゲーム風の画面を作るには十分過ぎるかなと。ファミコンやPCエンジンならBGが1面、メガドライブでもBGが2面だったし。

スーファミ(SFC)は何枚まで出せたんだろう。ググってみたらMode0からMode7まであったみたいだけど。Mode0が4枚まで出せたと書いてあるな…。ただ、1パレットが4色か…。

_Super Nintendo Entertainment System - Wikipedia

環境は、Ubuntu Linux 20.04 LTS。Windows10 x64 21H2 + VMware Player 16.2.3 build-19376536 上で動かしてる。

こんな感じになった。

元画面は640x360。それを、ディスプレイ解像度 1440x900に拡大して描画してる。

BG相当を3枚も描画できれば、2Dゲーム風の画面を作るには十分過ぎるかなと。ファミコンやPCエンジンならBGが1面、メガドライブでもBGが2面だったし。

スーファミ(SFC)は何枚まで出せたんだろう。ググってみたらMode0からMode7まであったみたいだけど。Mode0が4枚まで出せたと書いてあるな…。ただ、1パレットが4色か…。

_Super Nintendo Entertainment System - Wikipedia

◎ ソース。 :

ソースと使用画像は以下。

_09tilemap1.c

_scifi_bg_chip.xpm

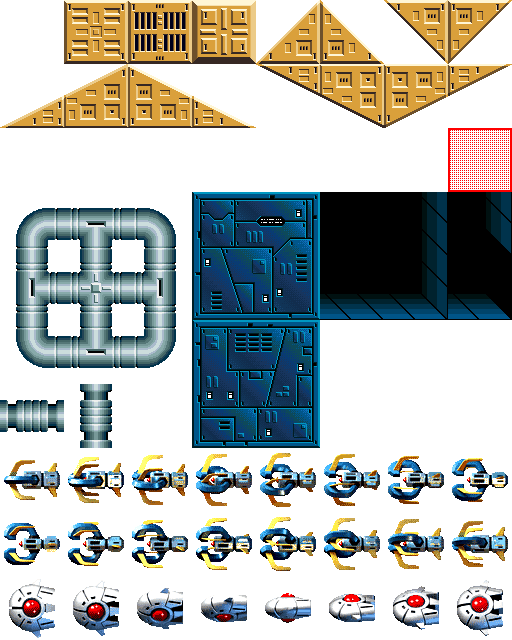

一応、元画像(.png)も置いておきます。CC0 / Public Domain ってことで自由に使ってください。1チップ(1タイル) 64x64ドットが、8x8個並んでます。インデックスカラー画像、48色。だったはず。たぶん。

_scifi_bg_chip.png

コンパイルは以下。

実行は以下。

少し解説。

今回、今までのソースと違って、State という構造体を定義して、処理で利用する変数を全部その State の中に入れることにした。各関数に引数を渡すあたりの記述が面倒臭かったので、State のポインタを渡して全部の変数にアクセスできるようにしてしまえ、みたいな。

1枚の xpm を分割して複数の Pixmap を作るあたりは、split_pixmaps() という関数で処理してる。

ちょっとハマった点。マスク用のPixmapをコピー(XCopyArea)する時は、マスク用のGCを別途用意しないといけない。そのあたりを知らなかったもので、RGB部分とマスク部分の両方を同じGCで処理しようとして、エラーが出て悩んでしまった。RGB部分を持ってる Pixmap と、マスク用の Pixmap は深度(Depth)が違うので、GCも深度別に用意しないといけないのだとか。

タイルマップを描画するあたりは、draw_tilemap() で処理してる。

本来、この手の処理は、BG用の大きなバッファ(Pixmap)を用意しておいて、スクロールに応じて書き換えが必要な場所だけ書き換えて、そのBG用の大きなバッファをソースにして表示用バッファに描画、といった処理をしたほうが速度は稼げるのだけど。今回は面倒臭かったので、毎フレーム、愚直に、チップ(タイル)を何十個も描画し直すやり方を選んでしまった。まあ、これはこれで、BGのアニメーションはしやすかったりもするけれど…。

余談。タイルマップ用のデータは、Tiled 1.8.5 64bit版を使わせてもらいました。ありがたや。

_Tiled | Flexible level editor

ちなみに、Tiled から json でエクスポートするとタイル番号は1から始まるけれど、csv でエクスポートするとタイル番号は0から始まるのですな…。知らなかった…。

_09tilemap1.c

_scifi_bg_chip.xpm

一応、元画像(.png)も置いておきます。CC0 / Public Domain ってことで自由に使ってください。1チップ(1タイル) 64x64ドットが、8x8個並んでます。インデックスカラー画像、48色。だったはず。たぶん。

_scifi_bg_chip.png

コンパイルは以下。

gcc 09tilemap1.c -o 09tilemap1 -I /usr/include/X11 -lX11 -lXext -lm -lXpm

実行は以下。

./09tilemap1

少し解説。

今回、今までのソースと違って、State という構造体を定義して、処理で利用する変数を全部その State の中に入れることにした。各関数に引数を渡すあたりの記述が面倒臭かったので、State のポインタを渡して全部の変数にアクセスできるようにしてしまえ、みたいな。

1枚の xpm を分割して複数の Pixmap を作るあたりは、split_pixmaps() という関数で処理してる。

ちょっとハマった点。マスク用のPixmapをコピー(XCopyArea)する時は、マスク用のGCを別途用意しないといけない。そのあたりを知らなかったもので、RGB部分とマスク部分の両方を同じGCで処理しようとして、エラーが出て悩んでしまった。RGB部分を持ってる Pixmap と、マスク用の Pixmap は深度(Depth)が違うので、GCも深度別に用意しないといけないのだとか。

タイルマップを描画するあたりは、draw_tilemap() で処理してる。

本来、この手の処理は、BG用の大きなバッファ(Pixmap)を用意しておいて、スクロールに応じて書き換えが必要な場所だけ書き換えて、そのBG用の大きなバッファをソースにして表示用バッファに描画、といった処理をしたほうが速度は稼げるのだけど。今回は面倒臭かったので、毎フレーム、愚直に、チップ(タイル)を何十個も描画し直すやり方を選んでしまった。まあ、これはこれで、BGのアニメーションはしやすかったりもするけれど…。

余談。タイルマップ用のデータは、Tiled 1.8.5 64bit版を使わせてもらいました。ありがたや。

_Tiled | Flexible level editor

ちなみに、Tiled から json でエクスポートするとタイル番号は1から始まるけれど、csv でエクスポートするとタイル番号は0から始まるのですな…。知らなかった…。

◎ Core2Duo機でも動作確認してみた。 :

Intel Core2Duo E8400 (2コア, 3.0GHz) + NVIDIA GeForce 9500GT + Ubuntu Linux 20.04 LTS、ディスプレイ解像度 1920x1200 の環境でも動作確認してみた。今となっては非力なCPU+GPUのはずだけど、それでも大体 3〜 5msec で動いてたので、この程度の描画処理なら60FPSで動かせそうな気配がする。

もっとも、Ryzen 5 5600X + VMware Player + Ubuntu Linux 20.04 LTS、ディスプレイ解像度 1920x1080 では 0.9〜1.1msec で動いたので、Ryzen 5 5600X と比べると Core2Duo E8400 は 1/5 の速度、ということになるのだろうか。いやまあ、仮想PC上ではなくて実機上で動かしたら、また違う処理時間になるかもしれないけど。

もっとも、Ryzen 5 5600X + VMware Player + Ubuntu Linux 20.04 LTS、ディスプレイ解像度 1920x1080 では 0.9〜1.1msec で動いたので、Ryzen 5 5600X と比べると Core2Duo E8400 は 1/5 の速度、ということになるのだろうか。いやまあ、仮想PC上ではなくて実機上で動かしたら、また違う処理時間になるかもしれないけど。

◎ OpenGLを使うべきだろうか。 :

Xlib についてググったら、1985年頃に登場したものらしくて。

_Xlib - Wikipedia

そんなに古いライブラリ(?)を使ってもこのくらいの描画はできるのだな、という感想を持ったけれど、さすがにこういう感じの描画をしたいなら OpenGL だか glx だかを使うべきなのでは、という気もしてきた。

_GLX - Wikipedia

xscreensaver のドキュメント内でも、「高速な描画をしたいなら OpenGL/glx を使うことを検討すべきやで」みたいなことが書いてあった気もするし。

_Xlib - Wikipedia

そんなに古いライブラリ(?)を使ってもこのくらいの描画はできるのだな、という感想を持ったけれど、さすがにこういう感じの描画をしたいなら OpenGL だか glx だかを使うべきなのでは、という気もしてきた。

_GLX - Wikipedia

xscreensaver のドキュメント内でも、「高速な描画をしたいなら OpenGL/glx を使うことを検討すべきやで」みたいなことが書いてあった気もするし。

[ ツッコむ ]

#2 [pc] キーボードのキーを押しても電源がONにならない

メインPCの電源スイッチの塗装が微妙に剥げてきた。つまりはそれだけ何回も、電源スイッチを押してるわけで、これはなんだかちょっとアレだなと。

そこで、キーボードを押したら電源が入るようにできないかと思い立った。メインPCのM/B、GIGABYTE B450M S2H (rev. 1.x) のBIOS設定画面を表示して、該当項目を有効にしてみた。

しかし、キーボードを押しても電源が入らない。何故。USBハブを介して接続しているせいだろうか。

であれば、M/Bに直接接続しているマウスならどうだろう。マウスのダブルクリックをしたら電源が入るようにBIOS設定を変えてみた。しかし、こちらも効果無し。

ググってみたら、おそらくだけど理由が分かってきた。

_[マザーボード] BIOS設定で「PS/2キーボードによる電源オン」を有効にする方法 | サポート 公式 | ASUS 日本

_価格.com - 『キーボードからの電源ON』 GIGABYTE GA-EP35-DS3R Rev.2.1 のクチコミ掲示板

_Power on by keyboard/mouse doesn't work on my Gigabyte motherboard - Super User

キーボードやマウスで電源ONにする機能は、「PS/2キーボードなら使えます」と言う話だった模様。自分が使ってるキーボードも、マウスも、USB接続だった…。

親父さん用PCに使っていた Mini-ITX M/B、ASUS PRIME A320I-K と BIOSTAR RACING B350GTN は、キーボードのキーを押しても電源ONになったので、てっきり自分の使ってる GIGABYTE B450M S2H (rev. 1.x) もそのように設定できるだろうと思い込んでた。でも、思い返してみると、親父さんが使ってるキーボードは、PS/2キーボードだった気もする。メンテナンス時に、あの丸いPS/2コネクタを背面に差していたような…。いや、どうだったかな。自信が無くなってきた。そのうち確認してみよう…。

そこで、キーボードを押したら電源が入るようにできないかと思い立った。メインPCのM/B、GIGABYTE B450M S2H (rev. 1.x) のBIOS設定画面を表示して、該当項目を有効にしてみた。

しかし、キーボードを押しても電源が入らない。何故。USBハブを介して接続しているせいだろうか。

であれば、M/Bに直接接続しているマウスならどうだろう。マウスのダブルクリックをしたら電源が入るようにBIOS設定を変えてみた。しかし、こちらも効果無し。

ググってみたら、おそらくだけど理由が分かってきた。

_[マザーボード] BIOS設定で「PS/2キーボードによる電源オン」を有効にする方法 | サポート 公式 | ASUS 日本

_価格.com - 『キーボードからの電源ON』 GIGABYTE GA-EP35-DS3R Rev.2.1 のクチコミ掲示板

_Power on by keyboard/mouse doesn't work on my Gigabyte motherboard - Super User

キーボードやマウスで電源ONにする機能は、「PS/2キーボードなら使えます」と言う話だった模様。自分が使ってるキーボードも、マウスも、USB接続だった…。

親父さん用PCに使っていた Mini-ITX M/B、ASUS PRIME A320I-K と BIOSTAR RACING B350GTN は、キーボードのキーを押しても電源ONになったので、てっきり自分の使ってる GIGABYTE B450M S2H (rev. 1.x) もそのように設定できるだろうと思い込んでた。でも、思い返してみると、親父さんが使ってるキーボードは、PS/2キーボードだった気もする。メンテナンス時に、あの丸いPS/2コネクタを背面に差していたような…。いや、どうだったかな。自信が無くなってきた。そのうち確認してみよう…。

[ ツッコむ ]

2022/06/09(木) [n年前の日記]

#1 [xscreensaver] xscreensaverでタイルマップ描画

_昨日、

Xlibを使ってタイルマップ描画ができるか試してそれっぽくなったけれど、同じ処理を xscreensaver上でも実現できるのか気になったので試してみた。

環境は、Ubuntu Linux 20.04 LTS。Windows10 x64 21H2 + VMware Player 16.2.3 build-19376536 上で動かしてる。CPU は Ryzen 5 5600X。VMware に3コアを割り振ってる。

こんな感じになった。

動いてくれて一安心。

ただ、CPU使用率が高い気もする…。1440x900の画面解像度なら20%程度だけど、1920x1080にすると30%ぐらいになる。元画面は640x360で固定してるから…画面解像度まで拡大する処理が結構重いのだろうか。

ちなみに、VMware の設定でCPUコアを1つにして動作確認してみたけれど、3コアを指定した場合とCPU使用率は変わらなかった。xscreensaver は、複数コアが載っている環境でも、使用率の表示結果が違ってくるわけではないっぽい。

環境は、Ubuntu Linux 20.04 LTS。Windows10 x64 21H2 + VMware Player 16.2.3 build-19376536 上で動かしてる。CPU は Ryzen 5 5600X。VMware に3コアを割り振ってる。

こんな感じになった。

動いてくれて一安心。

ただ、CPU使用率が高い気もする…。1440x900の画面解像度なら20%程度だけど、1920x1080にすると30%ぐらいになる。元画面は640x360で固定してるから…画面解像度まで拡大する処理が結構重いのだろうか。

ちなみに、VMware の設定でCPUコアを1つにして動作確認してみたけれど、3コアを指定した場合とCPU使用率は変わらなかった。xscreensaver は、複数コアが載っている環境でも、使用率の表示結果が違ってくるわけではないっぽい。

◎ ソース。 :

今回は、xscreensaver-6.04.tar.gz をDL・解凍して、中にファイルを追加する形で実験。

_XScreenSaver

_XScreenSaver: Download

ソース(*.c)、マニュアル(*.man)。hacks/ 以下にコピーする。

_hellotilemap.c

_hellotilemap.man

設定画面定義ファイル(*.xml)。hacks/config/ 以下にコピーする。

_hellotilemap.xml

使用画像。hacks/images/ にコピーする。

_scifi_bg_chip.png

使用画像を .h に変換したファイル。hacks/images/gen/ 以下にコピーする。ただ、本来は、make時に *.png から自動生成されるはず。

_scifi_bg_chip_png.h

hacks/Makefile.in や driver/XScreenSaver.ad.in の変更点は以下。「hellotilemap」で検索すれば、どのあたりを修正してるか分かるかなと。

_makefile.in.patch

_xscreensaver.ad.in.patch

一応、xscreensaver に自作のスクリーンセーバを追加して、ビルドする手順もざっくりとメモ。公式リポジトリ版を上書きしちゃうけど…。

少し解説。

基本的には、 _昨日、 書いた、 _09tilemap1.c をコピペしていっただけ。

ただし、xscreensaver 上では、XClearWindow() を呼んでしまうとエラーになることに気づかなくて結構ハマった。 Pixmap を対象にして中身をクリアしたかっただけなので、XFillRectangle() を使って塗り潰してしまえばOKだった。

_XScreenSaver

_XScreenSaver: Download

ソース(*.c)、マニュアル(*.man)。hacks/ 以下にコピーする。

_hellotilemap.c

_hellotilemap.man

設定画面定義ファイル(*.xml)。hacks/config/ 以下にコピーする。

_hellotilemap.xml

使用画像。hacks/images/ にコピーする。

_scifi_bg_chip.png

使用画像を .h に変換したファイル。hacks/images/gen/ 以下にコピーする。ただ、本来は、make時に *.png から自動生成されるはず。

_scifi_bg_chip_png.h

hacks/Makefile.in や driver/XScreenSaver.ad.in の変更点は以下。「hellotilemap」で検索すれば、どのあたりを修正してるか分かるかなと。

_makefile.in.patch

_xscreensaver.ad.in.patch

一応、xscreensaver に自作のスクリーンセーバを追加して、ビルドする手順もざっくりとメモ。公式リポジトリ版を上書きしちゃうけど…。

mkdir ~/pkg mkdir ~/pkg/xscreensaver cd ~/pkg/xscreensaver wget https://www.jwz.org/xscreensaver/xscreensaver-6.04.tar.gz tar zxvf xscreensaver-6.04.tar.gz cd xscreensaver-6.04 # file copy *.c : copy to hacks/ *.man : copy to hacks/ *.xml : copy to hacks/config/ *.png : copy to hacks/images/ *_png.h : copy to hacks/images/gen/ Makefile.in : copy to hacks/ XScreenSaver.ad.in : copy to driver/ # build ./configure --prefix=/usr --libexecdir=/usr/lib make sudo make install rm ~/.xscreensaver xscreensaver-settings &

少し解説。

基本的には、 _昨日、 書いた、 _09tilemap1.c をコピペしていっただけ。

ただし、xscreensaver 上では、XClearWindow() を呼んでしまうとエラーになることに気づかなくて結構ハマった。 Pixmap を対象にして中身をクリアしたかっただけなので、XFillRectangle() を使って塗り潰してしまえばOKだった。

[ ツッコむ ]

#2 [anime] 「DEATH NOTE ディレクターズカット完全決着版 リライト・幻視する神」を視聴

BS12で放送されたソレを録画しておいたので視聴。TVアニメ版の総集編だろうか。

実を言うと、「デスノートか…今更見てもな…」と思いながら見始めたのだけど、とにかく演出がキレッキレで、総集編なのにグイグイと引き込まれてしまった。あらゆる場面で、緩急と言うか、コントラストをかなり意識した演出がされていて、その手管が実に鮮やかで…。このアニメはスゴイ。素晴らしい。

以下、ちょっとネタバレになりそうだけど…。

例えば、主人公が某アイテムを手にして驚くシーン。まずはLが映ってるカットで、おそらくはジェット旅客機が近づいてるのか、「キイイィーン」という音が鳴り始めて。その音が最高潮・最大音量に達したタイミングで、音がスッと消えて、無音+主人公が驚いてる止め絵カットに切り替わる。その直後、主人公を演じる宮野真守氏の絶叫と、膨大かつ細切れな映像(記憶)が次々にフラッシュバック。そこからLのカットに切り替わると、若干静寂気味の客観的な視点というか、環境音が鳴ってるカットに。てな感じで、音の使い方があまりにも上手くて、それだけでもゾクゾクしてしまった。

あるいは、例のポテチシーン。とにかく激しく、スタイリッシュに、手前に効果線を載せながら、ポテチ袋を取り出し、破いて、ペンを走らせて、ポテチを食う主人公。その直後にLが見ているカメラ映像に切り替わるけど、客観的には何もしてないように見える主人公の図が提示される。

とにもかくにもコントラスト。「静」の前には「動」を置き、「動」の前には「静」を置く。そんな見せ方が何度も出てくる。

かつてPIXARを率いていたジョン・ラセター監督が、訪日してインタビューを受けるたびに、「我々は宮崎アニメから緩急(コントラスト)を学んだ」と口にしてたけど。その宮崎駿監督のお膝元のスタジオジブリでは、若手演出家さん達が「緩急? なんですかソレ?」状態のアニメを作り続けて…。しかし、ジブリとは縁もゆかりも無いはずのMADHOUSEで、各演出家さん達がここまでコントラストを駆使したアニメを産み出していたとは…。いや、たぶんこのコントラストのつけ方は宮崎アニメあたりから学んだものではなくて、全然違うところから来ている感じもするのだけど。何にせよ、これは上手いなと…。素晴らしい。

実を言うと、「デスノートか…今更見てもな…」と思いながら見始めたのだけど、とにかく演出がキレッキレで、総集編なのにグイグイと引き込まれてしまった。あらゆる場面で、緩急と言うか、コントラストをかなり意識した演出がされていて、その手管が実に鮮やかで…。このアニメはスゴイ。素晴らしい。

以下、ちょっとネタバレになりそうだけど…。

例えば、主人公が某アイテムを手にして驚くシーン。まずはLが映ってるカットで、おそらくはジェット旅客機が近づいてるのか、「キイイィーン」という音が鳴り始めて。その音が最高潮・最大音量に達したタイミングで、音がスッと消えて、無音+主人公が驚いてる止め絵カットに切り替わる。その直後、主人公を演じる宮野真守氏の絶叫と、膨大かつ細切れな映像(記憶)が次々にフラッシュバック。そこからLのカットに切り替わると、若干静寂気味の客観的な視点というか、環境音が鳴ってるカットに。てな感じで、音の使い方があまりにも上手くて、それだけでもゾクゾクしてしまった。

あるいは、例のポテチシーン。とにかく激しく、スタイリッシュに、手前に効果線を載せながら、ポテチ袋を取り出し、破いて、ペンを走らせて、ポテチを食う主人公。その直後にLが見ているカメラ映像に切り替わるけど、客観的には何もしてないように見える主人公の図が提示される。

とにもかくにもコントラスト。「静」の前には「動」を置き、「動」の前には「静」を置く。そんな見せ方が何度も出てくる。

かつてPIXARを率いていたジョン・ラセター監督が、訪日してインタビューを受けるたびに、「我々は宮崎アニメから緩急(コントラスト)を学んだ」と口にしてたけど。その宮崎駿監督のお膝元のスタジオジブリでは、若手演出家さん達が「緩急? なんですかソレ?」状態のアニメを作り続けて…。しかし、ジブリとは縁もゆかりも無いはずのMADHOUSEで、各演出家さん達がここまでコントラストを駆使したアニメを産み出していたとは…。いや、たぶんこのコントラストのつけ方は宮崎アニメあたりから学んだものではなくて、全然違うところから来ている感じもするのだけど。何にせよ、これは上手いなと…。素晴らしい。

◎ 顔芸を最初にやり始めたのは誰なのかしら。 :

そういえば、このアニメは原作からして顔芸も駆使しまくった作品だと思うけど。顔芸って何時頃から使われ始めたのだろう…。

「DB」「聖闘士星矢」では顔芸なんて使ってなかったよな…。「ゴルゴ13」あたりも使ってないし…。手塚治虫作品や藤子F作品でも使ってないだろうし…。

「進撃の巨人」「ゴールデンカムイ」等を思い返すと、もう顔芸は漫画表現として定着してる気もする。始祖は誰なんだろう…?

もしかして永井豪先生か石川賢先生あたりだろうか。デビルマンやゲッターロボでやってそうな…。

「DB」「聖闘士星矢」では顔芸なんて使ってなかったよな…。「ゴルゴ13」あたりも使ってないし…。手塚治虫作品や藤子F作品でも使ってないだろうし…。

「進撃の巨人」「ゴールデンカムイ」等を思い返すと、もう顔芸は漫画表現として定着してる気もする。始祖は誰なんだろう…?

もしかして永井豪先生か石川賢先生あたりだろうか。デビルマンやゲッターロボでやってそうな…。

[ ツッコむ ]

2022/06/10(金) [n年前の日記]

#1 [blender] blenderで作業中

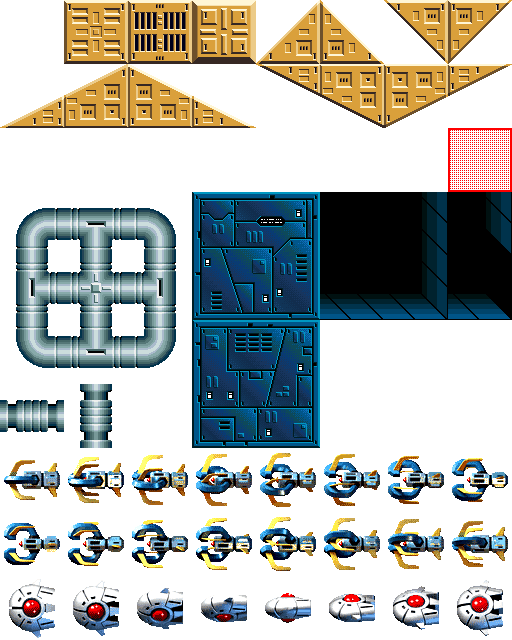

2D横スクロールSTGに出てきそうな、グルグル回転する雑魚敵っぽいアニメーション画像が欲しくなってきた。blender 2.93.9 x64 LTS を使ってそれっぽいモデルを作成して画像を作成。使い方をかなり忘れてる…。

とりあえず最終的に2D画像が得られればいいかなと雑な感じでモデルを作ってたけど、そのうち3DCGモデルとして使う場面もありそうな気がしてきた。ローポリモデルとしても使えるように作り直したほうがいいかな…。

とりあえず最終的に2D画像が得られればいいかなと雑な感じでモデルを作ってたけど、そのうち3DCGモデルとして使う場面もありそうな気がしてきた。ローポリモデルとしても使えるように作り直したほうがいいかな…。

[ ツッコむ ]

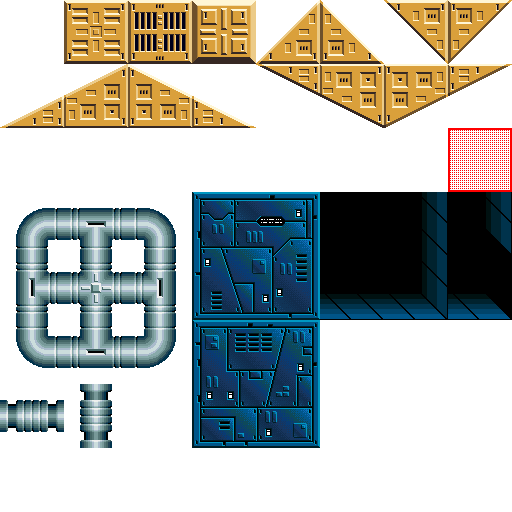

#2 [cg_tools] ImageMagickでスプライトシート画像を作成

blender で作業をして、512x512ドット、16枚の、雑魚敵っぽい感じのレンダリング画像が得られた。これを、64x64ドットにリサイズして、タイル状に並べて、1枚のスプライトシートにしたい。

以前作業した時は ImageMagick を使った気がする。日記を検索したら作業手順が見つかった。

_ImageMagick montage の覚書

magick montage で目的は果たせそう。

環境は、Windows10 x64 21H2 + ImageMagick 7.1.0-5 Q16 x64。

Lanczosアルゴリズム+アンシャープマスクで、64x64ドットに縮小しつつ、タイル状に8x2個並べる場合。

Cubicアルゴリズム+アンシャープマスクで、64x64ドットに縮小つつ、タイル状に8x2個並べる場合。

以前作業した時は ImageMagick を使った気がする。日記を検索したら作業手順が見つかった。

_ImageMagick montage の覚書

magick montage で目的は果たせそう。

環境は、Windows10 x64 21H2 + ImageMagick 7.1.0-5 Q16 x64。

Lanczosアルゴリズム+アンシャープマスクで、64x64ドットに縮小しつつ、タイル状に8x2個並べる場合。

magick montage -tile 8x2 -filter Lanczos -resize 62x62 -unsharp 10x5+0.7+0 -geometry +1+1 -background none render\*.png PNG32:spritesheet.png

Cubicアルゴリズム+アンシャープマスクで、64x64ドットに縮小つつ、タイル状に8x2個並べる場合。

magick montage -tile 8x2 -resize 62x62 -unsharp 10x5+0.7+0 -geometry +1+1 -background none render\*.png PNG32:spritesheet.png

- ImageMagick 7.x は、convert ではなく magick で実行する。

- -tile MxN で、タイル状にMxN個並べる。

- -filter xxxx で拡大縮小アルゴリズムが選べる。-filter Lanczos で Lanczosアルゴリズムを指定。

- -resize 62x62 で 62x62ドットに縮小。

- -unsharp 10x5+0.7+0 でアンシャープマスクをかける。

- -geometry +1+1 で、(1,1) の位置に配置。結果的に、64x64ドット、周囲に1ドットの隙間がある画像を作成。

- -background none で背景を透明にする。

- render\*.png で入力画像ファイルを指定。

- PNG32:spritesheet.png で出力画像ファイル名を指定。

- PNG32: をつけると、RGBA各8bitの画像になる。PNG32: をつけないと、利用している ImageMagick の種類によってはRGBA各16bitの画像になる。

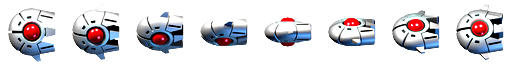

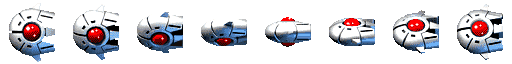

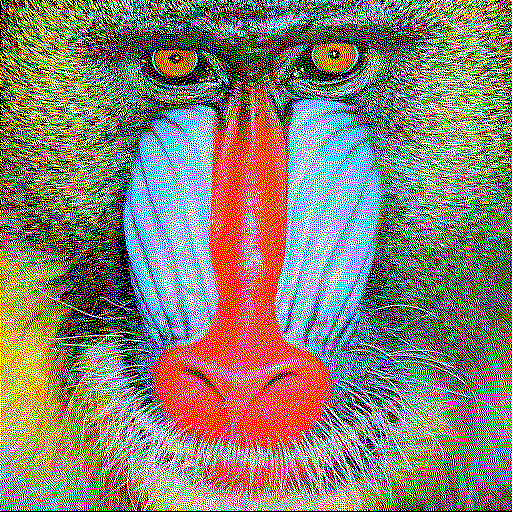

◎ 成果物。 :

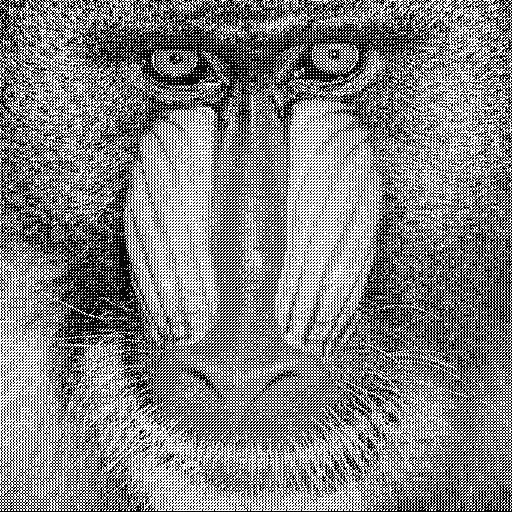

そんな感じで、64x64ドットの画像が並んだスプライトシートが得られたので一応アップロード。CC0 / Public Domain ってことで。何か使い道がありそうなら自由に使ってください。

フルカラー画像(RGBA各8bit)。

_spritesheet_lanczos.png

GIMP 2.10.30 で読み込んで、アルファチャンネルを1bitにしたもの。レイヤー → 透明部分 → アルファチャンネルのしきい値、で調整した。

_spritesheet_alpha1bit.png

EDGE2 1.16 dev015 で48色に減色、かつ、少しだけドット修正したもの。

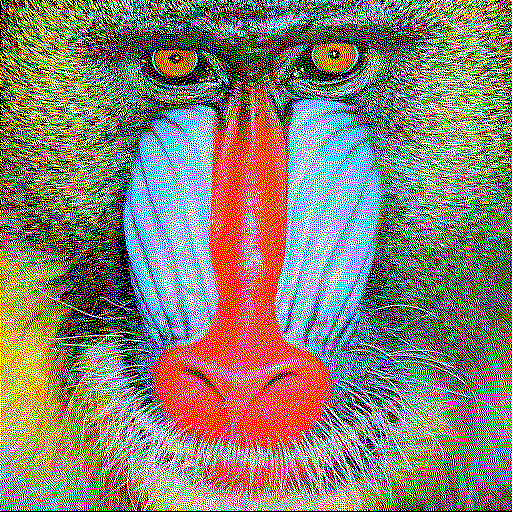

_spritesheet_48col.png

アニメGIFにしたもの。

レンダリング画像(512x512、16枚)。

_render.zip

元のblenderファイル(.blend)も一応置いときます。blender 2.93.9 x64 LTS で作成。

_enemytypec02_lowpoly.zip

フルカラー画像(RGBA各8bit)。

GIMP 2.10.30 で読み込んで、アルファチャンネルを1bitにしたもの。レイヤー → 透明部分 → アルファチャンネルのしきい値、で調整した。

EDGE2 1.16 dev015 で48色に減色、かつ、少しだけドット修正したもの。

アニメGIFにしたもの。

レンダリング画像(512x512、16枚)。

_render.zip

元のblenderファイル(.blend)も一応置いときます。blender 2.93.9 x64 LTS で作成。

_enemytypec02_lowpoly.zip

[ ツッコむ ]

#3 [nitijyou] 日記をアップロード

2022/05/20を最後に日記をアップロードしてなかったのでアップロード。

[ ツッコむ ]

2022/06/11(土) [n年前の日記]

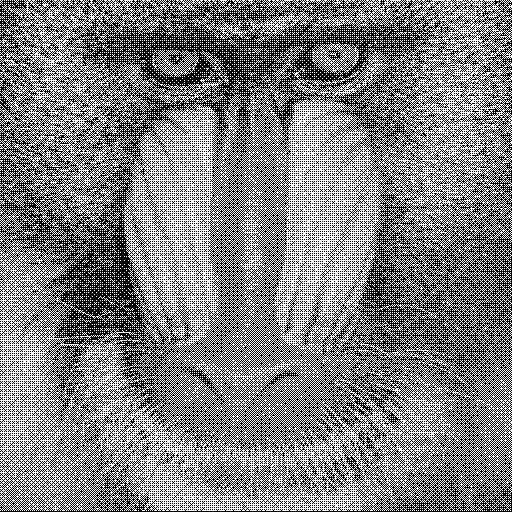

#1 [xlib] Xlibでタイルマップの前に雑魚敵モドキを描画してみた

_昨日、

雑魚敵っぽい画像を作成することができたので、

_先日作成した、

Xlibでタイルマップを描画するプログラムに追加して描画してみた。

環境は、Ubuntu Linux 20.04 LTS。Windows10 x64 21H2 + VMware Player 16.2.3 build-19376536 上で動かしてる。

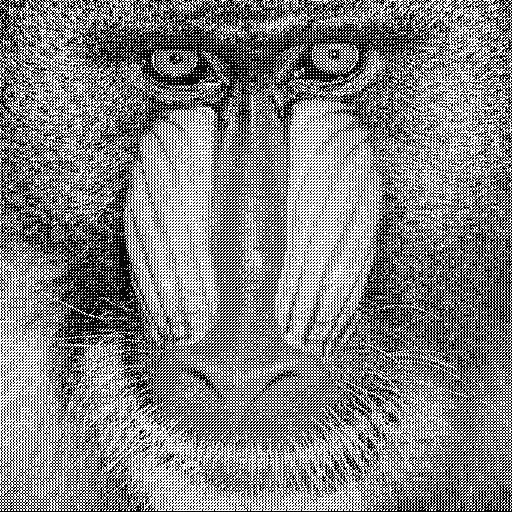

こんな感じになった。

実際に描画してみたら、自分の中ではコレジャナイ感が沸いてきた。雑魚敵の見た目のボリュームが足りないというか、ほっそりしたデザインは雑魚敵として全然合ってない気がする。その手のゲーム画面を眺めて傾向を調べてみたほうがいいのかもしれない。

でもまあ、Xlibを使っても、2Dゲーム風の画面を作れそうな気配はしてきた。

環境は、Ubuntu Linux 20.04 LTS。Windows10 x64 21H2 + VMware Player 16.2.3 build-19376536 上で動かしてる。

こんな感じになった。

実際に描画してみたら、自分の中ではコレジャナイ感が沸いてきた。雑魚敵の見た目のボリュームが足りないというか、ほっそりしたデザインは雑魚敵として全然合ってない気がする。その手のゲーム画面を眺めて傾向を調べてみたほうがいいのかもしれない。

でもまあ、Xlibを使っても、2Dゲーム風の画面を作れそうな気配はしてきた。

◎ ソース。 :

ソースは以下。

_10objs.c

使用画像は以下。実際に使ってるのは .xpm。*.xpm は、*.c と同じ場所に置く。

_scifi_bg_chip2.xpm

_scifi_bg_chip2.png

コンパイルは以下。

実行は以下。

_10objs.c

使用画像は以下。実際に使ってるのは .xpm。*.xpm は、*.c と同じ場所に置く。

_scifi_bg_chip2.xpm

_scifi_bg_chip2.png

コンパイルは以下。

gcc 10objs.c -o 10objs -I /usr/include/X11 -lX11 -lXext -lm -lXpm

実行は以下。

./10objs

◎ xscreensaverにも組み込んでみた。 :

xscreensaver上でも動くかどうか試してみた。

_先日書いたhellotilemap.c

を修正。

_hellotilemap.c

_scifi_bg_chip2_png.h

_scifi_bg_chip2.png

一応手元では動いてる。まあ、Xlib利用版と見た目は変わらないけれど…。

_hellotilemap.c

_scifi_bg_chip2_png.h

_scifi_bg_chip2.png

一応手元では動いてる。まあ、Xlib利用版と見た目は変わらないけれど…。

[ ツッコむ ]

2022/06/12(日) [n年前の日記]

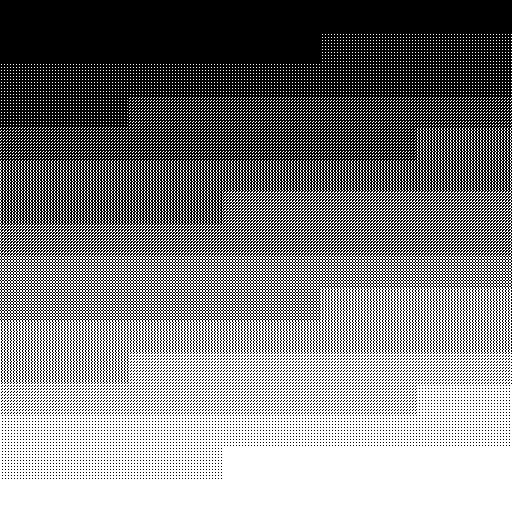

#1 [prog] 昔の2D横スクロールSTGの回転パターンを調べてた

_昨日、

作成した雑魚敵っぽい画像をタイルマップ上に描画してみたものの、なんか違うな、コレジャナイと感じてしまった。大昔の2D横スクロールSTGの雑魚敵の回転パターンってどういう感じに仕上げてあったのだろう、大体何パターンぐらい持つのが一般的だったのだろうかと気になってきて、そのあたりを調べてた。YouTubeでその手の動画を検索して、回転してる雑魚敵っぽいものが出てきたら、一時停止してコマ送りで確認。

余談。今時のYouTubeは、「.」「,」キーでコマ送りができたのですな。今まで知らなかった…。キーボード上で、「,」「.」には「<」「>」も刻印されてるから、割り当てとしては分かりやすい。そういえば Adobe Flash もそういうショートカットキーだった気がする。何にせよ、コマ送りをして何か調べる時は便利だなと。ありがたや。

ところで、この場合の回転パターンというのは、画面のX軸、もしくはY軸を回転軸としている系の回転。

画面のZ軸(奥行き方向?)を回転軸にしている場合も、当時は「回転パターン」と呼んで扱っていたけれど、その向きの回転は気にしなくて良さそうだなと。容量次第で持てるパターン数が違ってくるだろうし、そもそも今時の描画ライブラリなら回転描画もできる場合が多いから、事前に回転パターンを用意しておく必要も無い。いやまあ、回転させても不自然さを感じない光の当たり方を意識して画像を作らないといけない、という注意点はあるかもしれないけど。

さておき。その手の動画を眺めた感じでは、角度変化については、45度、30度、22.5度、この3種類がありそうだなと感じた。0度から180度まで回る際に、45度は4枚必要、30度は6枚必要、22.5度は8枚必要、ということになるのかな。

一応、以下のソレを眺めて枚数を数えてみた。

上下、あるいは前後が対象になってるデザインにすれば上記の枚数で済むけれど、非対称のデザインなら360度回した画像を作らないといけないから枚数は倍になるはず。

_先日作成した画像 は…16枚も作ってしまった。昔の2Dゲーム風を再現したいなら、枚数がリッチ過ぎた…。半分の8枚でも良かったのだな。

余談。今時のYouTubeは、「.」「,」キーでコマ送りができたのですな。今まで知らなかった…。キーボード上で、「,」「.」には「<」「>」も刻印されてるから、割り当てとしては分かりやすい。そういえば Adobe Flash もそういうショートカットキーだった気がする。何にせよ、コマ送りをして何か調べる時は便利だなと。ありがたや。

ところで、この場合の回転パターンというのは、画面のX軸、もしくはY軸を回転軸としている系の回転。

画面のZ軸(奥行き方向?)を回転軸にしている場合も、当時は「回転パターン」と呼んで扱っていたけれど、その向きの回転は気にしなくて良さそうだなと。容量次第で持てるパターン数が違ってくるだろうし、そもそも今時の描画ライブラリなら回転描画もできる場合が多いから、事前に回転パターンを用意しておく必要も無い。いやまあ、回転させても不自然さを感じない光の当たり方を意識して画像を作らないといけない、という注意点はあるかもしれないけど。

さておき。その手の動画を眺めた感じでは、角度変化については、45度、30度、22.5度、この3種類がありそうだなと感じた。0度から180度まで回る際に、45度は4枚必要、30度は6枚必要、22.5度は8枚必要、ということになるのかな。

一応、以下のソレを眺めて枚数を数えてみた。

- 45度 (4枚) : サンダーフォースIII(MD)

- 30度 (6枚) : グラディウス(AC)、サンダークロス(AC)、サンダークロスII(AC)

- 22.5度 (8枚) : グラディウスII(AC)、サンダーフォースIV(MD)

上下、あるいは前後が対象になってるデザインにすれば上記の枚数で済むけれど、非対称のデザインなら360度回した画像を作らないといけないから枚数は倍になるはず。

_先日作成した画像 は…16枚も作ってしまった。昔の2Dゲーム風を再現したいなら、枚数がリッチ過ぎた…。半分の8枚でも良かったのだな。

◎ 2022/06/13追記。 :

簡単な3DCGモデルを作って、45度、30度、22.5度で回転させてみた。

45度ずつ回転。

30度ずつ回転。

22.5度ずつ回転。

元のモデルの作りがよろしくなくて、なんだか分かりづらい気もするけれど。それでも一応、45度はナシだな、ぐらいのことは分かった。最低でも30度、できれば22.5度の回転パターンじゃないと回ってるように見えない気がする。

いやまあ、リアルタイム3DCGでゲーム画面を作るのが当たり前になったこの時代に、こんな検証をしてみても、という気もするのだけど。昔の2Dゲームらしい画面に近づけたい時はこういうのも関係してくるのかもしれないなあ、ということで。あるいは手描きアニメを作る際にも関係してくるのかもしれない。45度ずつの動画は回ってるように見えない、せめて30度は欲しい、とかそんな感じで。

45度ずつ回転。

30度ずつ回転。

22.5度ずつ回転。

元のモデルの作りがよろしくなくて、なんだか分かりづらい気もするけれど。それでも一応、45度はナシだな、ぐらいのことは分かった。最低でも30度、できれば22.5度の回転パターンじゃないと回ってるように見えない気がする。

いやまあ、リアルタイム3DCGでゲーム画面を作るのが当たり前になったこの時代に、こんな検証をしてみても、という気もするのだけど。昔の2Dゲームらしい画面に近づけたい時はこういうのも関係してくるのかもしれないなあ、ということで。あるいは手描きアニメを作る際にも関係してくるのかもしれない。45度ずつの動画は回ってるように見えない、せめて30度は欲しい、とかそんな感じで。

[ ツッコむ ]

2022/06/13(月) [n年前の日記]

#1 [cg_tools] スプライトシートからアニメGIFを作りたい

スプライトシートからアニメGIFを作りたい。環境は Windows10 x64 21H2。

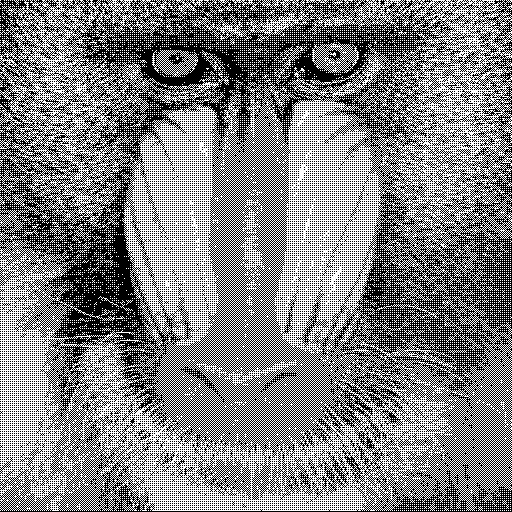

スプライトシートというのは、以下のようにアニメパターンがタイル状に並んでる画像のこと。

今までは、ドットエディタ EDGE2 でスプライトシート画像を読み込んでアニメGIFを作ってたけど、この作業がちょっと面倒臭くて。

できればスプライトシートから一発でアニメGIFにしたい。何かいい手はないものか。

ググってたら、ImageMagick を使ってスプライトシートからアニメGIFにする方法が紹介されてた。

_imagemagick - Convert sprite sheet to gif animation - Stack Overflow

例えば、128x128ドット単位で自動で切り出してアニメGIFにするなら、以下のような感じで指定すればいいらしい。

試しに、Windows10 x64 21H2 + ImageMagick 7.1.0-5 Q16 x64 で作業してみた。たしかにこれでアニメGIFが出力された。

ただ、一応出力できたけど、これは問題がある。このアニメGIFをIrfanViewで表示すると再生速度がめちゃくちゃ速い。また、Firefox や XnView で表示するとゆっくり動いてるけど、それでも再生速度がおかしい。「-delay 20」を指定してるから 20/100秒 のディレイ(wait値)を指定してるはずなのだけど…。それと、背景が残ってしまっている。

出力されたGIFをGIMPで読み込んでみたら、全フレームのディレイ値が 0ms になっていた。また、GIF/MNG-LCアニメ作成ソフト Giam 2.09 で読み込んでみても、やはりディレイ値が 0ms になってた。

_Giam ダウンロードのページ

_Giam - k本的に無料ソフト・フリーソフト

どうやら、ImageMagick の「-delay」指定は正常に働いてない気がする。

それでも、Firefox や XnView でそれっぽい再生速度になっているのは…。おそらくだけど、妙なディレイ値が指定されているアニメGIFについては、デフォルトのディレイ値(10/100秒)で表示してしまう仕様なのではなかろうか。そしておそらく、IrfanView は指定されたディレイ値(0ms)をそのまま使って表示する仕様だから、めちゃくちゃ速い再生速度になるのではないかと。

ImageMagick のバージョンが古くてバグがあるのだろうかと、ImageMagick-7.1.0-37-Q16-HDRI-x64-static.exe を使って、7.1.0-5 から 7.1.0-37 にアップデートしてみたけれど、結果は変わらなかった。

スプライトシートというのは、以下のようにアニメパターンがタイル状に並んでる画像のこと。

今までは、ドットエディタ EDGE2 でスプライトシート画像を読み込んでアニメGIFを作ってたけど、この作業がちょっと面倒臭くて。

- キャプチャフレーム機能を使って、手作業で各フレームの位置を指定。

- アニメーションプレイヤウインドウで、アニメの様子を確認しつつ、キャプチャフレームウインドウ上でディレイ値を調整。

- キャプチャフレームウインドウの、ファイル → エクスポート → アニメーションGIF形式、を選んで書き出す。

できればスプライトシートから一発でアニメGIFにしたい。何かいい手はないものか。

ググってたら、ImageMagick を使ってスプライトシートからアニメGIFにする方法が紹介されてた。

_imagemagick - Convert sprite sheet to gif animation - Stack Overflow

例えば、128x128ドット単位で自動で切り出してアニメGIFにするなら、以下のような感じで指定すればいいらしい。

magick spritesheet.png -crop 128x128 +adjoin +repage -adjoin -loop 0 -delay 20 output.gif

試しに、Windows10 x64 21H2 + ImageMagick 7.1.0-5 Q16 x64 で作業してみた。たしかにこれでアニメGIFが出力された。

ただ、一応出力できたけど、これは問題がある。このアニメGIFをIrfanViewで表示すると再生速度がめちゃくちゃ速い。また、Firefox や XnView で表示するとゆっくり動いてるけど、それでも再生速度がおかしい。「-delay 20」を指定してるから 20/100秒 のディレイ(wait値)を指定してるはずなのだけど…。それと、背景が残ってしまっている。

出力されたGIFをGIMPで読み込んでみたら、全フレームのディレイ値が 0ms になっていた。また、GIF/MNG-LCアニメ作成ソフト Giam 2.09 で読み込んでみても、やはりディレイ値が 0ms になってた。

_Giam ダウンロードのページ

_Giam - k本的に無料ソフト・フリーソフト

どうやら、ImageMagick の「-delay」指定は正常に働いてない気がする。

それでも、Firefox や XnView でそれっぽい再生速度になっているのは…。おそらくだけど、妙なディレイ値が指定されているアニメGIFについては、デフォルトのディレイ値(10/100秒)で表示してしまう仕様なのではなかろうか。そしておそらく、IrfanView は指定されたディレイ値(0ms)をそのまま使って表示する仕様だから、めちゃくちゃ速い再生速度になるのではないかと。

ImageMagick のバージョンが古くてバグがあるのだろうかと、ImageMagick-7.1.0-37-Q16-HDRI-x64-static.exe を使って、7.1.0-5 から 7.1.0-37 にアップデートしてみたけれど、結果は変わらなかった。

◎ 指定の順番がマズかった。 :

色々試していたところ、以下の指定ならディレイ値が反映してくれるようだと分かった。

要するに、一番最初に「-delay 20」を書いてから、その次に背景の消去方法、「-dispose Background」を記述すれば、期待通りのディレイ値と背景消去方法で生成できる模様。

そんなわけで、以下の画像が得られた。

以下のページで使用事例が色々解説されてる。こういったドキュメントをちゃんと読み込めば、もっと色々な変換作業ができるのだろうな…。

_Animation Basics -- ImageMagick Examples

magick -delay 20 -dispose Background spritesheet.png -crop 128x128 +adjoin +repage -adjoin -loop 0 output.gif

- -delay N : ディレイ値を指定。単位は 1/100秒。

- -dispose (None|Previous|Background) : 背景の消去方法を指定。Background は、フレームを背景色でクリアする。

- -crop NxM : 1フレーム分を切り出すサイズ。N x M のサイズで切り出していく。

- +adjoin +repage -adjoin : 不明。とりあえずこの指定をすると、複数のフレームを持っている画像が出力できるらしい。

- -loop 0 : ループアニメを指定。

要するに、一番最初に「-delay 20」を書いてから、その次に背景の消去方法、「-dispose Background」を記述すれば、期待通りのディレイ値と背景消去方法で生成できる模様。

そんなわけで、以下の画像が得られた。

以下のページで使用事例が色々解説されてる。こういったドキュメントをちゃんと読み込めば、もっと色々な変換作業ができるのだろうな…。

_Animation Basics -- ImageMagick Examples

[ ツッコむ ]

#2 [cg_tools] APNGとWebPの作成を試した

アニメGIFを作る作業が面倒臭くなってきた。そもそも2022年にもなって256色しか使えないとかおかしいだろ。みたいな。

そこでふと、そういえば APNG という画像フォーマットがあったなと思い出した。フルカラーでアニメーション画像を作れるフォーマットだったはず。一時期オワコン扱いされてた記憶があるけど、今時はどういう扱いになってるんだろう。

そこでふと、そういえば APNG という画像フォーマットがあったなと思い出した。フルカラーでアニメーション画像を作れるフォーマットだったはず。一時期オワコン扱いされてた記憶があるけど、今時はどういう扱いになってるんだろう。

◎ APNGを試した。 :

APNGについて、今時のブラウザの対応状況はどうなっているのだろう。

_Animated Portable Network Graphics - Wikipedia

_APNG - Wikipedia

_Comparison of web browsers - Wikipedia

昔は対応ブラウザが少なかった、というか Firefox しか対応してなかった気がするのだけど、今現在は Google Chrome も対応してくれたらしい。Google Chrome が対応しているということは、Microsoft Edge も、Opera も、Vivaldi も対応してるはず。つまりメジャーなブラウザなら、そのほとんどが APNG に対応済みと捉えてしまっていいのかもしれない。

試しに作ってみた。APNG Assembler で作れるらしいので、APNG Assembler 2.91 GUI版をDLして作業。32bit版と64bit版、GUI版とCUI版があるらしい。

_APNG Assembler download | SourceForge.net

_APNG Assembler

_APNG AssemblerでアニメーションするPNG(APNG)を書き出す - Qiita

作成した APNG を Firefox 101.0.1 x64 にドラッグアンドドロップしたら、たしかにアニメが表示された。これでいいんじゃないかな…。

ここに載せてみたらどうなるだろう。さて、動いているように見えるだろうか…?

_spritesheet_22_5deg_apng.png

Webサーバ側の設定は必要なのだろうか。どうなんだろう。png 扱いのはずだから、特に設定は要らないのかな。

_Animated Portable Network Graphics - Wikipedia

_APNG - Wikipedia

_Comparison of web browsers - Wikipedia

昔は対応ブラウザが少なかった、というか Firefox しか対応してなかった気がするのだけど、今現在は Google Chrome も対応してくれたらしい。Google Chrome が対応しているということは、Microsoft Edge も、Opera も、Vivaldi も対応してるはず。つまりメジャーなブラウザなら、そのほとんどが APNG に対応済みと捉えてしまっていいのかもしれない。

試しに作ってみた。APNG Assembler で作れるらしいので、APNG Assembler 2.91 GUI版をDLして作業。32bit版と64bit版、GUI版とCUI版があるらしい。

_APNG Assembler download | SourceForge.net

_APNG Assembler

_APNG AssemblerでアニメーションするPNG(APNG)を書き出す - Qiita

作成した APNG を Firefox 101.0.1 x64 にドラッグアンドドロップしたら、たしかにアニメが表示された。これでいいんじゃないかな…。

ここに載せてみたらどうなるだろう。さて、動いているように見えるだろうか…?

Webサーバ側の設定は必要なのだろうか。どうなんだろう。png 扱いのはずだから、特に設定は要らないのかな。

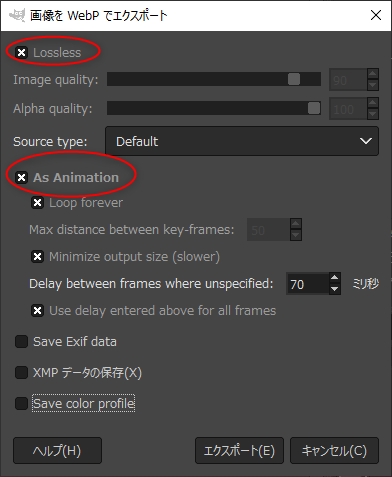

◎ WebPを試した。 :

GIMP で APNG を作れないかとググっていたら、「GIMP 2.10 は アニメーションWebPに標準対応してるからそっちを使ったほうがいい」という話を見かけた。

_APNG (animated PNG) plug-in for Gimp 2.10 Windows64x - GIMP Chat

WebP って何だっけ。

_アニメーション画像の歴史 APNG-WebP戦争 | Otogeworks

上記のページで、APNG と WebP に関しての経緯がまとまっていて大変勉強になった。WebPは、アニメーションも、ロスレス画質(画質劣化が一切無い)も、不可逆圧縮(Jpegのようなもの)も、何から何までサポートしたゴイスな画像フォーマット、と思っておけばいいのだろうか。

今時のメジャーなブラウザなら、APNG、WebP、どちらも対応しているらしい。ますますもってアニメGIFを使う理由が無くなってきた。

GIMPを使って作成できるか試してみた。GIMP 2.10.30 Portable x64 samj版を使用。

_spritesheet_22_5deg_gimp210.webp

画質設定でロスレス指定もできるようだし、これでもいいんじゃないかな…。

ちなみに、Webサーバ IIS上でWebPを利用するには、「MIMEの種類」に対して設定が必要だった。追加を選んで、「.webp」に「image/webp」を指定しないといけない。

Webサーバ Apache2上でWebPを利用する場合は、「AddType image/webp webp」を .htaccess あたりに追加しておけばいいのかもしれない。たぶん。

_APNG (animated PNG) plug-in for Gimp 2.10 Windows64x - GIMP Chat

WebP って何だっけ。

_アニメーション画像の歴史 APNG-WebP戦争 | Otogeworks

上記のページで、APNG と WebP に関しての経緯がまとまっていて大変勉強になった。WebPは、アニメーションも、ロスレス画質(画質劣化が一切無い)も、不可逆圧縮(Jpegのようなもの)も、何から何までサポートしたゴイスな画像フォーマット、と思っておけばいいのだろうか。

今時のメジャーなブラウザなら、APNG、WebP、どちらも対応しているらしい。ますますもってアニメGIFを使う理由が無くなってきた。

GIMPを使って作成できるか試してみた。GIMP 2.10.30 Portable x64 samj版を使用。

- 1レイヤーを1フレーム扱いにして読み込む。アニメGIFを作る際の手順そのままで良い。

- エクスポート時に、出力ファイル名の拡張子を「.webp」にする。

- 保存時のダイアログに「Lossless」や「As Animation」という設定項目があるのでチェックを入れて保存。

画質設定でロスレス指定もできるようだし、これでもいいんじゃないかな…。

ちなみに、Webサーバ IIS上でWebPを利用するには、「MIMEの種類」に対して設定が必要だった。追加を選んで、「.webp」に「image/webp」を指定しないといけない。

Webサーバ Apache2上でWebPを利用する場合は、「AddType image/webp webp」を .htaccess あたりに追加しておけばいいのかもしれない。たぶん。

◎ GIMPでAPNGを保存。 :

前述のフォーラムで紹介されているプラグインを使って、GIMP 2.10 64bit版で APNG の保存ができるか試してみた。

環境は、Windows10 x64 21H2 + GIMP 2.10.30 Portable 64bit samj版。Portable版なので、一般的なGIMPとはフォルダ構成が違ってるかもしれない。

_APNG (animated PNG) plug-in for Gimp 2.10 Windows64x - GIMP Chat

アニメGIFを作る時と同様に、1レイヤーを1フレーム扱いにして画像を作成。

これを APNG として保存する。

保存された png を Firefox 101.0.1 64bit や Google Chrome 102.0.5005.63 64bit にドラッグアンドドロップしてみたけれど、アニメ画像として再生された。

_spritesheet_22_5deg_apng_from_gimp210.png

ただ、この file-apng.exe を導入すると、GIMP の起動時に一瞬DOS窓が開いて閉じるあたりが気になる…。APNG保存時に、DOS窓が開くのも気になる…。でもまあ、動いてるからいいか…。

環境は、Windows10 x64 21H2 + GIMP 2.10.30 Portable 64bit samj版。Portable版なので、一般的なGIMPとはフォルダ構成が違ってるかもしれない。

_APNG (animated PNG) plug-in for Gimp 2.10 Windows64x - GIMP Chat

- apng-Gimp-2.10-64bit.zip をDLして解凍。

- libpng15-15.dll を、GIMPインストールフォルダ\bin\ にコピー。libpng16-16.dll というファイルが既に入ってるのだけど、いいのだろうか…?

- file-apng.exe を、ユーザフォルダ\.gimp\plug-ins\ 等の場所にコピー。

- plug-in-file-apng.ui を、GIMPインストールフォルダ\share\gimp\2.0\ui\ にコピー。

- GIMPを起動。

アニメGIFを作る時と同様に、1レイヤーを1フレーム扱いにして画像を作成。

これを APNG として保存する。

- ファイル → 名前を付けてエクスポート。

- 「ファイル形式の選択」をクリックして、「PNG+APNG Image」を選んで「エクスポート」。

- 「拡張子が一致しません。この名前で保存してもよろしいですか?」と尋ねてくるけど、気にせず「保存」。

- 何故かDOS窓が開きつつ、ファイル保存設定ダイアログが表示される。

- 「Animated PNG Options」の「As animation」にチェックを入れる。

- 他はPNG保存時のノリで設定して、「エクスポート」。

保存された png を Firefox 101.0.1 64bit や Google Chrome 102.0.5005.63 64bit にドラッグアンドドロップしてみたけれど、アニメ画像として再生された。

ただ、この file-apng.exe を導入すると、GIMP の起動時に一瞬DOS窓が開いて閉じるあたりが気になる…。APNG保存時に、DOS窓が開くのも気になる…。でもまあ、動いてるからいいか…。

◎ GIMP 2.8.22 Portableで試してみた。 :

手元の環境では GIMP 2.8.22 Portable x86 もインストールしてあるけれど、そちらにも file-apng.exe は導入済みだった。APNG で保存したい時は GIMP 2.8.22 Portable を使えば済むのかもしれない。

_APNG support for GIMP download | SourceForge.net

などと思ったりもしたのだけど、GIMP 2.8.22 Portable を起動して APNG のエクスポートを試してみたら、保存時の設定ダイアログが表示されないことに気づいた。DOS窓上に file-apng.ui 関係のエラーが大量に発生している。どうやら以前から正常動作してなかったらしい。

エラーメッセージを眺めたら、「GIMP 2.8.22 Portableインストールフォルダ\App\gimp\lib\gimp\2.0\plug-ins\ 以下に file-apng.ui が無いぞ」と言ってるように見えた。もしかすると .ui ファイルを読み込んでくる場所については決め打ちで作ってあるのかもしれない。試しにその場所に file-apng.ui を置いてみたらエラーが出ない状態になって、APNGでのエクスポートができるようになった。

ちなみに、file-apng.exe は、ユーザフォルダ/.gimp-2.8/plug-ins/ に置いてあっても動いてくれた。.ui の置き場所だけは注意、ということになるのだろうなと。

_APNG support for GIMP download | SourceForge.net

などと思ったりもしたのだけど、GIMP 2.8.22 Portable を起動して APNG のエクスポートを試してみたら、保存時の設定ダイアログが表示されないことに気づいた。DOS窓上に file-apng.ui 関係のエラーが大量に発生している。どうやら以前から正常動作してなかったらしい。

エラーメッセージを眺めたら、「GIMP 2.8.22 Portableインストールフォルダ\App\gimp\lib\gimp\2.0\plug-ins\ 以下に file-apng.ui が無いぞ」と言ってるように見えた。もしかすると .ui ファイルを読み込んでくる場所については決め打ちで作ってあるのかもしれない。試しにその場所に file-apng.ui を置いてみたらエラーが出ない状態になって、APNGでのエクスポートができるようになった。

ちなみに、file-apng.exe は、ユーザフォルダ/.gimp-2.8/plug-ins/ に置いてあっても動いてくれた。.ui の置き場所だけは注意、ということになるのだろうなと。

◎ 余談。GIMP上でのディレイ値変更について。 :

GIMPでアニメGIF等を作る場合、レイヤー名にディレイ値(wait時間)を書いておくことで、各フレームの表示時間を個別に変更できるのだけど、以下のスクリプトを利用すれば全レイヤーに対して一括で値を変更できるので便利。

_フレーム表示時間変更

フィルタ → アニメーション → フレーム表示時間変更、で呼び出せる。

このあたり、以前もメモしてあった…。

_GIMPでGIFアニメを作成する際のwait値を変更するスクリプトその2

各スクリプトを追加すると、フィルター → アニメーション以下のメニューに追加される。

_フレーム表示時間変更

フィルタ → アニメーション → フレーム表示時間変更、で呼び出せる。

このあたり、以前もメモしてあった…。

_GIMPでGIFアニメを作成する際のwait値を変更するスクリプトその2

各スクリプトを追加すると、フィルター → アニメーション以下のメニューに追加される。

- フレーム表示時間変更

- Rename Layers...

- Set frames delay...

- Change frame delays...

◎ ImageMagickでAPNGを出力。 :

ImageMagick でも APNGを出力できないものかと調べてみた。環境は、Windows10 x64 21H2 + ImageMagick 7.1.0-37 Q16-HDRI x64。static版。

スプライトシート画像からアニメGIFを生成する指定に対して、アニメGIFではなくAPNGで保存するように変更すればOKだったりしないか。ググったところ、「apng:output.png」と書けば APNG を指定することになるらしい。

_ImageMagick - Image Formats

試してみた。どうだろう。動いてるように見えるだろうか。

_spritesheet_22_5deg_apng_from_im7.png

スプライトシート画像からアニメGIFを生成する指定に対して、アニメGIFではなくAPNGで保存するように変更すればOKだったりしないか。ググったところ、「apng:output.png」と書けば APNG を指定することになるらしい。

_ImageMagick - Image Formats

試してみた。どうだろう。動いてるように見えるだろうか。

magick -delay 3 -dispose Background spritesheet.png -crop 128x128 +adjoin +repage -adjoin -loop 0 apng:output.png

◎ ImageMagickでWebPを出力。 :

ImageMagick で アニメーションWebPを出力できるだろうか。以下のページによると、7.0.8-68 で対応、と書いてあるので、使えそうな気がする。

_ImageMagick と WebP - Qiita

試してみた。

_spritesheet_22_5deg_im7.webp

これで、ImageMagick を使えばアニメーションWebPを出力することも可能、と分かった。ただ、この指定では、ロスレス画質は指定してないので、不可逆圧縮で出力されてるのではないか。

前述の解説ページに、ロスレスを指定する時は「-define webp:lossless=true」をつける、と書いてあった。これも試してみる。

_spritesheet_22_5deg_im7_lossless.webp

ファイルサイズが、10.9 KByte から 61,9 KByte に増えたので、おそらくロスレス画質になっているのではないかな…。たぶん。

でも、見た感じ、違いは全然分かりませんな…。

GIMP 2.10.30 で両方開いて、拡大表示をして確認してみたけれど、たしかに不可逆圧縮とロスレスの違いはあった。でも、等倍表示では分からない程度の微妙な差だなと…。

_ImageMagick と WebP - Qiita

試してみた。

magick -delay 7 -dispose Background spritesheet.png -crop 128x128 +adjoin +repage -adjoin -loop 0 output.webp

これで、ImageMagick を使えばアニメーションWebPを出力することも可能、と分かった。ただ、この指定では、ロスレス画質は指定してないので、不可逆圧縮で出力されてるのではないか。

前述の解説ページに、ロスレスを指定する時は「-define webp:lossless=true」をつける、と書いてあった。これも試してみる。

magick -delay 7 -dispose Background spritesheet.png -crop 128x128 +adjoin +repage -adjoin -loop 0 -define webp:lossless=true output_lossless.webp

ファイルサイズが、10.9 KByte から 61,9 KByte に増えたので、おそらくロスレス画質になっているのではないかな…。たぶん。

でも、見た感じ、違いは全然分かりませんな…。

GIMP 2.10.30 で両方開いて、拡大表示をして確認してみたけれど、たしかに不可逆圧縮とロスレスの違いはあった。でも、等倍表示では分からない程度の微妙な差だなと…。

[ ツッコむ ]

2022/06/14(火) [n年前の日記]

#1 [cg_tools] ImageMagickでアルファチャンネルを2値化

先日、スプライトシート画像を作成していた際は、GIMP 2.10.30 を使ってアルファチャンネルの2値化をしていたのだけど。一々GIMPを起動するのもなんだかアレだなと思えてきて。自分の環境ではGIMPにプラグインを入れまくってるのでとにかく起動が遅いわけで。そのくらいの処理なら ImageMagick でやれないだろうかと調べてみた。

環境は、Windows10 x64 21H2 + ImageMagick 7.1.0-37 Q16-HDRI x64。

参考ページ。

_ImageMagick - rounding the alpha channel - Stack Overflow

_imagemagick 6 (-threshold -fill -transparent -fazz) | 丸ノ内テックブログ

これでアルファチャンネルの2値化ができる模様。

環境は、Windows10 x64 21H2 + ImageMagick 7.1.0-37 Q16-HDRI x64。

参考ページ。

_ImageMagick - rounding the alpha channel - Stack Overflow

_imagemagick 6 (-threshold -fill -transparent -fazz) | 丸ノ内テックブログ

magick input.png -channel alpha -threshold 85% output.png

- -channel alpha で、アルファチャンネルを対象にする。

- -threshold 85% で、85% を境にして2値化する。

これでアルファチャンネルの2値化ができる模様。

◎ 減色は上手く行かなかった。 :

ここまでできたら、減色処理も ImageMagick でやれないものかと思って試していたのだけど。

_ImageMagick の減色処理 - Qiita

これはちょっと、思っていた通りの結果にならず。自分は市松模様っぽいディザが好きなので、そういう見た目の減色結果が欲しいのだけど、ImageMagick で処理をすると誤差拡散っぽいディザパターンになってしまう。まだ、EDGE2 か GIMP で減色したほうが自分好みの結果になるなと…。いやまあ、GIMP の減色処理もなかなかに酷いのだけど。あちこちに突飛な色のドットが出現してしまう。なんでだろ。

_ImageMagick の減色処理 - Qiita

これはちょっと、思っていた通りの結果にならず。自分は市松模様っぽいディザが好きなので、そういう見た目の減色結果が欲しいのだけど、ImageMagick で処理をすると誤差拡散っぽいディザパターンになってしまう。まだ、EDGE2 か GIMP で減色したほうが自分好みの結果になるなと…。いやまあ、GIMP の減色処理もなかなかに酷いのだけど。あちこちに突飛な色のドットが出現してしまう。なんでだろ。

◎ ImageMagickの使用例について。 :

以下のページに、ImageMagick の使用例が色々載ってるのでメモ。

_Examples of ImageMagick Usage

日本語で膨大な量の解説記事を書いてくれてる方がいらっしゃる。ありがたや。マジで助かります。

_ImageMagick 解説インデックス - Qiita

ImageMagick で射影変換できるなんて知らなかった。ラッパーを書けば便利に使えるのではあるまいか…。

_ImageMagick で射影変換 (Homography, Perspective projection) - Qiita

_Examples of ImageMagick Usage

日本語で膨大な量の解説記事を書いてくれてる方がいらっしゃる。ありがたや。マジで助かります。

_ImageMagick 解説インデックス - Qiita

ImageMagick で射影変換できるなんて知らなかった。ラッパーを書けば便利に使えるのではあるまいか…。

_ImageMagick で射影変換 (Homography, Perspective projection) - Qiita

◎ 余談。DB32パレットについて。 :

ググっていたら、DB8、DB16、DB32パレット等がまとめてあるページに遭遇。

_geoffb/dawnbringer-palettes: Limited color palettes by DawnBringer in various formats.

.csv やGIMPのパレットファイルまで置いてある。ありがたや。

_geoffb/dawnbringer-palettes: Limited color palettes by DawnBringer in various formats.

.csv やGIMPのパレットファイルまで置いてある。ありがたや。

[ ツッコむ ]

2022/06/15(水) [n年前の日記]

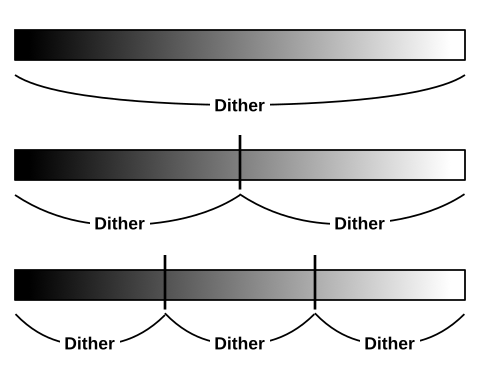

#1 [cg_tools] 減色ツールについて調べてた

ImageMagick で奇麗に減色できないものか、-ordered-dither の指定の仕方でそれっぽくならないかと試していたのだけど、他の減色ツールではどうなるのかが気になってきた。

そんなわけで、現在でも利用できるツールを使って、フルカラー画像を32色や16色に変換して結果を眺めているところ。 *1

環境は Windows10 x64 21H2。

利用したツールは以下。括弧内は配布ファイル名。

_Padieの詳細情報 : Vector ソフトを探す!

_多摩川ソフトウェア工房 Padie (WebArchive)

_xPadie Pro (WebArchive)

_結社「障泥烏賊ライブラリ」用地

_COLGAのページ

_ずるねこの減色256色にするよ誤差拡散有り低速の詳細情報 : Vector ソフトを探す!

_Color quantizer

_pngnq-s9 download | SourceForge.net

_pngnq - image quantization

_pngquant - lossy PNG compressor

OPTPiX 1.31 だけが有償ソフト。他はフリーソフト。

OPTPiX は無印だった頃に購入したのでバージョンがとんでもなく古い。今はもうプロ用というか企業様御用達のツールになっているので個人で購入する事例はまず無いだろうなと…。公式サイトを眺めたら、6ヶ月間の使用ライセンスで180,000円と書いてあった…。

xPadie、xPadie Pro、Yukari は、減色エンジンが Padie のソレなので、大体似たような変換結果になる印象を受けた。

色々試してみたけれど、やはり OPTPiX の変換結果が優秀に思えた。その次にイイ感じだったのが Padie系。ディザの種類で「アニメーション」を選ぶとドット絵のソレっぽくなるのがイイ感じ。

「ずるねこの〜」は、256色への減色で固定されていたのが残念。任意の色数への減色結果を確認してみたかった…。

Color quantizer は Bayer ディザが選べるので、比較的好みの減色結果になった。

pngquant は、Floyd-Steinberg ディザしか使えないようで、ちょっと残念。

でもまあ、どれを使っても、ImageMagick で減色するより、はるかにイイ感じになるなと…。その点だけは分かった。